Sommaire

- Le contexte

- Recherche de solution de sauvegarde Cloud

- Le solution kdrive d'Infomaniak

- Les fonctionnalités importantes absentes de kdrive

- Pour résumer et en guise de conclusion

Le contexte

Je suis devenu paranoïaque de la perte de données depuis une perte récente de données, et je m'emploie maintenant à parfaire régulièrement mon dispositif de sauvegarde, j'ai déjà consacré deux journaux à ce sujet ici même pour partager mon expérience.

Dans le premier journal j'évoquais les circonstances de la perte de données issue d'une corruption de données à bas bruit et pour prévenir toute nouvelle déconvenue, je décrivais une première configuration de mise en place d'un système de sauvegarde basé sur un script bash avec rsync et unison.

Mais finalement ce système s'avérait peu satisfaisant et les commentaires du premier journal m'ont donné de très bons conseils pour pousser plus loin dans la configuration en abandonnant mon script basé sur rsync pour passer à borg et btrfs. Tout cela est raconté dans le deuxième journal.

Les commentaires du deuxième journal évoquaient également la possibilité d'utiliser un espace dans le cloud. Effectivement cela permet la séparation physique de la sauvegarde, et éviter que les sauvegardes stockées au même endroit que les données d'origine subissent les mêmes sinistres, bien sûr on considèrera que le cloud ne parte pas lui même en fumée ou que du moins le professionnel ait mis en place les dispositifs qui vont bien pour restaurer les données de ses clients en cas de sinistre.

Recherche de solution de sauvegarde Cloud

J'ai donc commencé à chercher une solution de stockage sur cloud, mes critères de recherche étant :

- un accès pour plusieurs personnes, en l’occurrence le cercle familial restreint ;

- une capacité d'au moins 2To pour pouvoir stocker essentiellement des documents divers et des photos, pour mes besoins propres et celui de mon cercle ;

- un outil de synchronisation qui fonctionne sous Linux et un autre sous Android ;

- et certaines garanties de sécurité, de confidentialité et de non réutilisation de mes données.

J'ai ouvert cette recherche aux services payants, considérant que tout service mérite rémunération et que si c'est gratuit, c'est qu'il y a un loup quelque part, rien n'est gratuit dans ce bas monde et dans ce cas ce sont les données personnelles qui sont la source de financement.

Je ne dresserai pas ici une liste fastidieuse de toutes les solutions qui peuvent exister, on trouve beaucoup de sites qui les comparent avec plus ou moins d'objectivité quand ce ne sont pas des publireportages à peine déguisés. Je citerai toutefois cette page du forum d'Ubuntu et la page Wikipedia, même si elles ne sont pas complètement à jour.

Pour faire très bref dans cette phase de recherche et au risque que ce journal passe également pour un publireportage mon choix s'est porté sur kdrive de la société suisse Infomaniak.

Je précise que je n'ai aucune action dans cette société et ce journal s'inscrit dans une démarche totalement désintéressée, considérez le comme un partage d'expérience et j'attends en retour des expériences similaires pour que chacun fasse son opinion sur le sujet.

Le solution kdrive d'Infomaniak

Revenons donc à nos moutons, Les raisons (dans le désordre) qui ont conduit à ce choix sont :

- il existe bien un client Linux et Android ;

- leur solution pour 3To pour 6 utilisateurs est une des moins chères du marché (à vrai dire je n'ai pas trouvé moins cher pour des services équivalents) ;

- les données sont stockées sur trois différents serveurs et deux datacenters situés en Suisse gérés par une société indépendante non cotée en bourse, les outils utilisés sont basées sur des solutions libres (voir par là) ;

- la législation suisse en terme de protection de la vie privée est d'un bon niveau, la loi sur la protection des données (LPD) bientôt en vigueur améliore sensiblement la législation suisse actuelle en s'inspirant très largement du RGPD européen sans être toutefois aussi exigeant ;

- Infomaniak ne pratique pas l'analyse cloud pour extraire des informations commerciales exploitables et les revendre à des tiers.

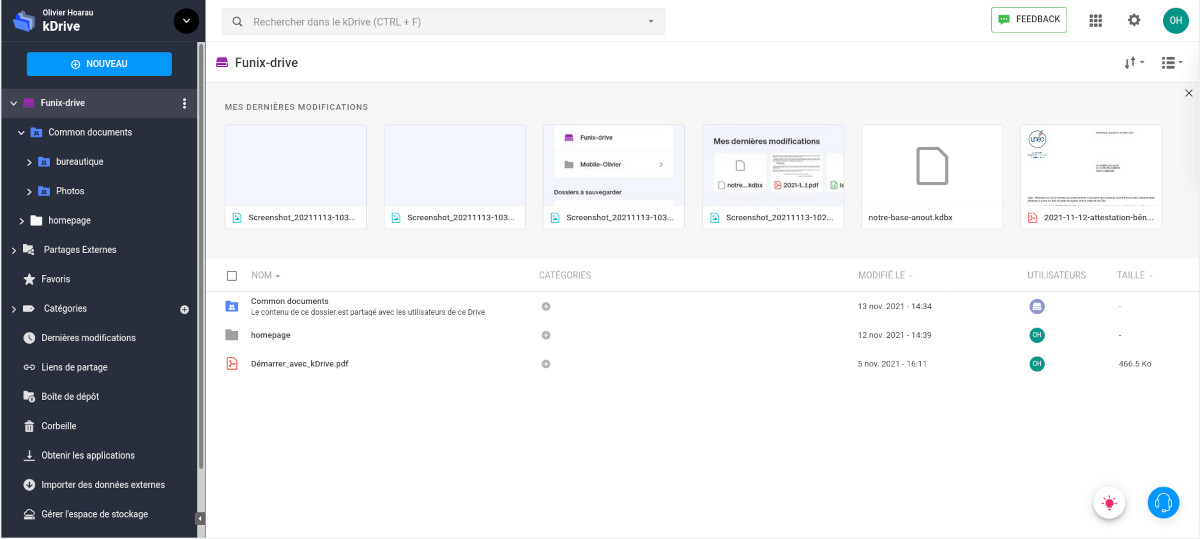

Dans la pratique, l'essentiel de l'administration se fait à partir d'un navigateur et ceci quel que soit l'OS. C'est à partir du navigateur qu'on créera l'arborescence des fichiers partagés ou non, les fichiers partagés se retrouveront dans le répertoire Common documents, c'est également à partir du navigateur qu'on importera les fichiers.

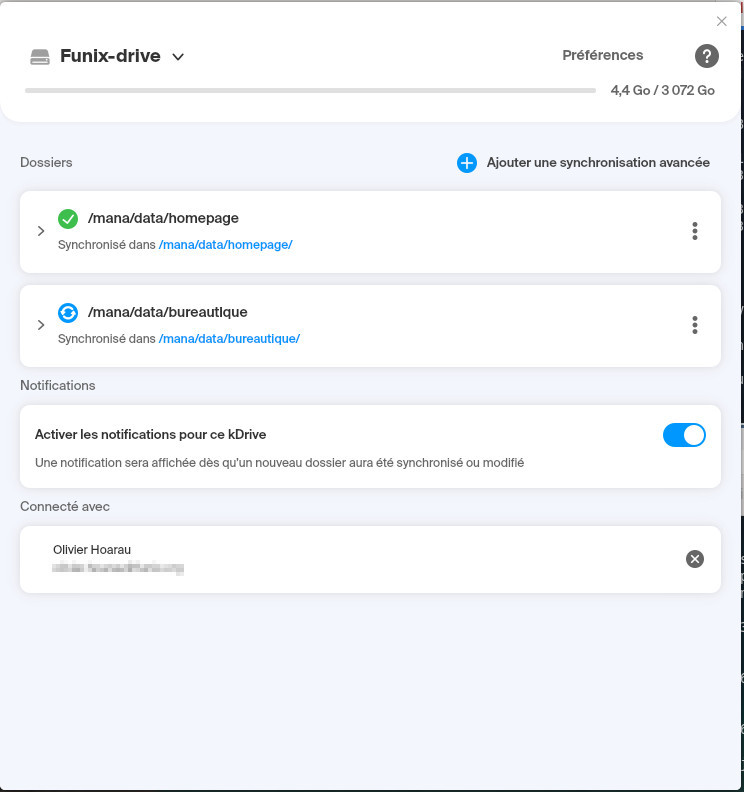

Ensuite on récupèrera l'exécutable Linux au format appimage pour lancer les synchronisations automatiques et qui fonctionne sur n'importe distribution récente, dont ma Mageia 8. Avec cet exécutable on désignera les répertoires à synchroniser, côté local et côté cloud, on pourra le lancer en tâche de fond pour œuvrer en silence. J'ai choisi de ne pas travailler directement sur les fichiers sur le cloud, la référence reste les fichiers locaux et le cloud la sauvegarde.

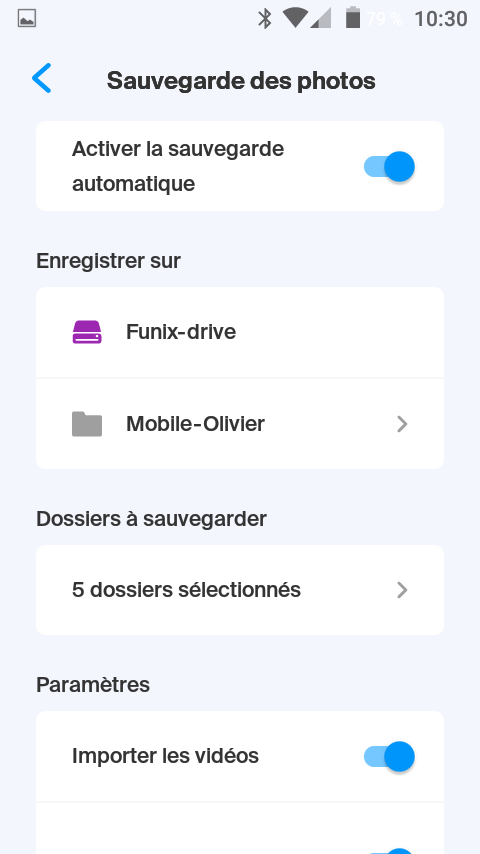

L'équivalent existe également sur Android, c'est un moyen pratique de synchroniser en background les fichiers multimédia qui se trouvent sur le téléphone et de faire le ménage régulièrement.

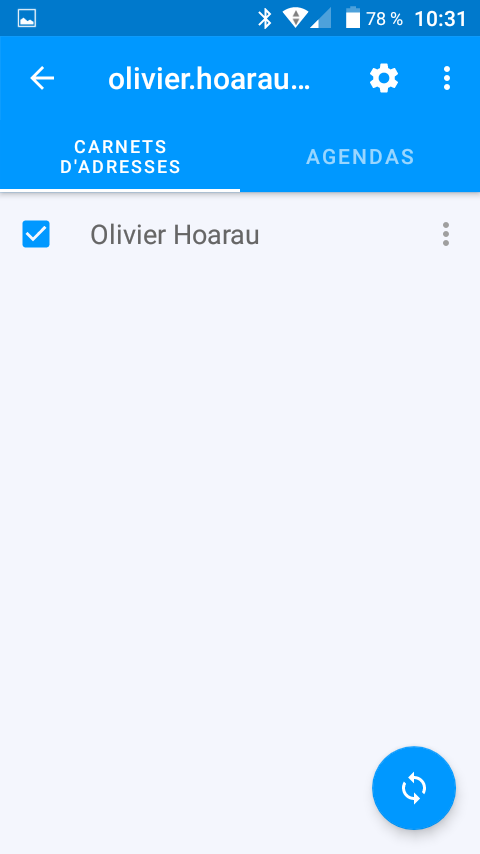

Accessoirement sur Android, on trouvera également un utilitaire de synchronisation des contacts et de l'agenda basé sur le protocole WebDAV.

Côté sécurité, on trouvera également sous Android une application pour assurer une double authentification. Kdrive offre également tous un tas de service que je compte découvrir au fil de l'eau, il s'agit notamment d'outils de travail collaboratif et de transfert de (gros) fichiers.

Les fonctionnalités importantes absentes de kdrive

Sans être exhaustif, j'ai retenu deux fonctionnalités que kdrive n'offre pas (encore) :

Le chiffrement de bout en bout

Le chiffrement de bout en bout ne porte pas sur le transfert des données entre le client et le serveur en utilisant un tunnel de chiffrement comme cela se fait maintenant communément, mais il permet de partager des dossiers et des fichiers entre utilisateurs du partage cloud sans que les dits dossiers et fichiers soient lisibles par une tierce personne y compris les administrateurs d'Infomaniak.

Cette fonctionnalité est actuellement à l'étude (voir par ici) et les utilisateurs de kdrive pourront émettre leurs propres clés de chiffrement.

C'est une pratique qui n'a rien de répréhensible et que les législateurs voudraient pourtant bien interdire ou du moins restreindre que ce soit en Europe (cf. cette résolution) ou aux États Unis (cf. ce projet de loi), mais en attendant c'est la solution pour s'assurer qu'autrui ne puisse avoir accès aux données sans consentement. La réquisition judiciaire reste toujours possible, la CNIL en touche un mot par ici, pour des données hébergées en Suisse l'affaire récente de Protonmail qui a fait l'objet ici de ce journal, montre que la Suisse peut y avoir également recours au nom des accords internationaux sur le terrorisme et la cybercriminalité qu'elle a signés. A noter que cette fonctionnalité existe déjà pour d'autres solutions cloud (MEGA, pCloud entre autres)

La gestion et l'affichage évolués des photos

La gestion et l'affichage des photos restent assez basiques, il est prévu dans un avenir proche des améliorations pour atteindre le standard d'autres solutions cloud. Par ailleurs j'avais parlé dans un post récent sur Digikam, d'outils de recherche et de gestion évolués des photos incluant notamment la reconnaissance faciale dont Photos iCloud d'Apple et certainement d'autres offraient à ses utilisateurs, et bien kdrive ne le permet pas encore même si ce point est en projet (voir ici).

Pour résumer et en guise de conclusion

Pour faire suite à mon dernier journal sur la sauvegarde, le cloud complète mon dispositif de sauvegarde en garantissant que mes données ne partent pas en fumée avec mon serveur local et mes sauvegardes locales, tout en offrant un service de partage à la fois performant et simple d'utilisation à mon cercle familial.

A vrai dire maintenant je ne vois pas ce que je pourrais faire de plus pour améliorer encore mon dispositif, j'ai l'impression d'avoir épuisé le sujet et m'être mis à l'abri d'une nouvelle perte de données tout en ayant étendu le service à l'ensemble de mon cercle familial. Toutefois si vous voyez encore une piste d'amélioration, je reste preneur de tout remarque.

# Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par cg . Évalué à 3.

Merci pour ce chouette journal !

Pour ma part, j'ai une exigence et un besoin supplémentaires.

Je veux chiffrer les données avant de les envoyer chez un tiers. Ça se fait avec duplicity ou ses dérivés par exemple, qui vont gérer le transfert vers un hébergeur (j'avais trouvé Backblaze qui a une offre tarifaire aussi claire que celle de Infomaniak). Bien sûr, avec ça, pas de recherche, pas de partage, juste des blocs de données inexploitables sans la clé. On perd donc en fonctionnalités par-rapport à ta solution.

En faisant une sauvegarde complète par semaine et des incrémentales chaque jour (ou 1 full/mois et 1 incrémentale/semaine), ça se passe bien. En tout cas, sur un petit volume de données, pas trop de problèmes.

Par contre, sur un gros volume, c'est plus compliqué. Refaire une sauvegarde complète par mois ou par semaine quand on a 200To de données, ça consomme de la bande passante et ça prend du temps ! Il semble exister un moyen de "combiner la sauvegarde complète et les incrémentales (synthetic backup) côté serveur, mais je n'ai pas bien compris comment ça fonctionne.

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par Psychofox (Mastodon) . Évalué à 10.

J'utilise restic (et duplicati sur le windows de ma copine) sur du stockage objet wasabi.

Le tout est chiffré.

Il y a quelques années j'avais utilisé crashplan quand ils avaient une offre particulier similaire à backblaze. Les backups/restore entre appareils locaux étaient très efficace mais un jour j'ai testé restaurer 1TB depuis leurs serveurs, les temps de download étaient à des années lumières de leurs temps d'upload si bien que ça aurait pris plusieurs semaines de copie continues. Inutilisable en cas de désastre donc

Bref testez vos temps de restauration, ça peut être important si un jour vous souffrez d'un incendie ou grosse perte de données.

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par cg . Évalué à 3.

Bien vu, c'est un des points qui me fait hésiter entre un stockage "cloud" et un serveur dont je suis le propriétaire. Le prix plaide pour le cloud, sans hésiter (sur les devis que j'ai eu c'est 3 à 5 fois moins cher).

Par contre, quand tu as ton serveur dans un data center pas trop loin, tu peux louer une voiture et aller le chercher pour faire les restaurations sur ton LAN directement (le fameux wagon rempli de bandes).

(Et puis j'aime bien l'idée de louer un van en mode agence tous risques pour trimballer les backups, j'entends presque la symphonie héroïque rien qu'à y penser :D)

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par chimrod (site web personnel) . Évalué à 3.

Avec duplicity, je me suis créé des scripts de sauvegarde et de restauration différenciés :

Si je veux restaurer mes données, je commence par un dégel, puis par un rapatriement sur mon PC, et c’est seulement à ce moment là que je lance la restauration à ce moment là. Je sépare du coup les problèmes réseau des problème de restauration…

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par Psychofox (Mastodon) . Évalué à 4. Dernière modification le 15 novembre 2021 à 11:13.

Ça ne change pas que si ça prend 3 semaines à copier, c'est bien plus chiant que de se faire livrer des disques en 2-3 jours ouvrables. Et accessoirement si tu es dans un cas de disaster recovery avec perte totale, ton environnement local tu l'as pas et dois le reconstruire d'abord en achetant du matériel. Ça ralentit d'autant plus la démarche (et faut avoir penser à garder ses secrets, comme les clés de chiffrements, accessibles ailleurs que sur le backup our l'environnement à reconstruire.

Je crois que crashplan et backblaze ont un service d'envoi de disques, moyennant une modique somme, mais la dernière fois que j'avais vérifié c'était valable uniquement aux USA.

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par chimrod (site web personnel) . Évalué à 3.

Alors là on joue carrément pas dans la même cour :) je parle des photos de ma maman, mon dossier administratif et ce genre de chose. Je pense pas avoir des semaines de transfert pour tout récupérer…

(Et oui, mes clefs gpg sont imprimées et rangées)

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par Psychofox (Mastodon) . Évalué à 3.

Je pars du principe que je peux tout perdre du jour au lendemain. Domicile qui brûle, tremblement de terre, tsunami, que sais-je :)

Si j'ai une copie dans un autre pays c'est pour pallier à ce genre de merde.

Alors certe au début je n'aurais surtout besoin que des papiers administratifs et pas de ma collection de photos et souvenirs de ces 20 dernières années qui peuvent attendre un peu plus. Mais je dois aussi penser qu'une fois que j'ai tout perdu, ma copie unique est celle externalisée, donc j'ai tout intérêt à récupérer toutes les données et en avoir une copie locale. On sait jamais qu'un coup de loi de murphy fait qu'ils aient eux-même des problèmes ou qu'un problème de facturation fait qu'ils te dégomment tes données.

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par ptit_poulet . Évalué à 1.

Ah oui je confirme. Après un crash de mon NAS la 1ère chose que j'ai fait c'est de lancer une copie de la copie (vers un autre serveur temporaire) car avec Murphy j'étais pas à l'abri que le serveur de backup hébergé à l'autre bout de l'Europe se fracasse aussi…

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par barmic 🦦 . Évalué à 3.

Pourquoi n'avoir qu'une seule sauvegarde hors site ? Aussi rapide que soit ta connexion, lors d'une destruction totale de ton équipement local, tu as un spof pour au moins plusieurs jours.

https://linuxfr.org/users/barmic/journaux/y-en-a-marre-de-ce-gros-troll

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par ptit_poulet . Évalué à 2.

Si je prends mon cas, les documents très sensibles sont répliqués sur 6 appareils différents et sur plusieurs sites géographiques car cela ne représente pas un gros volume.

Mais les données moins sensibles qui elles représentent un gros volume ne sont sauvegardées qu'à un seul autre endroit pour des raisons de coûts à l'année. Les limites de l'usage personnel sont souvent les finances malheureusement…

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par Psychofox (Mastodon) . Évalué à 4.

C'est un choix à faire en fonction de l'investissement.

Dans le cas de Wasabi, j'imagine que si j'ai une destruction locale totale je ferais une synchro du bucket vers un bucket dans un autre datacenter avant de rapatrier toutes les données. C'est relativement vite fait.

Personnellement je pense que le point le plus important avant d'avoir n copies c'est de vérifier régulièrement l'intégrité des données sur l'unique sauvegarde hors-site, chose que j'avoue n'avoir pas encore automatisé. Parce que bon synchroniser sur 3 sites différents des fichiers corrompus, ça a peu d'intérêt.

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par mahikeulbody . Évalué à 2.

Ah, on peut faire ça maintenant ? Je suis sur Wasabi et il n'y avait pas cette fonctionnalité quand ils ont créé leur datacenter en Hollande ; il avait fallu que je ré-upload tout.

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par Psychofox (Mastodon) . Évalué à 3.

Je ne crois pas que la fonctionnalité existe mais si j'avais besoin je ferais ça depuis un vps avec minio ou rclone.

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par mahikeulbody . Évalué à 4.

+1 pour restic et le stockage objet de wasabi (environ 5$/mois pour 1 To). API Amazon S3 et bonnes performances.

[^] # Re: Chiffrement avant le transfert, sauvegardes "synthétiques"

Posté par Graveen . Évalué à 2.

rclone

duplicati

j'utilise ces 2 outils.

# Offre à vie pcloud

Posté par saltimbanque (site web personnel) . Évalué à 5.

Plusieurs articles élogieux m'ont vanté Pcloud et dès que mon HDD a cramé, et après restauration des data (enfin celle du mois d'avant! bien fait pour moi!), j'ai voulu tester leur offre à vie, n'en ayant pas trouvé ailleurs. Le montant est important, 350€!, mais, à vie. Donc par exemple si un abonnement me coûtait 10€ par mois il me reviendrait à 350€ en à peu près 3 ans.

Est-ce que j'utiliserai Pcloud plus de 3 ans? J'imagine que oui. 2 To deviendront relativement peu à la longue, puis deviendront ridiculement petits, mais j'ai encore beaucoup de marge en sauvant tout ce qui m'importe.

Maintenant il n'y a rien d'open source là dedans. Mais cela fonctionne très bien sous Linux (client distribué au format Appimage) ou Android. Le client Linux se base sur l'idée d'un disque virtuel. J'étais plutôt parti sur une autre idée mais finalement un disque virtuel c'est simple et ça marche. L'appli Android fait le boulot mais me séduit moins car je n'ai pas trouvé pour avoir accès aux fichiers hors lignes directement depuis d'autres applications ( il faut passer par l'interface de leur appli pour accéder aux fichiers hors lignes, ce qui ne convient pas à toutes les manières de faire). Ça reste sympa de pousser instantanément toute image ou tout ce que je veux sur le cloud!

Le chiffrement c'est uniquement côté serveur. Chiffrer côté client c'est faisable mais ça vous coûte un bras.

Pas non plus de service particulier. Agenda, calendrier, notes, je ne sais quoi, oubliez, c'est sans fioriture, fichiers fichiers fichiers! Mais bon je peux très bien m'autohéberger pour ces services et sauvegarder sur Pcloud.

Je reste malheureux de ne pas avoir trouvé un équivalent FOSS ou préservant plus de libertés. Un Nextcloud à vie m'aurait envouté par exemple.

[^] # Re: Offre à vie pcloud

Posté par Faya . Évalué à 4.

Le client, non (même la version CLI). Le serveur non plus… Mais ils ont quelques dépôts sous licence MIT, principalement des SDK : https://github.com/pCloud

125$ à vie pour le chiffrement côté client, ça me paraît pas si cher payé (enfin tout dépend combien de temps on a l'intention de vivre… et si l'entreprise elle-même nous survit)

[^] # Re: Offre à vie pcloud

Posté par cosmocat . Évalué à 3.

J'utilise également pcloud avec https://rclone.org/#providers pour uploader et https://www.borgbackup.org/ pour backuper et les chiffrer côté client.

[^] # Re: Offre à vie pcloud

Posté par gUI (Mastodon) . Évalué à 7.

Attention à ne pas se oublier que le "à vie" n'est pas la tienne, mais la leur : si la boite ferme, le contrat est fini (et dans les cas des sauvegardes, ce n'est pas jouer sur les mots).

En théorie, la théorie et la pratique c'est pareil. En pratique c'est pas vrai.

[^] # Re: Offre à vie pcloud

Posté par saltimbanque (site web personnel) . Évalué à 3. Dernière modification le 15 novembre 2021 à 10:34.

Le bon point étant que si je vis plus longtemps que cette boîte j'aurai au moins une satisfaction :)

On peut aussi noter que l'offre "à vie" a en réalité une limite de 99 ans. Auraient t'il peur de la cryogénisation?

Je n'ai pas trouvé de publication financière malheureusement. En 2019 visiblement il y a eu une annonce comme quoi la boîte était bénéficiaire, à l'époque elle mentionnait 9 millions d'utilisateurs (1). Aujourd'hui pCloud mentionne 14 millions d'utilisateurs (2).

Il aurait été appréciable que pCloud communique un peu plus de chiffres sur leur site web pour se faire une meilleure idée. Sinon hormis les chiffres on peut se poser la question plus largement, est-ce que ce genre de boîte a vocation à survivre, mais à moyen terme je ne vois pas trop ce qui viendrait remettre en cause le principe

(1) https://techcrunch.com/2019/04/16/dropbox-challenger-pcloud-just-became-profitable/

(2) https://www.pcloud.com/fr/company/about.html

[^] # Re: Offre à vie pcloud

Posté par Dring . Évalué à 4. Dernière modification le 15 novembre 2021 à 10:07.

Faudrait que je revérifie, mais il me semble qu'en droit français (et ce n'est probablement pas le seul pays), il est impossible de faire un contrat éternel ; d'où cette limite à 99 ans qu'on retrouve souvent.

Rien à voir donc avec une crainte quelconque, c'est juste une contrainte juridique, qui comme souvent est là pour protéger des abus.

[^] # Re: Offre à vie pcloud

Posté par Dring . Évalué à 3.

Tiens: https://www.legifrance.gouv.fr/codes/article_lc/LEGIARTI000032041412

"Les engagements perpétuels sont prohibés."

On peut aussi avoir un engagement à durée indéterminée, mais avec des clauses de rupture (à l'initiative de n'importe laquelle des parties).

[^] # Re: Offre à vie pcloud

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 2.

P.S. 1 admin pour virer du 1er lien le « ? » et tout ce qui suit ?

“It is seldom that liberty of any kind is lost all at once.” ― David Hume

[^] # Re: Offre à vie pcloud

Posté par gUI (Mastodon) . Évalué à 3.

Fait, merci

En théorie, la théorie et la pratique c'est pareil. En pratique c'est pas vrai.

[^] # Re: Offre à vie pcloud

Posté par Christophe . Évalué à 3.

Que ce soit un abonnement ou un forfait, de toutes façons, si la boîte coule c'est terminé pour la sauvegarde.

Donc finalement, ici, on peut simplement espérer que pCloud survive au moins 3 ans, et ensuite ça devient de plus en plus intéressant financièrement pour le client.

Perso j'ai également choisi cette offre: le risque est faible que pCloud coule à court terme, et il n'y a pas la question de ce qui arrive si le paiement cesse.

Pour l'instant c'est satisfaisant, et pour les données sensible j'encrypte chez moi avec rclone.

[^] # Re: Offre à vie pcloud

Posté par saltimbanque (site web personnel) . Évalué à 5.

A propos de rclone : j'avais en tête (journaux sur ce même site?) que encrypter soi même pour pousser sur du cloud était délicat, parce que cela compromettait le principe de ne pousser que les modifications. Est-ce qu'il y a un truc particulier avec rclone qui évite cela?

[^] # Re: Offre à vie pcloud

Posté par Christophe . Évalué à 4.

L'encryption proposée par rclone est faite fichier par fichier (le nom aussi peut être encrypté). Donc c'est mieux qu'un disque virtuel complètement crypté, et moins bien qu'une encryption bloc par bloc.

Au quotidien, seuls les fichiers modifiés sont ré-envoyés, ce qui me convient bien.

[^] # Re: Offre à vie pcloud

Posté par jyes . Évalué à 4.

C’est là la raison d’être de logiciels comme CryFS qui me semble bien rentrer dans la conversation ici mais avec lequel j’avoue avoir trop peu d’expérience pour juger de sa qualité.

[^] # Re: Offre à vie pcloud

Posté par barmic 🦦 . Évalué à 2.

Comment ce genre d'offre à vie peut être viable ?

https://linuxfr.org/users/barmic/journaux/y-en-a-marre-de-ce-gros-troll

[^] # Re: Offre à vie pcloud

Posté par BAud (site web personnel) . Évalué à 3. Dernière modification le 16 novembre 2021 à 00:55.

cf. https://www.humour-culte.fr/video-humour/films/la-cite-de-la-peur-on-peut-tromper-une-fois-mille-personnes/

tant que t'as payé le disque dur une fois, tu peux le refourguer à 1000 personnes

;-)

le calcul précis est laissé à titre d'exercice :p

[^] # Re: Offre à vie pcloud

Posté par barmic 🦦 . Évalué à 2.

C'est pas faux

https://linuxfr.org/users/barmic/journaux/y-en-a-marre-de-ce-gros-troll

# Mon « cloud » perso

Posté par Adrien . Évalué à 9.

De mon côté je sauvegarde avec borg (chiffré) sur 2 raspberrypi(+2disques externes), placés à deux endroit différents (famille, amis…), sur lequel tourne simplement ssh+borg.

L'avantage est que cela coute très peu cher, est bien sécurisé, et je maitrise bien la localisation physique de mes données. Avec l'avènement de la fibre pour les particuliers, c'est une solution très pratique !

Seul inconvénient : borg ne permet pas tellement la sauvegarde des Android…

[^] # Re: Mon « cloud » perso

Posté par Funix (site web personnel, Mastodon) . Évalué à 3.

C'est juste, mais cela fait un peu plus que de la sauvegarde, je n'insiste sans doute pas suffisamment là dessus dans mon journal, puisque cela ouvre la possibilité de faire du partage de données à distance très simplement. Pour cela j'avais mis en place un VPN privé (cf. cet autre journal), mais cela reste assez lourdingue et pas forcément très performant d'autant que j'habite dans la pampa, certes en bord de mer, mais on ne peut pas tout avoir puisque je dois me contenter d'une connexion ADSL.

https://www.funix.org mettez un manchot dans votre PC

[^] # Re: Mon « cloud » perso

Posté par Epy . Évalué à 3. Dernière modification le 14 novembre 2021 à 13:45.

En revanche un Nextcloud avec une appli de synchro, oui:

https://fossforce.com/2021/11/nextcloud-announces-a-new-backup-application-for-its-home-users/

à tester :) Les données exportées pourront probablement être incluses dans borg ensuite

J'utilise CalCardBackup pour calendriers + contacts de Nextcloud pour le moment: https://codeberg.org/BernieO/calcardbackup mais j'avoue ne pas avoir eu à restaurer encore

[^] # Re: Mon « cloud » perso

Posté par Psychofox (Mastodon) . Évalué à 6.

Je suis le seul à trouver à peu près inutilisable l'appli nextcloud sur android?

Alors oui elle synchronize mes photos et vidéos mais plus ou moins quand ça lui chante et l'appli se fige bien souvent quand on veut la consulter.

[^] # Re: Mon « cloud » perso

Posté par Julien_J06 . Évalué à 1.

J'ai pas de relevé de soucis gênant ou bloquant à l'utilisation, je ne synchronises pas (encore) de données de mon téléphone vers NextCloud mais de NC vers mon téléphone (en téléchargeant manuellement depuis l'application)

Julien_c'est_bien (y'a pas que Seb)

[^] # Re: Mon « cloud » perso

Posté par gouttegd . Évalué à 2.

J’ai effectivement constaté ça au début, mais je n’ai plus eu ce genre de problèmes, depuis environ un an je dirais.

# Viser Mars

Posté par tisaac (Mastodon) . Évalué à 3.

Il me semble que le next step est d'avoir un backup sauvegardé sur Mars, la Lune ou un truc du genre pour se prémunir d'un météorite sur la terre ou autre catastrophe du genre :-D

Merci pour cette série de journaux !

Surtout, ne pas tout prendre au sérieux !

[^] # Re: Viser Mars

Posté par Funix (site web personnel, Mastodon) . Évalué à 5.

Oui, bonne idée, je vais me rapprocher de Thomas Pesquet pour lui confier un backup quand il ira sur la lune.

https://www.funix.org mettez un manchot dans votre PC

[^] # Re: Viser Mars

Posté par flavien75 . Évalué à 1.

par contre je te raconte le ping quand tu auras besoin de récupérer tes données

Les vrais naviguent en -42

[^] # Re: Viser Mars

Posté par Psychofox (Mastodon) . Évalué à 5.

Ce qui compte c'est la bande passante. Pour récupérer les données tu renvoies Thomas ou ses futurs collègues.

[^] # Re: Viser Mars

Posté par cosmocat . Évalué à 3.

Et le coût. Si c'est à toi de financer le lancement, ça va commencer à faire cher…

[^] # Re: Viser Mars

Posté par polochon . Évalué à 1. Dernière modification le 15 novembre 2021 à 21:33.

Il y a deja des pi dans l'iss: https://esero.fr/projets/astro-pi/

Reste plus qu'à installer borg et hop!

Ça se tente :-)

[^] # Re: Viser Mars

Posté par Arkem . Évalué à 4.

Je trépigne d'impatience à l'idée de pouvoir sauvegarder un jour sur Alpha du Centaure en cas de supernova

[^] # Re: Viser Mars

Posté par NicolasP . Évalué à 5.

C'est pour dans même pas un demi-siècle.

Par contre 4,3 AL dans le meilleur des cas, ça ne va pas changer grand chose en cas de supernova. Il va falloir viser plus loin.

[^] # Re: Viser Mars

Posté par gUI (Mastodon) . Évalué à 3.

On est bien d'accord que le ping minimal c'est donc 4,3 années ? Ouais tendu quand même…

En théorie, la théorie et la pratique c'est pareil. En pratique c'est pas vrai.

[^] # Re: Viser Mars

Posté par Kioob (site web personnel) . Évalué à 4.

Beh non, le ping mini est 8.6 AL

alf.life

[^] # Re: Viser Mars

Posté par gUI (Mastodon) . Évalué à 4.

Ah oui évidemment, l'aller-retour !

Sinon le ping c'est en année (durée), pas en année lumière (distance)

En théorie, la théorie et la pratique c'est pareil. En pratique c'est pas vrai.

[^] # Re: Viser Mars

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 2.

Et le calcul suppose d'utiliser la fibre intergalactique pour la transmission…

“It is seldom that liberty of any kind is lost all at once.” ― David Hume

[^] # Re: Viser Mars

Posté par NicolasP . Évalué à 3.

On appelle ça des ondes radios. Et pour continuer de pinailler, pas besoin que ça soit intergalactique, Alpha du Centaure est dans la même galaxie que nous.

[^] # Re: Viser Mars

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 2.

Ou intragalactique alors, mais peu importe : le plus important dans mon propos était qu'il fallait un « équivalent fibre optique » (je ne pointe étrangement pas de techno exacte pour du pinaillage parce-que le plus important dans mon propos est d'aller à la vitesse de la lumière) Il est cependant vrai que le Deep Space Network utilise surtout la bande X…

“It is seldom that liberty of any kind is lost all at once.” ― David Hume

[^] # Re: Viser Mars

Posté par cg . Évalué à 2.

Peu importe, peu importe… Pour la latence, les ondes radios, c'est le must, monsieur !

Extrait de l'article Spread Networks de Wikipedia:

Si le sujet vous intéresse, il y a le livre docu-fiction Flash Boys (de Michael Lewis) sur le trading haute fréquence, qui devrait satisfaire les plus geeks. Il y a aussi les bouquins d'Alexandre Laumonier (tomes 6, 5, et 4, le tome 6 étant à mon sens le plus intéressant, car il retrace l'histoire de la bourse ces derniers siècles. Ceci dit le tome 4 commence par une vente au enchères paltipante). Le sieur Laumonier s'est passionné pour les liaisons utilisés par les traders haute-fréquence, et même en trouvant que c'est le mal, j'avoue que c'est de la belle ouvrage, ces réseaux.

[^] # Re: Viser Mars

Posté par ptit_poulet . Évalué à 6.

Heuu les gars je vous arrête de suite ! C'est pas pour rien que les Anciens ont créé la porte des étoiles… c'est justement pour gagner du temps pour les sauvegardes/restaurations.

[^] # Re: Viser Mars

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 2.

Bien vu ; je l'oublies trop souvent ;-)

“It is seldom that liberty of any kind is lost all at once.” ― David Hume

# Rclone avec infomaniak

Posté par toumani . Évalué à 3.

Comme j'utilise aussi Infomaniak pour mes sauvegardes et que je n'ai pas non plus d'actions dans la boîte, j'en profite pour signaler que tu peux aussi passer par rclone et rclone-browser pour synchroniser tes données. De mon côté, j'utilise ça pour sauvegarder mes données de travail à la fin de la journée. J'ai une commande standard

qui me permet de faire ça en 5mns de manière systématique. C'est pratique, surtout avec le nombre de pdfs que j'accumule et auxquels je tiens.

[^] # Re: Rclone avec infomaniak

Posté par Funix (site web personnel, Mastodon) . Évalué à 2.

en gros c'est ce que fait l'appimage kdrive si je comprends bien

https://www.funix.org mettez un manchot dans votre PC

[^] # Re: Rclone avec infomaniak

Posté par cg . Évalué à 1.

Ça m'a semblé simple, et j'ai peu de données (moins de 50Go), je me suis lancé !

Donc j'ai maintenant un backup distant (mais chiffré avant le transfert), avec rclone.

Merci encore pour ce journal qui m'a motivé !

[^] # Re: Rclone avec infomaniak

Posté par Funix (site web personnel, Mastodon) . Évalué à 2.

peux tu détailler un peu, je viens d'installer rclone mais visiblement il faut rajouter l'option swiss backup, on ne peut pas le faire simplement avec kdrive ?

https://www.funix.org mettez un manchot dans votre PC

[^] # Re: Rclone avec infomaniak

Posté par cg . Évalué à 3.

En effet, kdrive et swiss backup sont deux services différents.

kdrive va te faire des synchros entre appareils, Swissbackup est un stockage objet compatible Swift destiné à y mettre des fichiers.

Je m'attendais à suer un peu pour configurer rclone, mais en fait, le site de Infomaniak t'affiche les commandes à taper et génère même un bout de conf rclone. Par contre ce bout de conf est pour un bucket non chiffré.

Donc infomaniak te crée un premier bout de config rclone.conf, à mettre dans

.config/rclone/rclone.conf:[swissbackup]

type = swift

user = SBI-ABC123

key = dslkdlj43lk

auth = https://swiss-backup02.infomaniak.com/identity/v3

domain = default

tenant = sb_project_SBI-ABC123

tenant_domain = default

region = RegionOne

storage_url =

auth_version =

Ceci te crée un "remote" nommé swissbackup.

Et ensuite, si tu veux des backups chiffrés, tu ajoutes un remote dans ce remote (ici swissbackup:secret) :

[secret]

type = crypt

remote = swissbackup:secret

password = kljferklfjerklfjewrklgjwrefrjrklgwrjgl [etc...]

password2 = fsdfjldfjasdlfjdsl [etc...]

Avec

rclone config, ça se fait très simplement, faut répondre à des questions. J'ai ensuite trouvé ces options pour ne pas sauvegarder des trucs inutiles et accélérer les transferts :rclone --log-file=/tmp/backup-swiss.log sync -Pl --skip-links --transfers=32 --exclude "/.mu/**" --exclude "/.cache/**" --exclude "/.config/discord/Cache/**" --exclude "/.config/discord/Code\ Cache/**" --exclude "/Downloads/**" --delete-excluded /home/moi secret:moi

Les options :

-P : indiquer l'avancement (progress)

-l : convertir les liens symboliques en fichiers normaux (et inversement au restore)

--skip-links : ne pas buter sur les liens symboliques mal transférés.

--delete-excluded : supprimer, côté backup, les fichiers exclus (pratique si on complète la liste d'exclusion après un premier backup.

Avec cette config, ça prend 10 minutes avec des pointes à 40Mbps pour tout scanner et envoyer les changements. Le plus gros du temps est dans mon dossier de mails qui est en maildir et contient environ 70000 petits fichiers.

À la fin, avec rclone-browser, tu peux aller vérifier à la main qu'il y a bien ce que tu crois sur les serveurs distants. Je te recommande de tester avec un petit sous-répertoire léger, ça m'a pris quelques essais de comprendre la syntaxe d'

exclude!.J'ai mis mes options dans un script et hop.

~$ backup-swiss

Enter configuration password:

password:

Transferred: 42.394 MiB / 42.394 MiB, 100%, 142.500 KiB/s, ETA 0s

Checks: 127579 / 127579, 100%

Deleted: 1 (files), 0 (dirs)

Transferred: 78 / 78, 100%

Elapsed time: 8m15.0s

[^] # Re: Rclone avec infomaniak

Posté par cg . Évalué à 1.

jnettop m'a tué, c'était 40MBytes/s, donc environ 300Mbits/s :-o

[^] # Re: Rclone avec infomaniak

Posté par Funix (site web personnel, Mastodon) . Évalué à 2.

OK merci, mais je comprends donc qu'il faut prendre une option supplémentaire (même si c'est pas la mer à boire, c'est à partir de 2,4€ par mois)

https://www.funix.org mettez un manchot dans votre PC

# next cloud ? pareil

Posté par steph1978 . Évalué à 4.

Cela ressemble furieusement à du NextCloud et c'est tant mieux.

Je trouve aussi que c'est très compétitif en terme de prix.

Je n'ai pas complètement compris comment se faisait la sauvegarde ? à partir du PC ? Lancée à la main ?

J'ai mis en place le dispositif suivant :

Comme j'ai installé NextCloud sur un serveur loué sur lequel j'ai la main, je fais du SSH directement dessus. Ainsi la sauvegarde n'est pas dépendante du PC.

Cela couvre :

# L’œuf et la poule - la clé de chiffrement

Posté par cg . Évalué à 3.

C'est évoqué rapidement dans les commentaires, mais je voulais savoir comment vous faites pour stocker la clé de chiffrement (ou déchiffrement si asymétrique), sans que ce soit dans l'ordi ou le même endroit que l'ordi protégé ?

J'ai quelques pistes d'après des articles lus ici et là, mais je voulais un retour de "terrain".

[^] # Re: L’œuf et la poule - la clé de chiffrement

Posté par Psychofox (Mastodon) . Évalué à 6.

Différentes options:

Toute combinaisons de ces propositions.

Dans tous les cas la clé de chiffrement est forcément présente sur l'ordi protégé ainsi que les clés API pour copier les données, sauf si on passe par une serveur de backup local. Il faut donc dans ce cas s'assurer de l'immutabilité des données distantes en utilisant des clés d'API qui n'ont pas de droits administratifs. Idéalement si on ne passe pas par une serveur de backup local, il vaut mieux avoir des clés de chiffrement et d'API différentes pour chaque pc protégés et que celles-ci n'aient accès qu'à des espaces séparés (buckets s3 différents, etc) et on ne copie les clés d'e chiffrement et d'API d'une machine à l'autre que sur un besoin ponctuel pour restaurer les données sur un autre ordi.

[^] # Re: L’œuf et la poule - la clé de chiffrement

Posté par cg . Évalué à 1.

Merci, mais qu'as-tu choisi par exemple (si ça te semble honnête de l'écrire sur le net :)) ?

Le coffre en banque, ça semble solide comme offre et accessible à la famille en cas de décès. C'est relativement cher (140€/an pour ma banque), mais c'est offline, donc immune à pas mal de type d'attaques (j'ai pas de frère jumeau par exemple).

Pour 10€/an je peux avoir un bitwarden hébergé aux états-unis (chez Azure). Et ça donne des sous à un logiciel open-source (il semble y avoir plusieurs licences, pas certain que ce soit libre). Je peux y stocker seulement mes clés de backups, ou migrer mon Keepass dedans. Mais en cas de décès, ben personne n'aura accès à mes docs.

La solution de faire une enveloppe avec la clé genre chez de la famille pourrait être pas mal. Peut-être qu'un notaire ferait l'affaire aussi, dans le testament par exemple (quelle matinée sinistre :D).

Bon faut que je fasse mon choix avant que les flammes n’atteignent mon laptop :)

Suivre le flux des commentaires

Note : les commentaires appartiennent à celles et ceux qui les ont postés. Nous n’en sommes pas responsables.