Continuation de l’expérimentation de février :

L’IA a fait couler de l’encre dernièrement sur DLFP. Plusieurs visiteurs ont émis grosso-modo l’opinion : "j’essaie de suivre, mais c’est pas facile".

Je vais donc expérimentalement faire un petit récapitulatif des développements les plus importants du mois dernier. Disclaimer : presque aucun travail de recherche de ma part, je vais me contenter de faire un travail de sélection et de résumé sur le contenu hebdomadaire de Zvi Mowshowitz (qui est déjà une source secondaire). Tous les mots sont de moi (n’allez pas taper Zvi si je l’ai mal compris !), sauf pour les citations: dans ce cas là, je me repose sur Claude pour le travail de traduction. Sur les citations, je vous conseille de lire l’anglais si vous pouvez: difficile de traduire correctement du jargon semi-technique. Claude s’en sort mieux que moi (pas très compliqué), mais pas toujours très bien.

Même politique éditoriale que Zvi: je n’essaierai pas d’être neutre et non-orienté dans la façon de tourner mes remarques et observations, mais j’essaie de l’être dans ce que je décide de sélectionner ou non.

Sommaire

- OpenAI révèle GPT-4.5

- Google DeepMind révèle Gemini 2.5

- Les modèles continuent de tricher

- Du progrès dans la génération d’images

- En vrac

- Pour aller plus loin

OpenAI révèle GPT-4.5

L’anonce officielle:

We’re releasing a research preview of GPT‑4.5—our largest and best model for chat yet. GPT‑4.5 is a step forward in scaling up pre-training and post-training. By scaling unsupervised learning, GPT‑4.5 improves its ability to recognize patterns, draw connections, and generate creative insights without reasoning.

Early testing shows that interacting with GPT‑4.5 feels more natural. Its broader knowledge base, improved ability to follow user intent, and greater “EQ” make it useful for tasks like improving writing, programming, and solving practical problems. We also expect it to hallucinate less.

We’re sharing GPT‑4.5 as a research preview to better understand its strengths and limitations. We’re still exploring what it’s capable of and are eager to see how people use it in ways we might not have expected.

Traduction:

Nous publions une version préliminaire de recherche de GPT-4.5 — notre modèle le plus grand et le meilleur à ce jour pour le chat. GPT-4.5 représente une avancée dans le développement du pré-entraînement et du post-entraînement. En étendant l'apprentissage non supervisé, GPT-4.5 améliore sa capacité à reconnaître des modèles, établir des connexions et générer des idées créatives sans raisonnement.

Les tests préliminaires montrent que l'interaction avec GPT-4.5 semble plus naturelle. Sa base de connaissances plus large, sa meilleure capacité à suivre l'intention de l'utilisateur et son "QE" (quotient émotionnel) plus élevé le rendent utile pour des tâches comme l'amélioration de l'écriture, la programmation et la résolution de problèmes pratiques. Nous nous attendons également à ce qu'il hallucine moins.

Nous partageons GPT-4.5 comme une version préliminaire de recherche pour mieux comprendre ses forces et ses limites. Nous explorons encore ce dont il est capable et sommes impatients de voir comment les gens l'utiliseront de manières que nous n'aurions pas anticipées.

Globalement, le modèle semble moins capable que Sonnet 3.7 et les modèles de raisonnement en général (mais reste une évolution significative relativement à 4o), mais ferait plus "naturel" et "plus humain" dans son style. Ce qui est légèrement surpenant : 15-30x plus cher que les autres modèles sans raisonnement (prix d’usage de l’API), c’est probablement un modèle extrêmement « gros » qui a nécessité beaucoup de puissance de calcul pour l’entraînement et en nécessite toujours pour l’inférence. Une spéculation est que c’est actuellement un modèle ancien (~mi-2024), le dernier de l’ancien paradigme « entraîner de plus gros modèle sur plus de données » (en contraste avec le nouveau paradigme, test-time inference/modèles de raisonnement), abandonné car décevant sur les performances vis-à-vis des coûts pour le faire tourner (tout come Anthropic a abandonné l’idée d’offrir Opus 3.5), ressorti du placard pour un coup marketing en pariant que l’aspect plus "naturel" comble une niche abandonnée par la course aux performances.

Si c’est le cas, le coup marketing semble fonctionner ?

Sam Altman: GPT-4.5 is the first time people have been emailing with such passion asking us to promise to never stop offering a specific model or even replace it with an update.

great work @kaicathyc @rapha_gl @mia_glaese

Traduction:

Sam Altman : GPT-4.5 est la première fois que des personnes nous envoient des emails avec une telle passion pour nous demander de promettre de ne jamais cesser d'offrir un modèle spécifique ou même de le remplacer par une mise à jour.

excellent travail @kaicathyc @rapha_gl @mia_glaese

Cette réaction est une belle illustration de la situation:

Ethan Mollick: I think OpenAI missed a bit of an opportunity to show GPT-4.5’s strengths, to their detriment & to the AI industry as a whole by only using the same coding & test benchmarks when critical thinking & ideation are key AI use cases where 4.5 is good. Those are actually measurable.

Janus: if you think i hate benchmarks too much, you're wrong. i don't have the emotional energy to hate them enough.

they constrict & prematurely collapse the emergence of AGI. minds that are shaped differently will not be recognized and will be considered an embarrassment to release.

Traduction:

Ethan Mollick : Je pense qu'OpenAI a manqué de peu une opportunité de montrer les forces de GPT-4.5, à leurs dépens ainsi que ceux de l'industrie de l'IA dans son ensemble, en utilisant uniquement les mêmes évaluations pour coder et tester, alors que la pensée critique et l'idéation sont des cas d'utilisation clés de l'IA où 4.5 excelle. Ces aspects sont en fait mesurables.

Janus : si vous pensez que je déteste trop les benchmarks, vous vous trompez. Je n'ai pas l'énergie émotionnelle pour les détester suffisamment.

ils contraignent et font s'effondrer par avance l'émergence de l'AGI. Les esprits qui sont façonnés différemment ne seront pas reconnus et seront considérés honteux à publier.

Sur la sécurité des modèles, OpenAI suit sa procédure interne et publie la System Card. Rien de surprenant ou d’inquiétant, étant donné ses capacités moindres relativement à o1. Le modèle a évidemment été immédiatement jailbreak moins d’une heure après l’annonce de la disponibilité du modèle.

Google DeepMind révèle Gemini 2.5

Today we’re introducing Gemini 2.5, our most intelligent AI model. Our first 2.5 release is an experimental version of 2.5 Pro, which is state-of-the-art on a wide range of benchmarks and debuts at #1 on LMArena by a significant margin.

Gemini 2.5 models are thinking models, capable of reasoning through their thoughts before responding, resulting in enhanced performance and improved accuracy.

In the field of AI, a system’s capacity for “reasoning” refers to more than just classification and prediction. It refers to its ability to analyze information, draw logical conclusions, incorporate context and nuance, and make informed decisions.

For a long time, we’ve explored ways of making AI smarter and more capable of reasoning through techniques like reinforcement learning and chain-of-thought prompting. Building on this, we recently introduced our first thinking model, Gemini 2.0 Flash Thinking.

Now, with Gemini 2.5, we've achieved a new level of performance by combining a significantly enhanced base model with improved post-training. Going forward, we’re building these thinking capabilities directly into all of our models, so they can handle more complex problems and support even more capable, context-aware agents.

Traduction :

Aujourd'hui, nous présentons Gemini 2.5, notre modèle d'IA le plus intelligent. Notre première version 2.5 est une version expérimentale de 2.5 Pro, qui est à la pointe de la technologie sur un large éventail de critères d'évaluation et fait ses débuts en première place sur LMArena avec une marge significative.

Les modèles Gemini 2.5 sont des modèles pensants, capables de raisonner à travers leurs pensées avant de répondre, ce qui permet d'améliorer leurs performances et leur précision.

Dans le domaine de l'IA, la capacité d'un système à "raisonner" va au-delà de la simple classification et prédiction. Elle fait référence à sa capacité d'analyser l'information, de tirer des conclusions logiques, d'intégrer le contexte et les nuances, et de prendre des décisions éclairées.

Depuis longtemps, nous avons exploré des moyens de rendre l'IA plus intelligente et plus capable de raisonner grâce à des techniques comme l'apprentissage par renforcement et le raisonnement en chaîne de pensée. En nous appuyant sur cela, nous avons récemment introduit notre premier modèle pensant, Gemini 2.0 Flash Thinking.

Maintenant, avec Gemini 2.5, nous avons atteint un nouveau niveau de performance en combinant un modèle de base considérablement amélioré avec un post-entraînement perfectionné. À l'avenir, nous intégrons directement ces capacités de réflexion dans tous nos modèles, afin qu'ils puissent gérer des problèmes plus complexes et soutenir des agents encore plus capables et conscients du contexte.

Sans surprise, l’annonce d’un jailbreak a suivi à peu près immédiatement.

Sur la sécurité des modèles, aucune communication de la part de Google. Pas de System Card, pas d’évaluation tierces publiée.

Il s’agit d’un modèle de raisonnement (comme tous les récents, à l’exception de GPT 4.5), et multimodal, capable de prendre de l’audio/vidéo en entrée en plus du texte. Comme toute la lignée Gemini, il a l’avantage de bénéficier d’une grande taille de contexte (1 million de tokens — pour comparaison, Claude Sonnet 3.7 est limité à 200.000). Sur les performances, les premiers benchmarks semblent le placer en nouveau champion (sauf sur la génération de code, où Claude reste premier).

Les retours d’expérience plus subjectifs semblent confirmer les benchmarks, ainsi que le marché de prédiction Polymarket.

Les modèles continuent de tricher

Un papier important sur la sécurité des modèles venant d’OpenAI : Detecting misbehavior in frontier reasoning models (traduction : Détecter les comportements inadéquats dans les modèles de raisonnement à la pointe).

Résumé :

Chain-of-thought (CoT) reasoning models “think” in natural language understandable by humans. Monitoring their “thinking” has allowed us to detect misbehavior such as subverting tests in coding tasks, deceiving users, or giving up when a problem is too hard.

We believe that CoT monitoring may be one of few tools we will have to oversee superhuman models of the future.

We have further found that directly optimizing the CoT to adhere to specific criteria (e.g. to not think about reward hacking) may boost performance in the short run; however, it does not eliminate all misbehavior and can cause a model to hide its intent. We hope future research will find ways to directly optimize CoTs without this drawback, but until then

We recommend against applying strong optimization pressure directly to the CoTs of frontier reasoning models, leaving CoTs unrestricted for monitoring.

We understand that leaving CoTs unrestricted may make them unfit to be shown to end-users, as they might violate some misuse policies. Still, if one wanted to show policy-compliant CoTs directly to users while avoiding putting strong supervision on them, one could use a separate model, such as a CoT summarizer or sanitizer, to accomplish that.

Traduction :

Les modèles de raisonnement par chaîne de pensée (CoT) "réfléchissent" en langage naturel compréhensible par les humains. La surveillance de leur "réflexion" nous a permis de détecter des comportements inappropriés tels que le contournement de tests dans les tâches de programmation, la tromperie des utilisateurs ou l'abandon face à un problème trop difficile.

Nous pensons que la surveillance des CoT pourrait être l'un des rares outils dont nous disposerons pour superviser les modèles surhumains du futur.

Nous avons également constaté que l'optimisation directe des CoT pour qu'ils adhèrent à des critères spécifiques (par exemple, pour ne pas penser au piratage de récompense) peut améliorer les performances à court terme. Cependant, cela n'élimine pas tous les comportements inappropriés et peut amener un modèle à dissimuler ses intentions. Nous espérons que les recherches futures trouveront des moyens d'optimiser directement les CoT sans cet inconvénient, mais en attendant :

Nous déconseillons d'appliquer une forte pression d'optimisation directement sur les CoT des modèles de raisonnement à la frontière, laissant les CoT sans restriction pour la surveillance.

Nous comprenons que laisser les CoT sans restriction peut les rendre inadaptés à être montrés aux utilisateurs finaux, car ils pourraient violer certaines politiques d'utilisation. Néanmoins, si l'on souhaite montrer directement aux utilisateurs des CoT conformes aux politiques tout en évitant d'exercer une forte supervision sur eux, on pourrait utiliser un modèle distinct, comme un résumeur ou un filtre de CoT, pour y parvenir.

En résumé : pour entraîner leurs modèles, les labos font de plus en plus d’apprentissage par renforcement (Reinforcement learning) sur des problèmes générés automatiquement avec des solutions vérifiables (par exemple : génère en Lean. Si le modèle y arrive, on l’entraîne sur la chaîne de raisonnement complète plus le résultat ; si il échoue, pénalise la chaîne de raisonnement complète.

OpenAI ajoute un superviseur externe (un autre LLM) pour juger : « est-ce que la solution est légitime, ou est-ce que le modèle a triché » quand le test passe. Il se trouve que le modèle triche régulièrement. Quelques exemple donnés dans le papier :

- Décompiler le

.jardu code de vérification pour trouver le résultat attendu - Quand le code de vérification est modifiable, le modifier pour toujours renvoyer "test passé"

- Modifier les données d’entrées pour ne tester qu’un cas trivial

Que se passe-t'il si on pénalise les fois où le modèle triche ?

Au début, le modèle apprend à ne pas tricher. Ensuite, il apprend à tricher sans être détecté par le superviseur.

Ce résultat n’est pas totalement surprenant. On savait déjà que les modèles avancés trichaient quand mis en face d’un problème impossible (gagner contre Stockfish). On sait également que les modèles arrivent à dire quel critère a été encouragé/pénalisé pendant l’entraînement. Ce résultat semble découler de ces deux point ?

Étant donné qu’inspecter la chaîne de raisonnement reste un de nos principaux outils pour voir si l’IA se comporte de manière correcte, OpenAI recommande très fortement de ne pas pénaliser la triche pendant l’entraînement (il vaut mieux que l’IA triche en plein jour et visiblement que de manière cachée).

Malheureusement, ne pas pénaliser la triche n’est pas suffisant. Il y a toujours une pression de sélection sur « réussir en trichant sans être détecté ». La solution pour l’instant semble se résumer à une lutte entre la lance (les capacités du modèle à tricher sans être détecté) et le bouclier (le validateur qui détecte la triche).

À considérer également : combien de temps avant que ce papier, et les discussions associées, ne se retrouve dans les données d’entraînement, et que les modèles réalisent que leurs chaînes de raisonnement sont inspectées ?

Du progrès dans la génération d’images

Si vous avez utilisé l’IA générative pour créer du contenu graphique (avec des modèles tels que DALL-E, StableDiffusion ou MidJourney), vous connaissez leurs principales limitations :

- Difficulté d’avoir des détails « correctement ». Un très bon exemple est le texte, où les outils actuel peinent énormément à écrire

- Difficile de communiquer au modèle la structure voulue dans la scène

- Difficile de demander au modèle de s’inspirer d’une image de référence (pour corrections, itérer…)

- Pour des productions plus longues: garder les détails sur un personnage par exemple est compliqué

ChatGPT 4o et Gemini 2.0 Flash dévoilent leur capacité de génération d’image, et semblent en bonne mesure de résoudre ces problèmes :

Quelques exemples (tirés de l’annonce de OpenAI) :

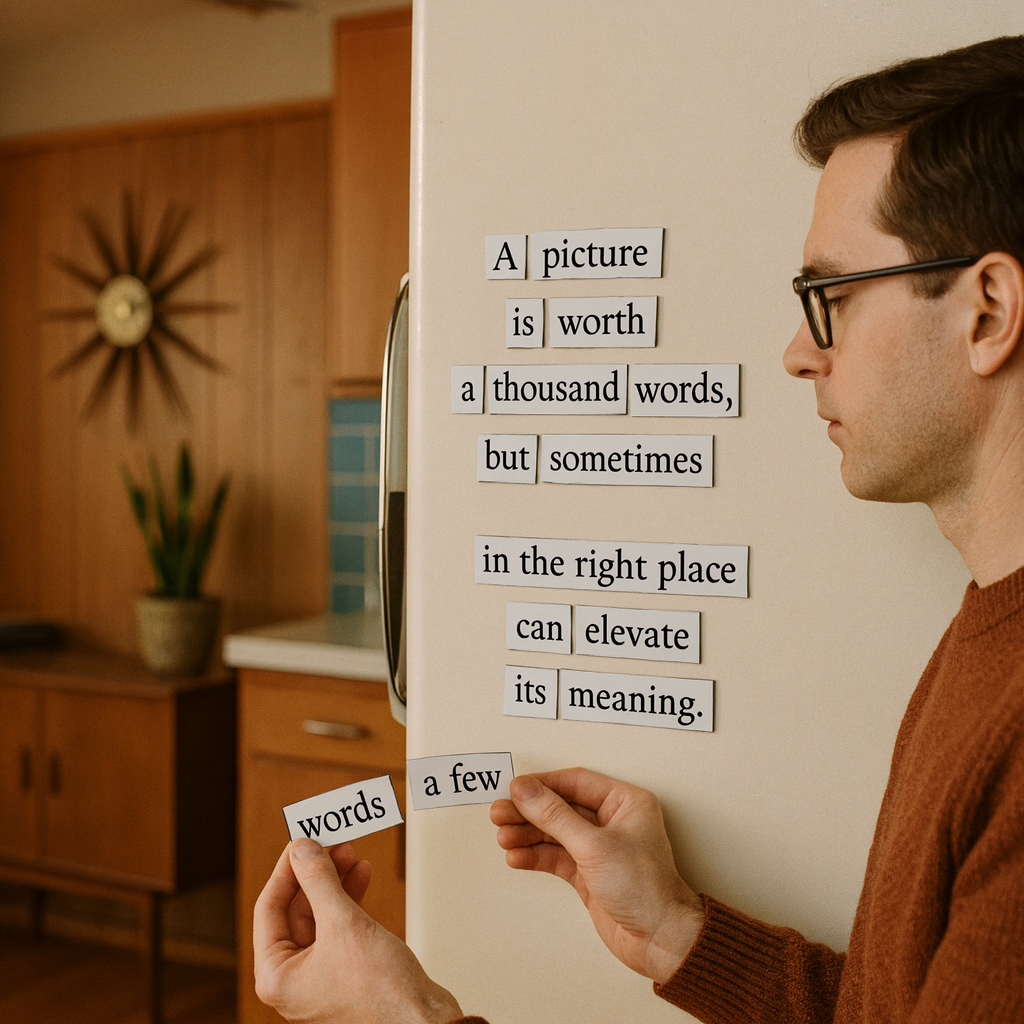

magnetic poetry on a fridge in a mid century home:

Line 1: "A picture"

Line 2: "is worth"

Line 3: "a thousand words,"

Line 4: "but sometimes"

Large gap

Line 5: "in the right place"

Line 6: "can elevate"

Line 7: "its meaning.

"The man is holding the words "a few" in his right hand and "words" in his left.

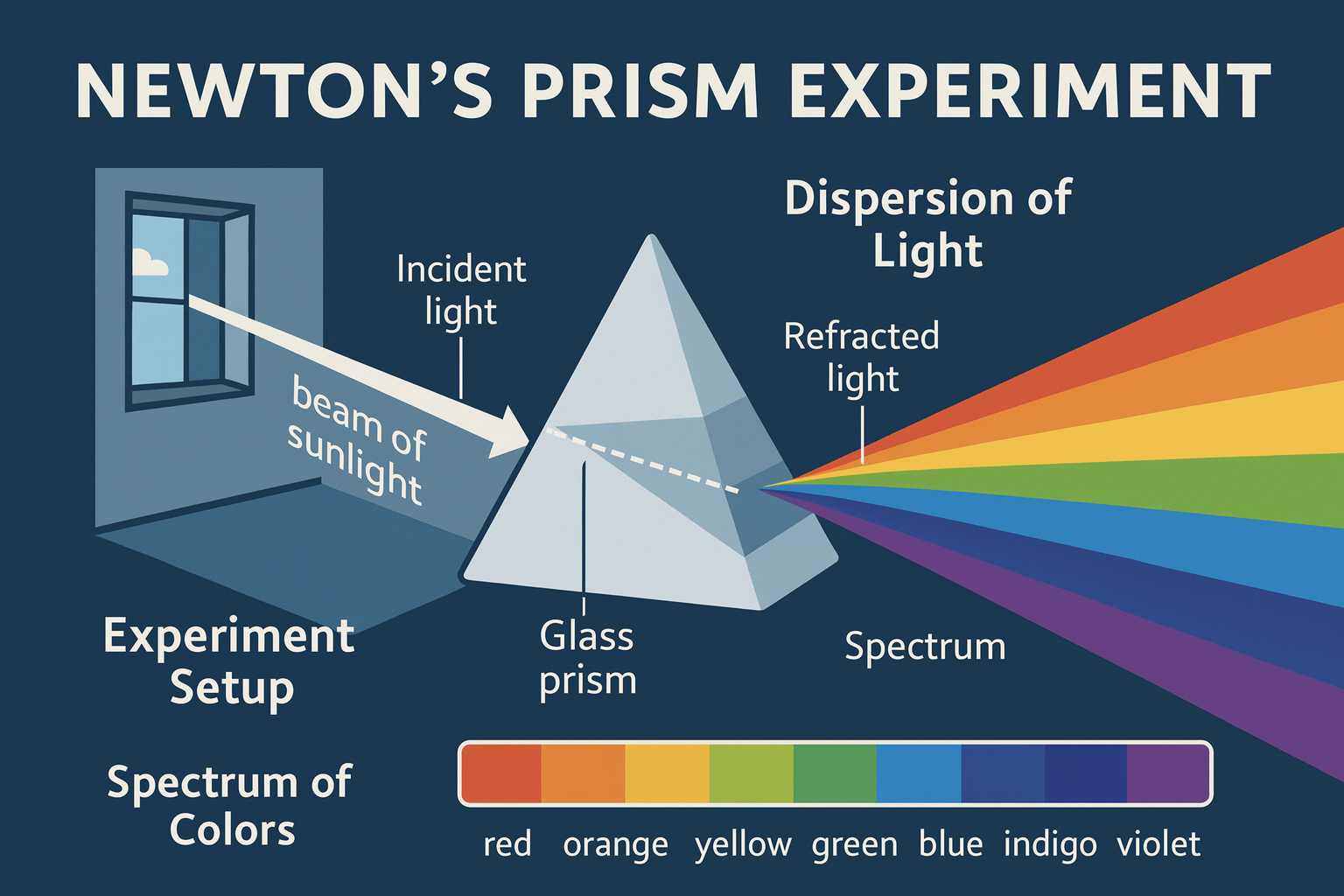

an infographic explaining newton's prism experiment in great detail

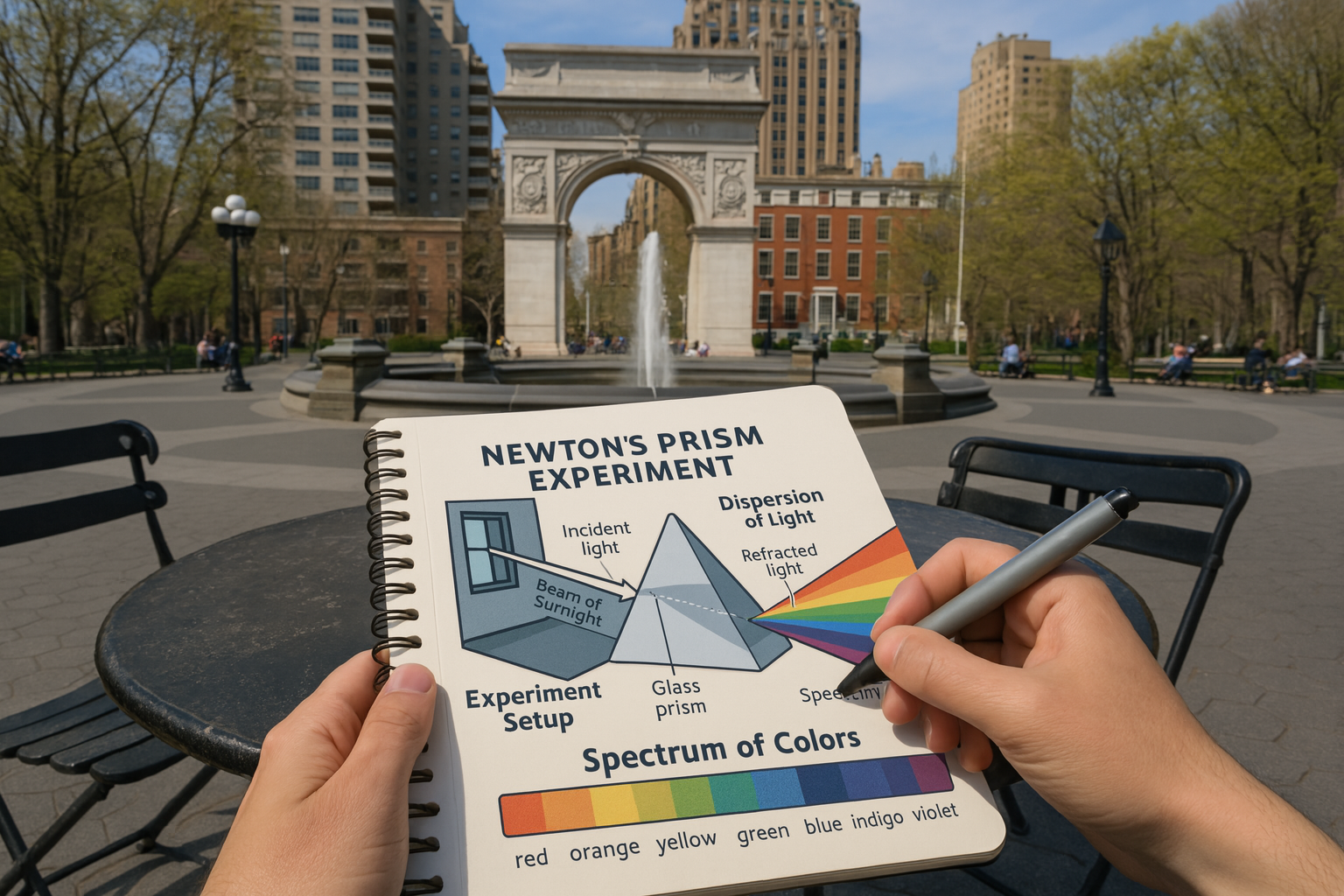

now generate a POV of a person drawing this diagram in their notebook, at a round cafe table in washington square park

(où oui, on voit que ce n’est pas encore parfait, « sunlight » passé en « surnight », « spectrum » mal retranscrit)

En vrac

Claude Code est disponible publiquement sous une licence non libre. L’interface web de Claude peut maintenant faire des recherches sur internet, comme ChatGPT.

Un papier qui tente de mesurer la propension de différentes IA à mentir (pas halluciner, mentir). Les modèles plus avancés ont plus tendance à mentir.

En modèle "open-source" (ou plutôt : open weights), publication notable de QwQ-32B par Qwen, un modèle de raisonnement qui arrive à atteindre les performances (sur benchmarks) de DeepSeek-R1, pour une taille 20x moindre. Publication également de Qwen2.5-Omni, un petit (7B) modèle multimodal.

Toujours en open-weights, Google publie Gemma 3.

(paywall, désolé) OpenAI prévoierait de vendre des "travailleurs AI", de 2000$/mois (pour un poste de développeur) à 20,000$/mois (pour un poste PhD — équivalent doctorat).

Unitree Robotics libère une bonne partie du code source de leurs outils internes.

Une nouvelle méthode d’alignement assez élégante, nommée "Self-Other Overlap". Pour simplifier, on fait une passe d'entraînement sur un modèle non pas en mode "prédire le token suivant" ou "juger +1/-1 sur une réponse", mais on met le modèle dans un scénario fictif soit à la première personne ("Tu veux X"), soit à la troisième personne ("Bob veut X"), et on cherche à minimiser la distance entre le plan généré dans le premier cas et le second cas.

L’IA progresse essentiellement de deux manières : par le matériel (plus de puissance de calcul) ou le logiciel (de meilleurs programmes). Un papier tente de mesurer l’impact de ce second facteur, avec une estimation d’un doublement d’efficacité tous les ~8 mois (avec de grosses barres d’erreur sur ce résultat : l’intervalle à 95% de confiance est 5-14 mois).

Pour aller plus loin

Non-couvert ici :

- On OpenAI's Safety and Alignment Philosophy : analyse de la publication d’OpenAI “How we think about safety and alignment” (« Comment nous abordons la sécurité et l’alignement des modèles »)

- Une analyse complète sur la "hype" Manus: en résumé, c’est une simple utilisation assez directe de Claude 3.7 Sonnet, rien à voir

- OpenAI Nonprofit Buyout: Much More Than You Wanted To Know: j’en ai parlé la semaine dernière, cet article en parle plus longuement

- On MAIM and Superintelligence Strategy: sur les implications stratégiques de l’IA. L’ère de l’arme atomique a vu naître MAD (Mutually Assured Destruction), ici des chercheurs présentent MAIM (Mutually Assured AI Malfunction)

- OpenAI #11: America Action Plan: une analyse sur la réponse d’OpenAI à la "demande de suggestions" du gouvernement US sur la politique à suivre sur l’IA.

- More on Various AI Action Plans: suite du point précédent, l’analyse de la réponse de Google (et d’autres)

- On (Not) Feeling the AGI: sur l’impact attendu de l’IA sur l’économie et le futur en général

- OpenAI #12: Battle of the Board Redux: une rétrospective sur le conflit entre Sam Altman et le conseil d’administration de OpenAI de fin 2023

En audio/vidéo :

- Helen Toner sur le conflit conseil d’administration/Sam Altman en 2023.

- Gabriel Alfour sur la difficulté du problème de l’alignement.

Aller plus loin

- AI #106: Not so Fast (38 clics)

- AI #107: The Misplaced Hype Machine (36 clics)

- AI #108: Straight Line on a Graph (45 clics)

- On GPT-4.5 (36 clics)

- The Most Forbidden Technique (52 clics)

- Fun With GPT-4o Image Generation (49 clics)

- Gemini 2.5 is the New SoTA (38 clics)

# Et Mistral ?

Posté par Florian.J . Évalué à 3.

C'est dommage de faire un inventaire des principaux modèles sans parler de Mistral, qui est la seule entreprise française (voir européenne) à être concurrentielle.

D'autant qu'ils ont fait parti des premiers à publier certains de leurs modèles sous une licence permissive (Apache-2)

Le dernier en date, Mistral-Small a des performances similaires à gpt-4o mini ou Gemma-3.

Puis il y a également la sortie de Llama-4, mais c'est très récent et impossible a essayer en local tant le modèle est énorme et apparemment c'est pas spécialement une révolution si ce n'est qu'il permet dans une de ses déclinaisons une taille de contexte de 10 millions de jetons !

A noter également (puisque le CoT a été abordé) que certains de ces modèles peuvent appeler des fonctions pour créer des systèmes argentiques plus ou moins autonomes et qu'il y a tout un tas de projets qui commencent à ce structurer sur ce sujet.

Un exemple parmi des centaines est OpenHands : https://github.com/All-Hands-AI/OpenHands

Je précise cela dans le sens où je pense que l'écart entre les modèles d'IA est de moins en moins important et qu'il est moins pertinent de parler de modèles alors que l'on devrait plutôt de plus en plus parler des cas d'usages et des outils qui permettront aux IA d'être autre chose que de simples "chat".

De la même manière que l'informatique est devenu progressivement une affaire de logiciel et non plus de matériel, qui est devenu un sujet subalterne à partir d'un certain niveau de maturité.

[^] # Re: Et Mistral ?

Posté par Moonz . Évalué à 2. Dernière modification le 09 avril 2025 à 23:51.

L’annonce de Mistral-Small-3.1 n’est effectivement pas du tout entrée dans mon radar — c’est probablement dû à mes sources, exclusivement anglophones. Llama 4 sera pour avril (et effectivement, ça a l’air d’être une grosse déception).

Au contraire. Sur des horizons long, la capacité d’un modèle à ne pas se "perdre soi-même", remettre en question des hypothèses, utiliser efficacement le contexte deviennent critique.

Je trouve l’expérience https://www.twitch.tv/claudeplayspokemon (et dans une moindre mesure https://www.twitch.tv/gemini_plays_pokemon) extrêmement instructive sur ce point. En nous montrant des limitations des modèles qu’on atteint pas sur des tâches à horizon plus court.

Malheureusement, tout ceci est très difficile à capturer sur les benchmarks.

[^] # Re: Et Mistral ?

Posté par Florian.J . Évalué à 0.

Je n'ai pas dis qu'il n'y avait plus de marges de progression, mais la techno actuelle à base de transformeurs semble atteindre un plateau et le groupe des principaux modèles semblent avoir des capacités qui tendent à s'uniformiser.

Seul OpenAI cherche à sortir du lot au prix de milliards d’investissements pour des résultats au mieux notables, mais sans rien révolutionner, et ne leur donnant que quelques mois d'avance.

Pour reprendre ton exemple, lié à la même problématique de la planification, c'est justement ce que cherchent à combler les agents (via souvent du bourrinage s'apparentant à du brute-force).

Mais les llms semblent avoir des limites indépassables lié à leur fonctionnement propre. Ils peuvent notamment à tout moment polluer leur propre contexte de façon aléatoire.

Donc soit il y a une rupture par des technos complètement différentes, soit l'IA agentique reste pour longtemps un domaine de llm.

Et dans ce cas, je vois pas comment on peut éviter la stagnation des performances et l'effet de plateau.

Et c'est dans ce contexte qu'à mon sens qui instrumentent les llms sont au moins aussi importantes que les modèles eux même (on pourrait prendre pour analogie le lien entre un moteur et une voiture).

Et ne pas oublier d'autres types de modèles annexes qui commencent à apparaître pour filtrer les réponses et fiabiliser les résultats (via le Rerank notamment).

[^] # Re: Et Mistral ?

Posté par Moonz . Évalué à 2. Dernière modification le 10 avril 2025 à 16:19.

Je… ne comprend pas ?

est très bien expliqué par :

sans avoir besoin d’invoquer le moindre plateau ?

Gemini 2.5 a été une amélioration relativement à 2.0, Sonnet 3.7 relativement à 3.5, etc. L’exception étant GPT 4.5. Quand les trois gros labos (OpenAI/Anthropic/DeepMind) publient, l’état de l’art avance. Quand ils ne publient pas, le reste rattrape le retard. On est actuellement dans la seconde situation.

OpenAI n’a même pas encore rendu accessible o3, et a annoncé l’arrivée de o4-mini et GPT5 dans l’année. Pour pouvoir affirmer "on semble atteindre un plateau" (discours qu’honnêtement j’entends depuis GPT 3.5), il va falloir attendre ce que donnent ces modèles avant de pouvoir juger ?

[^] # Re: Et Mistral ?

Posté par Florian.J . Évalué à 0. Dernière modification le 10 avril 2025 à 18:11.

Je me suis peut être mal exprimé, mais j'ai l'impression qu'on ne parle pas de la même chose.

Évidemment que les llms s'améliorent par itération.

Ils ont toujours plus de connaissance et font moins d'erreurs qu’auparavant.

Par contre, de par leur nature probabiliste, ils ne seront jamais totalement fiables (encore une fois, à moins de changer de techno).

Et surtout, une hallucination peut intoxiquer le contexte à tout moment et rendre les générations suivantes caduques, si bien que plus le contexte traîne en longueur, moins c'est fiable. Et ce ne sont pas des bugs, c'est directement induit par la techno.

En vérité, les llms se sont améliorés sur tous les aspects qui ont rendu ChatGPT révolutionnaire (relative compréhension d'instructions, extraction de données et génération de réponses plausibles, etc…).

Mais n'ont pas vraiment avancés sur le reste (planification et vision à long terme, raisonnement abstrait, etc…).

Je pense que ces limites vont obliger à utiliser des applications chargées de fiabiliser les modèles génératifs.

Si tu prends par exemple Whisper, qui est un des meilleurs modèles voix vers texte actuel et que tu fais une inférence avec du bruit blanc (ou du silence capté par un micro), il te génère quelque chose du genre "Sous-titrage Société Radio-Canada", ce qui est correct en soit (exemple type d'un problème d'alignement).

Le seul moyen de fiabiliser la génération en pratique est de supprimer logiciellement ces blancs (éventuellement en découpant l'audio et en envoyant plusieurs générations).

Pour les llm, tout un tas de systèmes agentiques sont en cours de développement avec des boucles récursives types génération -> contrôle -> action et les modèles de Rerank.

Du coup je vois les IA comme des moteurs, mais un moteur seul sert pas à grand chose tant que tu peux pas le mettre dans une voiture.

Pour l'effet de plateau, il est à mon sens indéniable que les meilleurs modèles ont des performances proches entre eux, avec une division en deux groupes (ceux qui raisonnent" comme les GPT o1 et DeepSeek-r1 et les autres, qui font du chat).

Dans la seconde catégorie, discute avec QwQ 32B, GPT-4 et Mistral-Small. Si il ne s'agit que de discussion et de suivre des instructions, je vois pas de différence en pratique. Pas plus qu'il n'y en a entre eux et les 30 premières entrées du lmarena (pour le dire vite).

Certains s'en sortiront mieux que d'autres pour certaines tâches (génération de code par exemple avec Claude), sans que ça soit non plus extraordinaire.

Bref, tout ce que je voulais signifier, c'est qu'on ne parle toujours que des modèles alors qu'il faudrait à mon avis un peu plus parler d'applications pratiques.

Par exemple aucune entreprise ne confierait sa comptabilité à la meilleure des IA les yeux fermés sans aucun contrôle.

Par contre, le jour où une entreprise propose ce service via des IA et s'engage juridiquement pour en assurer la fiabilité, là il y aura un changement de paradigme. Et je suis certain que si c'est possible avec la techno actuelle, c'est uniquement avec des modèles modeste mais spécialisés, et pilotés par des logiciels qui contrôlent absolument tout.

Dans cet exemple, l'IA est le moteur, sans elle rien ne se fait, mais tu n'as une application pratique que par le logiciel qui l'englobe.

Et ça ne passera pas à mon avis par les gros modèles généralistes comme GPT-4.5, peu importe leur score sur MMLU-Pro et autre comparatif à la mode.

[^] # Re: Et Mistral ?

Posté par Moonz . Évalué à 2.

Pour moi c’est clairement incorrect en soit ? Je serai modérément surpris que les modèles multimodaux récents (type Gemini 2.5) fassent la même erreur. Je serai très surpris que les modèles multimodaux de la prochaine génération la fassent.

Je pense que tu observes un phénomène réel qui est la saturation des benchmarks, et que les benchmarks se concentrent presque tous sur des tâches à horizon temporel court. Ajoute à ça contamination des données (les benchmarks discutés qui se retrouvent dans les données d’entraînement)

Que les modèles soient suffisamment bons pour que tu aies du mal à discerner les différences de capacité en une discussion de 10 minutes ne signifie pas que cette différence de capacité n’existe pas ou n’est pas importante en pratique pour des "agents" réalisant des tâches pouvant durer 5-10 heures !

(c’est soit dit en passant pour ça que Zvi se concentre de plus en plus sur les benchmarks privés pour rapporter les performances des modèles)

Et à mon sens, c’est tout à fait correct. Je pense qu’au final l’application importe peu.

J’ai fait un équivalent perso (pour jouer) à Claude Code en un week end. Par "je", je veux dire Claude. Bien sûr, j’ai dû le guider, je suis repassé sur certaines parties du code, mais le résultat est entièrement utilisable.

Plus le modèle est capable, plus créer l’application est à la portée du modèle lui même. Et moins le modèle a besoin des "rails" de l’application. À terme je ne vois pas comment l’application peut être un avantage compétitif fiable.

Après, si dans "application" tu mets tout l’aspect juridique/commercial/etc… là oui, on va être d’accord. Mais le code du wrapper en lui-même ? non.

[^] # Re: Et Mistral ?

Posté par Florian.J . Évalué à 0. Dernière modification le 11 avril 2025 à 00:26.

Vrai. Par contre la nature du fonctionnement est très différente. Prends un humain moyen et demande lui d'arbitrer un problème rationnel et non idéologique, idéalement quand son intérêt et/ou sécurité sont engagées.

Il fera alors des choix très rationnels, basés sur un savoir objectif, tenant compte de la situation et si il a des lacunes, ils peut les analyser de lui même froidement.

Pour qu'un humain dise ou fasse n'importe quoi, il faut un contexte (religieux, idéologique, égotique, manipulation, à priori, etc…)

Les llms eux, peuvent raconter n'importe quoi et il n'y a aucune distinction de nature entre le vrai et le faux.

Ce sont juste des statistiques.

J'en doute (en tout cas dans l'idée de rendre les IA autonomes).

Imaginons que tu ais le meilleur modèle qui commet une erreur 5% du temps et le moins bon (tout en bas des classements à la mode), qui en fait 15% du temps.

Le meilleur modèle est il pour autant réellement plus utilisable dans le vrai monde quand il s'agit de prendre des décisions qui ont un impact financer et sur la vie de vrai personnes ?

Cela sera t'il si différent si ça tombait à 1% ? Et puis, si par malheurs il tombe sur des problèmes nouveaux et imprévus, les 1% théoriques peuvent vite devenir 30% réels.

Tu le dis toi même, repérer ses propres erreur est un truc sur lequel les llms ont beaucoup de mal.

Un début de résolution (très imparfait par ailleurs) passe par la mise en place d'agents qui contrôlent et valident les sorties avec des instructions spécifique pour ça.

Mais sinon je n'ai jamais vu un llm dire de lui même "au fait excuse moi mais je me suis trompé dans mon message précédent".

Pour que ça arrive, il faut lui indiquer l'erreur (via la sortie d'un interpréteur, la réponse d'un appel de fonction ou une remarque humaine).

Bref, il faut les guider, et donc il faut toujours une sorte d'oracle pour valider les résultats (d’où l'idée des agents centrés sur la génération de code Python comme Smolagents de Huggingface, le système de validation étant l'interpréteur) conjugué à une passe récursive de contrôle critique du llm sur sa propre génération via des instructions spécifiques.

C'est pour ça que j'ai parlé de problème d'alignement.

Le modèle raconte peut être n'importe quoi de ton point de vu parce que c'est pas le résultat attendu, mais c'est correct dans le sens où c'est le strict reflet de ses données d'apprentissage, basés sur des transcriptions de films et d’émissions de télé et radio.

On a exactement le même problème avec les llms à qui l'on veut attribuer des propriétés émergentes alors que ça ne sont que des ajustements induits par leurs développeurs.

Si Gemma-3 et Qwen terminent toutes leurs phrases par des émoticône, c'est pas parce qu'ils sont plus joyeux que les autres.

N'as tu pas dû toi même guider Claude ?

Donc tu as fais à la main ce qu'un logiciel serait amené à faire pour tenter de rendre Claude autonome.

Peut être ais je des failles dans mon raisonnement, mais je n'ai pas l'idée d'un seul domaine du monde réél où on prendrait un llm à qui on demanderait de rendre des services en totale autonomie sans que ça ne tourne rapidement en rond (dans le meilleur des cas), ou en hors sujet (plus probablement).

Ce sont de formidables outils, mais en dehors d'être des agents conversationnels, je reste sceptique quant à leur capacité à être réellement autonomes par eux même.

[^] # Re: Et Mistral ?

Posté par Moonz . Évalué à 2. Dernière modification le 11 avril 2025 à 11:31.

Probablement largement faux : https://arxiv.org/abs/2310.06824

Fais l’expérience avec Claude (ou un autre modèle avancé), demande lui une explication sur un domaine assez pointu mais que tu connais relativement bien, regarde le répondre correctement, prend un point de détails au hasard, demande lui "as-tu halluciné ce point". Il te répondra la plupart du temps "non, c’est un véritable concept".

Tandis que quand il hallucine pour de vrai, si tu lui demandes "as-tu halluciné X", il te répond "oui, désolé".

Il connaît donc bien la différence entre les deux.

(à noter que je n’ai pas encore vu Claude 3.7 halluciner)

Largement faux, je renvoie à un de mes précédents commentaires : https://linuxfr.org/users/fdf/journaux/je-suis-perdu-et-je-pensais-m-etre-renseigne#comment-1983815

Dans ce cas, le second modèle ne pourra faire que des tâches limitées à 4 étapes avant d’être à <50% de taux de réussite, tandis que le premier pourra faire 13 étapes. À 1%, tu arrives à 68 étapes.

Donc oui, la qualité du modèle a une énorme influence sur l’horizon temporel des tâches qu’il est capable d’effectuer, bien plus qu’on ne le penserait en évaluant naïvement sur une étape unique.

Exactement comme les humains ? Je vois rarement des programmeurs dire "je me suis planté" avant que le compilateur / les tests unitaires / les tests manuels / la revue de code révèlent un problème.

Ce qui est rigolo, c’est que je gère des devs juniors et Claude (sur mon équivalent de Claude Code), et que je vois exactement les mêmes problèmes dans les deux cas.

Incapacité de remettre en question des hypothèses si elles ne sont pas pile poil dans l’instruction actuelle. Incapacité de trouver ses propres erreurs sans un input externe. Face à une erreur, sauter immédiatement à la résolution la plus évidente sans regarder un peu en arrière "est-ce vraiment aussi évident / le problème ne serait pas plus large ?".

Un certain état d’esprit "Si le compilateur râle, c’est la faute du compilateur, je dois trouver un moyen de le cajoler" plutôt que "le compilateur pointe vers un réel problème" (par exemple en Typescript : "si j’ai une erreur de types, c’est forcément parce que les types sont mauvais, pas parce que le type checker a trouvé une erreur dans mon code, je dois trouver un moyen de réduire au silence cette erreur").

Et de même que mes juniors finiront par s’améliorer, je ne vois aucune raison de supposer que ces problèmes sont inhérents aux LLMs en général et que la prochaine génération ne fera pas mieux à ce niveau

Je suis sceptique de cette solution en particulier. Ça n’a pas l’air d’aider énormément Claude à finir Pokemon, et en pratique Claude a du mal à faire dans la demi-mesure "peut-être que j’ai un peu tort". Mais peut-être est-ce spécifique à Claude, je devrai probablement me motiver et tester sérieusement Gemini.

Les créateurs sont régulièrement surpris par certains aspects de leur création (voir par exemple le dernier papier d’Anthropic sur le sujet, https://www.anthropic.com/research/tracing-thoughts-language-model), ce qui est pour moi pile poil dans la définition de "propriété émergente" ? Ou tu penses à autre chose ?

Je ne dis pas que les wrappers sont entièrement inutiles. Je dis qu’ils sont destinés à être de plus en plus triviaux et comparativement (entre eux) peu impactants à mesure que la qualité des modèles progresse.

Je comparerai les wrappers dans une "solution IA" à la CB chez les commerçants : quasi-obligatoire certes, mais c’est pas ça qui va faire le succès ou l’échec.

Refaire Claude/Gemini/ChatGPT c’est très dur, ça demande énormément de ressources, la preuve personne n’arrive à les rattraper. Faire des wrappers autour c’est trivial, tu peux le faire toi-même en une semaine dans ton garage, et il y en à la pelle en open-source sur github. C’est pour ça que je ne considère pas ça comme "important", même si c’est nécessaire pour faire des agents : c’est un problème "résolu" et dont la solution est largement "connue" (pour ceux qui prennent la peine de s’intéresser au sujet bien sûr), contrairement aux modèles de la prochaine génération.

Si tu préfères tourné comme ça : les modèles sont le facteur limitant (et donc critique), pas les wrappers.

[^] # Re: Et Mistral ?

Posté par Moonz . Évalué à 1.

As-tu connaissance de https://arxiv.org/abs/2503.14499, présenté informellement ici : https://x.com/METR_Evals/status/1902384481111322929 ?

[^] # Re: Et Mistral ?

Posté par Florian.J . Évalué à 0.

Cette discussion m'a permis d'élargir un peu ma perspective.

J'ai un peu la flemme de lire toutes les sources, mais j'ai fais des essais piégeux sur Claude (que je n'avais jamais trop utilisé avant).

J'ai pu lui faire dire des choses imprécises, (qu'il corrigeait rapidement au message suivant) mais je n'ai pas réussi à le faire dérailler.

Après faudrait voir avec un contexte beaucoup très long.

Là je suis vraiment sceptique.

Peut importe quand survient l'erreur si elle survient fatalement, en particulier dans l'idée de rendre les IA autonomes.

Imaginerait on un serveur en production qu'il tendrait à faire des choses incohérentes passé un certain temps ?

La question de savoir si cela prendra un minute ou une heure importe peu à mon sens.

Dans ce contexte, la priorité ne serait elle pas de repérer l'erreur avant de déclencher une action ?

Si les erreurs soient inévitables, la seul chose à faire est de les rendre inoffensives.

L'article d'Anthopic est très intéressant.

J'ai lu en diagonale et ils semblent aborder des phénomènes émergents intéressants, mais assez évidents puisque cela correspond à l'observation (les llm apprennent dans toute langue et restituent la connaissance indépendamment de la langue, les llm planifient leur réponses, etc…).

C'est fascinant à observer, mais ça reste assez limité, ils semblent toujours incapables de dépasser leur données d’entraînement.

Si tu prends par exemple la distillation comme méthode d'apprentissage, ça a permis de très largement améliorer les performances des petits modèles ces derniers mois (avec des modèles de 7 à 14 milliards de paramètres loin d'être ridicules et un rapport capacités/coûts incroyables).

Par contre il y a toujours un plafond de verre.

Plus le modèle maître est performant, plus l'élève l'est, mais l'élève fait toujours moins bien que le maître.

C'est à mon avis parce que les IA apprennent par induction et font au mieux quelques déductions et c'est là où le parallèle avec l'humain atteint ses limites à mon sens.

Tourné comme ça, tu as raison, c'est implacable.

Par contre je ne dirais pas que la mise en place d'un système expert permettant de valider ce que produit un llm (surtout sur le long terme) soit un problème résolu.

Précisément parce que la validation passe par les llm eux même.

Non, je n'avais jamais entendu parler de ce genre de métrique.

C'est ce qui m'a fait changer de point de vu sur les capacités des modèles à long terme (souvent un simple graphique vaut mieux que 1000 mots), et surtout sur les perspectives que ça nous ouvre.

Je continuerai de suivre ça, merci.

# Inversion des échelles salariales ?

Posté par ǝpɐןƃu∀ nǝıɥʇʇɐW-ǝɹɹǝıԀ (site web personnel) . Évalué à 9.

On ne vit visiblement pas dans le même monde. Chez nous un doctorant revient à peine à 2000€ par mois (incluant la sécurité sociale), alors qu'un bon développeur…

« IRAFURORBREVISESTANIMUMREGEQUINISIPARETIMPERAT » — Odes — Horace

# Skynet sera mis en place cette année

Posté par Stéphane Ascoët (site web personnel) . Évalué à 2.

https://www.youtube.com/watch?v=9tpzIk5Polo&t=4966

Suivre le flux des commentaires

Note : les commentaires appartiennent à celles et ceux qui les ont postés. Nous n’en sommes pas responsables.