En tant que mécanicien pratiquant l'impression 3D et ayant des rudiments de conception assistée par ordinateur (CAD) et de réalisation de pièces, je vais me permettre de te donner mon avis. Je laisse l'aspect logistique à d'autres.

Il y a des parties réalisables. Des pièces non soumises à une charge mécanique importantes qui cassent, ou s'il n'y a pas de contraintes d'encombrement peuvent être facilement refaites en 3D avec du PLA. C'est le premier cas d'étude.

Il faut être capable d'utiliser un soft de CAD (FreeCAD, OpenSCAD, OnShape, CATIA, Fusion 360, …), faire des formes primaires à partir des surfaces fonctionnelles et grossir l'ensemble pour que les limites de l'impression 3D soient négligeable doit permettre d'arriver à un résultat rapidement.

Il faut par contre se faire des des outils de mesures, car les assemblages dans les pièces mécanique, ne sont pas toujours fait dans l'électroménager avec des pièces standards. Il faut faire aussi attention, si il y a de la chaleur, alors les matériaux du FDM sont inutilisables (fluage à température faible), il faut plutôt s'orienter vers de la résine, qui est plus exigeante en terme d'utilisation et que l'on trouve moins en FabLab. Je pense que cela peut correspondre à quelques cas d'utilisation.

Sur les parties soumises à des efforts mécaniques, par exemple un coupleur de couteaux avec l'arbre moteur pour un mixer ou moulin, ces pièces sont faites en injection avec des matériaux ad-hoc, il est illusoire de vouloir les refaire, l'encombrement est décisif, la qualité du matériau fondamental tant pour la mécanique que pour l'aspect sanitaire, car avoir des bouts de plastique dont on ignore tout dans son assiette semble à éviter …

Les propriétés des matériaux semblent aussi un frein majeur, refaire un tuyau d'aspirateur, par exemple semble non trivial … Ce ne sont que quelques exemple pour illustrer que le pb est complexe et ne peut probablement pas se faire si simplement.

Si on passe à ce qui utilise des capteurs ou des actionneurs, alors c'est encore pire.

Dans bien des cas, les pièces d'électroniques de puissance cassées peuvent être identifiées par contrôle visuel, donc si la référence est encore visible il est possible d'acheter de composant et le remplacer en sachant souder. Si ce n'est pas le cas, il faut être capable de faire une analyse électrique avec un multimètre, ce qui peut nous ramener au cas précédent.

Si on prend les éléments de chauffe, c'est bien souvent les résistances qui se mettent en court-circuit, toutes ces resistances sont faites sur mesure pour l'appareil, en faire une manuellement serait un travail qui couterait très cher par rapport au prix de l'appareil sans l'assurance d'avoir la bonne température, car cela dépend du type de matériau et aller identifier ces propriétés thermiques et électriques ne semble pas réaliste dans le contexte d'une réparation.

Si une carte électro(tech)nique lache et que l'on n'identifie pas le composant, certaines utilisent directement le 220V (quasiment tout l'électroménager), donc manipuler ce types de circuit peut potentiellement être mortel, pas sûr que cela vaille le coût …

Les réparateurs, changent ce genre de cartes, il est assez rare qu'ils s'engagent à sur des composant pouvant prendre feu ou pouvant occasionner des risques électriques.

Les repair-cafés sont des lieux ou des gens ayant beaucoup d'expertise se réunissent pour aider à réparer tant que possible, mais je suis assez dubitatif sur les aspects responsabilité civile d'une telle oeuvre … Tant qu'il n'y a pas d'accident, on n'en parlera pas, je ne voudrais pas être le gars qui a aidé et expliqué et dont la personne se serait blessée chez elle avec l'objet réparé avec ou sans bidouillage aval.

Par contre, je trouve qu'il est vraiment dommage de ne pas avoir de ressourcerie générale qui permettrait à des professionnels de mettre à disposition des pièces détachées qui partent à la benne chaque année … Il faudrait contraindre les industriels à avoir ds référencement explicites sur les produits permettant à des ouvriers de créer ces ressourcerie pour créer des catalogues de pièces détachées d'occasion issues des déchets des gens qui ne veulent pas recycler et avoir des ressources à disposition que l'on pourrait réemployer dans des FabLab ou il est possible de concevoir de manière dédiée aux pièces de ressourcerie tant sur l'aspect mécanique, électronique, électrotechnique.

Quand on voit le prix que l'on doit payer pour une enceinte, des moteurs, des roulettes, pour concevoir un nouveau produit, c'est clairement un frein à l'innovation !

Je serais prêt à ce que mes impôts concernant la déchetterie, si je pouvais aller chercher gratuitement des pièces bien classées dans une ressourcerie municipale !

Il faudrait de l'emploi beaucoup d'emploi pour le réemploi !

Le pdf c'est merdique pour autre chose qu'un truc qui a vocation d'être imprimé. Vous connaissez beaucoup de présentations qui finissent imprimées?

Tout ce que vous dites est vrai, mais ce n'est pas le sujet. Aussi merdique qu'il soit, le pdf est le seul format d'export qui conserve la mise en page et garde l'aspect vectoriel qui soit implémenté dans tout les logiciels et soit lisible dans un navigateur. SVG, n'est pas parfaitement pris en charge par LO par exemple.

On a inventé un truc pratique qui permet d'avoir du contenu lisible sur des appareils de tout type de taille d'écran, qui permet de jouer différents types de contenu multimédia, sur lequel on peut même jouer l'audio voire la vidéo de présentation. Ça s'appelle HTML5 (+css). C'est bien plus pratique qu'un pdf ou une vidéo sur youtube et ça se partage facilement.

Donc, oui on pourrait tout faire en HTML+CSS+JS, mais si c'était si simple, pourquoi l'export LO est si pourri par exemple. Sans parler de beamer, qui ne sait pas comment faire, et powerpoint … Personne ne sait faire ça. Donc ça appelle à des développements très important sur les softs qui font les contenus … ce n'est pas prêt d'arriver.

Le point est que le travaille de Guillaume, qui exploite exactement ce que vous décrivez, est probablement le player JS+SVG+video, le plus avancé du monde. Il faut payer un pris important sur le workflow pour l'utiliser, de ce fait peu de gens vont le faire. Si demain tu pouvais utiliser tes outils comme beamer, impress, powerpoint et ensuite passer par la case Sozi, ou mieux avoir un export directement compatible avec Sozi, alors tout le monde aurait envie de l'utiliser !

Après, ce que je propose requiert un énorme travail, j'imagine bien que c'est n'est pas du tout dans les priorités de Guillaume.

Le point que je voulais mettre ne avant, c'est que pour avoir une base d'utilisateurs prêt à subventionner le temps passé sur le logiciel, il faut répondre à un besoin du plus grand nombre.

Si avoir des présentations en lignes est bien un besoin du plus grand nombre, changer son workflow de présentation n'est pas possible pour la plupart. Cela veut dire que la base d'utilisateurs, restera faible, et la possibilité de financement également !

Il y a eu un très grand changement par rapport au moment où tu as commencé à écrire Sozi !

Tous les navigateurs supportent le pdf en natif !

Je pense que si tu relâchais la contrainte du SVG pour permettre le pdf, alors n'importe quel outil pourrait être utilisé.

Je pourrais par exemple parfaitement utiliser libreoffice writer pour faire un très beau document (comme Ysabeau) et ensuite l'animer. De plus il pourrait avoir plusieurs pages et permettre de lever le principal frein à l'utilisation de Sozi, qui est pour moi la scénarisation sans mouvement. Tout faire par le changement de cadre est assez lourd, comme expliqué plus bas, dès fois faire "flèche de droite" "flèche de gauche" avec tout qui reste en place permet de bien montrer les diffs et c'est très parlant. Je l'ai déjà fait avec Sozi, mais le positionnement des cadre était une plaie à faire pour que la transition soit bonne.

On en revient pour moi au fait, que des outils comme impress et powerpoint sont très bon pour la structuration spatiale de la présentation, mais leurs players et animations sont complètements nuls en 2021. Je suis incapable d'avoir ne vidéo qui marche sous windows (de la salle de conf) et linux avec libreoffice et même quand j'exporte en pdf, le perds les animations et les vidéos ne marchent pas sur tout les OS …

Tout cela est pénible.

Sozi pourrait être le player ultime ajoutant toute la partie animation (et inclusion de vidéos) à un travail déjà effectué !

Mon rêve, un export Sozi de Impress, qui permettrait d'ouvrir dans Sozi, le l'odp (via pdf ou autre import) (multi-pages, j'insiste) avec les anims faites sous LO récupérées et remettre une couche d'anim au petits oignons en plus dans chaque slide et entre chaque slides.

On pourrait aussi du coup prendre des présentations beamer et récupérer les menus auto et tout ça.

Le travail que tu as fait d'ajout de JS sur un SVG est fantastique, mais il occasionne une telle rupture dans l'usage, que ça limite considérablement la base d'utilisateurs.

Si tu pouvais faire la même chose, non pas avec le SVG mais le PDF, je pense que tu multiplierais par 100x ta base d'utilisateurs, car tu viendrais en aval de tout ce qui existe, contrairement à aujourd'hui ou tu dis changez tout votre workflow et vous pourrez utiliser Sozi.

En gros un module PDF.js pour Sozi, le ferait passer dans une toute autre catégorie !

Et je pense que du coup, ça serait plus simple d'avoir des bakers pour que tu puisses y passer du temps.

Pour l'instant, ça ne concerne que les hypsters de la présentation, pas les bons pères de famille ;-).

Je suis d'accord avec Guillaume. De notre cotés technique et scientifique, on a Beamer, si on veut se focaliser sur le fond.

Le problème, c'est que l'objectif de mon travail ce n'est pas les maths et les concepts. C'est la comparaison des résultats de méthodes différentes, d'expé et num … De ce fait je dois mettre en vis à vis des quantités scalaires dans (X,Y) où même (X,Y,Z,t) et montrer que ce n'est pas trop mal.

Du coup, je peux prendre une méthode montrer les résultats, faire une autre slide et montrer les mêmes résultats avec une autre méthode, regarder les erreurs, faire des commentaires.

Il faut arriver à faire passer ces informations dans un temps très court, les superpositions doivent donc être parfaites et animations au service du message, pas d'une cause graphique.

En fait ce que serait vraiment top, serait de pouvoir partir d'un .odp, et de pouvoir faire les animations dans les slides avec Sozi et de pouvoir passer d'une slide à l'autre avec des scénarisations ou évènements.

Zoomer sur une image avec Sozi est top, mais faire apparaître simplement des objets et faire table rase en changeant de diapo est nécessaire.

Toutes les solutions qui prétendent pouvoir facilement séparer fond et forme, ont mis mes doctorants dans une détresse forte pour leurs soutenances de thèse, car pour beamer, à chaque fois ils finnissaient par faire une grosse slide dans inkscape et l'importer, sachant que le passage d'une slide à l'autre en WYSIWYM était un enfer d'itérations frustrantes.

C'est pour moi toujours un sujet assez chaud en terme de réflexion!

Il y a 10 ans, je faisais mes présentations en Sozi et j'étais très fier du résultat !

Si j'ai fini par arrêter, c'est que le travail nécessaire pour faire une belle présentation est 10x plus long qu'une présentation libreoffice …

En fait, pour faire un SVG en libre, c'est principalement Inkscape, et ce logiciel demande de tout créer soit même, de ce fait c'est long, très long.

De plus le support des document svg était incomplet à l'époque dans tout les navigateurs et Sozi assurait la compatibilité avec Firefox.

Par exemple, une vidéo insérée dans Firefox fonctionnait bien, mais dans chrome, non …

Il fallait, donc faire pas mal de taf pour avoir quelque chose bien.

Il est clair que mes présentations de l'époque étaient bien plus classe que celles d'aujourd'hui. Par contre, il me faut 5x moins de temps pour faire une présentation et aujourd'hui je dois avouer que c'est bien cela qui prime !

Ce qui pourrait être intéressant, serait d'avoir des workflows présentés, car peut être qu'il y a autre chose que Inkscape pour faire le patron de base qui sera animé.

On a voulu faire pareil, une alarme sur un congel en bioméca qui ne peut pas tomber en panne, du coup RPi et consort, mais lorsqu'on a voulu regarder pour les forfaits on a vu que free interdit le M2M, et les forfaits M2M sont tous plus cher que free pour une quantité de data ridicule !

Bon au final je pense que si il y a peu de traffic, ils laisseront passer, mais c'est toujours bon. de savoir que ce n'est pas autorisé

Toute transformation d'image n'est pas inversible. Les transformations d'images inversibles continues et à dérivées continues sont appelées difféomorphe, elles sont le seules à garantir l'inversibilité, permettant de reconstruire l'image.

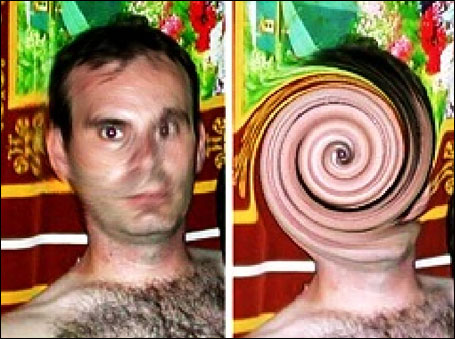

L'exemple du swirl est assez parlante (attention, image dérangeante):

On voit bien que la reconstruction n'est pas parfaite, alors que pour le coup je pense que la fonction est difféomorphe, si on en prend la définition de skimage, car c'est une exponentielle sur les coordonnées polaires.

Donc, même dans ce cas favorable, la quantification, rend la reconstruction possible, mais pas parfaite. Pour moi c'est bien plus difficile que le simple flou que l'on voit sur les images !

Pour info l'identification de la fonction de transformation d'une image vers une autre s'appelle le recalage d'image (Image Registration, DIC, PIV, Optical Flow), j'ai fait des articles sur ce sujet ici même, et je peux garantir, que sans l'algorithme, personne ne saurait retrouver la transformation inverse, c'est juste irréaliste !

Peut être, mais quand on est n'est pas capable de distinguer un filtre de flou d'un filtre de bougé…

Bon, photoshop, ce n'est pas la science hein, il va falloir réfléchir un peu avant d'écrire des sottises.

Vous ne comprenez visiblement rien au sujet, mais vous insistez pour avoir le dernier mot …

Non, ça mérite bien le fameux duty call

Tout les flous que je connais peuvent être vus comme un opération de convolution (peut être qu'il en existe qui échappent à cette affirmation) entre une image non-floutée et un noyau de convolution appelée fonction d'étalement du point ou PSF, comme expliqué précédemment. Donc, si on connaît la PSF, on peut déconvoluer.

Dans ce contexte, la distinction entre un flou isotrope tel que celui appliqué sur l'image se révèle être une PSF différente, point final. Créer une PSF revient à prendre une réponse impulsionnelle et appliquer le filtre, puis normaliser par la moyenne des niveaux de gris …

Ce n'est pas bien dur à faire. Ensuite, on passe dans un algo de type déconvolution de Wiener, on choisi l'amplitude du bruit qui imposera une coupure fréquentielle à l'image et c'est fini. On n'est pas dans les experts à Miami là tout de même …

Au passage un flou de bougé est infiniment plus difficile à reconstruire qu'un simple flou gaussien isotrope avec un gros écart type … Donc, si ça marche pour le flou de bougé, ne parlons pas du flou appliqué ici.

point. Final. A la ligne.

Un peu confus non ? C'est final genre -->[] ou c'est à la ligne …

Ces petites blagues sur le dos des gens, sans chercher à comprendre, sont agaçantes, mais cela n'a rien de grave, juste un peu agaçant.

c'est monter sur ses grands chevaux … Du coup, il n'est pas possible de signifier son agacement dans un échange ?

Ton exemple était faux, et ta tournure de phrase :

En 4ème, j'ai eu 12 de moyenne. Quelles étaient mes notes de français ?

sous-entend explicitement qu'un enfant que 15 ans (4ième) n'aurait pas fait une telle erreur …

Il me semble l'avoir expliqué ton erreur de raisonnement de manière non condescendante et non agressive.

Ton post est inutilement désagréable, du coup si ce n'est pas de l'humour au dépend d'une personne qu'est-ce ?

Après, c'était peut être une réponse trop rapide. Tu considères que je te prête "un comportement et une volonté que tu démens", soit, mais du coup le sens de ton commentaire m'échappe totalement. Je t'ai juste signifié que ta blague m'avait agacé et que visiblement, tu n'avais pas compris la teneur de mon questionnement, mais sur ce point, c'est bien ma faute, que de ne pas avoir bien posé le problème.

La bienveillance des échange est bien souvent conditionnée par leurs antécédents. Il est clair que j'ai fait le choix de te signifier que tu m'avais agacé, tout en exprimant que ce n'était pas grave.

Du coup, je ne vois pas trop le problème.

Par contre, je n'ai pas mis d'intention, ta phrase semble être humoristique et tourne en dérision mon questionnement, sans que tu n'aies pris le temps de le comprendre. C'est une interprétation et pas un procès d'intention. Je ne cherche pas à savoir pourquoi tu as fait ça, je signifie mon agacement, sur l'interprétation de ton post.

évite peut être de prêter de mauvaises intentions comme cela aux autres.

par contre, l'impératif est une injonction, de plus sur un point que j'estime faux : prêter de mauvaise intentions, avec une fin de post en bref, pouvant être aisément interprété comme la manifestation d'une lassitude, permettant de couper court à une conversation désagréable.

Du coup, tu ne veux pas envenimer, tu ne tiens pas à débattre, ridiculise mon agacement (monter sur tes grands chevaux) mais tu formules des injonctions et coupes court à la discussion.

Dans l'absolue, je n'ai pas à t'expliquer comment avoir des échanges sains, mais en tout cas tes modalités pour échanger avec moi ne me conviennent pas du tout.

Tout les arguments sont valides mais la conclusion est discutable. La vrai quesiton est celle de la réversibilité de la perte d’entropie de l'image. C'est justement le point des méthodes de déconvolution. Si il est clair qu'un calcul d'entropie avant et après donnera des résultats différents, il n'est pas si évident que l'opération inverse ne soit pas accessible dans une certaine mesure. Les questions sont est-ce que la quantification des niveaux de gris (codage sur 3*8bits ) entraîne une irreversilité et est-ce que la transformation en vidéo (probablement h26{4|5}) apporte une sécurité suffisante si quelqu'un s'amuse à essayer de reconstruire les visages.

En 4ème, j'ai eu 12 de moyenne. Quelles étaient mes notes de français ?

Il est bien indenté par rapport au poste de barmic, même si j'inclue des éléments de vos postes, donc pas de problème d'amalgames tout seul dans ma tête. En général sur ce forum, lorsque l'on répond à quelqu'un l'indentation permet de comprendre qui est destinataire direct.

Enfin pour être plus clair :

On ne peut pas reconstituer une information qui a été "détruite", c'est en dehors des théories de la physique. N'importe quel filtre de floutage est destructeur, donc c'est physiquement impossible de reconstituer une image parfaitement identique à elle-même après sa "destruction".

Évoquer de manière péremptoire que l'on est en dehors des lois de la physique, est assez désagréable, lorsque l'on ne cherche pas à comprendre les enjeux et les possibilités qu'il existe en analyse d'images, et c'est d'ailleurs sur ce sujet que Francesco vous répondait.

Ce n'est pas un problème pour moi de se tromper, mais ayant un on égo de chercheur de la génération Y, les positions d'autorités me rendent souvent agressif, encore plus dans cette période de police de la pensée liée à la Covid19.

Avec comme limite de ne pas convertir de matriciel en SVG (mais du SVG en matriciel, oui).

Quand j'utilise la découpe laser, je pars souvent de PNG N&B et je dois les vectoriser. Je trouve que ce processus est assez marrant, mais pour l'instant les meilleurs outils sont ceux du web !

Après, c'est clairement un sujet trop éloigné de Yoga.

C'est tellement simple qu'en faire une dépêche parait pas pertinent.

C'est tout aussi vrai pour la GUI, non ?

Je trouve au contraire, que le fait que cela soit simple justifie que ça apparaisse dans la dépêche ! Après, c'est vous qui l'écrivez, donc c'est vous qui décidez !

Merci pour le soft, j'essayerais de voir ce que j'arrive à faire sur un document un de ces jours !

En 4ème, j'ai eu 12 de moyenne. Quelles étaient mes notes de français ?

Ces petites blagues sur le dos des gens, sans chercher à comprendre, sont agaçantes, mais cela n'a rien de grave, juste un peu agaçant.

Attention aussi aux confusions : "deconvoluer" une image ça n'est pas la même chose que faire des corrections d'images d'observation astronomique.

Confus. Il y a d'autres corrections dans l'analyse d'image astronomiques que la déconvolution, mais celle-ci en fait partie.

Faire une déconvolution va peut-être aider éventuellement une IA en réduisant le champ des possibilités, mais sûrement pas à faire des miracles.

Non, de ce que j'ai lu (mais c'est pour moi un sujet marginal d'intérêt), la plupart des algos d'IA sur la déconvolution travaillent à chercher la PSF, en partant du principe que le flou de bouger se traduit par une "trajectoire" à identifier, car celle-ci peut se traduire par une PSF dédiée. Il s'agit donc de trouver le mouvement qui a eu lieu entre le moment où l'on a commencé à intégrer le flux rayonné, et le moment où on a arrêté. Trouver une trajectoire spatio-temporelle avec comme seul indice le résultat en terme de flou est un problème mal posé. Sur les problèmes mal posés, l'IA peut apportés beaucoup pour éviter les minimums locaux, et trouver le bon espace d'exploration à moindre coût.

Sur des images sans flou de bougé mais avec un flou, dont on ne peut pas avoir d'autre représentation des objets qu'avec la seule modalité floutée, alors, il y a sûrement du travail qui peut être fait en IA sur l'identification de la PSF.

Lorsque l'on peut aller lire le code de floutage, reconstruire la PSF, ne doit pas être bien difficile.

En bref, je suis d'accord avec les autres moules, le plus sûr est le carré noir. C'est une destruction certaine de l'information, nécessaire à la reconnaissance, pour le flou, il faudrait y passer un temps important pour trancher.

un flou n'est pas une moyenne et peut être représenté mathématiquement par une convolution. Une moyenne prend N valeur et en retourne 1, la convolution prend N valeurs et en retourne N via une relation avec son voisinage.

Il existe un pan de l'analyse d'image qui travaille à des stratégies de déconvolution, qui permettent de déflouter les images par exemple.

Il s'agit de trouver une fonction d'étalement du point (point spread function PSF) qui est en somme la représentation de la convolution et de l'appliquer à l'image par des méthodes telles que la déconvolution de Wiener.

Il en existe plein pour par exemple corriger des flous de bougé, lorsque l'on ne connaît pas la trajectoire, il faut la retrouver, cela s'appelle à déconvolution aveugle.

Lorsque l'on connaît la fonction de convolution il est assez simple de déconvoluer. Et comme c'est du LL, il est simple d'aller regarder le code du flou et de fabriquer un psf.

Après, c'est vrai que la déconvolution n'est jamais parfaite, pas (plus qu'une transformation géométrique inverse ne conservera parfaitement les niveaux de gris), le fait de sauver une image avec un format destructeur avec des niveaux quantifié sur 8 ou 10 bits, peut faire que la déconvolution crée des hautes fréquences parasites qui la rendront inopérante …

C'était sur ce point que je me posais des questions, mais il est vrai que je n'avais pas pris le temps de bien poser le problème.

Il existe aussi des algorithme de superrésolution sur des vidéos qui associés à la déconvolution pourraient régulariser le problème.

De manière générale, il est sain d'éviter de penser que la personne qui écrit quelque chose est une abrutie et de faire un raisonnement par l'absurde faux derrière, mais bon vous n'avez pas été le seul :

N'importe quel filtre de floutage est destructeur, donc c'est physiquement impossible de reconstituer une image parfaitement identique à elle-même après sa "destruction".

Il n'est pas question d'être identique, mais de pouvoir reconnaître un visage, cela fait une très grosse différence.

De plus sur un signal continu, il est assez simple d'inverser la convolution, le fait que le signal soit quantifié, et ensuite compressé destructivement, doit probablement réduire les chances de pouvoir recréer une image acceptable.

La seule possibilité de s'en approcher est d'utiliser des IA, et encore, il ne faut pas que le filtre appliqué ait été trop important (trop de flou, trop de mélange et/ou déformation). Dans l'exemple du journal, le flou est tellement important qu'on n'arrive même pas à distinguer l'implantation des yeux, donc aucune chance même pour l'IA la plus sophistiquée de reconstituer un visage, en tout cas qui ressemble à la personne de départ.

Il faudrait tester, on est souvent surpris, mais il est très probable que cette personne ait raison. Il n'est par contre absolument pas nécessaire d'utiliser de l'IA, lorsque l'on a la donnée de sortie et le modèle. On résout des problèmes mal posés depuis des siècles (merci Hadamard), appeler l'IA, dès que l'on n'a pas envie de réfléchir est un peu facile.

J'avais lu cette publi, il y a quelques années, mais il est vrai que le niveau de convolution ici, est bien plus élevé. Mais comme on n'a pas la PSF, celle identifiée est forcément moins précise qu'une que l'on peut reconstruire avec un algo.

Est-il assuré que l'on ne puisse pas dé-flouter les visages ?

Si l'algo est ouvert, alors trouver la meilleure déconvolution sur la séquence d'image semble possible, non ?

Un pédocriminel avait été arrêté, car il avait appliqué une déformation en spirale sur sa photo, et la police scientifique avait réussi à trouver la transformation inverse et reconstituer sa photo !

La c'est encore plus simple !!

Du coup, quelle est la sécurité associée à ce genre d'outils ?

Bon après je n'ai que très peu joué avec les outils de déconvolution, donc ce n'est peut être pas si simple !!

Ceci dit, étant donné que YOGA est aussi un outil en CLI et une bibliothèque Python, il est tout à fait possible d'écrire un script ou un outil qui s’appuierait sur YOGA pour effectuer ce genre d'opération.

Tout à fait juste. C'est dommage que la dépêche soit si orientée interface graphique.

Peut être qu'illustrer les nouveautés avec des insertions de codes aurait été plus parlant !

Avez vous pensé à faire une galerie de type matplotlib, avec des exemples de codes et les résultats. Ça pourrait être assez simple à faire et rendre une image dans le navigateur est assez simple !

un truc qui pourrait être super utile, serait de pouvoir prendre un fichier odf, le décompresser, récupérer les images et les réduire dans Yoga avant de les remplacer par celles optimisées et refaire l'archive !

Il y a un outil de redimensionnement dans libreoffice, mais il n'est pas forcément hyper intéressant, dans le sens ou son principal intérêt est de réduire la résolution de l'image par rapport à sa taille dans la présentation ou dans le fichier texte.

Je me doute bien que le sujet est bien sensible et complexe.

De ce que j'ai vu, la plupart des gens qui arrivent à monétiser leurs travaux sont les influenceurs sur youtube. Le problème, c'est que cela demande de passer un temps énorme à faire ce travail. Il faut faire au moins une vidéo par semaine pour attirer durablement, et le temps d'arriver à créer une communauté se chiffre en années sur ce genre de sujets.

Mais des choses comme des timelaps de création sur ZeMarmot, des nouvelles fonctionnalités de gimps comme tu le fais ici, mais avec une vidéo et quelqu'un qui parle dessus, attirerais plus de monde.

Honnêtement, mon temps passé sur youtube n'est pas raisonnable et je ne peux pas aller ailleurs, car il n'y a juste pas le contenu que j'aime regarder, ou il faut aller sur trop de plateformes pour le trouver.

Youtube est une des meilleures plateforme pour inciter les gens à aller sur vos plateformes de financement.

Et pour être tout à fait clair, vous n'êtes pas X, Y. La démarche est fantastique, si vous aviez une chaîne youtube, je serais abonné directement sans me poser de question.

Après, il est clair que ça demande un taf de dingue, mais peut être qu'une personne qui aime le montage vidéo pourrait s'associer à vous.

Franchement, je suis désolé, si tu trouves que j'enfonce des portes ouvertes, mais quand je vois des gens comme Linus de LTT qui se font des millions, je trouve que c'est bien dommage que des gens comme vous n'arrivent pas à vivre de leur passion.

C'est vraiment chouette que votre collaboration à tout les deux ait donné autant d'amélioration pour tout les utilisateurs de GIMP.

Peut-être faudrait il faire un peu de pub, je sais bien que cela nécessite de passer par des plateformes de type youtube, mais quand on voit les donations à votre projet qui sont de 1256€/mois, au regard de l'ampleur du projet et de ce que ça rapport au collectif avec GIMP, peut être que mettre en avant cela en allant chez des influenceurs dans le domaine de la création graphique, vous permettrait de toucher un autre public.

1256€ à deux par mois, ce n'est vraiment pas grand chose, c'est être dans la précarité si vous vous y consacrez à 100% ou faire des jobs alimentaires. C'est un peu triste, car votre projet est vraiment chouette et vertueux. Peut être communiquer en anglais pour augmenter la base de donateurs ?

Il me semble que vous avez ciblé 8k€ pour pouvoir travailler sereinement, cela ne semble pas inaccessible, par exemple marcan semble avoir réussi à se faire un salaire normal pour travailler sur le portage de linux sur le macbook ARM. Il y a aussi Syama Pedersen qui a 7800 contributeurs avec un minimum à 2€/mois et un max à 22€/mois. Du coup, ne pensez vous pas qu'en essayant de créer une petite communauté autour d'une plateforme non-libre, vous pourriez vous autofinancer de manière pérenne ?

Je n'y connais rien, mais je trouve cela dommage que votre démarche ne touche que si peu de monde !

Ou c'est peut être que la FSF ne sert plus à grand chose aujourd'hui. Ils n'ont pas su embrasser la culture libre et finalement n'ont pas de contributions majeures ces dernières années, du coup tout le monde se fou un peu de ce qu'ils peuvent bien dire. Avoir RMS est peut être pour eux, à la vue de leur inutilité, le seul moyen d'espérer avoir une influence. C'est assez affligeant à vrai dire.

J'ai testé Elmer FEM et à l'époque, un peu SALOME, il faudrait tester FreeFEM, j'en ai conclu que je n'ai plus (j'ai failli faire un PhD sur les plasmas, comme un con j'ai dit non) le niveau, et de loin.

Elmer est une bonne solution mais si ce que tu veux faire n'est pas dedans, contrairement à COMSOL, tu auras du mal …

La solution OpenSource la plus proche de COMSOL est fenics. C'est une code FEM qui permet de résoudre des formulations variationnelles. Donc si tu es capable de formuler ton problème sous forme variationnelle affaiblie, et du coup compatible avec la FEM, tu pourras le résoudre avec fenics.

le coeur est en C++ mais tu peux accéder à la partie formulation variationnelle, choix des éléments, mise en données, lancement de la simulation et récupération des données en python.

Une tentative d'intégration avec FreeCAD a été lancée, elle permet d'exporter au format de mise en données de fenics les groupes de noeuds et d'éléments nécessaires à la simulation.

Il existe aussi sfepy qui permet de faire des choses assez avancées il faut voir si ton problème peut se formuler simplement avec.

Après tu peux aussi faire du couplage faible avec Salome et des codes dédiés, mais ne connaissant pas la physique du plasma, je ne sais pas trop si il y a des outils disponibles.

En ce qui concerne OpenFOAM, ce n'est pas des éléments finis, mais des volumes finis, Une discrétisation par la méthode des volumes finis (MVF) est basée sur une forme intégrale de l'EDP à résoudre (par exemple, la conservation de la masse, de la quantité de mouvement ou de l'énergie). L'EDP est écrite sous une forme qui peut être résolue pour un volume fini (ou cellule) donné. Le domaine de calcul est discrétisé en volumes finis, puis les équations de base sont résolues pour chaque volume. Le système d'équations résultant implique généralement des flux de la variable conservée, et donc le calcul des flux est très important dans le MVF, alors que la discrétisation par la méthode des éléments finis (FEM) est basée sur une représentation par morceaux de la solution en termes de fonctions de base spécifiées. Le domaine de calcul est divisé en domaines plus petits (éléments finis) et la solution dans chaque élément est construite à partir des fonctions de base. Les équations réelles qui sont résolues sont généralement obtenues en reformulant l'équation de conservation sous une forme faible : les variables de champ sont écrites en termes de fonctions de base, l'équation est multipliée par des fonctions de test appropriées, puis intégrée sur un élément. La solution FEM étant formulée en termes de fonctions de base spécifiques, on en sait beaucoup plus sur la solution que pour MVF.

Il faut donc vraiment évaluer ce que tu veux récupérer comme infos sur ton problème avant de savoir si tu vas pouvoir basculer sur la MVF.

En fait Zenitram et toi vous parlez de deux choses différentes.

Zenitram dit que si les options par défaut sont mauvaises les gens considéreront que le logiciel n'est pas au niveau de la concurrence sans faire le moindre effort. Là ou il trolle un peu, c'est qu'il dit qu'ils ont raison. Personnellement, je ne juge pas le bien ou le mal, je constate, que quand je dis que je trouve LO super, les gens ouvrent grands les yeux et quand j'explique pourquoi, les gens soufflent et disent, c'est pas pour moi trop compliqué. On parle de BAC+8, mais les sujets attenants à mon choix les indiffèrent !

Donc ces personnes là, sont inaccessibles, et c'est selon moi le pb principal de LO, d'être un MSO à la ramasse dans la tête des gens in-intéressés au LL.

C'est cette masse qui fait basculer et permet d'avoir de l'argent pour des développeurs. C'est un produit end-user, pas comme le noyau, ou une lib pour analyser des codecs ! Ça doit plaire au end-user point.

MSO l'a compris et investi beaucoup dans ces aspects et du coup fidélise sa clientèle qui est prête à payer, et de ce fait nous empêche d'échanger avec eux quand on est sur Linux.

Honnêtement, vu le temps que cela me fait perdre, si il y avait une version native à jour sur Linux, je pense que je l’achèterais non pas pour un usage quotidien, mais pour juste avoir la paix dans les échanges …

Tu représentes une experte qui apporte énormément et met tout à disposition des autres, et je te remercie beaucoup pour ça, mais un dirait un utilisateur de Vim fasse à un utilisateur de Visual Studio Code !

Ils ne s'entendront jamais !

Tu as tout à fait raison ! On peut faire de magnifiques choses avec LO, si il y a un léger avantage sur la justification des paragraphes et des tableaux plus élégants (mais très chiant à faire), qui font un style sympa (fait par d'autres, hein), le style par défaut de LaTeX est beau. Celui de LibreOffice est ideux. Je suis désolé mais ce n'est pas normal de devoir être un pro pour faire un document élégant. C'est bien dommage que tes modèles ne soient pas par défaut dans LibreOffice, et c'est bien dommage qu'ils ne fassent pas un effort pour avoir un document élégant par défaut.

Il ne faut pas se mentir, le principal avantage de LO est de faire comme MSO en libre, mais du coup toutes les mises en pages sous impress sont ratée, non pas par un manque de compatibilité, mais par le fait qu'il y a des tas de polices non-libres dans MSO. Il serait tellement simple d'analyser les polices présentes dans un document et de proposer de les installer, soit sur le système, soit dans le document si nécessaire … Alors oui, si le document embarquait les polices alors il serait plus lourd (quelques centaines de ko …), mais à l'époque ou des gens sont d'accord pour tout mettre en conteneurs dockers, cela me semble vraiment stupide comme objection. La taille d'une image haute résilution est certainement supérieure à la taille de toutes les polices présentes dans MSO.

C'est donc bien le pb, on voit bien que leur objectif n'est pas de capter un public, sinon ces améliorations triviales auraient été faites depuis bine longtemps.

Si les développeurs s'éclatent et que des gens comme toi ou moi arrivons à faire des documents de qualité, c'est déjà pas mal, mai ça ne changera pas le rapport de domination de MSO sur LO.

OO tente de faire changer ce rapport de domination, et les gens trouvent que ce n'est pas si mal.

Personnellement, les animations, les vidéos, marchent tellement mal depuis MSO que je n'ai jamais trouvé cela utile.

Et j'ai tellement de polices moisies sur mon laptop, que je n'ai pas trop de pb de compatibilité !

Donc oui, tu as raison LO est un formidable logiciel, et ils ont raisons LO ne fait pas assez pour faciliter la migration, alors que c'est quasiment sa raison d'être.

Et ne pas venir me dire, c'est libre tu n'as qu'à le faire. Perso, je suis assez expert pour qu'il fasse ce que je veux, donc non, je ne passerais pas de mon temps pour changer ça.

Au CNRS on fait rendez-vous.renater.fr, qui nous permet de faire tourner jitsi. Même avec ça, on s'en sortait pas, même quand le serveur n'était pas chargé. Donc, ce n'est vraiment si simple, de plus la possibilité de rejoindre l'audio par téléphone n'était pas activée …

Le problème est que l'on ne peut pas être de tout les combats, et comme je ne suis pas dans la confidence des gens des SI des écoles d'ing ou fac, c'est un peu dur de pouvoir avoir un quelconque moyen autre que des plateformes extérieures. Il y a sûrement un travail à faire.

# Assez complexe en général

Posté par freejeff . En réponse au journal À la recherche des pièces détachées. Comment mieux (p)réparer notre futur, en réparant nos appareils. Évalué à 10.

Salut,

En tant que mécanicien pratiquant l'impression 3D et ayant des rudiments de conception assistée par ordinateur (CAD) et de réalisation de pièces, je vais me permettre de te donner mon avis. Je laisse l'aspect logistique à d'autres.

Il y a des parties réalisables. Des pièces non soumises à une charge mécanique importantes qui cassent, ou s'il n'y a pas de contraintes d'encombrement peuvent être facilement refaites en 3D avec du PLA. C'est le premier cas d'étude.

Il faut être capable d'utiliser un soft de CAD (FreeCAD, OpenSCAD, OnShape, CATIA, Fusion 360, …), faire des formes primaires à partir des surfaces fonctionnelles et grossir l'ensemble pour que les limites de l'impression 3D soient négligeable doit permettre d'arriver à un résultat rapidement.

Il faut par contre se faire des des outils de mesures, car les assemblages dans les pièces mécanique, ne sont pas toujours fait dans l'électroménager avec des pièces standards. Il faut faire aussi attention, si il y a de la chaleur, alors les matériaux du FDM sont inutilisables (fluage à température faible), il faut plutôt s'orienter vers de la résine, qui est plus exigeante en terme d'utilisation et que l'on trouve moins en FabLab. Je pense que cela peut correspondre à quelques cas d'utilisation.

Sur les parties soumises à des efforts mécaniques, par exemple un coupleur de couteaux avec l'arbre moteur pour un mixer ou moulin, ces pièces sont faites en injection avec des matériaux ad-hoc, il est illusoire de vouloir les refaire, l'encombrement est décisif, la qualité du matériau fondamental tant pour la mécanique que pour l'aspect sanitaire, car avoir des bouts de plastique dont on ignore tout dans son assiette semble à éviter …

Les propriétés des matériaux semblent aussi un frein majeur, refaire un tuyau d'aspirateur, par exemple semble non trivial … Ce ne sont que quelques exemple pour illustrer que le pb est complexe et ne peut probablement pas se faire si simplement.

Si on passe à ce qui utilise des capteurs ou des actionneurs, alors c'est encore pire.

Dans bien des cas, les pièces d'électroniques de puissance cassées peuvent être identifiées par contrôle visuel, donc si la référence est encore visible il est possible d'acheter de composant et le remplacer en sachant souder. Si ce n'est pas le cas, il faut être capable de faire une analyse électrique avec un multimètre, ce qui peut nous ramener au cas précédent.

Si on prend les éléments de chauffe, c'est bien souvent les résistances qui se mettent en court-circuit, toutes ces resistances sont faites sur mesure pour l'appareil, en faire une manuellement serait un travail qui couterait très cher par rapport au prix de l'appareil sans l'assurance d'avoir la bonne température, car cela dépend du type de matériau et aller identifier ces propriétés thermiques et électriques ne semble pas réaliste dans le contexte d'une réparation.

Si une carte électro(tech)nique lache et que l'on n'identifie pas le composant, certaines utilisent directement le 220V (quasiment tout l'électroménager), donc manipuler ce types de circuit peut potentiellement être mortel, pas sûr que cela vaille le coût …

Les réparateurs, changent ce genre de cartes, il est assez rare qu'ils s'engagent à sur des composant pouvant prendre feu ou pouvant occasionner des risques électriques.

Les repair-cafés sont des lieux ou des gens ayant beaucoup d'expertise se réunissent pour aider à réparer tant que possible, mais je suis assez dubitatif sur les aspects responsabilité civile d'une telle oeuvre … Tant qu'il n'y a pas d'accident, on n'en parlera pas, je ne voudrais pas être le gars qui a aidé et expliqué et dont la personne se serait blessée chez elle avec l'objet réparé avec ou sans bidouillage aval.

Par contre, je trouve qu'il est vraiment dommage de ne pas avoir de ressourcerie générale qui permettrait à des professionnels de mettre à disposition des pièces détachées qui partent à la benne chaque année … Il faudrait contraindre les industriels à avoir ds référencement explicites sur les produits permettant à des ouvriers de créer ces ressourcerie pour créer des catalogues de pièces détachées d'occasion issues des déchets des gens qui ne veulent pas recycler et avoir des ressources à disposition que l'on pourrait réemployer dans des FabLab ou il est possible de concevoir de manière dédiée aux pièces de ressourcerie tant sur l'aspect mécanique, électronique, électrotechnique.

Quand on voit le prix que l'on doit payer pour une enceinte, des moteurs, des roulettes, pour concevoir un nouveau produit, c'est clairement un frein à l'innovation !

Je serais prêt à ce que mes impôts concernant la déchetterie, si je pouvais aller chercher gratuitement des pièces bien classées dans une ressourcerie municipale !

Il faudrait de l'emploi beaucoup d'emploi pour le réemploi !

Personnellement, j'y suis très favorable !

[^] # Re: Outil fantastique, mais chronophage

Posté par freejeff . En réponse au journal Des nouvelles de Sozi. Évalué à 4.

Tout ce que vous dites est vrai, mais ce n'est pas le sujet. Aussi merdique qu'il soit, le pdf est le seul format d'export qui conserve la mise en page et garde l'aspect vectoriel qui soit implémenté dans tout les logiciels et soit lisible dans un navigateur. SVG, n'est pas parfaitement pris en charge par LO par exemple.

Donc, oui on pourrait tout faire en HTML+CSS+JS, mais si c'était si simple, pourquoi l'export LO est si pourri par exemple. Sans parler de beamer, qui ne sait pas comment faire, et powerpoint … Personne ne sait faire ça. Donc ça appelle à des développements très important sur les softs qui font les contenus … ce n'est pas prêt d'arriver.

Le point est que le travaille de Guillaume, qui exploite exactement ce que vous décrivez, est probablement le player JS+SVG+video, le plus avancé du monde. Il faut payer un pris important sur le workflow pour l'utiliser, de ce fait peu de gens vont le faire. Si demain tu pouvais utiliser tes outils comme beamer, impress, powerpoint et ensuite passer par la case Sozi, ou mieux avoir un export directement compatible avec Sozi, alors tout le monde aurait envie de l'utiliser !

Après, ce que je propose requiert un énorme travail, j'imagine bien que c'est n'est pas du tout dans les priorités de Guillaume.

Le point que je voulais mettre ne avant, c'est que pour avoir une base d'utilisateurs prêt à subventionner le temps passé sur le logiciel, il faut répondre à un besoin du plus grand nombre.

Si avoir des présentations en lignes est bien un besoin du plus grand nombre, changer son workflow de présentation n'est pas possible pour la plupart. Cela veut dire que la base d'utilisateurs, restera faible, et la possibilité de financement également !

[^] # Re: Outil fantastique, mais chronophage

Posté par freejeff . En réponse au journal Des nouvelles de Sozi. Évalué à 5.

Il y a eu un très grand changement par rapport au moment où tu as commencé à écrire Sozi !

Tous les navigateurs supportent le pdf en natif !

Je pense que si tu relâchais la contrainte du SVG pour permettre le pdf, alors n'importe quel outil pourrait être utilisé.

Je pourrais par exemple parfaitement utiliser libreoffice writer pour faire un très beau document (comme Ysabeau) et ensuite l'animer. De plus il pourrait avoir plusieurs pages et permettre de lever le principal frein à l'utilisation de Sozi, qui est pour moi la scénarisation sans mouvement. Tout faire par le changement de cadre est assez lourd, comme expliqué plus bas, dès fois faire "flèche de droite" "flèche de gauche" avec tout qui reste en place permet de bien montrer les diffs et c'est très parlant. Je l'ai déjà fait avec Sozi, mais le positionnement des cadre était une plaie à faire pour que la transition soit bonne.

On en revient pour moi au fait, que des outils comme impress et powerpoint sont très bon pour la structuration spatiale de la présentation, mais leurs players et animations sont complètements nuls en 2021. Je suis incapable d'avoir ne vidéo qui marche sous windows (de la salle de conf) et linux avec libreoffice et même quand j'exporte en pdf, le perds les animations et les vidéos ne marchent pas sur tout les OS …

Tout cela est pénible.

Sozi pourrait être le player ultime ajoutant toute la partie animation (et inclusion de vidéos) à un travail déjà effectué !

Mon rêve, un export Sozi de Impress, qui permettrait d'ouvrir dans Sozi, le l'odp (via pdf ou autre import) (multi-pages, j'insiste) avec les anims faites sous LO récupérées et remettre une couche d'anim au petits oignons en plus dans chaque slide et entre chaque slides.

On pourrait aussi du coup prendre des présentations beamer et récupérer les menus auto et tout ça.

Le travail que tu as fait d'ajout de JS sur un SVG est fantastique, mais il occasionne une telle rupture dans l'usage, que ça limite considérablement la base d'utilisateurs.

Si tu pouvais faire la même chose, non pas avec le SVG mais le PDF, je pense que tu multiplierais par 100x ta base d'utilisateurs, car tu viendrais en aval de tout ce qui existe, contrairement à aujourd'hui ou tu dis changez tout votre workflow et vous pourrez utiliser Sozi.

En gros un module PDF.js pour Sozi, le ferait passer dans une toute autre catégorie !

Et je pense que du coup, ça serait plus simple d'avoir des bakers pour que tu puisses y passer du temps.

Pour l'instant, ça ne concerne que les hypsters de la présentation, pas les bons pères de famille ;-).

[^] # Re: Outil fantastique, mais chronophage

Posté par freejeff . En réponse au journal Des nouvelles de Sozi. Évalué à 4.

Je suis d'accord avec Guillaume. De notre cotés technique et scientifique, on a Beamer, si on veut se focaliser sur le fond.

Le problème, c'est que l'objectif de mon travail ce n'est pas les maths et les concepts. C'est la comparaison des résultats de méthodes différentes, d'expé et num … De ce fait je dois mettre en vis à vis des quantités scalaires dans (X,Y) où même (X,Y,Z,t) et montrer que ce n'est pas trop mal.

Du coup, je peux prendre une méthode montrer les résultats, faire une autre slide et montrer les mêmes résultats avec une autre méthode, regarder les erreurs, faire des commentaires.

Il faut arriver à faire passer ces informations dans un temps très court, les superpositions doivent donc être parfaites et animations au service du message, pas d'une cause graphique.

En fait ce que serait vraiment top, serait de pouvoir partir d'un .odp, et de pouvoir faire les animations dans les slides avec Sozi et de pouvoir passer d'une slide à l'autre avec des scénarisations ou évènements.

Zoomer sur une image avec Sozi est top, mais faire apparaître simplement des objets et faire table rase en changeant de diapo est nécessaire.

Toutes les solutions qui prétendent pouvoir facilement séparer fond et forme, ont mis mes doctorants dans une détresse forte pour leurs soutenances de thèse, car pour beamer, à chaque fois ils finnissaient par faire une grosse slide dans inkscape et l'importer, sachant que le passage d'une slide à l'autre en WYSIWYM était un enfer d'itérations frustrantes.

C'est pour moi toujours un sujet assez chaud en terme de réflexion!

# Outil fantastique, mais chronophage

Posté par freejeff . En réponse au journal Des nouvelles de Sozi. Évalué à 7.

Il y a 10 ans, je faisais mes présentations en Sozi et j'étais très fier du résultat !

Si j'ai fini par arrêter, c'est que le travail nécessaire pour faire une belle présentation est 10x plus long qu'une présentation libreoffice …

En fait, pour faire un SVG en libre, c'est principalement Inkscape, et ce logiciel demande de tout créer soit même, de ce fait c'est long, très long.

De plus le support des document svg était incomplet à l'époque dans tout les navigateurs et Sozi assurait la compatibilité avec Firefox.

Par exemple, une vidéo insérée dans Firefox fonctionnait bien, mais dans chrome, non …

Il fallait, donc faire pas mal de taf pour avoir quelque chose bien.

Il est clair que mes présentations de l'époque étaient bien plus classe que celles d'aujourd'hui. Par contre, il me faut 5x moins de temps pour faire une présentation et aujourd'hui je dois avouer que c'est bien cela qui prime !

Ce qui pourrait être intéressant, serait d'avoir des workflows présentés, car peut être qu'il y a autre chose que Inkscape pour faire le patron de base qui sera animé.

Un ancien utilisateur nostalgique.

# Free interdit le M2M

Posté par freejeff . En réponse au message Recherche modèle d'alarme pour maison. Évalué à 6. Dernière modification le 23 septembre 2021 à 20:32.

On a voulu faire pareil, une alarme sur un congel en bioméca qui ne peut pas tomber en panne, du coup RPi et consort, mais lorsqu'on a voulu regarder pour les forfaits on a vu que free interdit le M2M, et les forfaits M2M sont tous plus cher que free pour une quantité de data ridicule !

Bon au final je pense que si il y a peu de traffic, ils laisseront passer, mais c'est toujours bon. de savoir que ce n'est pas autorisé

[^] # Re: Risque de déconvolution ?

Posté par freejeff . En réponse au journal Deface: flouter simplement et automatiquement les visages dans une vidéo. Évalué à 7.

Sur le swirl, c'est bien plus compliqué que ça.

Toute transformation d'image n'est pas inversible. Les transformations d'images inversibles continues et à dérivées continues sont appelées difféomorphe, elles sont le seules à garantir l'inversibilité, permettant de reconstruire l'image.

L'exemple du swirl est assez parlante (attention, image dérangeante):

On voit bien que la reconstruction n'est pas parfaite, alors que pour le coup je pense que la fonction est difféomorphe, si on en prend la définition de skimage, car c'est une exponentielle sur les coordonnées polaires.

Donc, même dans ce cas favorable, la quantification, rend la reconstruction possible, mais pas parfaite. Pour moi c'est bien plus difficile que le simple flou que l'on voit sur les images !

Pour info l'identification de la fonction de transformation d'une image vers une autre s'appelle le recalage d'image (Image Registration, DIC, PIV, Optical Flow), j'ai fait des articles sur ce sujet ici même, et je peux garantir, que sans l'algorithme, personne ne saurait retrouver la transformation inverse, c'est juste irréaliste !

[^] # Re: Risque de déconvolution ?

Posté par freejeff . En réponse au journal Deface: flouter simplement et automatiquement les visages dans une vidéo. Évalué à 4.

Bon il y a du niveau …

Bon, photoshop, ce n'est pas la science hein, il va falloir réfléchir un peu avant d'écrire des sottises.

Vous ne comprenez visiblement rien au sujet, mais vous insistez pour avoir le dernier mot …

Non, ça mérite bien le fameux duty call

Tout les flous que je connais peuvent être vus comme un opération de convolution (peut être qu'il en existe qui échappent à cette affirmation) entre une image non-floutée et un noyau de convolution appelée fonction d'étalement du point ou PSF, comme expliqué précédemment. Donc, si on connaît la PSF, on peut déconvoluer.

Dans ce contexte, la distinction entre un flou isotrope tel que celui appliqué sur l'image se révèle être une PSF différente, point final. Créer une PSF revient à prendre une réponse impulsionnelle et appliquer le filtre, puis normaliser par la moyenne des niveaux de gris …

Ce n'est pas bien dur à faire. Ensuite, on passe dans un algo de type déconvolution de Wiener, on choisi l'amplitude du bruit qui imposera une coupure fréquentielle à l'image et c'est fini. On n'est pas dans les experts à Miami là tout de même …

Au passage un flou de bougé est infiniment plus difficile à reconstruire qu'un simple flou gaussien isotrope avec un gros écart type … Donc, si ça marche pour le flou de bougé, ne parlons pas du flou appliqué ici.

Un peu confus non ? C'est final genre -->[] ou c'est à la ligne …

[^] # Re: Risque de déconvolution ?

Posté par freejeff . En réponse au journal Deface: flouter simplement et automatiquement les visages dans une vidéo. Évalué à 0.

Et bien, si :

c'est monter sur ses grands chevaux … Du coup, il n'est pas possible de signifier son agacement dans un échange ?

Ton exemple était faux, et ta tournure de phrase :

sous-entend explicitement qu'un enfant que 15 ans (4ième) n'aurait pas fait une telle erreur …

Il me semble l'avoir expliqué ton erreur de raisonnement de manière non condescendante et non agressive.

Ton post est inutilement désagréable, du coup si ce n'est pas de l'humour au dépend d'une personne qu'est-ce ?

Après, c'était peut être une réponse trop rapide. Tu considères que je te prête "un comportement et une volonté que tu démens", soit, mais du coup le sens de ton commentaire m'échappe totalement. Je t'ai juste signifié que ta blague m'avait agacé et que visiblement, tu n'avais pas compris la teneur de mon questionnement, mais sur ce point, c'est bien ma faute, que de ne pas avoir bien posé le problème.

La bienveillance des échange est bien souvent conditionnée par leurs antécédents. Il est clair que j'ai fait le choix de te signifier que tu m'avais agacé, tout en exprimant que ce n'était pas grave.

Du coup, je ne vois pas trop le problème.

Par contre, je n'ai pas mis d'intention, ta phrase semble être humoristique et tourne en dérision mon questionnement, sans que tu n'aies pris le temps de le comprendre. C'est une interprétation et pas un procès d'intention. Je ne cherche pas à savoir pourquoi tu as fait ça, je signifie mon agacement, sur l'interprétation de ton post.

par contre, l'impératif est une injonction, de plus sur un point que j'estime faux : prêter de mauvaise intentions, avec une fin de post en bref, pouvant être aisément interprété comme la manifestation d'une lassitude, permettant de couper court à une conversation désagréable.

Du coup, tu ne veux pas envenimer, tu ne tiens pas à débattre, ridiculise mon agacement (monter sur tes grands chevaux) mais tu formules des injonctions et coupes court à la discussion.

Dans l'absolue, je n'ai pas à t'expliquer comment avoir des échanges sains, mais en tout cas tes modalités pour échanger avec moi ne me conviennent pas du tout.

[^] # Re: Risque de déconvolution ?

Posté par freejeff . En réponse au journal Deface: flouter simplement et automatiquement les visages dans une vidéo. Évalué à 2.

Tout les arguments sont valides mais la conclusion est discutable. La vrai quesiton est celle de la réversibilité de la perte d’entropie de l'image. C'est justement le point des méthodes de déconvolution. Si il est clair qu'un calcul d'entropie avant et après donnera des résultats différents, il n'est pas si évident que l'opération inverse ne soit pas accessible dans une certaine mesure. Les questions sont est-ce que la quantification des niveaux de gris (codage sur 3*8bits ) entraîne une irreversilité et est-ce que la transformation en vidéo (probablement h26{4|5}) apporte une sécurité suffisante si quelqu'un s'amuse à essayer de reconstruire les visages.

[^] # Re: Risque de déconvolution ?

Posté par freejeff . En réponse au journal Deface: flouter simplement et automatiquement les visages dans une vidéo. Évalué à 1.

Le message répondait principalement à ça :

Il est bien indenté par rapport au poste de barmic, même si j'inclue des éléments de vos postes, donc pas de problème d'amalgames tout seul dans ma tête. En général sur ce forum, lorsque l'on répond à quelqu'un l'indentation permet de comprendre qui est destinataire direct.

Enfin pour être plus clair :

Évoquer de manière péremptoire que l'on est en dehors des lois de la physique, est assez désagréable, lorsque l'on ne cherche pas à comprendre les enjeux et les possibilités qu'il existe en analyse d'images, et c'est d'ailleurs sur ce sujet que Francesco vous répondait.

Ce n'est pas un problème pour moi de se tromper, mais ayant un on égo de chercheur de la génération Y, les positions d'autorités me rendent souvent agressif, encore plus dans cette période de police de la pensée liée à la Covid19.

Désolé, de vous avoir vexé.

[^] # Re: SVG ?

Posté par freejeff . En réponse à la dépêche YOGA Image Optimizer v1.1 : résultats des travaux de l'été. Évalué à 3.

Quand j'utilise la découpe laser, je pars souvent de PNG N&B et je dois les vectoriser. Je trouve que ce processus est assez marrant, mais pour l'instant les meilleurs outils sont ceux du web !

Après, c'est clairement un sujet trop éloigné de Yoga.

[^] # Re: Optimisation présentations et fichiers textes

Posté par freejeff . En réponse à la dépêche YOGA Image Optimizer v1.1 : résultats des travaux de l'été. Évalué à 2.

Merci, mais je l'avais trouvée !

C'est tout aussi vrai pour la GUI, non ?

Je trouve au contraire, que le fait que cela soit simple justifie que ça apparaisse dans la dépêche ! Après, c'est vous qui l'écrivez, donc c'est vous qui décidez !

Merci pour le soft, j'essayerais de voir ce que j'arrive à faire sur un document un de ces jours !

[^] # Re: Risque de déconvolution ?

Posté par freejeff . En réponse au journal Deface: flouter simplement et automatiquement les visages dans une vidéo. Évalué à 3.

Ce n'est pas vous mais barmic :

Ces petites blagues sur le dos des gens, sans chercher à comprendre, sont agaçantes, mais cela n'a rien de grave, juste un peu agaçant.

Confus. Il y a d'autres corrections dans l'analyse d'image astronomiques que la déconvolution, mais celle-ci en fait partie.

Non, de ce que j'ai lu (mais c'est pour moi un sujet marginal d'intérêt), la plupart des algos d'IA sur la déconvolution travaillent à chercher la PSF, en partant du principe que le flou de bouger se traduit par une "trajectoire" à identifier, car celle-ci peut se traduire par une PSF dédiée. Il s'agit donc de trouver le mouvement qui a eu lieu entre le moment où l'on a commencé à intégrer le flux rayonné, et le moment où on a arrêté. Trouver une trajectoire spatio-temporelle avec comme seul indice le résultat en terme de flou est un problème mal posé. Sur les problèmes mal posés, l'IA peut apportés beaucoup pour éviter les minimums locaux, et trouver le bon espace d'exploration à moindre coût.

Sur des images sans flou de bougé mais avec un flou, dont on ne peut pas avoir d'autre représentation des objets qu'avec la seule modalité floutée, alors, il y a sûrement du travail qui peut être fait en IA sur l'identification de la PSF.

Lorsque l'on peut aller lire le code de floutage, reconstruire la PSF, ne doit pas être bien difficile.

En bref, je suis d'accord avec les autres moules, le plus sûr est le carré noir. C'est une destruction certaine de l'information, nécessaire à la reconnaissance, pour le flou, il faudrait y passer un temps important pour trancher.

[^] # Re: Risque de déconvolution ?

Posté par freejeff . En réponse au journal Deface: flouter simplement et automatiquement les visages dans une vidéo. Évalué à 6.

Désolé, mais j'ai peut être été un peu rapide.

un flou n'est pas une moyenne et peut être représenté mathématiquement par une convolution. Une moyenne prend N valeur et en retourne 1, la convolution prend N valeurs et en retourne N via une relation avec son voisinage.

Il existe un pan de l'analyse d'image qui travaille à des stratégies de déconvolution, qui permettent de déflouter les images par exemple.

Il s'agit de trouver une fonction d'étalement du point (point spread function PSF) qui est en somme la représentation de la convolution et de l'appliquer à l'image par des méthodes telles que la déconvolution de Wiener.

Il en existe plein pour par exemple corriger des flous de bougé, lorsque l'on ne connaît pas la trajectoire, il faut la retrouver, cela s'appelle à déconvolution aveugle.

Lorsque l'on connaît la fonction de convolution il est assez simple de déconvoluer. Et comme c'est du LL, il est simple d'aller regarder le code du flou et de fabriquer un psf.

Après, c'est vrai que la déconvolution n'est jamais parfaite, pas (plus qu'une transformation géométrique inverse ne conservera parfaitement les niveaux de gris), le fait de sauver une image avec un format destructeur avec des niveaux quantifié sur 8 ou 10 bits, peut faire que la déconvolution crée des hautes fréquences parasites qui la rendront inopérante …

C'était sur ce point que je me posais des questions, mais il est vrai que je n'avais pas pris le temps de bien poser le problème.

Il existe aussi des algorithme de superrésolution sur des vidéos qui associés à la déconvolution pourraient régulariser le problème.

De manière générale, il est sain d'éviter de penser que la personne qui écrit quelque chose est une abrutie et de faire un raisonnement par l'absurde faux derrière, mais bon vous n'avez pas été le seul :

Il n'est pas question d'être identique, mais de pouvoir reconnaître un visage, cela fait une très grosse différence.

De plus sur un signal continu, il est assez simple d'inverser la convolution, le fait que le signal soit quantifié, et ensuite compressé destructivement, doit probablement réduire les chances de pouvoir recréer une image acceptable.

Il faudrait tester, on est souvent surpris, mais il est très probable que cette personne ait raison. Il n'est par contre absolument pas nécessaire d'utiliser de l'IA, lorsque l'on a la donnée de sortie et le modèle. On résout des problèmes mal posés depuis des siècles (merci Hadamard), appeler l'IA, dès que l'on n'a pas envie de réfléchir est un peu facile.

J'avais lu cette publi, il y a quelques années, mais il est vrai que le niveau de convolution ici, est bien plus élevé. Mais comme on n'a pas la PSF, celle identifiée est forcément moins précise qu'une que l'on peut reconstruire avec un algo.

Donc pas si trivial au final.

# Risque de déconvolution ?

Posté par freejeff . En réponse au journal Deface: flouter simplement et automatiquement les visages dans une vidéo. Évalué à 4.

Est-il assuré que l'on ne puisse pas dé-flouter les visages ?

Si l'algo est ouvert, alors trouver la meilleure déconvolution sur la séquence d'image semble possible, non ?

Un pédocriminel avait été arrêté, car il avait appliqué une déformation en spirale sur sa photo, et la police scientifique avait réussi à trouver la transformation inverse et reconstituer sa photo !

La c'est encore plus simple !!

Du coup, quelle est la sécurité associée à ce genre d'outils ?

Bon après je n'ai que très peu joué avec les outils de déconvolution, donc ce n'est peut être pas si simple !!

[^] # Re: Optimisation présentations et fichiers textes

Posté par freejeff . En réponse à la dépêche YOGA Image Optimizer v1.1 : résultats des travaux de l'été. Évalué à 3.

Tout à fait juste. C'est dommage que la dépêche soit si orientée interface graphique.

Peut être qu'illustrer les nouveautés avec des insertions de codes aurait été plus parlant !

Avez vous pensé à faire une galerie de type matplotlib, avec des exemples de codes et les résultats. Ça pourrait être assez simple à faire et rendre une image dans le navigateur est assez simple !

# Optimisation présentations et fichiers textes

Posté par freejeff . En réponse à la dépêche YOGA Image Optimizer v1.1 : résultats des travaux de l'été. Évalué à 2.

Salut,

un truc qui pourrait être super utile, serait de pouvoir prendre un fichier odf, le décompresser, récupérer les images et les réduire dans Yoga avant de les remplacer par celles optimisées et refaire l'archive !

Il y a un outil de redimensionnement dans libreoffice, mais il n'est pas forcément hyper intéressant, dans le sens ou son principal intérêt est de réduire la résolution de l'image par rapport à sa taille dans la présentation ou dans le fichier texte.

[^] # Re: Félicitations

Posté par freejeff . En réponse à la dépêche GIMP 2.10.24: version cartographe. Évalué à 4.

Salut Jehan,

Je me doute bien que le sujet est bien sensible et complexe.

De ce que j'ai vu, la plupart des gens qui arrivent à monétiser leurs travaux sont les influenceurs sur youtube. Le problème, c'est que cela demande de passer un temps énorme à faire ce travail. Il faut faire au moins une vidéo par semaine pour attirer durablement, et le temps d'arriver à créer une communauté se chiffre en années sur ce genre de sujets.

Mais des choses comme des timelaps de création sur ZeMarmot, des nouvelles fonctionnalités de gimps comme tu le fais ici, mais avec une vidéo et quelqu'un qui parle dessus, attirerais plus de monde.

Honnêtement, mon temps passé sur youtube n'est pas raisonnable et je ne peux pas aller ailleurs, car il n'y a juste pas le contenu que j'aime regarder, ou il faut aller sur trop de plateformes pour le trouver.

Youtube est une des meilleures plateforme pour inciter les gens à aller sur vos plateformes de financement.

Et pour être tout à fait clair, vous n'êtes pas X, Y. La démarche est fantastique, si vous aviez une chaîne youtube, je serais abonné directement sans me poser de question.

Après, il est clair que ça demande un taf de dingue, mais peut être qu'une personne qui aime le montage vidéo pourrait s'associer à vous.

Franchement, je suis désolé, si tu trouves que j'enfonce des portes ouvertes, mais quand je vois des gens comme Linus de LTT qui se font des millions, je trouve que c'est bien dommage que des gens comme vous n'arrivent pas à vivre de leur passion.

# Félicitations

Posté par freejeff . En réponse à la dépêche GIMP 2.10.24: version cartographe. Évalué à 10.

C'est vraiment chouette que votre collaboration à tout les deux ait donné autant d'amélioration pour tout les utilisateurs de GIMP.

Peut-être faudrait il faire un peu de pub, je sais bien que cela nécessite de passer par des plateformes de type youtube, mais quand on voit les donations à votre projet qui sont de 1256€/mois, au regard de l'ampleur du projet et de ce que ça rapport au collectif avec GIMP, peut être que mettre en avant cela en allant chez des influenceurs dans le domaine de la création graphique, vous permettrait de toucher un autre public.

1256€ à deux par mois, ce n'est vraiment pas grand chose, c'est être dans la précarité si vous vous y consacrez à 100% ou faire des jobs alimentaires. C'est un peu triste, car votre projet est vraiment chouette et vertueux. Peut être communiquer en anglais pour augmenter la base de donateurs ?

Il me semble que vous avez ciblé 8k€ pour pouvoir travailler sereinement, cela ne semble pas inaccessible, par exemple marcan semble avoir réussi à se faire un salaire normal pour travailler sur le portage de linux sur le macbook ARM. Il y a aussi Syama Pedersen qui a 7800 contributeurs avec un minimum à 2€/mois et un max à 22€/mois. Du coup, ne pensez vous pas qu'en essayant de créer une petite communauté autour d'une plateforme non-libre, vous pourriez vous autofinancer de manière pérenne ?

Je n'y connais rien, mais je trouve cela dommage que votre démarche ne touche que si peu de monde !

[^] # Re: Parallèle avec la politique

Posté par freejeff . En réponse au journal GNU t'es la ?. Évalué à 6.

Ou c'est peut être que la FSF ne sert plus à grand chose aujourd'hui. Ils n'ont pas su embrasser la culture libre et finalement n'ont pas de contributions majeures ces dernières années, du coup tout le monde se fou un peu de ce qu'ils peuvent bien dire. Avoir RMS est peut être pour eux, à la vue de leur inutilité, le seul moyen d'espérer avoir une influence. C'est assez affligeant à vrai dire.

[^] # Re: Salome-Meca, Code Aster vs COMSOL

Posté par freejeff . En réponse à la dépêche ParaView, une bibliothèque libre pour la visualisation scientifique. Évalué à 5.

Salut,

Elmer est une bonne solution mais si ce que tu veux faire n'est pas dedans, contrairement à COMSOL, tu auras du mal …

La solution OpenSource la plus proche de COMSOL est fenics. C'est une code FEM qui permet de résoudre des formulations variationnelles. Donc si tu es capable de formuler ton problème sous forme variationnelle affaiblie, et du coup compatible avec la FEM, tu pourras le résoudre avec fenics.

le coeur est en C++ mais tu peux accéder à la partie formulation variationnelle, choix des éléments, mise en données, lancement de la simulation et récupération des données en python.

Une tentative d'intégration avec FreeCAD a été lancée, elle permet d'exporter au format de mise en données de fenics les groupes de noeuds et d'éléments nécessaires à la simulation.

Il existe aussi sfepy qui permet de faire des choses assez avancées il faut voir si ton problème peut se formuler simplement avec.

Après tu peux aussi faire du couplage faible avec Salome et des codes dédiés, mais ne connaissant pas la physique du plasma, je ne sais pas trop si il y a des outils disponibles.

En ce qui concerne OpenFOAM, ce n'est pas des éléments finis, mais des volumes finis, Une discrétisation par la méthode des volumes finis (MVF) est basée sur une forme intégrale de l'EDP à résoudre (par exemple, la conservation de la masse, de la quantité de mouvement ou de l'énergie). L'EDP est écrite sous une forme qui peut être résolue pour un volume fini (ou cellule) donné. Le domaine de calcul est discrétisé en volumes finis, puis les équations de base sont résolues pour chaque volume. Le système d'équations résultant implique généralement des flux de la variable conservée, et donc le calcul des flux est très important dans le MVF, alors que la discrétisation par la méthode des éléments finis (FEM) est basée sur une représentation par morceaux de la solution en termes de fonctions de base spécifiées. Le domaine de calcul est divisé en domaines plus petits (éléments finis) et la solution dans chaque élément est construite à partir des fonctions de base. Les équations réelles qui sont résolues sont généralement obtenues en reformulant l'équation de conservation sous une forme faible : les variables de champ sont écrites en termes de fonctions de base, l'équation est multipliée par des fonctions de test appropriées, puis intégrée sur un élément. La solution FEM étant formulée en termes de fonctions de base spécifiques, on en sait beaucoup plus sur la solution que pour MVF.

Il faut donc vraiment évaluer ce que tu veux récupérer comme infos sur ton problème avant de savoir si tu vas pouvoir basculer sur la MVF.

[^] # Re: Beaux documents

Posté par freejeff . En réponse au journal C'est foutu pour LibreOffice. Évalué à 10.

En fait Zenitram et toi vous parlez de deux choses différentes.

Zenitram dit que si les options par défaut sont mauvaises les gens considéreront que le logiciel n'est pas au niveau de la concurrence sans faire le moindre effort. Là ou il trolle un peu, c'est qu'il dit qu'ils ont raison. Personnellement, je ne juge pas le bien ou le mal, je constate, que quand je dis que je trouve LO super, les gens ouvrent grands les yeux et quand j'explique pourquoi, les gens soufflent et disent, c'est pas pour moi trop compliqué. On parle de BAC+8, mais les sujets attenants à mon choix les indiffèrent !

Donc ces personnes là, sont inaccessibles, et c'est selon moi le pb principal de LO, d'être un MSO à la ramasse dans la tête des gens in-intéressés au LL.

C'est cette masse qui fait basculer et permet d'avoir de l'argent pour des développeurs. C'est un produit end-user, pas comme le noyau, ou une lib pour analyser des codecs ! Ça doit plaire au end-user point.

MSO l'a compris et investi beaucoup dans ces aspects et du coup fidélise sa clientèle qui est prête à payer, et de ce fait nous empêche d'échanger avec eux quand on est sur Linux.

Honnêtement, vu le temps que cela me fait perdre, si il y avait une version native à jour sur Linux, je pense que je l’achèterais non pas pour un usage quotidien, mais pour juste avoir la paix dans les échanges …

Tu représentes une experte qui apporte énormément et met tout à disposition des autres, et je te remercie beaucoup pour ça, mais un dirait un utilisateur de Vim fasse à un utilisateur de Visual Studio Code !

Ils ne s'entendront jamais !

[^] # Re: Beaux documents

Posté par freejeff . En réponse au journal C'est foutu pour LibreOffice. Évalué à 9.

Salut Ysabeau.

Tu as tout à fait raison ! On peut faire de magnifiques choses avec LO, si il y a un léger avantage sur la justification des paragraphes et des tableaux plus élégants (mais très chiant à faire), qui font un style sympa (fait par d'autres, hein), le style par défaut de LaTeX est beau. Celui de LibreOffice est ideux. Je suis désolé mais ce n'est pas normal de devoir être un pro pour faire un document élégant. C'est bien dommage que tes modèles ne soient pas par défaut dans LibreOffice, et c'est bien dommage qu'ils ne fassent pas un effort pour avoir un document élégant par défaut.

Il ne faut pas se mentir, le principal avantage de LO est de faire comme MSO en libre, mais du coup toutes les mises en pages sous impress sont ratée, non pas par un manque de compatibilité, mais par le fait qu'il y a des tas de polices non-libres dans MSO. Il serait tellement simple d'analyser les polices présentes dans un document et de proposer de les installer, soit sur le système, soit dans le document si nécessaire … Alors oui, si le document embarquait les polices alors il serait plus lourd (quelques centaines de ko …), mais à l'époque ou des gens sont d'accord pour tout mettre en conteneurs dockers, cela me semble vraiment stupide comme objection. La taille d'une image haute résilution est certainement supérieure à la taille de toutes les polices présentes dans MSO.

C'est donc bien le pb, on voit bien que leur objectif n'est pas de capter un public, sinon ces améliorations triviales auraient été faites depuis bine longtemps.

Si les développeurs s'éclatent et que des gens comme toi ou moi arrivons à faire des documents de qualité, c'est déjà pas mal, mai ça ne changera pas le rapport de domination de MSO sur LO.

OO tente de faire changer ce rapport de domination, et les gens trouvent que ce n'est pas si mal.

Personnellement, les animations, les vidéos, marchent tellement mal depuis MSO que je n'ai jamais trouvé cela utile.

Et j'ai tellement de polices moisies sur mon laptop, que je n'ai pas trop de pb de compatibilité !

Donc oui, tu as raison LO est un formidable logiciel, et ils ont raisons LO ne fait pas assez pour faciliter la migration, alors que c'est quasiment sa raison d'être.

Et ne pas venir me dire, c'est libre tu n'as qu'à le faire. Perso, je suis assez expert pour qu'il fasse ce que je veux, donc non, je ne passerais pas de mon temps pour changer ça.

[^] # Re: Jitsi ne suffit malheureusement pas tout le temps

Posté par freejeff . En réponse au journal Comment et quoi répondre aux invitations Zoom et Microsoft Team → vs Jitsi Meet. Évalué à 3.

Tout à fait.

Au CNRS on fait rendez-vous.renater.fr, qui nous permet de faire tourner jitsi. Même avec ça, on s'en sortait pas, même quand le serveur n'était pas chargé. Donc, ce n'est vraiment si simple, de plus la possibilité de rejoindre l'audio par téléphone n'était pas activée …

Le problème est que l'on ne peut pas être de tout les combats, et comme je ne suis pas dans la confidence des gens des SI des écoles d'ing ou fac, c'est un peu dur de pouvoir avoir un quelconque moyen autre que des plateformes extérieures. Il y a sûrement un travail à faire.