Sehr geehrter Journal,

L'œil humain contient une multitude de récepteurs appelés des cônes et des bâtonnets qui transforment un signal lumineux en un signal nerveux, qui sera analysé par le cerveau.

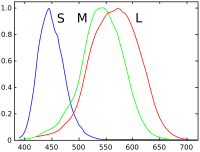

Il y a trois types de cônes (S,M,L) qui ont chacun une réponse différente en fonction de la longueur d'onde:

La perception des couleurs provient du fait que ces cônes récepteurs sont excités différemment.

Un mélange de lumière verte et de rouge va exciter les récepteurs exactement de la même manière qu'un rayon monochromatique de longueur d'onde correspondant à du jaune. Ce qui fait que ces couleurs sont indifférenciable pour l'humain bien qu'étant techniquement différentes couleurs

Essayons de trouver quelle intensité on doit donner aux différents sous-pixels d'un écran (dont les longueurs d'ondes sont β, γ et ρ) pour simuler la couleur d'un rayon monochromatique de longueur d'onde λ:

Il suffit trouver r,g et b tels que :

L(λ) = b L(β) + g L(γ) + r L(ρ)

M(λ) = b M(β) + g M(γ) + r M(ρ)

S(λ) = b S(β) + g S(γ) + r S(ρ).

Si β, γ et ρ ont été bien choisis, il devrait être possible de représenter toutes les couleurs et combinaisons de couleurs (en supposant que notre modèle est correct).

Mais serait-il possible de rendre de meilleures couleurs si nos écrans avaient 4 couleurs par pixels? Il faudrait bien sûr que les photos qu'on y affiche soient également prises avec des capteurs de 4 couleurs.

(Mais les constructeurs préfèrent faire des écrans avec seulement deux couleurs par pixels.)

Fait intéressant: Tout le monde connaît des daltoniens, mais il existe une autre « maladie » génétique qui affecte le chromosome X. Plus de 1% des femmes seraient touchées. Elles auraient un quatrième type de cônes qui leur permettrait de voir plus de couleurs.

Il y a des couleurs qui n'existent pas car elle correspondent a une combinaison

d'excitation des cônes et des bâtonnets qui ne peux pas être produite avec de la lumière normale. (Par exemple : exciter les cônes verts sans les cônes rouges.)

Il est toutefois possible d'arriver à ces excitations par des moyens chimiques. On peux aussi changer la perception au niveau du cerveau. Il est ainsi possible assez facilement de percevoir des couleurs non-imaginable en temps normal.

Attention cependant : cela est illégal car vous avez décidé de l'interdire via vos gouvernement démocratiques. (Dit geldt niet als je uit Nederland mij leest)

Le cerveau humain est composé d'environs 10¹³ neurones. Chacun d'eux peut être relié à jusqu'à 100 de ces voisins à l'aide de connexions synaptiques. Pour représenter tout ça, il faudrait une capacité de stockage d'au moins 10 Pio. Il serait alors possible d'émuler le cerveau un peu comme une machine virtuelle.

Les neurones fonctionnent à environ 200 Hz. Pour émuler un cerveau en temps réel, il faudrait donc une puissance de calcul d'au moins 10 Pflops.

Bonne nouvelle ! Cette puissance a été atteinte comme il a été annoncé dans le dernier Top500. Ce sera donc à portée de tous dans quelques années.

Le but de projets comme http://www.brainpreservation.org/ ou Blue_Brain est de rechercher comment tout cela est possible. Et il y a déjà pas mal de progrès.

Nous aurons donc bientôt des ordinateurs capables de tout ce que l'humain est

capable. Including feelings, love, and consciousness (whatever that means).

Mais entre nous, vouloir émuler sur du hardware électronique l'architecture du cerveau qui est prévue pour « hardware » bio-chimique, ça me semble une mauvaise idée. C'est un peu comme si on construisait des avions avec des plumes imitant le mouvement des ailes des oiseaux. Je pense qu'on peux faire bien mieux en s'y prenant différemment.

Dans tous les cas, des ordinateurs dont les capacités dépassent celle de l'homme arrivent bientôt. À ce moment, il n'y aura plus besoin de développeurs car les ordinateurs seront capables de se programmer tout seul.

Il est donc urgent de commencer à faire du lobby pour instaurer une taxe sur tout matériel informatique capable de se programmer lui-même. Cette taxe sera reversée au personnes ayant un diplôme reconnu dans la profession informatique. (Mais surtout ne pas mentionner le fait que les politiciens, eux aussi, seront inutiles)

# hum

Posté par fabien . Évalué à 4.

C'est tres interressant… enfin, jusqu'a ce tu parles en neerlandais.

A ce demander si cette langue n'a pas un effet bizard sur le cerveau (biologique pourtant), car aprés ça, même de retour en français, c'est moins bien quand même…

[^] # Re: hum

Posté par vladislav askiparek . Évalué à 5.

Tu n'aimes pas le néerlandais (ni l'allemand, parce qu'il y en a aussi), mais à priori, tu n'aimes pas non plus le français.

> tres -> très

> jusqu'a -> jusqu'à

> jusqu'a ce tu parles.. -> jusqu'à ce que tu parles..

> neerlandais -> néerlandais

> A -> À

> bizard -> bizarre

> aprés -> après

De rien.

[^] # Re: hum

Posté par j_m . Évalué à 8.

Tiens! maintenant que l'Allemand devient un peu à la mode, ne serait il pas temps de changer le bon vieux (et démodé) "Da Linux French Page" par "Die Linux französische Seite" ?

[^] # Re: hum

Posté par paladar . Évalué à 2.

On pourrait de temps en temps tourner : DLFP, DPLeF, DLFS etc…

[^] # Re: hum

Posté par Julien_J06 . Évalué à 2.

Moi j'ai préféré après…

Julien_c'est_bien (y'a pas que Seb)

[^] # Re: hum

Posté par case42 (site web personnel) . Évalué à -2.

Dingue comme la xénophobie vient s'insinuer partout de nos jours…

[^] # Re: hum

Posté par fabien . Évalué à 2.

Ceux qui n'ont pas d'humour, peuvent-y voir ce qu'ils veulent… même de la xénophobie malheureusement…

# Vidéo en rapport chez TED

Posté par Enzo Bricolo 🛠⚙🛠 . Évalué à 4.

http://www.ted.com/talks/henry_markram_supercomputing_the_brain_s_secrets.html

…

"des ordinateurs dont les capacités dépassent celle de l'homme arrivent bientôt"

pas sur, on en reparle dans 10 ans

Enzo

[^] # Re: Vidéo en rapport chez TED

Posté par bubar🦥 . Évalué à 3.

Les ordinateurs c'est bien jolis, mais sans base de données à la hauteur… 10 ans, tu es gentil :)

[^] # Re: Vidéo en rapport chez TED

Posté par Aujourd'hui . Évalué à 2.

Quand on simule une architecture avec une autre, on ne simule pas en détail chacun des transistor présent dans la machine que l'on veux simuler. On se contente de ré-interpreter le jeu d'instruction.

Le truc c'est qu'on ne connais encore pas le « jeu d'instructions » du cerveau (s'il existe un concept similaire). C'est pour ça qu'on recherche des modèle plus simple de fonctionnement. (La couche d'abstraction au dessus des neurones)

Par exemple, on croit savoir quelles sont les zones du cerveau responsable de la mémoire et on cherche à comprendre comment elle fonctionne.

On remarque aussi que la disposition de certains neurones responsables de la vision forment un agencement qui ressemble à celui d'un calcul de convolution (Procédé mathématique beaucoup utilisé en traitement des images)

[^] # Re: Vidéo en rapport chez TED

Posté par Badeu . Évalué à 2.

En es-tu bien sûr ?

Dans le monde numérique, la simulation se passe (du plus haut vers le plus bas) au niveau comportemental, au niveau RTL, au niveau porte et … au niveau transistor ! bigre !

Maintenant, tu confonds peut être avec l'émulation ou la virtualisation, mais ça n'a rien à voir.

[^] # Re: Vidéo en rapport chez TED

Posté par Aujourd'hui . Évalué à 1.

Oui, je voulais dire émulation.

# The Embodied Mind

Posté par drakmaniso . Évalué à 10.

Ça fait de nombreuses années maintenant que certains chercheurs en sciences cognitives ont montré qu'on ne peut pas réduire l'esprit au seul cerveau: il faut considérer le corps dans son entier (voire même son environnement). Je pense notamment à Francisco_Varela et Antonio_Damasio.

Ces mêmes chercheurs ont aussi montré que l'esprit ne fonctionne pas comme un ordinateur: la séquence perception / traitement de l'information / action n'est qu'une grossière approximation, prenant source en grande partie dans notre culture cartésienne.

(Au cas où ça intéresserait certains, Varela a écrit un petit livre d'introduction assez clair, "L'invitation aux sciences cognitives".)

Bref, on peut entasser les pétaflops autant qu'on veux, on est toujours aussi loin de la naissance d'un ordinateur «dont les capacités dépassent celle de l'homme». Ce qui n'empêche pas la recherche en IA d'être passionnante (au contraire: il n'y a rien de plus décevant qu'un domaine scientifique où tout a été découvert…).

[^] # Re: The Embodied Mind

Posté par Aujourd'hui . Évalué à 3.

En fait, il est vrai que le système nerveux s'étend à plus que le cerveau. Il y a aussi beaucoup de neurones dans la moelle épinière, et il faut aussi prendre en compte toutes les terminaisons nerveuse. Mais la plus grosse partie reste dans le cerveau, donc ça ne change pas grand chose aux ordres de grandeurs.

Où tu pensais à encore d'autre éléments qui interviendrais ?

[^] # Re: The Embodied Mind

Posté par ZeroHeure . Évalué à 4.

Ce n'est pas qu'une question de système nerveux ou de quantité de neurones. Comme il l'a écrit il faut considérer le corps dans son entier (voire même son environnement). Autrement dit, il faut considérer le cerveau dans son fonctionnement et son interaction avec le reste du corps et l'environnement. Vu que l'ordi est loin d'imiter l'un comme l'autre, on est tranquille un bout de temps encore.

"La liberté est à l'homme ce que les ailes sont à l'oiseau" Jean-Pierre Rosnay

[^] # Re: The Embodied Mind

Posté par Aujourd'hui . Évalué à 3.

Si tu parles du lent processus d'apprentissage, qui prends des années pour permettre à l'enfant de devenir adulte, et qui inclus effectivement de nombreuse interactions avec l'environnement extérieur, alors, je suis d'accord. Cela va être compliqué de simuler tout ça. (En plus ça implique plein de processus chimique dans le corps, avec les hormones et ce genre de choses)

Mais il est peut être possible de zapper le processus d'apprentissage en générant des cerveaux déjà mature ?

[^] # Re: The Embodied Mind

Posté par paladar . Évalué à 3.

Ne fut-ce que pour apprendre à parler, tu as généralement besoin de voir, directement ou par procuration, de parler pour répéter, de sentir etc… Donc avant qu'un ordi soit pourvu de sens et d'une mémoire, je vois mal comment tu arriverais à le faire «comprendre». Dire qu'un ordi est capable de répondre à une phrase où il y a fleur parce qu'il sait reconnaître le son n'est pas dire qu'un ordi peut comprendre ce que, concrètement, c'est qu'une fleur.

[^] # Re: The Embodied Mind

Posté par Nicolas Boulay (site web personnel) . Évalué à 2.

Ce que tu décrit est le processus d'apprentissage qui peut se réduire à des essais erreurs d'expériences ou d’interaction avec l'extérieur.

Si un ordinateur n'a pas de bras, il lui reste facilement la vision, le son et internet pour faire ces expériences.

Il est d'ailleurs fascinant de voir à quel point, un smartphone est truffé de capteur absent des ordinateurs (accéléromètre/gyroscope, GPS, webcam, micro, haut parleur, …).

"La première sécurité est la liberté"

[^] # Re: The Embodied Mind

Posté par navaati . Évalué à 2.

Pas de chocolat.

[^] # Re: The Embodied Mind

Posté par drakmaniso . Évalué à 1.

Justement, l'erreur, c'est de ne se préoccuper que du cerveau. Or, s'il est évidemment central pour la cognition, il a été à maintes reprise montré qu'il n'est pas suffisant. On ne peut pas avoir de cognition sans corps.

Pour reprendre une terminologie informatique, le corps n'est pas une interface entre le cerveau et l'extérieur. C'est de l'ensemble "cerveau plus corps plongé dans le monde" qu'émerge la pensée, et le corps y participe activement.

Un ordinateur reçoit des données, traite cette information, puis fournit un résultat; même si on imagine un parallélisme massif, au niveau atomique on retrouvera toujours le même processus. À l'inverse un être humain ne s'arrête jamais de percevoir, agir ou penser: tout cela se déroule en même temps, et s'influence mutuellement, continuellement.

J'ai trouvé un court extrait de L'invitation aux sciences cognitives de Varela (c'est un PDF), c'est sans doute plus clair que mes tentatives d'explications.

[^] # Re: The Embodied Mind

Posté par Nicolas Boulay (site web personnel) . Évalué à 1.

Cette redéfinition

continuelle de ce qu’il convient de faire ne

ressemble en rien à un programme qui serait

stocké dans un répertoire d’alternatives potentielles,

mais dépend crucialement de la contingence,

de l’improvisation et de la flexibilité.

Le texte commence mal. Il dit simplement que la vie n'est pas homothétique à un automate. Mais l'ensemble des programmes possibles ne sont pas tous des automates, un programme peut gérer des données qui peut complexifier sont états interne.

« De même qu’il n’y a pas de représentation

centrale, il n’y a pas de système central. Chaque

niveau d’activité relie directement la perception

et l’action. C’est seulement l’observateur

de la créature qui infère une représentation

centrale ou un contrôle central. La créature elle-

même en est dénuée : seule intervient une

série de comportements concurrents. C’est du

chaos local de leurs interactions qu’émergent,

aux yeux de l’observateur, des comportements

cohérents. »

idem, un programme peut aussi être une composition. cf la programmation par agent ou les systèmes distribués.

Il apparaissait plutôt que le cerveau

fonctionne à partir d’interconnexions

massives, sur un schéma distribué, de sorte

que la configuration des liens entre ensembles

de neurones puisse se modifier au fil de

l’expérience. Ces ensembles témoignent d’une

aptitude à l’auto-organisation qui ne trouve

aucune représentation en logique.

Cette affirmation n'a pas de sens non plus. Dans le cas du réseau de neurone simulé, l'information, la mémoire est contenu dans les poids de chaque synapse et n'est pas localisé ou localisable.

_

Mais grâce à la nature configurationnelle

du système, une coopération globale

en émerge spontanément lorsque les états

de chaque « neurone » en cause atteignent

un stade satisfaisant. Un tel système ne requiert

donc pas d’unité centrale de traitement

pour contrôler son fonctionnement._

Il y a des tas de systèmes numériques qui n'ont pas réellement de système central : cf les avions, les voitures, les trains,…

Le vrais défi posé par cette approche est sa

mise en cause du préjugé le plus enfoui de

notre tradition scientifique, à savoir que le

monde tel que nous le percevons est indépendant

de celui qui le perçoit.

C'est pourtant la base de l'incertitude d’Heisenberg, qui est connu depuis un moment ! On peut aussi ajouter à ça l'effet placebo, les études en double aveugle, etc…

"La première sécurité est la liberté"

[^] # Re: The Embodied Mind

Posté par drakmaniso . Évalué à 1.

Quelle que soit la complexité d'un programme, il y aura toujours une machine de Turing équivalente. Un ordinateur ne peux y échapper, par construction. Donc si, ce qu'il dit a du sens: même si une machine peut simuler une part d'improvisation et de flexibilité, cela ne reste qu'une simulation, basée sur un mécanisme où toute improvisation est exclue.

Oui, la notion d'émergence est commune avec les système à agents (d'ailleurs il cite Brooks dans le texte, qui a beaucoup travaillé en robotique sur ce thème). Mais Varela montre que cette notion n'est pas suffisante, parce qu'elle requiert toujours l’existence d'un "sens" indépendant du monde.

Encore une fois, tu confonds simulation et caractéristique intrinsèque. Le problème d'une auto-organisation simulée, c'est qu'il y a toujours une limite à cette capacité. Alors que l'auto-organisation du vivant ne s'arrête même pas à l'individu, elle enveloppe le monde dans son entier, et de façon continue.

Le fait qu'il y ai plusieurs éléments centraux ne change rien au problème.

Il n'y a qu'à voir la difficulté qu'on a eu à intégrer les incertitudes d'Heisenberg pour comprendre que ce n'est pas dans notre tradition. Quand aux effets placebo et double aveugle, ce sont des mécanisme psychologiques, ce qui est précisément le sujet…

Après, ce texte n'est qu'un court extrait d'un ouvrage de vulgarisation, si tu veux étudier l'approche de Varela c'est "L'inscription corporelle de l'esprit" qu'il faut lire (The Embodied Mind).

[^] # Re: The Embodied Mind

Posté par Nicolas Boulay (site web personnel) . Évalué à 2.

Quelle que soit la complexité d'un programme, il y aura toujours une machine de Turing équivalente. Un ordinateur ne peux y échapper, par construction. Donc si, ce qu'il dit a du sens: même si une machine peut simuler une part d'improvisation et de flexibilité, cela ne reste qu'une simulation, basée sur un mécanisme où toute improvisation est exclue.

Ce que tu veux dire est complètement dénué de sens. En gros, tu es en train dire un truc du genre : les programmes sont limité, donc un compilateur C ne pourrait pas compiler tout programme. Tu oublis complètement que dans la machine de turing, celle-ci peut écrire sur le ruban et surtout le ruban est infinie.

Sinon, définies-moi "improvisation".

Mais Varela montre que cette notion n'est pas suffisante, parce qu'elle requiert toujours l’existence d'un "sens" indépendant du monde.

C'est complètement faux et idiot. Le recuit simulé, les algo génétiques, les 'marching ants' sont des principes génériques pour résoudre un problème sans avoir aucune idée de comment y arrivé. Seul compte la manière d'évaluer le résultat, ce qui est bien plus facile de faire des essais-erreurs dans le monde réel, que de le simuler sur une machine.

Le problème d'une auto-organisation simulée, c'est qu'il y a toujours une limite à cette capacité. Alors que l'auto-organisation du vivant ne s'arrête même pas à l'individu, elle enveloppe le monde dans son entier, et de façon continue.

Désolé mais ça aussi, c'est complètement bidon. La matière pour faire les neurones est aussi limité. Si la simulation de neurone est trop complexe, on pourra toujours simuler au niveau atomique. Ce n'est qu'un problème de taille de problème, pas de nature. On parlait de intelligence (humaine) .

Le continu qui renvoi à l'analogique et à cette idée d'infinie, est absurde. Le bruit de l'environnement limite la quantité d'information transmissible (bruit thermique, bruit quantique, bruit électromagnétique, …). La quantité d'information stoqué l'est sur de la matière qui n'est pas infini non plus.

Le fait qu'il y ai plusieurs éléments centraux ne change rien au problème.

Ce n'est pas bien de changer le sens des mots. Dans ce cas, je peux affirmer que chaque neurone est un élement central. C'est aussi absurde que de dire que le contrôleur d'abs de la voiture est central. Si la quantité entre jeux, ce n'est donc encore une fois pas une histoire de nature mais de complexité.

Après, ce texte n'est qu'un court extrait d'un ouvrage de vulgarisation, si tu veux étudier l'approche de Varela c'est "L'inscription corporelle de l'esprit" qu'il faut lire (The Embodied Mind).

J'ai surtout l'impression que l'auteur ne veut absolument pas que le vivant soit simulable, qu'il soit d'une nature différente quitte à tordre un peu les faits. On dirait un croyant que l'éventualité de la "simulation de l'âme" met en trans. En plus, je n'aime pas son style, on dirait du

Bogdanov."La première sécurité est la liberté"

[^] # Re: The Embodied Mind

Posté par drakmaniso . Évalué à 2.

Sauf que justement, le cerveau n'est pas un élément isolé. Il fait partie intégrale du corps, et le corps fait partie intégrale du monde. Ils ont évolués, émergés ensemble, et se construisent mutuellement ("co-construisent") en permanence. Ce ne sera jamais le cas d'un ordinateur (au sens équivalent à une machine de Turing), quelque soit les mécanismes de feedback et d'auto-programmation qu'on y ajoute; précisément parce que ce sont des ajouts et non pas une caractéristique intrinsèque.

Tu es libre de ne pas avoir envie de lire Varela. Mais ce n'est pas la peine qu'on continue à argumenter dans le vide, dans ce cas: je suis totalement incapable de résumer correctement ses travaux dans un commentaire sur dlfp…

[^] # Re: The Embodied Mind

Posté par Nicolas Boulay (site web personnel) . Évalué à 2.

Sauf que justement, le cerveau n'est pas un élément isolé. Il fait partie intégrale du corps, et le corps fait partie intégrale du monde. Ils ont évolués, émergés ensemble, et se construisent mutuellement ("co-construisent") en permanence. Ce ne sera jamais le cas d'un ordinateur (au sens équivalent à une machine de Turing), quelque soit les mécanismes de feedback et d'auto-programmation qu'on y ajoute; précisément parce que ce sont des ajouts et non pas une caractéristique intrinsèque.

J'ai envie de te dire et alors ? J'ai fait pas mal de robotique amateur, et il devient évident que pour apprendre, il vaut mieux un contact avec le monde. Je suis 100% d'accord sur ce point. Mais ce n'est pas inaccessible à un ordinateur !

Au pire, on aurait un robot humanoïde. Les "ajouts" font partis du choix de départ, c'est l'équivalent du code, de l'ADN qui code aussi les bras et les yeux d'un humain. Qu'est-ce qui empêche de fournir à un ordinateur des moyens de communication et d'agir sur le monde réel ?

"La première sécurité est la liberté"

[^] # Re: The Embodied Mind

Posté par drakmaniso . Évalué à 0. Dernière modification le 05 mars 2012 à 22:13.

Ce n'est absolument pas de ça dont il s'agit. La cognition d'un être humain est construite par le même mouvement qui produit aussi le monde, le corps.

Ce n'est pas une "connexion" entre le cerveau et l'extérieur, c'est le fait que les distinctions esprit/corps, et corps/monde, sont des abstractions construites par l'homme, certes utiles mais qui n'ont aucune existence dans l'absolu.

À l'inverse, pour un ordinateur que l'on interface au monde, il y aura toujours cette distinction, par construction. La position de Varela (entre autre), c'est que cette différence est fondamentale.

Encore une fois, des chercheurs autrement plus qualifiés que moi ont eu besoin de multiples articles et livres pour développer leur position; mon intention ici n'était que de signaler l'existence de ces travaux, absolument pas d'en faire un exposé inattaquable (je n'en suis pas capable).

Sur ce, bonne soirée.

[^] # Re: The Embodied Mind

Posté par Nicolas Boulay (site web personnel) . Évalué à 4.

Ce n'est pas une "connexion" entre le cerveau et l'extérieur, c'est le fait que les distinctions esprit/corps, et corps/monde, sont des abstractions construites par l'homme, certes utiles mais qui n'ont aucune existence dans l'absolu.

C'est plus de la science mais de la métaphysique :)

Je vois ce que tu veux dire, mais je pense que la différence qui existe au niveau physique, peut s'exprimer au niveau logiciel (sauf calcul quantique, et encore).

"La première sécurité est la liberté"

[^] # Re: The Embodied Mind

Posté par drakmaniso . Évalué à 1.

Ce n'est pas une "science dure" comme les maths ou la biologie, mais ça n'en reste pas moins une science. On travaille différemment en sciences humaines, cela peut sembler moins rigoureux au premier abord, mais l'objectivité et la répétabilité y sont tout aussi importantes.

[^] # Re: The Embodied Mind

Posté par brendel . Évalué à 1. Dernière modification le 06 mars 2012 à 17:28.

Ça ressemble plus a un avis personnel qu'à un résultat scientifique. J'ai bien compris que Varela était sûrement très intelligent, et a eu une carrière intéréssant. On imagine donc qu'il a écrit des articles intéréssants en neuroscience et en biologie. Cependant Wikipedia précise aussi que "Il a fait partie du Mind and Life Institute, qui facilite les rencontres entre la science et le bouddhisme".

Du coup on comprend mieux pourquoi il parle de métaphysique dans ses livres. Livres qui, rappelons le, rapporte uniquement ce que l'auteur en tant qu'humain veut faire passer. Moi ce que j'aimerai bien voir comme références c'est les articles de recherche qui présente ces résultats. En particulier les expériences répétables qui permettent de l'affirmer. En gros ce qui m'intéresse c'est uniquement la partie scientifique de son discours, corroboré par des fait. Le reste, c'est uniquement ce qu'il pense (et croit) et qui peut être très différent de la réalité.

Je dis pas qu'il a tort, juste que tu affirmes comme vrai avec force des choses qui semblent bien difficiles à prouver. Et comme dit plus haut on dirait furieusement que ça vient d'une volonté que l'intelligence humaine ne soit pas simulable. Je serai intéressé de savoir précisément ce que dit le bouddhisme sur le rapport au monde des humain. M'est avis qu'on doit y trouver des similitudes.

[^] # Re: The Embodied Mind

Posté par drakmaniso . Évalué à 2.

Ce n'est pas un avis personnel. Comme dit plus haut, on travaille différemment en sciences humaines, et notamment la notion de preuve y est très différente.

Si je conseillais plus haut le livre "The Embodied Mind", c'est justement parce qu'il contient énormément de références; nombre d'articles aussi bien que d'expériences (répétables, donc) sont cités.

Enfin, la discussion s'est centrée sur Varela, mais il n'est pas le seul à déconstruire la vision cartésienne de l'esprit. J'ai cité aussi Damasio, pour les autres noms ma mémoire me fait défaut (cela fait des années que je ne travaille plus dans ce domaine).

[^] # Re: The Embodied Mind

Posté par Aujourd'hui . Évalué à 1.

Et tu penses qu'il n'y a pas de machine de turing équivalente à un esprit humain ?

(Note que l'article que tu donne en lien ne montre rien du tout. Il énonce des hypothèses mais ne montre rien.)

# Notes

Posté par neil . Évalué à 10.

J'avoue avoir du mal à suivre ce journal.

Mais en vrac :

La perception des couleurs est beaucoup plus complexe qu'une vue restrictive sur les cônes. La couleur est en quelque sorte perdue dans la rétine, et reconstruite dans le cortex visuel. Il y a tout un tas d'illusions qui permettent de le montrer. Par exemple, si on met la même couleur dans la même partie du champ visuel, pour deux stimuli différents, la perception peut être complètement différente, par exemple à cause du contexte spatial (ce qui est autour de la couleur), ou temporel (les couleurs qu'il y a eu avant). Cet aspet dynamique et contextuel du traitement visuel est fondamental dans le cerveau.

Il existe déjà tout un tas d'autres représentations des couleurs, Espace colorimétrique.

Le projet Blue Brain est un projet scientifique, le mettre dans le même sac que Brain préservation qui est une forme de cryogénie (avec les appels à donner votre mémoire me semble un peu tiré par les cheveux. Pour d'autres projets, qui ne visent à comprendre qu'une infime partie de la complexité du cerveau humain, on peut citer les projets européens FACETS (terminé récemment), BrainScaleS (en cours), Human Brain Project (futur), ou le projet américain SyNAPSE [1,2].

De façon plus générale, les projets qui visent à comprendre comment tout cela est possible sont. juste de la poudre aux yeux. Heureusement personne n'y croit. Ça viendra en son temps (pas avant de nombreuses décennies)

Les neurones sont connectés à bien plus d'autres neurones qu'une centaine ! On estime qu'ils sont en général connectés à entre 1000 et 10000 neurones. Mais les connexions à chaques neurones sont formées de d'un grand nombre de boutons synaptiques. Pour une modélisation détaillée il faut aussi prendre en compte la répartition spatiales de ces connexions, ainsi que leur « poids » (un terme qui regroupe tout un tas de facteurs). Là encore, l'aspect dynamique est très important, les connexions se forment, et évoluent en permanence.

HAHAHA

Les neurones sont des cellules avec tout un tas de mécanismes moléculaires, électriques, génétiques, et autres, qui contribuent au calculs neuronaux. Chacun possède sa propre dynamique, plus rapide (électrique) ou plus lente (génétique, gliale).

Ouais enfin on peut utiliser toute la puissance nécessaire, si on ne sait pas ce qu'on fait, comme Izhikevich en 2005 par exemple, ça ne sert pas à grand chose. Le gars a soit-disant simulé un cerveau entier et il a juste observé des oscillation. Youpi !

J'aime ton humilité sur la deuxième partie.

Sur le fond, c'est toutes les branches de la modélisation que tu sembles ignorer, on simule bien le déplacement des planètes sur des ordinateurs, et il n'y a pas besoin d'avoir des ordinateurs à gravités ou qui soient sous vide interplanétaires.

On ne connait pratiquement rien du cerveau humain, on est donc extrêmement loin de pouvoir arriver à n'en reproduire ne serait-ce qu'une infime partie. Mais les neurosciences (qui n'ont qu'un très lointain rapport avec l'intelligence artificielle), sont un domaine passionnant qui combine des talents dans tous les domaines (biochimie, génétique, optique, physique, informatique, psychologie, etc, etc). Sans une véritable approche multi-domaine, avec une variété de façon de penser radicalement opposées, il sera impossible d'arriver à comprendre le cerveau humain. Tout le monde peut y contribuer.

[^] # Re: Notes

Posté par Aujourd'hui . Évalué à 1.

Oui bien sûr, ceci est une simplification. Ceux qui veulent une explication détaillée peuvent aller lire Wikipedia. Je présente juste une courte introduction. Désolé si c'était pas clair.

Pareil pour les chiffre de mon journal, ils sont juste des approximations sensé représenter des ordres de grandeurs. Juste pour montrer que on arrive a cette puissance de calcul.

Ça dépends ce qu'on cherche à faire. Si ce qu'on recherche c'est de simuler exactement un humain, alors oui, la simulation des neurones est sans doute la manière de procéder.

Mais ce que je voulais dire c'est que si on cherche juste a produire un intelligence suprême, alors je pense qu'il doit exister de meilleur moyens d'arriver au résultat.

Mais ne t'en fait pas, je n'ai pas encore quitté mon travail. Je sais qu'il faudra encore attendre quelque (dizaines d') années. Mais je veux juste attirer l'attention sur le fait que ça pourrait venir plus vite qu'on y pense. Et là… qui sait ce qui se passera (voir aussi: Singularité_technologique )

[^] # Re: Notes

Posté par Badeu . Évalué à 10.

C'est quand même un peu ringard cette idée de vouloir persévérer à comparer le cerveau à une machine et de parler en capacité de stockage et puissance de calcul pour celui-ci !

D'un côté on a un ensemble de transistors faisant deux opérations super simples, que l'on parallèlise à mort pour créer une foultitude d'instructions appartenant à un ensemble fini, qui ne peuvent fonctionner qu'en cadençant la propagation de l'état des uns vers les autres à l'aide d'un signal d'horloge et en aucun cas fonctionner sans. Et, grosso modo on bosse avec quelques états électriques à l'intérieur et rien de plus. Donc finalement quelque chose de très fini, de très figés.

Et on cherche à comparer ça avec une structure biologique, auto adaptive, fonctionnant sur une infinité de stimuli analogiques, à aucun moment échantillonés ou réduites à un ensemble discret, capable de sélectionner ses stimulis à la volée, d'apprendre à en reconnaitre, les amplifier, en créer de nouveaux, se reconfigurer à la volée … Bref quelque chose dont les possibilités sont limitées par la combinaison de ses milliers facteurs. Je pense sans me tromper qu'on peut dire que la capacité de calcul, de stockage, d'un cerveau tend plus vers l'infini qu'autre chose.

Ce journal déstructuré mérite un beau label 100% bullshit.

[^] # Re: Notes

Posté par Aujourd'hui . Évalué à -1.

Parce que tu trouve que les transistors c'est super simples ?

Leurs réponse à haute fréquence n'est pas si simple que ça.

En ce qui concerne le « auto adaptive », c'est un peu comme les compilateurs JIT qui optimisent le code au besoin.

Et pour l'apprentissage, il y a aussi des algorithmes qui apprennent. Un bon example est la reconnaissence faciale.

Pour le « à aucun moment échantillonés » ce n'est pas vrai, le cerveau aussi échantillone.

Donc oui, je pense que ça vaux la peine d'essayer de comparer « la puissance de calcul » d'un cerveaux et celle de nos machine. Ça nous permet de relativisé et de se rendre compte de leur complexité relative.

Et tu te trompe, les capacité de calcul et de stockage du cerveau ne tendent pas vers l'infini.

[^] # Re: Notes

Posté par Badeu . Évalué à 3. Dernière modification le 05 mars 2012 à 01:05.

un transistor tu le sélectionnes pour faire son boulot de transistor dans un circuit numérique, tu n'attends qu'une chose : qu'il atteigne son niveau haut ou bas en fonction de son type et pas d'un comportement non déterminé. Les contraintes physiques dans certains domaines d'utilisations ne sont peut être pas simples, mais tu n'en attendras rien d'autre que son boulot de transistor.

L'auto adaptivité n'a rien à voir avec les compilos JIT qui appliquent des transformations à la volée au code selon des patterns bien établi comme le fond les compilos depuis des années. Il n'est pas intelligent, il n'applique qu'un algorithme bien défini. Pour les algorithmes qui apprennent, ils restent à des années lumières de la notion d'apprentissage qui qualifie le comportement d'un être vivant, et largement aidé par les informations que l'on soumet au départ. Ton exemple de la reconnaissance faciale par exemple, par défaut recherchera toujours au moins un motif nez bouche yeux, etc, basé sur l'information que l'on lui aura soumis au départ. Elle va pas se mettre du jour au lendemain à dire "oh! tiens ceci est un visage ! oh! tiens ceci est un vase" elle va extrapoler des critères prédéfinis de définition d'un visage selon un jeu d'algorithmes qui aura été implémenté mais ne vas pas apprendre et améliorer sa façon de faire. Ce n'est qu'un programme.

Pour l'échantillonnage, je persiste et signe que c'est une notion à la con dans le cas du cerveau qui est quelque chose qui fonctionne de manière continu et complètement analogique. Si tu es persuadé que ton cerveau fonctionne avec des 0 et des 1, génial, mais dans la réalité chaque information qui le traverse ne se transforme qu'en un mélange de stimulis électriques et chimiques.

[^] # Re: Notes

Posté par Nicolas Boulay (site web personnel) . Évalué à 5.

Tu es entrain de passé d'un excès à l'autre, en ignorant toutes les maths autour de la modélisation ou de l’échantillonnage.

C'est pas parce que c'est analogique que les subtilités sont infinies à cause "du bruit". Ou alors tu fais parti de ceux qui croit que les vinyles ont plus de subtilité qu'un CD pour faire de la HIFI.

Il n'est pas intelligent, il n'applique qu'un algorithme bien défini.

Un neurone n'est pas non plus intelligent. Il ne fait qu'appliquer les processus chimique codés dans l'ADN. Cela n'est pas une différence de nature avec un ordinateur, mais une différence de complexité.

Elle va pas se mettre du jour au lendemain à dire "oh! tiens ceci est un visage ! oh! tiens ceci est un vase" elle va extrapoler des critères prédéfinis de définition d'un visage selon un jeu d'algorithmes qui aura été implémenté mais ne vas pas apprendre et améliorer sa façon de faire. Ce n'est qu'un programme.

Tout cela ne veut rien dire du tout. Un programme peut apprendre : cf les filtres antispam a filtre bayésien. On peut aussi cité Watson qui gère une énorme base de donné qui pourrait s'enrichir avec l'analyse d'internet.

"La première sécurité est la liberté"

[^] # Re: Notes

Posté par Badeu . Évalué à 1.

Certes et je savais qu'on me le reprocherai.

oui mais est-ce que l'élément de base de l'ordinateur, le transistor, va évoluer dans le temps pour faire émerger un nouveau comportement ? la brique élémentaire du cerveau à quand même une multitude de capacité d'adaptation (dégradation, accoutumance, etc. je ne m'aventurerai pas au delà sur un sujet que je ne maitrise pas) et ça, même si on l'émule dans le cadre d'un programme, ce sera finalement selon des critères assez déterminés à la base et bien plus réduits qu'un neurone ne le fera dans la nature.

Concernant ton exemple avec les programmes qui apprennent, on reste cependant sur des choses assez spécifiques qui au delà de leurs champs d'action, ne feront rien. Bien que les filtres antispams "apprennent" ou que les démonstrations de Watson soient impressionnantes. Quand je dis n'apprennent pas, je ne dis pas n'améliorent pas la précision et/ou la pertinence de leurs résultats, mais voient émerger de nouveaux comportements inatendus mais pourtant pertinents et leur permettant d'accomplir leur tâche d'une nouvelle façon.

j'avoue /o\ (tout en étant conscient que c'est faux)

[^] # Re: Notes

Posté par Nicolas Boulay (site web personnel) . Évalué à 1.

_et ça, même si on l'émule dans le cadre d'un programme, ce sera finalement selon des critères assez déterminés à la base et bien plus réduits qu'un neurone ne le fera dans la nature. _

Non pas du tout. Pourquoi être limité ? En quoi, il est non possible de simuler le processus qui amène les neurones à se développer avec les stimulu extérieurs ? L'important est d'avoir assez de RAM.

Quand je dis n'apprennent pas, je ne dis pas n'améliorent pas la précision et/ou la pertinence de leurs résultats, mais voient émerger de nouveaux comportements inatendus mais pourtant pertinents et leur permettant d'accomplir leur tâche d'une nouvelle façon.

As-tu vu l'apprentissage de la marche par des robots qui fonctionnent par essais erreurs ? C'est le principe de tout les systèmes d'optimisation génériques, il n'y a aucune piste de départ, juste une façon d'évaluer la pertinence d'une solution (qui dépend donc du problème).

Et que dire des systèmes de calcul "bourrin", comme le min-max qui peut donner à notre niveau d'humain, une impression de niveau stratégique dingue à une IA d'échec.

D'ailleurs, c'est amusant de voir que chaque fois que la machine bas l'humain, on dit que ce n'est plus une histoire d'intelligence : d'abord le calcul, ensuite le jeu d'échec, aujourd'hui, on dit que le go reste inaccessible, et la reconnaissance d'objet de même (jusqu'à ce que Watson le fasse dans quelques années).

"La première sécurité est la liberté"

[^] # Re: Notes

Posté par neil . Évalué à 3. Dernière modification le 06 mars 2012 à 00:36.

C'est un argument fallacieux. On pourrait de même se demander, si « l'élément de base du cerveau, l'atome, va évoluer dans le temps pour faire émerger un nouveau comportement ».

Et pour ce qui est de l'Émergence, c'est un phénomène très largement étudié, et qui se retrouve tout à fait dans des simulations informatiques (et qui est étudié depuis des décennies !).

Les argumentaires du type « les ordinateurs ils peuvent pas », sont une complète ineptie, qui ne montrent que les limites de l'imagination de leurs auteurs. De temps en temps on entend ainsi dire que « les ordinateurs ne peuvent pas représenter les nombres irrationnels » (les systèmes de calcul formel ont tout faux !), ou que tout ce qui contient de l'aléatoire ne peut pas être simulé (non, les méthodes de Monte-Carlo n'existent pas !).

D'ailleurs le bruit c'est rigolo, c'est une propriété fondamentale du système nerveux (et pas que des humains). Ça permet de faire tout un tas de choses, comme améliorer le signal, ce qui est plutôt contre-intuitif, par exemple par des effets de résonance stochastique. Et, oui, on peut faire la même chose dans un ordinateur (omfg!).

[^] # Re: Notes

Posté par CHP . Évalué à 4.

En tout cas, pas le miens !

[^] # Re: Notes

Posté par briaeros007 . Évalué à 1.

Alors je ne suias pas du tout d'accord.

Là tu compare le contenu du contenant.

Un neurone n'est pas forcément "autoadaptatif". Certains neurone peuvent faire varier ses connexions il est vrai, mais pas forcément (et heureusement, tu aurais l'air fin si un des axones allant dans la jambe décide d'un coup de gérer la main…)

Et il n'accepte pas du tout une infinité de stimuli analogique, mais accepte certains signaux bio-électrique (plus précisément des fréquences au niveau micro et des amplitudes au niveau macro) avec des effets de seuils.

[^] # Re: Notes

Posté par neil . Évalué à 1. Dernière modification le 06 mars 2012 à 18:02.

En fait si. Il y a dans tous les neurones différentes plasticités. Par exemple dans la rétine, la réponse va varier en fonction du contraste, par exemple pour pouvoir gérer une scène avec

différentes luminosités, pareil pour d'autres sytème, comme le système haptique. En plus de ce type d'adaptation on trouve aussi de la fatigue neurale (un neurone va répondre moins fort s'il est trop stimulé).

Encore faux. Dans le cerveau il y a des aires qui contrôlent par exemple la vision, ou la motricité. Mais si une zone est inutilisé, par exemple chez les aveugles ou les gens qui le deviennent, les aires de la vision vont s'occuper d'autres choses, l'ouïe par exemple. De même, si tu rajoutes des capacités motrices (un bras artificiel contrôlé par des électrodes implantées dans le cortex, ou par imagerie), des nouveaux circuits apparraissent. Et donc oui, tes neurones qui contrôlaient ta main peuvent d'un coup gérer un autre membre !

Là encore c'est faux. Si tu regardes, par exemple, la réponse d'une neurone du cortex visuel primaire au contraste (mais ça marche pour toutes les aires sensorielles sur d'autres facteurs), tu observes une fonction de la fréquence de décharge par rapport au contraste (et tu peux retrouver le contraste en observant l'activité). Et le contraste étant une quantité continue, il a une infinité de valeurs.

[^] # Re: Notes

Posté par Nicolas Boulay (site web personnel) . Évalué à 3.

Et le contraste étant une quantité continue, il a une infinité de valeurs.

Encore une personne qui croit que le vinyle est meilleur en HIFI que le CD car c'est analogique…

Le rapport signal sur bruit et ce que cela implique sur la quantité d'information transmissible, cela te parle ?

"La première sécurité est la liberté"

[^] # Re: Notes

Posté par briaeros007 . Évalué à 3.

Le mot clé c'est pas "autoadaptatif" mais "forcément".

Et j'utilisais "auto-adaptatif" dans le sens "vas tout seul créer de nouvelles cx avec ses voisins etc…", pas "est un système biologique vivant et de par là même peut avoir des différences de comportement suivants les états n-1 mais qui ne dépendent pas du contexte de l'état n".

Rien de faux, on a jamais vu un axone allant dans la jambe aller controler la main, même après que la jambe soit sectionnée.

Que certains neurones puissent le faire je ne l'ai jamais nié, mais que tous le fassent, et constamment, ça c'est faux.

Bref à argumenter à coté on vas pas se comprendre.

Oulà non : les neurones qui donnaient un ordre aux neurons qui contrôlait la main peuvent réussir à donner des ordres à des neurones qui contrôle un autre membre.

Mais le neurones de la moelle épinière qui controlait la main, tu lui coupe son axone, il va juste plus rien contrôler du tout.

Et non. Je te renvoie à shannon et toute la théorie du signal. Ce n'est pas parce que c'est "analogique" que le nombre de valeurs sont illimitées.

# Légère erreur de calcul

Posté par Kaane . Évalué à 5. Dernière modification le 04 mars 2012 à 20:35.

Pour représenter tout ça, il faudrait une capacité de stockage d'au moins 10 Pio. Il serait alors possible d'émuler le cerveau un peu comme une machine virtuelle.

Supposons qu'on veuille juste couvrir tous les états possible d'un cerveau simplifié.

Par exemple un cerveau 15x15 (15 neurones tous interconnectés)

On prend trois états naturels pour les neurones (en forme, normal, fatigué)

On prend cinq neurotransmetteurs au niveau du neurone (symboliquement : angoisse, panique, plaisir, concentration, calme)

On met trois récepteurs à la surface de chaque neurone

On prend quatre états pour chaque axone (normal 100%, inhibé 50%, bloqué 0%, favorisé 150%)

On a donc un total de 3x53x4x15 états différent possible pour chaque neurone. Soit 22500.

Donc au final pour un réseau de 15 neurones simplistes : 2250015 possibilités. Soit au final 1,9175x1065 possibilités.

Il faut 2+7+2x15 = 39 bits minimum pour stocker de façon un peu utilisable l'état d'un neurone. Donc 39x15 bits pour stocker l'état de tous les neurones soit au final 1,9175x1065 x3915 octets pour stocker tous les différents états possibles.

Je vous laisse le soin de faire le calcul vous même pour 1013 neurones avec plus de 25 neurotransmetteurs et pas loin de 200 niveaux de transmissions analogiques possibles par axone. Ensuite il faudra prendre en compte le fait que la glia (qui a longtemps été considérée comme juste une gelée de soutien des neurones qui de temps en temps fait le ménage) joue un rôle dans la transmission et la stimulation des neurones (notamment des neurones miroirs) et un taux d'interconnexion pouvant dépasser 250 000 sur certains neurones du cortex préfrontal.

En plus s'ajoute à cela une différence fondamentale majeure : l'ordinateur est une machine à calculer, le cerveau est une machine à reconnaitre.

Bref la simulation de cerveau humain est quasiment impossible avec les techniques actuelles (j'entends par techniques actuelles puces électroniques avec des transistors dedans).

Attention cela ne veut en aucun cas dire que l'on ne pourra pas créer des formes de vie auto-conscientes avec des systèmes basés sur transistor, ni même que ces formes de vie ne pourrons pas se faire passer pour humaine. Mais fondamentalement elles n'auront jamais un comportement intrinsèque comparable au cerveau humain.

Ça me rappelle une scène du neuromancien de Gibson. Grosso-modo un des hackers essaye d'expliquer la différence entre une super IA et un humain et qui expliquait que lui était humain mais par exemple qu'il n'écrivait pas de poêmes, alors que si ca se trouve l'IA elle écrivait des poêmes mais pour autant n'était pas humaine.

Après la notion d'horizon informatique (que les anglais appellent "the singularity"), à savoir le moment ou un ordinateur devient capable de concevoir tout seul un ordinateur plus performant que lui même dans au moins un domaine, se rapproche clairement à grande vitesse. On devrait pouvoir l'atteindre d'ici 10 à 25 ans. Cependant il y a deux blocages majeurs :

a) Le prix des matières premières et la crise font que les budgets R&D se réduisent comme peau de chagrin sur les projets théoriques, ce qui risque de retarder pas mal les évolutions des processeurs (le rythme a déjà bien baissé récemment avec la démocratisation du multi-coeur)

b) On arrive aux limites de l'architecture transistor, à savoir que bientôt on ne pourra plus miniaturiser plus ce produit. En effet si on commence à rentrer dans des situations ou le nombre d'atomes en regard est trop petit pour que la loi des grands nombres s'applique, on est pas beau. (Explication : si on a 2 000 000 d'électron qui ont chacun 99 999 chances sur 100 000 de bouger si on les soumets à une tension électrique tout va bien, par contre si on en a 500 et sur une machine qui commute à 3Ghz…)

[^] # Re: Légère erreur de calcul

Posté par Aujourd'hui . Évalué à 3.

Il me semble que c'est toi qui fais des erreurs de calculs.

Je ne sais pas exactement comment tu fais tes comptes, mais

1,9175x1065 possibilités par neurones, (ce qui me semble beaucoup, je comprends pas bien ton calcul) ça ce code juste en 28 octets. c'est pas grand chose

Considérant N neurones, et considérant que tout les neurones sont inter-connectés (ce qui est loin d'être le cas), il doit être possible de stocker le tout dans un espace de taille de l'ordre de O(N²) octets.

Et toi tu me sort quelque chose de l'ordre de O(2N²)

C'est pas vraiment pareil.

Soit N le nombre de neurones, et C le nombre de connections moyen par neurone, il est possible de stocker le tout dans un espace de O(log(N)*N*C)

(Il suffit pour chaque connections (C*N) de stocker l'adresse des neurones concernés (2*log(N)), (plus quelques octets pour l'état))

[^] # Re: Légère erreur de calcul

Posté par Kaane . Évalué à 4.

1,9175x1065 possibilités par neurones, ça ce code juste en 28 octets. c'est pas grand chose

Il y a 22500 possibilités par neurones, soit 1,9175x1065 états différents pour l'ensemble du réseau.

(ce qui me semble beaucoup, je comprends pas bien ton calcul)

Ca tu peux remercier le markup lfr qui n'a pas l'air d'aimer qu'il y ait plusieurs puissances sur la même ligne. on va utiliser le e à l'avenir pour les puissances de 10 (oui c'est moche). Donc 1056 équivaut à e56. Et en plus étant fatigué j'ai un poil merdé à certains endroits. (Genre j'ai oublié qu'une synapse n'est pas forcément en train de transmettre, qu'un récepteur n'est pas forcément occupé etc.)

Le truc c'est que la liste des états n'a aucun intérêt pour une machine virtuelle, ce qui lui faut c'est la capacité à évaluer à partir de l'état N plus les commandes éventuellement passées, quel sera l'état N+1.

Et c'est là que se trouve l'erreur. Car si normalement l'espace mémoire ne sert que très peu en informatique classique, l'état du cerveau influence en quasi intégralité les états suivants.

On va dire que le monde extérieur (ici le dev) peut influer sur l'ensemble des paramètres neuronaux (état de fatigue, neurotransmetteur, inhibition) ce qui est le cas dans la vraie vie. De plus on va prendre la captation/libération des récepteurs comme étant une fonction aléatoire dépendante de la concentration relative de chaque neurotransmetteur.

La machine doit donc posséder pour chaque neurone à un instant T

- son état complet

- la concentration des différents neurotransmetteurs

- les changements induits par l'extérieur pour l'état suivant.

On refait les calculs :

3 états de fatigue (3 possibilités)

3 récepteurs qui peuvent accueillir chacun 1 des 5 neurotransmetteurs ou aucun (6x6x6 possibilités)

15 synapses connectés au neurone qui peuvent être chacune dans 4 états de stimulation différents et être en train de soumettre un message ou non. (15x4x2 possiblités)

Ca qui fait 3x6x6x6x15x4x2 possibilités soit 77 760 possibilités par neurone.

Donc au total pour l'ensemble du réseau 77 776015 possibilités soit 2,298e73. (En considérant que chaque neurone peut avoir un état indépendamment de l'état des autres neurones)

Chaque possibilité pour un neurone peut être stocké sur 17 bits. Raisonnablement en attribuant des bits séparés pour chaque segment de l'état on arrive à

2 bits pour la fatigue +

8 bits pour l'occupation des récepteurs +

7 bits pour l’état des synapses.

Il faut donc consacrer 17 bits à un état soit 255 bits pour l'ensemble du réseau.

Après il faut ajouter quelques bits pour la concentration des différents neurotransmetteurs ( au choix suivant la précision voulue) on va dire 24 bits (4 bits de précision pour la concentration d'un neurotransmetteur)

Maintenant la machine virtuelle doit être capable de déterminer en fonction de l'état N un état N+1 en prenant en compte tous les paramètres y compris l'influence extérieure. En force brute, en partant d'un système déterministe (1 etat -> 1 etat et un seul) il y a 2,298e73 possibilités pour le réseau de neurones, 2,298e73 possibilités d'interactions extérieurs (influence sur tous les paramètres) et 224 concentration en neurotransmetteurs différentes. Soit au final 2,298e73 états x (2,298e73 changements x 224 concentrations différentes en neurotrans) soit 8,860e153 cases de 279 bits chacune. Soit 3,090e155 octets de stockage pour avoir toutes les possibilités de changement possible.

Alors bien sur aucune machine virtuelle ne va s'amuser à stocker dans un coin toutes les transitions d'états, on s'attend à ce qu'elle puisse les calculer à partir des informations données. Néanmoins l'information primordiale à retenir et que l'ensemble des paramètres peut influer sur un nombre absolument délirant de neurones qui à leur tour vont influer etc.

Dans le cerveau toutes les infos sont à la fois données (stockage mémoire), message (signal) et vecteurs (registre).

En prenant un calcul pour des valeurs génériques, mais dans la vraie vie avec 1011 neurones ayant chacun en moyenne 104 connexions plusieurs centaines de récepteurs pour les neurotransmetteurs, environ 25 neurotransmetteurs connus (et plusieurs centaines de poisons qui passent la barrière hémato-encéphalique) et des centaines de paliers d'émission par synapse (avec inhibition ou non). on arrive rapidement à des nombres absolument gigantesques quand il s'agit d'évaluer le nombre d'états différents d'un neurone.

Par exemple il existe plusieurs neurotransmetteurs qui favorisent ou inhibent la transmission de certains autres neurotransmetteurs depuis la synapse jusqu'au neurone dans certaines conditions mais pas dans d'autres.

Par exemple le GABA inhibe le glutamate SAUF si il y a aussi de l'adrénaline SAUF si les cathécolamines sont déjà saturés SAUF si il y a défaut de sérotonine SAUF sur un cerveau "jeune" ou encore en développement. En donnant des paliers d'influence et de rétro-influence des différents neurotransmetteurs sur seulement une synapse et l'influence d'un seul neurotransmetteur sur un autre neurone on arrive déjà à des centaines de possibilités, si ce n'est des milliers. Donc déjà rien que sur le GABA on arrive à 1000S possibilités (avec S le nombre de synapses susceptibles de produire du GABA).

Sans compter qu'un neurotransmetteur peut se balader un peu (via la glia) et finir par se fixer sur un neurone autre que celui qui était visé par la synapse. Là on arrive à des millions de possibilités, pour un neurotransmetteur, pour une synapse.

Si un neurone a 1000 synapses susceptibles de produire du GABA on a déjà plusieurs centaines de milliards de milliards de cas possibles dans les interactions synapses - récepteurs. (Calcul : Par exemple 1000 synapses ayant chacun 1 000 000 de possibilités ca fait 1000000103 soit 10600 possibilités, près de 2000 bits pour un neurone pour un neurotransmetteur)

Après si tu prends tous les neurotransmetteurs et tours les neurones en sachant qu'à chaque ajout le nombre de possibilités croit de façon exponentielle ça devient délirant.

C'est très difficile à calculer "pour de vrai" compte tenu du nombre de paramètres qui sont encore inconnus au niveau du cerveau (le rôle de la glia dans la transmission des info c'est assez neuf par exemple). Mais même en sortant les poisons de l'équation (drogues, alcools, métaux lourds etc.) l'état du cerveau à un instant T est quasiment impossible à sauvegarder. C'est pour cela que j’étais parti sur un exemple simple.

[^] # Re: Légère erreur de calcul

Posté par Aujourd'hui . Évalué à 0.

2000 bits, soit juste 250 octets. on multiplie par 25 neurotransmetteurs et 1011 neurones

6*1014 octets, on a encore quelques ordre de grandeurs de marge pour arrivé aux 10 PétaOctets que j'annonce dans le journal.

(Un ordinateur x86-64 avec 16 registres de 64 bits et 16 registres de 128 bits peut être dans 216*64 + 16*128 états différents c'est quasiment 10925 (rien qu'en comptant les registres, pas la mémoire ou les flags) et ça peux facilement être emulé.)

Là où je veux en venir avec mes approximation, c'est que bien que énorme (un péta octet, c'est énorme), ça arrive dans l'ordre de grandeur de quelque chose de possible dans peu de temps.

Par ailleurs, je précise aussi que utiliser du brute force pour simuler chaque neurone est une approche très naïve. On comprends de mieux en mieux le fonctionnement de chaque partie de cerveaux, on arrivera sans doute bientôt à les modéliser avec des modèles bien plus simples.

[^] # Re: Légère erreur de calcul

Posté par Kaane . Évalué à 1.

2000 bits, soit juste 250 octets. on multiplie par 25 neurotransmetteurs et 1011 neurones

Sauf que les neurotransmetteurs interagissent les uns sur les autres. Pas tous, pas tout le temps certes, mais suffisamment pour que ce soit un problème. Donc soit on recalcule l'état final du neurone à chaque itération, soit on stocke les différentes interactions

Si on décide de stocker les interactions entre neurotransmetteurs, on a plus affaire à des multiplications mais à des puissances.

Si on décide de refaire les calculs, on un système en O(n²) par neurone avec n le nombre de neurotransmetteurs émis et reçus par le neurone. (avec un n a 25 max c'est lourd mais jouable)

Toujours pareil au niveau des interactions entre neurones. Soit on stocke les interactions soit on recalcule. Et toujours pareil avec une complexité en O(N²) avec N le nombre de neurones interconnectés dans le réseau. Comme les neurones peuvent interagir sur les neurotransmetteurs (et même quasiment que comme çà) on a au final une complexité de O(N²n²). Ouille.

Car en plus il ne faut pas prendre en compte les neurones un par un, mais tous en même temps vu qu'ils interagissent quasi instantanément les un sur les autres (par quasi instantanément j'entends le fait qu'un message d'un neurone A à un neurone B peut être inhibé par un neurone C avant même que le signal ne soit interprétable par le neurone A)

En plus bis les récepteurs d'un neurone sont stimulés ou inhibés par l'activation d'autres récepteurs voisins. On est donc obligé d'avoir l'état complet du cerveau (ou en tout cas du réseau de neurones concerné) à l'instant T pour pouvoir calculer l'état d'un neurone à l'instant T+1

Si on décide de stocker :

Tous les neurones ne peuvent pas émettre et recevoir l'ensemble des neurotransmetteurs, si c'était le cas on aurait

(10600 )25 possibilité par neurones. Donc 10600x25 = 1015000 soit (103 )5000 donc environ (210 )5000 donc 50 000 bits par neurone. Et encore une fois à la puissance 1011 pour le cerveau tout entier. le Pio est loin derrière.

Par ailleurs, je précise aussi que utiliser du brute force pour simuler chaque neurone est une approche très naïve. On comprends de mieux en mieux le fonctionnement de chaque partie de cerveaux, on arrivera sans doute bientôt à les modéliser avec des modèles bien plus simples.

Qu'on comprenne de mieux en mieux soit, mais on est encore loin du compte, et déjà avec ce que l'on sait la modélisation est loin d'être possible même sur des réseaux de quelques millions de neurones. Le coté analogique qui oblige à prendre en compte chaque paramètre en fonction de tous les autres (comme par exemple en climatologie) amène des problèmes d'une complexité démentielle que l'on choisisse une approche calculatoire ou une approche stockage de données.

[^] # Re: Légère erreur de calcul

Posté par Aujourd'hui . Évalué à 0.

Je ne comprends pas pourquoi tu veux faire puissance 1011, et pas *1011?

50000 bits/neurones = 50000 *1011 bits/cerveau = 568 Tio/cerveau

[^] # Re: Légère erreur de calcul

Posté par Kaane . Évalué à 2.

Je ne comprends pas pourquoi tu veux faire puissance 1011, et pas *1011?

Parce qu’il faut soit stocker l'influence des neurones les un sur les autres, soit la réévaluer constamment avec un calcul d'une complexité démentielle. Dans 5000 bits tu ne stockes "que" l'état du neurone et les interactions des 25 neurotransmetteurs au niveau des synapses de ce neurone. Il te faut également stocker (ou calculer) les interactions des 25 neurotransmetteurs sur chacune des synapses qui sont connectés à ce neurone en provenance d'axones d'autres neurones. Certes un neurone ne peux jamais produire 25 neurotransmetteurs ni être connecté à tous les autres ce qui fausse l'ordre de grandeur du facteur puissance, mais on sort très vite de ce qui est calculable ou stockable. En plus il y a des problèmes de vitesse de transmission (un message qui va de A à B puis à C peut aller plus vite qu'un message qui va directement de A à C) en fonction des inhibitions et des amplifications de tel ou tel message. Le cerveau humain n'est pas un automate complexe avec des états qui se propagent de façon ordonnées.

De plus il y a des boucles dans tous les sens, dans un réseau de neurones, si un neurone influe très fréquemment sur un autre, une connexion finira par être créée entre les deux.

C'est pour cela que considérer l'état d'un neurone indépendamment de l'état du reste du cerveau n'a pas vraiment de sens.

[^] # Re: Légère erreur de calcul

Posté par Nicolas Boulay (site web personnel) . Évalué à 3.

En plus il y a des problèmes de vitesse de transmission (un message qui va de A à B puis à C peut aller plus vite qu'un message qui va directement de A à C) en fonction des inhibitions et des amplifications de tel ou tel message.

Comment crois-tu que les simulateurs type VHDL/Verilog fonctionnent ? C'est comme tout, il y a juste un pas de temps qui peut être supérieur à la transmission la plus rapide, il n'y a rien d'extraordinaire à calculer.

Le cerveau humain n'est pas un automate complexe avec des états qui se propagent de façon ordonnées.

Un cpu voir pire un GPU, non plus. Cela n’empêche pas d'être simulable.

"La première sécurité est la liberté"

[^] # Re: Légère erreur de calcul

Posté par Kaane . Évalué à 2.

Comment crois-tu que les simulateurs type VHDL/Verilog fonctionnent ? C'est comme tout, il y a juste un pas de temps qui peut être supérieur à la transmission la plus rapide, il n'y a rien d'extraordinaire à calculer.

Il n'y a pas de transmission plus rapide dans un réseau de neurones. Un message de A à C passant par B donc A -> B -> C peut aller plus vite qu'un message A -> B. (Non non il n'y a pas d'erreur le chemin par trois points va plus vite que le chemin à deux.) Et ceci pour le même message (stimulation noradrénaline par exemple).

En message du neurone A vers le neurone B peut être reçu en premier par le neurone Z etc.

En plus il n'y a pas de notion d'horloge donc les messages sont en constante circulation, ça peut s’échantillonner raisonnablement mais au niveau simulation c'est pas gagné.

Un cpu voir pire un GPU, non plus. Cela n’empêche pas d'être simulable.

GNI ? Informatique analogique non déterministe ? Je t'assure que toute puce est un automate à état (et même un automate fini). Et que dans une puce, une propagation désordonnée c'est soit un bug silicium soit un court circuit et ça n'est pas franchement souhaitable.

[^] # Re: Légère erreur de calcul

Posté par Nicolas Boulay (site web personnel) . Évalué à 2.

"Un message de A à C passant par B donc A -> B -> C peut aller plus vite qu'un message A -> B."

Et alors ? En quoi n'est-ce pas simulable ? Ce n'est pas pour rien que je parle de VHDL, c'est possible d'écrire se genre de comportement dans ce langage… Il existe même des variantes continus à base de flux et de potentiel. (VHDL-AMS)

En plus il n'y a pas de notion d'horloge donc les messages sont en constante circulation, ça peut s’échantillonner raisonnablement mais au niveau simulation c'est pas gagné.

L’horloge s'est un peu surfait (l'asynchrone est la mode pour avaler facilement les délais de transmission). VHDL n'est pas synchrone de base, les horloges sont explicites. C'est pas gagné, mais c'est fait tous les jours.

GNI ? Informatique analogique non déterministe ? Je t'assure que toute puce est un automate à état (et même un automate fini).

Je ne voix pas ou tu veux en venir, un neurone représente aussi une quantité de matière fini. Il n'y rien d'infini dans le monde réel (sauf l'espace), même en biologie.

Et que dans une puce, une propagation désordonnée c'est soit un bug silicium soit un court circuit et ça n'est pas franchement souhaitable.

Je pensais aux dialogues asynchrones entre machine d'état indépendante. Mais on peut aussi rajouter les indéterminismes que l'on peut avoir sur les "network on chip" qui sont asynchrones pour des raisons de performance.

On peut facilement mettre des méga octets dans un puce numérique (hors RAM), tu as conscience de ce que cela représente en nombre d'état codable ? 2223 pour 8 Mo. Je ne parle que de technologie d'aujourd'hui.

"La première sécurité est la liberté"

[^] # Re: Légère erreur de calcul

Posté par Kaane . Évalué à 1.

Et alors ? En quoi n'est-ce pas simulable ? Ce n'est pas pour rien que je parle de VHDL, c'est possible d'écrire se genre de comportement dans ce langage…

Autant pour moi si c'est le cas, mais on est bien d'accord qu'il s'agit pour B de retransmettre un message qu'il n'a pas encore reçu. Dans le cerveau ce type de transmission est effectué par des sauts de potentiel et des transmissions de molécules via la glia. Il existe 10 fois plus de cellules gliales que de neurones.

L’horloge s'est un peu surfait (l'asynchrone est la mode pour avaler facilement les délais de transmission). VHDL n'est pas synchrone de base, les horloges sont explicites. C'est pas gagné, mais c'est fait tous les jours.

Même si tu simules des transmissions analogiques ou des évolutions non discrètes de potentiel, au final au moment de la simulation tu sera quand même dépendant d'un échantillonnage et d'une horloge. Le calcul des états sera lui complètement discret, on aura une succession de "snapshots" du cerveau émulé et il faudra trouver une fréquence d'échantillonnage raisonnable pour éviter les cumuls d'incertitudes qui conduiraient le modèle à s'éloigner progressivement du réel.

Je ne voix pas ou tu veux en venir, un neurone représente aussi une quantité de matière fini. Il n'y rien d'infini dans le monde réel (sauf l'espace), même en biologie.

Le neurone est certes un élément fini, mais ce n'est pas pour autant qu'un réseau de neurone est un automate à état fini. On peut peut-être l'approximer avec des automates à état fini, mais on ne peut pas être sur d'avoir un résultat comparable. Je t'accorde le fait que les réseaux de neurones ne sont pas infinis, mais le nombre de stimulus auquel le cerveau peut être soumis et réagir est quand même assez vaste, alors qu'en VHDL tu vas devoir te contenter d'un nombre limité de bus pour dialoguer. Ce nombre peut être très très vaste, mais de toutes les façons :

a) On sera de nouveau soumis au problème d'échantillonnage vu plus haut

b) Même avec un nombre délirant de bus et une sensibilité très poussée le transcodage en numérique va faire passer de simulation à émulation.

Je pensais aux dialogues asynchrones entre machine d'état indépendante. Mais on peut aussi rajouter les indéterminismes que l'on peut avoir sur les "network on chip" qui sont asynchrones pour des raisons de performance.

Mais l'asynchronicité n'empêche pas le déterminisme, heureusement d'ailleurs. Quand aux NoC, si il peut y avoir de l’indéterminisme au niveau du routage, mais généralement il n'y en a pas au niveau du traitement du message. (Et pour finir j'ajouterai que j'attend de voir un NoC qui fonctionne ailleurs que sur le simulateur VHDL du labo qui l'a codé avant de considéré la techno comme prête à la mise en vente sous 5/10 ans)

[^] # Re: Légère erreur de calcul

Posté par Nicolas Boulay (site web personnel) . Évalué à 3.

il faudra trouver une fréquence d'échantillonnage raisonnable pour éviter les cumuls d'incertitudes qui conduiraient le modèle à s'éloigner progressivement du réel.

Cela s'appelle le traitement numérique du signal. Cela date un peu comme science.

a) On sera de nouveau soumis au problème d'échantillonnage vu plus haut

b) Même avec un nombre délirant de bus et une sensibilité très poussée le transcodage en numérique va faire passer de simulation à émulation.

J'ai du mal à comprendre où tu veux en venir. Si le problème est le coté numérique de VHDL, on peut parler de simulateur comme spice, qui simule des signaux analogiques (VHDL-AMS est juste une généralisation de spice). spice est évidement bien plus lent qu'un simulateur numérique, mais le problème n'est qu'une histoire de puissance de calcul.

"La première sécurité est la liberté"

[^] # Re: Légère erreur de calcul

Posté par Kaane . Évalué à 1.

On ne parle pas de la même chose, bien sur que la modélisation de n'importe quoi est techniquement possible, mais la question ici est de savoir si on peut avoir un prototype fonctionnel dans un laps de temps raisonnable (disons à horizon 20 ans).

Un cerveau artificiel dans 20 ans, je n'y crois pas. Et les ordres de grandeurs tant au niveau puissance de calcul que capacité de stockage sont démesurés par rapport à ce qu'il est possible de faire.

Après attendons un peu et voyons si ça passe ou pas.

[^] # Re: Légère erreur de calcul

Posté par Nicolas Boulay (site web personnel) . Évalué à 2.

Non, ce n'était pas le débat du tout. Le postulat de départ de certains était de dire que la nature profonde du cerveau était impossible à reproduire sur ordinateur. Il n'était pas du tout question de durée.

Dans 20 ans, on aura plus de 1 To de RAM, et sans doute 1000 à 10 000 fois plus de puissance de calcul si on suit la loi de Moore. Il ne faut pas oublier non plus l'avènement de technologie comme la spintronic ou l'ordinateur quantique.

"La première sécurité est la liberté"

[^] # Re: Légère erreur de calcul

Posté par Kaane . Évalué à 1.

Non, ce n'était pas le débat du tout.

Si, si, ça s'appelle petite erreur de calcul car Aujourd'hui fait des calculs en diminuant la profondeur des divers types d’interactions, et que de fait il néglige (à mon sens) de nombreux facteurs de puissance.

Dans 20 ans, on aura plus de 1 To de RAM, et sans doute 1000 à 10 000 fois plus de puissance de calcul si on suit la loi de Moore

Même en supposant que l'on arrive à suivre la loi de Moore (ce dont je doute vu que l'on a déjà commencer à "tricher" en utilisant des architectures multi-coeurs en en faisant grossir les puces), je ne pense pas que les super-calculateurs dans 20 ans arriveront à simuler un cerveau. C'est à dire un individu conscient de lui même et capable d'appréhender une quasi infinité de stimulus avec une telle précision qu'il n'en retire jamais deux fois le même résultat.

Il ne faut pas oublier non plus l'avènement de technologie comme la spintronic ou l'ordinateur quantique.

Ils ont un léger problème avec les technos quantiques, faire un transistor ça marche, une porte aussi, mais le problème de construire une puce entière dont on puisse lire un résultat sans affecter l'ensemble de tous les autres éléments n'est pas encore résolu sur le papier. En clair quand on teste la valeur d'un spin ou d'un bit quantique on impacte l'ensemble des spins ou des bits quantiques avoisinants. Il faut donc soit réussir à lire tout l'état de la puce d'un seul coup, soit empêcher cet impact.

Si ce problème est résolu dans 20 ans alors oui on pourra commencer à construire des systèmes neuronaux d'un niveau de complexité comparable à ceux des créatures biologiques. Mais

a) j'y crois pas, les technos d'ordinateurs quantiques piétinent depuis 15 ans. On est pas à l'abri d'une découverte qui permette enfin d'avancer mais faire les étapes théorie -> physique fondamentale -> physique pratique -> concept -> proto -> fabrication industrielle en 20 ans c'est très très court.

b) On aura un système d'une complexité et d'une versatilité similaire, pour autant on aura pas forcément la possibilité de se rapprocher d'un simulateur de cerveau humain.

[^] # Re: Légère erreur de calcul

Posté par Nicolas Boulay (site web personnel) . Évalué à 3.

Pour mémoire, la loi de Moore c'est le doublement du nombre de transistor pour le même prix tous les 18 mois, rien à avoir avec la puissance mono-cpu.

"La première sécurité est la liberté"

[^] # Re: Légère erreur de calcul

Posté par Kaane . Évalué à 0.

Pour mémoire, la loi de Moore c'est le doublement du nombre de transistor pour le même prix tous les 18 mois

Non.

La première loi de Moore c'est que la complexité des circuits intégrés double tous les ans à prix constant.

La seconde loi de Moore c'est que le nombre de transistors des microprocesseurs doublait tous les deux ans. C'est une correction de la première loi.

En mettant deux microprocesseur sur le même circuit intégré on double certes le nombre de transistors mais on n'augmente ni la complexité ni le nombre de transistors par microprocesseur. Alors un processeur multi-coeur c'est un peu plus complexe que deux microprocesseurs sur le même circuit intégré mais c'est quand même vachement plus simple qu'un seul microprocesseur avec le double de transistor. D’où le terme de "triche".

[^] # Re: Légère erreur de calcul

Posté par Nicolas Boulay (site web personnel) . Évalué à 2.

Ce que fais l'industrie, c'est de baisser le prix unitaire du transistor à chaque changement de techno. Je ne vois pas non plus quelle différence, tu fais entre "circuits intégrés" et "microprocesseurs". C'est les même techno.

"La première sécurité est la liberté"

[^] # Re: Légère erreur de calcul

Posté par Kaane . Évalué à 1.

Ce que fais l'industrie, c'est de baisser le prix unitaire du transistor à chaque changement de techno

C'est le cas, mais ca n'a pas de rapport avec la loi de Moore.

Je ne vois pas non plus quelle différence, tu fais entre "circuits intégrés" et "microprocesseurs". C'est les même techno.

C'est pas moi qui fait la différence, c'est Moore. Et même si effectivement c'est les mêmes principes physiques sous-jacents les circuits intégrés sont des éléments indépendants les uns des autres et cablés à la queue leu leu, les microprocesseurs forment un ensemble logique intègre.

[^] # Re: Légère erreur de calcul

Posté par Nicolas Boulay (site web personnel) . Évalué à 2.

1er - […]en 65 […]. Constatant que la complexité des semiconducteurs proposés en entrée de gamme doublait tous les ans à coût constant depuis 1959, date de leur invention, il postulait la poursuite de cette croissance […]

2ième En 1975, Moore réévalua sa prédiction en posant que le nombre de transistors des microprocesseurs (et non plus de simples circuits intégrés moins complexes car formés de composants indépendants) sur une puce de silicium double tous les deux ans. […] wikipedia

En fait, il fait la différence entre les circuits simple, et complexe de l'époque. avec un x2/an, puis tous les 2 ans.

La différence qu'il faisait à l'époque, n'a aucun sens aujourd'hui. (ps: je suis ingénieur en microélectronique numérique)

"La première sécurité est la liberté"

[^] # Re: Légère erreur de calcul

Posté par Kaane . Évalué à 1.

La différence qu'il faisait à l'époque, n'a aucun sens aujourd'hui. (ps: je suis ingénieur en microélectronique numérique)

J'avoue bien volontiers n'être qu'un utilisateur de produits vis à vis de tout ce qui concerne la microélectronique, mais les catalogues que j'ai sous les yeux font la différence entre circuit intégré de base, microcontrôleurs et microprocesseurs.

J'imagine que Moore voulait insister sur le fait que ce serait la puissance des unités de calcul elle même qui doublerait et pas le cache/la mémoire eeprom embarqué/la ram embarqué.

[^] # Re: Légère erreur de calcul

Posté par Nicolas Boulay (site web personnel) . Évalué à 2.

A l'époque les circuits devaient être fait à la main, un microprocesseurs étant un mélange d'unité de calcul et de controle, cela devait être plus complexe à faire, que des série de porte logique ou de composant "réguliers" dédié (multiplieur). De mémoire, le cray1 était réalisé avec des dip ayant 2 portes logiques par chip.

La loi de Moore insiste sur la baisse des prix continue du transistor unitaire, et pas vraiment sur l'augmentation de puissance. Si l'augmentation du nombre de transistor est là, c'est parce que le prix n'augmente pas (par contre le prix d'un seul waffer s'envole, bientôt il n'y aura plus que 3 ou 4 usines dans le monde).

"La première sécurité est la liberté"

[^] # Re: Légère erreur de calcul

Posté par Maclag . Évalué à 2.

Il me semble que la Loi est "le nombre de transistors d'un circuit intégré double tous les 2ans à coût constant".

Une autre échelle à 18mois parle d'un doublement des performances, parce qu'on ne se contente pas de faire les transistors toujours plus petits, mais aussi plus rapides! (et avec une plâtrée de plus en plus épaisse de couches de métal au-dessus pour router tout ce bordel).

Et là, il va falloir être précis, parce qu'à l'époque, on débutait dans l'ère de la micro-électronique, et aujourd'hui, on nage entre:

-les microprocesseurs, DSP, ASIC

-l'analogique (qui n'a absolument rien à voir et ne diminue plus en taille au-delà d'une certaine limite techno!)

-les mémoires

-etc. etc.

D'ailleurs, on parle de "nano-électronique" pour les technologies de "prochaine génération", mais rappelons que les fondeurs de puces numériques aujourd'hui même tournent sur des ligne de 40nm, 32nm, 28nm, 22nm! Un micromètre, de "micro-électronique", mais c'est énoooooorme!!

Est-ce qu'on peut tricher? (garder le même nombre de transistors, mais en diviser le coût par deux en 2 ans) Mais tricher sur quoi? C'est une règle empirique établie par un homme (pas) seul sur une période de temps correspondant à l'essor de la technologie!

Bill Gates s'est fait retoqué une fois par le CEO de GM parce qu'il comparait l'évolution de la voiture avec celle de l'informatique. C'est vrai, ça a fait rire.

Mais que se serait-il passer si Louis Renault avait annoncé "la vitesse de pointe sera doublée et la consommation de carburant des voitures sera réduite de moitié tous les 2ans!".

Ben on aurait encore plus de suicides chez les constructeurs auto!!

[^] # Re: Légère erreur de calcul

Posté par Enzo Bricolo 🛠⚙🛠 . Évalué à 0.

Et encore tu simplifies peut être, car si ceux ci sont dans le vrai, on est pas prêt de simuler …

http://www.quantumconsciousness.org/

[^] # Re: Légère erreur de calcul

Posté par Nicolas Boulay (site web personnel) . Évalué à 2.

a) C'est un facteur de ralentissement pas un blocage.