Mais ouf, sauvé, je me suis abstenu d'être pris à l'insu de mon plein gré.

Donc, l'histoire c'est: j'installe un Linux (nickel, no problemo), ajoute uBlock sur FireFox et là je me dis "tiens y'a quoi dans le store ?" et je tombe sur

Grammar and Spell Checker (en 30 langues, c'est louche quand même).

Bon, j'y vais, je clique sur installer ("on verra bien", et puis ça peu franchement servir).

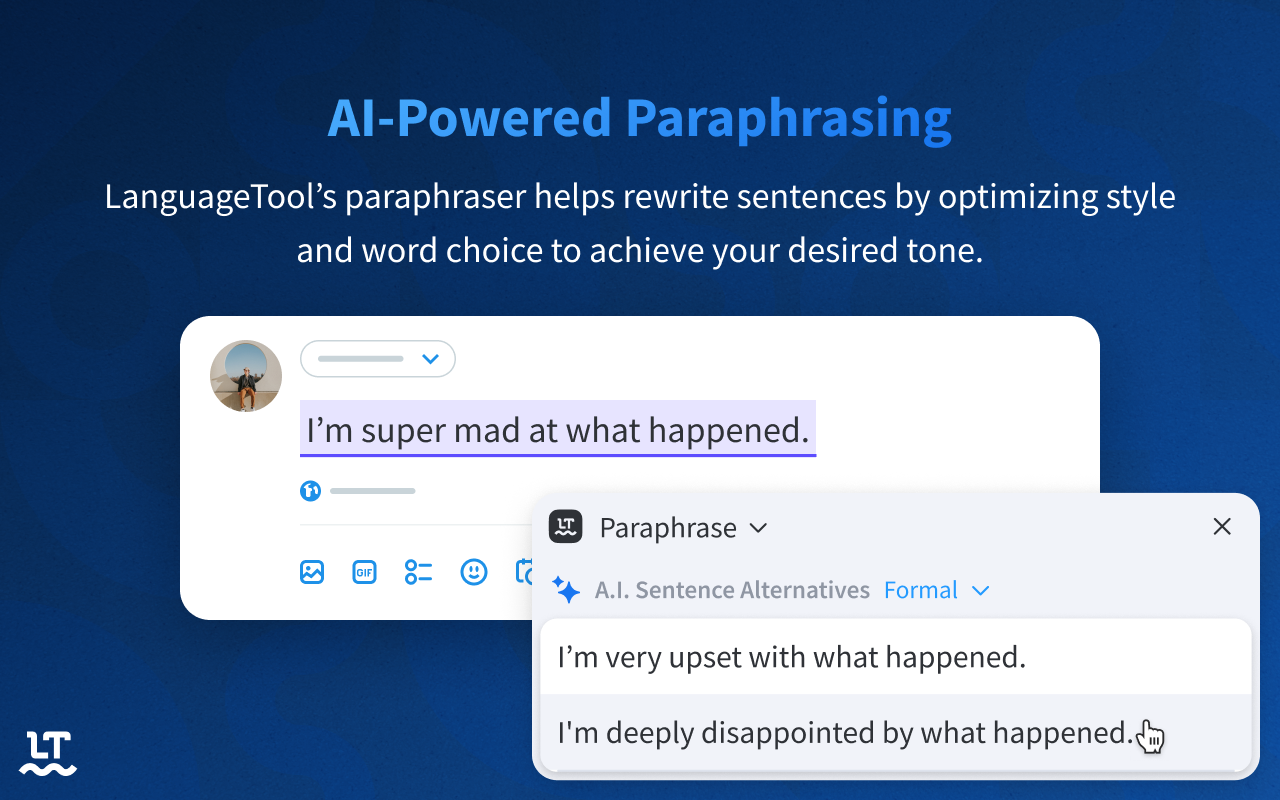

Une image, le temps que ça charge

Il y a 14 Mo dans /tmp à présent car il y a eu un message au sujet du super pouvoir de cette app:

Access your data for all websites

The extension could read the content of any web page you visit, as well as data you enter into those web pages, such as usernames and passwords. This is used for password managers, shopping tools, ad blockers, etc.Mais je ne vois pas

Extensions requesting this permission might:

- Read product and price information from a page to help find you the best price on items

- Offer a password manager that reads and writes details of your username and password

- Provide an ad blocker by reading the content of each web page you open to find and remove ad code

Bon, que les frontières entre OS/smartphone/applis/pc/cloud/office365 soient floues, c'est entendu

Pareil pour ces services "AI powered" (ou autres) dits "gratuits", on sait qu'en fait on leur offre tout notre vie privée digitale en contrepartie.

Mais qu'ils s’occupent de mots de passe ou même d'add-blocker , c'est pas un peu pousser mémé dans les orties ?

Extensions requesting this permission might:

- Update the look of some or all pages within the domain (<= ils vont mettre une feuille de vigne devant les zizis ?)

- Block content, such as advertising or content using certain tags, from a domain’s content feed

procédure avortée donc, ces 14 Mo auront bientôt disparus de /tmp

# DOM

Posté par jtremesay (site web personnel) . Évalué à 1.

Ou alors, peut-être le plugin a juste besoin d'accéder au DOM pour faire la traduction directement dans la page, tout comme le gestionnaire de mot de passe a besoin d'accéder au DOM pour remplir les formulaires de connexion ?

J'en sais rien, j'ai pas encore lu le code source pour savoir si oui ou non ils pompaient de la donnée privée.

[^] # Re: DOM

Posté par blfpd . Évalué à 1.

J’imagine que ça c’est pour mettre le widget dans le coin en bas à droite du champ de texte, plus la popup avec les suggestions.

[^] # Re: DOM

Posté par jtremesay (site web personnel) . Évalué à -9.

Par manque de temps, j'ai délégué l'analyse au stagiaire transistoré :

Vue Générale

Surface D’Injection

Données Textuelles Collectées / Envoyées

Identifiants et Auth

Stockage Local / Persisté

Limites / Protection Observées

Risques de Données Privées

Ce Qui Ne Semble PAS Être Collecté

Points de Vigilance Technique

L’extension collecte et transmet principalement du texte saisi et des métadonnées linguistiques / de compte (email, userID, token, langue maternelle, variantes). Les limites actuelles protègent les champs password mais pas d’autres formes de PII textuelles.

La combinaison injection universelle + réécriture + destinataire email introduit un risque élevé de fuite de données privées si l’utilisateur rédige du contenu sensible.

Des mesures de minimisation, filtrage PII, transparence d’envoi, et restriction de portée devraient être priorisées pour réduire l’exposition.

[^] # Re: DOM

Posté par Thomas Debesse (site web personnel, Mastodon) . Évalué à 10. Dernière modification le 26 novembre 2025 à 00:51.

Par manque de temps, gépalu.

Si tu fait écrire à une IA parce que t’as pas le temps d’écrire, je ne lirai pas (car c’est le même résultat que de faire lire par une IA).

ce commentaire est sous licence cc by 4 et précédentes

[^] # Re: DOM

Posté par octane . Évalué à 10.

Ca ouvre un champ de possibilités immenses. Un article trop long: L'IA le résume. On veut pas lire le résumé? Bah on a qu'a demander à l'IA d'en faire la synthèse. C'est une IA qui a fait la synthèse et on veut pas le lire? On a qu'a demander à l'IA de répondre à notre place. et on veut pas lire la réponse? haha! mais l'IA de notre interlocuteur l'a déjà résumé, synthétisé et commenté. Super!

Et BAM! place aux nouveaux sites WEB 6.0 (*) ou l'IA est omniprésente, on a même plus besoin de s'y connecter \o/ Gain de temps phénoménal, on aura du coup le temps de discuter avec nos proches. On pourrait faire des plateformes web ou on s'échangerait des messages. Mmmmmh, je sens que tiens un truc là. C'est quand même fantastique ce qu'on fait avec l'IA \o/

/s

(*) ou web5.0? je sais plus trop j'ai arrêté de compter à un moment

# Mauvaise nouvelle et j'ai l'air c*n

Posté par pseudonymous . Évalué à 4.

Merci pour la vigilance.

Mauvaise nouvelle : ça fait très longtemps que j'utilise cette extension. Très pratique, en particulier pour ceux, comme moi, qui écrivent moult fautes et erreurs d'inattention. Et à force de lire, écrire et écouter pas mal d'anglais, sans être véritablement "fluent", il y a un paquet de mots dont l'orthographe est mélangée (exemple : connection …).

J'ai l'air c*n : dans ma liste de plugins, cet outil est dénommé "AI Grammar Checker & Paraphraser – LanguageTool". Et la plupart du temps, quand je vois "AI" ou "IA", je m'éloigne en courant …

Je vais essayer de suivre ce journal pour savoir si le risque détecté est bien avéré.

# Politiques de confidentialités

Posté par blfpd . Évalué à 3.

Je l’ai installé aussi voyant que c’est suggéré par Mozilla.

Point positif pour moi, ça support l’espéranto!

Et puis LanguageTooler GmbH ça a l’air allemand, données en Europe quoi…

Mais dans les politiques de confidentialités on voit que

languagetool.orgc’est qu’un nom de domaine utilisé par Learneo, une société basé à San Fransisco, donc toutes les données doivent être envoyées là-bas.C’est rigolo le paragraphe pour la Confidentialité des enfants, en gros je lis ça comme si vous avez 13 ans ou moins — voire 16 ans dans l’Espace Économique Européen — merci de ne pas utiliser nos services ou au moins ne pas nous envoyer d’info perso parce qu’on a pas trop le droit enfin voilà quoi.

# Extensions requesting this permission **might**

Posté par pampryl . Évalué à 9.

C'est une phrase générique qui explique que "les extensions" qui demandent ce type de permissions sont généralement "capable de" faire l'un des exemple cité. En gros de la pédagogie sur l'autorisation que tu es en train de donner (ou non).

Ça ne veut pas du tout dire que "cette extension" s'occupe de ce type de fonctionnalité, mais que les autorisations qu'on lui donne pourraient servir à ce type de service.

Il tient ensuite à l'utilisateur de vérifier:

Malheureusement, une fois que tu donnés un accès à la lecture ou la modification du contenu des pages à une extension de ton navigateur, il est ensuite difficile de savoir si celle-ci utilise le contenu pour le but légitime de ses fonctionnalités annoncées. La demande est malgré tout légitime on dirait.

Et il ne semble pas y avoir d'autorisation plus granulaire non plus permettant de limiter la surface d'exposition.

# audit

Posté par sputnick (site web personnel, Mastodon) . Évalué à 10.

C'est un sujet que j’essaye de traiter/implémenter en ce moment en utilisant un script Python.

A la fin, j'obtiens une note de 0 à 100.

0 est fiable selon mes critères, non zéro, il faut se poser des questions.

Le script:

Le report me donne pour tampermonkey:

On ne peut pas mettre d'array dans le string...

# La correction grammaticale fonctionne bien ?

Posté par LeBouquetin (site web personnel, Mastodon) . Évalué à 10.

Je suis en train de voir avec Olivier (dev de Grammalecte) pour reprendre la maintenance de Grammalecte avec Algoo et je suis donc intéressé d'un retour de "performance" de language tool.

#tracim pour la collaboration d'équipe __ #galae pour la messagerie email __ dirigeant @ algoo

[^] # Re: La correction grammaticale fonctionne bien ?

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 10.

Language Tools a deux énormes défauts de mon point de vue :

Je pense qu'au niveau de la correction orthographique et grammaticales ils sont à peu près au même niveau.

Quand tu parles de reprendre la maintenance (ce qui serait déjà formidable sachant qu'à chaque mise à jour de LibreOffice, je me demande si Grammalecte va continuer à fonctionner), tu ne parles pas de nouveaux développement j'imagine. Ou bien tu penses pouvoir faire évoluer le logiciel ?

Je n’ai aucun avis sur systemd

[^] # Re: La correction grammaticale fonctionne bien ?

Posté par LeBouquetin (site web personnel, Mastodon) . Évalué à 10.

C'est la question : un client nous a sollicité pour faire des travaux sur Grammalecte. Ce sont des technologies que l'on connait donc on sait faire techniquement.

Ce que j'envisage, c'est soi "simple maintenance" (correction de bugs, faire en sorte que ça continue de tourner " soit aller plus loin - ajout de fonctionnalités ou autre.

J'envisage une campagne de financement participatif pour relancer le projet et nous permettre de nous y plonger sérieusement (professionnellement parlant) mais ça dépend aussi de ce qui est attendu de ses utilisateurs, de ce qui pourrait être intéressant comme développements, etc.

Je suis intéressé par tout retour sur le sujet.

#tracim pour la collaboration d'équipe __ #galae pour la messagerie email __ dirigeant @ algoo

[^] # Re: La correction grammaticale fonctionne bien ?

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 10.

Seulement ma façon de voir les choses. Il est possible que je dise des âneries, que j’enfonce des portes ouvertes ou que tu aies pensé à tout ça.

Précision de vocabulaire : pour moi ici un bug est un problème technique qui impacte le fonctionnement du logiciel, pas quelque chose lié à son dictionnaire par exemple.

Un logiciel comme Grammalecte ça évolue à plusieurs niveaux :

Je verrais bien mettre à la disposition, sur le site de l’application, une collection de dictionnaires et lexiques professionnels qui rendrait ainsi plus visible la fonctionnalité d’éditeur lexical.

Mais ça veut dire aussi qu’il faut un endroit où on peut déposer nos remarques qui devront se classer dans un des types de signalement que je viens d’évoquer et en rappelant en ce qui concerne l’ajout ou la modification de règles qu’on doit donner des précisions (en gros la solution, à charge côté développement de l’intégrer).

Olivier nous avait dit avoir eu une idée qu’il projetait de développer, avant que rien que l’idée de Grammalecte lui donne des boutons. Peut-être pourra-t-il t’en dire un peu plus.

Pour ma part, dans la mesure de mes moyens, je participerai au financement sans hésiter. Mais si tu as besoin de quelqu’un pour rédiger deux-trois trucs pour Grammalecte, n’hésite pas, je peux offrir du temps et des capacités rédactionnelles.

Il faudra aussi voir comment modifier la page Grammalecte sur le site des extensions de LibreOffice. Au besoin je peux demander à la personne qui s’occupe de la validation des extensions sur le site.

Ah, autre chose, je ne sais pas (plus?) comment Grammalecte gère les marques de trucs à corriger. Mais il faudrait sans doute des retours de personnes daltoniennes si c’est Grammalecte qui s’en occupe.

Et, là c’est une demande de fonctionnalité ou d’amélioration ! Grammalecte propose une fonctionnalité de modification du champ «Auteur». Il faudrait que ça modifie de façon à ce quand on exporte le fichier en EPUB avec l’extension Writer2xhtml cette modification soit bien conservée, ce qui n’est pas le cas. Et l’extension fait un bien meilleur travail que l’export en EPUB de LibreOffice qui a toujours le même vieux bug non corrigé sur les images SVG en prime.

Je n’ai aucun avis sur systemd

[^] # Re: La correction grammaticale fonctionne bien ?

Posté par LeBouquetin (site web personnel, Mastodon) . Évalué à 3.

Merci pour ce long message !

Effectivement il y a bien une distinction (complémentarité) entre la maintenance « technique » (bugs, fonctionnalités) et la maintenance « linguistique » (je ne sais pas si c'est le terme approprié, mais dans tous les cas, je te rejoins sur ces deux aspects

Si je reformule le sujet, l'idée est d'avoir une interface de constitution collaborative de dictionnaires/lexiques, c'est bien ça ?

Je pense qu'Olivier va nous donner l'accès (c'est bien lui qui le gère jusqu'à présent ?)

Intéressant. Je viens de découvrir la fonctionnalité, j'aurais imaginé qu'elle soit intégrée dans les propriétés du document (ou dit autrement : que sa modification soit proposée dans l'écran d'édition des propriétés du document intégré dans Libreoffice, mais manifestement ça n'y est pas)

Je crois que dans Libreoffice ça reprend l'interface classique (soulignement rouge et vert ondulé selon que c'est une erreur d'orthographe ou de grammaire)

#tracim pour la collaboration d'équipe __ #galae pour la messagerie email __ dirigeant @ algoo

[^] # Re: La correction grammaticale fonctionne bien ?

Posté par WalterPolo (Mastodon) . Évalué à 4.

'Si je reformule le sujet, l'idée est d'avoir une interface de constitution collaborative de dictionnaires/lexiques, c'est bien ça ?'

Pour info, avant Grammalecte (dont j'utilise essentiellement l'extension pour LibreOffice), une interface de ce type en ligne (mise en place et animée par Olivier) a existé : Dicollecte. Elle était vraiment super. Sauf erreur de ma part, les données lexicales (ou terminologiques pour la langue spécialisée) qui y étaient ajoutées par les contributeurices (et validées ensuite, d'où une liste de lexies en attente de validation longue comme le bras) ont fourni une partie du matériel 'linguistique' des dictionnaires embarqués avec l'extension Grammalecte (Dictionnaire “Classique”, Dictionnaire “Réforme 1990” et Dictionnaire “Toutes variantes”). Grammalecte a ensuite pris le relais de Dicollecte pour proposer un vérificateur à la fois orthographique et grammatical. Dicollecte a continué d'exister en parallèle, mais Olivier a consacré l'essentiel de son énergie au développement de Grammalecte. L'éditeur lexical de ce dernier reprend peu ou prou les données qu'il fallait saisir dans Dicollecte. À la différence de Dicollecte, l'éditeur lexical n'est pas partagé (c'est l'équivalent d'un dictionnaire utilisateur), même s'il existe la possibilité de l'exporter en .json. Par contre, Olivier prévoyait bien de proposer un 'dictionnaire communautaire' (la boîte de dialogue des options orthographiques de l'extension Grammalecte contient une option 'dictionnaire communautaire' désactivée et décrite comme 'fonctionnalité à venir'). Je crois que sous l'étiquette de 'dictionnaire communautaire', l'objectif d'Olivier était d'intégrer la dimension 'collective' qu'offrait Dicollecte. Par ailleurs, l'idée d'Ysabeau d'intégrer des jargons ou lexiques professionnels est excellente car elle ajouterait une possibilité de filtrage fin que ne permettait pas vraiment Dicollecte (qui, à mon avis, a été conçu à l'origine comme un dictionnaire de langue générale et non de langue spécialisée, mais qui permettait malgré tout de saisir des termes spécialisés vu sa souplesse).

En tout cas, comme d'autres ici, je suis partant pour une reprise de développement, au-delà de la maintenance nécessaire pour assurer la compatibilité avec LibreOffice (ou autre application utilisant Grammalecte) et prêt à y contribuer (n'étant pas développeur, ce ne serait qu'une contribution financière - à la mesure de mes modestes moyens ;-)

[^] # Re: La correction grammaticale fonctionne bien ?

Posté par ploum (site web personnel, Mastodon) . Évalué à 5.

Je suis super intéressé de soutenir un projet de reprise de Gramalecte.

Je suis dépendant d’Antidote 8 qui :

Si je parvenais un jour à remplacer antidote, ne fut-ce que pour la correction, je serais prêt à payer plusieurs dizaines d’euros par an !

Mes livres CC By-SA : https://ploum.net/livres.html

[^] # Re: La correction grammaticale fonctionne bien ?

Posté par LeBouquetin (site web personnel, Mastodon) . Évalué à 4.

Merci pour ce retour !

Qu'est-ce qui fait que tu pourras utiliser Grammalecte à la place d'Antidot (ou ne pourra pas) ?S'agit-il de qualité des corrections ? De la qualité du dictionnaire ? de Fonctionnalités bugguées ou manquantes ?

#tracim pour la collaboration d'équipe __ #galae pour la messagerie email __ dirigeant @ algoo

[^] # Re: La correction grammaticale fonctionne bien ?

Posté par ploum (site web personnel, Mastodon) . Évalué à 3.

Tout d’abord, il faut savoir que mon workflow, c’est de travailler sans corrections dans Vim.

Les corrections ne doivent venir qu’en relecture finale, d’un fichier markdown/gemtext.

Une fois que je suis prêt à publier un texte, je le lance avec :

Antidote -f monfichier.md

J’ai donc une vue nouvelle de mon fichier, avec toutes les fautes possibles. L’interface d’Antidote est pas top mais je m’y suis fait. J’ai tenté avec la ligne de commande de Grammalecte mais j’ai perdu trop de temps à valider mille fois des corrections suggérées avant de me rendre compte que ce n’était pas sauvé dans le fichier.

Ce qu’Antidote me permet :

Voir toutes les fautes identifiées avec une suggestion de correction accessible en un clic.

Corrections orthographiques, grammaticales et typographiques.

Corrections automatiques en Anglais ou en Français (les deux langues que j’utilise)

Accessoirement, j’utilise beaucoup les fonctions dictionnaire/synonyme/antonyme parce qu’accessible hors-ligne mais ce n’est clairement pas le focus de Grammalecte.

Que les choses soient claires : je ne demande pas de remplacer totalement Antidote. Je suis prêt à payer pour soutenir le projet juste si je me rends compte que je peux l’intégrer dans mon workflow. Et il ne manque pas grand chose je crois. Une ligne de commande qui vérifie un texte, me propose des suggestions à appliquer ou non (en retenant que j’ai dit non si je repasse sur le texte), je crois que ce serait déjà un super chouette outil.

Je suis de tout cœur avec cette reprise du projet.

Mes livres CC By-SA : https://ploum.net/livres.html

[^] # Re: La correction grammaticale fonctionne bien ?

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 3.

On dirait plus un souci d’interfaçage ? Faudra que je regarde ça quand j’aurai un peu de temps.

“It is seldom that liberty of any kind is lost all at once.” ― David Hume

# A noter que le serveur distant peut être auto-hébergé

Posté par Zertrin (Mastodon) . Évalué à 10.

Juste pour ajouter que, oui, par défaut le texte est envoyé à un site distant pour analyse.

MAIS, fait notable, cette extension est l'une des rares à permettre d'auto-héberger le serveur d'analyse et de configurer l'extension pour utiliser l'endpoint de son choix. C'est ce que je fais depuis des années, avec donc tout le texte envoyé sur mon serveur perso qui fait tourner LanguageTool dans un container docker.

[^] # Re: A noter que le serveur distant peut être auto-hébergé

Posté par pseudonymous . Évalué à 4.

Bon à savoir.

Et c'est ici qu'il faut creuser la question apparemment.

[^] # Re: A noter que le serveur distant peut être auto-hébergé

Posté par Luc-Skywalker . Évalué à 3. Dernière modification le 25 novembre 2025 à 20:04.

Ah intéressant. Merci.

Je me demande quel genre de matériel/bécane il faut pour obtenir un truc satisfaisant et fonctionnel.

"Si tous les cons volaient, il ferait nuit" F. Dard

[^] # Re: A noter que le serveur distant peut être auto-hébergé

Posté par anubis . Évalué à 7.

Il y a une app pour Yunohost, ce qui permet un auto-hébergement facile : https://apps.yunohost.org/app/languagetool :)

Ils identifient 1 Go d'espace disque (+base de donnée), 800 Mo de RAM pour l'exécution (https://github.com/YunoHost-Apps/languagetool_ynh/blob/master/manifest.toml#L28).

aussi sur le salon xmpp:linuxfr@chat.jabberfr.org?join

Suivre le flux des commentaires

Note : les commentaires appartiennent à celles et ceux qui les ont postés. Nous n’en sommes pas responsables.