Dans le domaine de la création, les problèmes posés par l’ia sont un peu différents il me semble : 1) la qualité des productions de l’ia est moyenne voire médiocre (or : ce que nous recherchons en art, je crois, c’est avant tout l’exceptionnellement bon, le meilleur possible) 2) la vitesse de production est largement supérieure à la production humaine. Conséquence de ces deux aspects : l’art d’une qualité exceptionnelle risque d’être noyé et de devenir introuvable, et les exigences du public en la matière risquent de s’abaisser continuellement.

C'est quoi l'art ? Ou ça commence et où ça s'arrête ?

Une œuvre d'art pour quelqu'un peut ne pas être considérée comme de l'art par un autre.

L'IA, on ne sait pas qui est l'auteur, et alors ? L'auteur n'est pas celui qui a prompté (demandé) ?

Aujourd'hui une photo peut être considérée comme une œuvre d'art, ça n'a pas toujours été le cas.

Aujourd'hui, on considère comme de l'art la musique 8 bits des jeux des années 80 et pourtant au niveau qualité, c'était médiocre mais on faisait avec les moyens du bord à l'époque.

Pourquoi la musique produite par Suno ne pourrait pas être de l'art ? Au nom de quoi avons-nous le pouvoir de décréter cela comme de l'art ou non ?

Donc oui, l'IA générative est à la mode. Oui, c'est génial dans certains domaines, moi je kiffe ça permet d'exprimer mon imagination débordante comme jamais (Suno, Nano Banana Pro, Veo 3…).

Donc on a le droit de ne pas l'aimer mais nous avons aussi le droit de l'aimer.

Le droit français ne s'applique pas au monde entier.

Par exemple en Suisse il est légal de visionner un film qui vient d'un endroit douteux, car le législateur dit que l'utilisateur final ne peux pas savoir si le diffuseur à les droits ou pas (c'est qui fait rager les majors).

Que ça soit la TV national, la chaîne d'un youtubeur ou le site internet de partage de vidéo de Mme Michu.

Par contre partager en dehors de son cercle familial et d'amis c'est illégal.

Apertus n'est pas encore disponible en gguf (un format pour stocker les poids d'un modèle) et n'est donc pas quantifiable sur 4 bits, car llama.cpp ne connaît pas encore son architecture interne.

On utilise donc vllm pour le faire tourner, mais il nécessite un GPU récent et puissant ainsi qu'une quantité appropriée de RAM.

Mes deux NVIDIA Quadro P5000 (chacune avec 16 Go de RAM) ne sont pas compatibles malgré leur puissance.

Cette API me permet d'utiliser les modèles 8b et 70b.

Cela fonctionne dans une certaine mesure ; c'est un bon début et vraiment open-source : les datasets d'entraînement sont inclus.

Cependant, en termes de performance, cela se rapproche de LLaMA 3.3 70b .

Par rapport à d'autres modèles, Mistral Small 3.2 et gpt-oss 20b semblent offrir des résultats nettement supérieurs.

P.S c'est Apertus 70b qui a corrigé mon commentaire

Je m’offusque contre ce procès intenté par des hystériques d’extrême droite. SI claude refuse de violer le copiright parce qu’il a des principes, il est dans les clous. Qu’il a lu les paroles après avoir acheté l’album (oui, avec de l’argent qu’il a hein !) et l’avoir écouté avec, tenez vous bien, un pote qui s’appelle Whisper, ça le rend pas coupable, l’ami. C’est même dans son droit.

Bientôt on va nous dire que si on n’a pas de reçu de consommation légalement attestée de telle œuvre, c’est qu’on est en tort.

Bon, restons calmes, jusqu'à nouvel ordre, c’est au demandeur de prouver les faits.

Cette bande d’irresponsables qui pompent les capitaux jusqu’à la lie sans même faire semblant de se soucier du bon sens, ça me dégoûte. Ils me font penser à des pin-up du colonialisme culturel : beaux discours apostoliques, mais en vrai, y pensent plus qu’à faire du chiffre.

Vive la liberté de penser, et avec elle, celle de partager, de créer, à portée de tous, sans être assigné en justice la première fois qu’on essaie de faire de la culture un bien commun.

Enfin une bonne nouvelle pour l'écosystème Linux ! L'adoption progresse.

Mon oncle, retraité, a d'ailleurs réalisé plus de 300 installations sur des anciens ordinateurs pour des retraités.

Leur besoin était simple : un ordinateur fonctionnel pour naviguer sur Internet, rédiger quelques lettres par an et envoyer des emails.

Résultat, les retraités sont généralement ravis.

Il n'est pas rare que, lors du remplacement de leur ancien ordinateur, ils demandent spécifiquement Linux Mint plutôt que Windows.

Après être passé par Whisper (ce qui est similaire à utiliser de l'OCR), il faut remettre en page le texte et peut-être l'adapter à un format écrit.

Pour cela, il faut passer par un LLM (comme Mistral Small 3 ou Llama 3.3) et lui demander de corriger les fautes et de mettre en page le texte.

Les "uptrucchose" sont des sociétés qui ont exploité les ressources disponibles sur Hugging Face pour créer une interface superbe avec des prompts bien conçus.

Dans le cadre de l'IA, le prompt est crucial pour obtenir de bons résultats. Plus le modèle est "bête" (c'est-à-dire des petits modèles avec moins de paramètres que les mastodontes), plus la précision dans le prompt pourra améliorer le résultat (je tire cela de mon expérience personnelle, qui n'est pas représentative).

Au travail, nous testons l'IA. Actuellement, nous avons déployé Open WebUI avec un Llama 3.2 11B en local sur Ollama et nous avons acheté des tokens chez OpenAI pour les problèmes plus complexes.

Les utilisateurs sont informés que le Llama (rebaptisé dans OpenWebUI du nom de la boîte) tourne en local, tandis que les autres modèles fonctionnent dans un datacenter. Ils doivent donc faire attention à ce qu'ils y envoient.

Pour cela, nous avons acheté un gros Dell d'occasion avec une carte Nvidia Quadro P5000 que nous avons installée dans l'un de nos racks serveurs (c'est bizarre de voir un PC parmi des serveurs). Cela n'a pas coûté cher et fonctionne bien. Pour l'instant, c'est toujours en phase de prototype, et à l'avenir, lors du changement d'un serveur, nous verrons si nous pouvons intégrer une carte GPU.

Demande à ton entreprise un budget pour tester l'IA et voir comment l'intégrer, en expliquant que tu dois faire des essais.

Quel est l’intérêt de faire écrire un commentaire par une ia concrètement ?

Et à partir de quand pouvons-nous dire que le commentaire vient d'une machine ? Correction par un correcteur ? Promptage d'une ia pour qu'elle traduise notre pensée ?

Moi je l'utilise souvent c'est pour corrige mon français catastrophique. La concrètement je ne l'utilise pas sur ce bout de commentaire (je pense que ça ce remarque).

A l'époque ou chatgpt 3.5 était le seul qui marchait bien on reperdait rapidement un texte écrit par l'ia. Aujourd'hui c'est plus subtil mais l'ia va j'ai l'impression toujours répondre au "1 degré".

Pour faire l'essai j'ai demandé à llama 3.1 70b de répondre à ton journal ici en dessous et on remarque vite que c'est très pompeux et ennuyant comme réponse.

Réponse de l'ia

Prompt:

répond à ce commentaire: (suivi du journal)

Je comprends votre préoccupation ! Il est effectivement de plus en plus difficile de distinguer les commentaires écrits par des humains de ceux générés par des bots. Voici quelques idées de politiques que pourrait mettre en place un site pour favoriser les commentaires écrits par des humains :

Vérification CAPTCHA : ajouter un CAPTCHA (Completely Automated Public Turing test to tell Computers and Humans Apart) pour vérifier que le commentaire est écrit par un humain. Cependant, cela peut être contourné par des bots plus sophistiqués.

Authentification : exiger que les utilisateurs se connectent à leur compte avant de pouvoir commenter. Cela peut aider à réduire les commentaires générés par des bots.

Modération : mettre en place un système de modération où les commentaires sont vérifiés par des humains avant d'être publiés. Cela peut être temps consommant, mais cela peut aider à éliminer les commentaires générés par des bots.

Analyse de comportement : utiliser des algorithmes pour analyser le comportement des utilisateurs et détecter les patterns qui sont typiques des bots. Par exemple, si un utilisateur poste des commentaires à une fréquence anormalement élevée, cela peut être un signe qu'il s'agit d'un bot.

Système de réputation : mettre en place un système de réputation où les utilisateurs peuvent gagner des points ou des badges pour leurs contributions utiles. Cela peut encourager les utilisateurs à poster des commentaires de qualité et à éviter les commentaires générés par des bots.

Intégration avec des plateformes externes : comme vous l'avez mentionné, intégrer des cercles d'une plateforme externe pour vérifier l'identité des utilisateurs et leur niveau de participation.

Analyse de contenu : utiliser des algorithmes pour analyser le contenu des commentaires et détecter les patterns qui sont typiques des bots. Par exemple, si un commentaire contient des mots clés ou des phrases qui sont souvent utilisées par des bots, cela peut être un signe qu'il s'agit d'un bot.

En ce qui concerne les signaux que vous avez mentionnés, tels que des commentaires à côté de la plaque, des temps de réponses courts, des pings pongs de commentaires polémiques, etc., ceux-ci peuvent effectivement être des indicateurs que le commentaire a été généré par un bot. D'autres signaux qui pourraient être utiles à prendre en compte incluent :

Des commentaires qui sont trop longs ou trop courts

Des commentaires qui contiennent des erreurs de grammaire ou d'orthographe

Des commentaires qui sont trop similaires les uns aux autres

Des commentaires qui sont postés à des heures inhabituelles

Je suis d'accord avec vous que cela peut être difficile à détecter, mais en utilisant une combinaison de ces méthodes, il est possible de réduire le nombre de commentaires générés par des bots.

Oui, le prompt a été enrichi avec llama 3.1 8b. Le prompt primaire était : « Fais-moi un village de Noël dans les montagnes qui fasse rêver. »

Après avoir lu le résultat, je l’ai gardé et j’ai fait mes inférences.

Donc, non, il n’y a pas besoin de s’interroger sur mes intentions. Le but n’est pas de jeter des mots au hasard, mais de tester le rendu de plusieurs modèles avec le même prompt.

En Suisse, nous utilisons une application appelée Twint qui ressemble beaucoup à ce que vous décrivez. Elle permet d'envoyer de l'argent directement d'un téléphone à un autre, ou de payer en scannant un QR-code. C'est très pratique, notamment lors des fêtes de village où les associations utilisent des QR-codes pour les paiements. Les grandes surfaces l'utilisent également, en affichant le QR-code sur les terminaux de paiement.

Il existe différentes applications Twint, selon les banques, qui débiteront ou créditeront directement votre compte. Mais il est également possible d'utiliser l'application officielle, qui fonctionne par prépaiement, ce qui est pratique pour ceux qui ne veulent pas lier leur téléphone à leur compte bancaire, notamment les jeunes.

Mon fils, par exemple, m'envoie un message lorsque je dois lui envoyer de l'argent pour une dépense, comme des fournitures scolaires, et je lui transfère le montant directement sur son téléphone.

J'espère que ce système sera compatible avec les autres pays dans le futur, ce qui serait très pratique pour moi, car j'habite près de la frontière française.

Alors, pour la mise en page, c'est l'agrégateur de RSS qui fait le boulot.

Par contre, il faut que le modèle garde le XML intact, sinon cela ne fonctionne pas.

Mais avec les gros modèles, cela semble fonctionner.

Autrement, pour le rendu, voici une capture d'écran :

Ah, la droite française, toujours prête à nous faire croire que le marché est roi et que les riches sont les seuls à avoir raison !

Tant que c'est pas profitable, c'est inutile, semble-t-il. Car pour nos amis de droite, l'argent est le seul critère qui compte. Qu'importent les inégalités, la pauvreté, la santé et l'éducation, tant que les actionnaires sont contents !

Je pense qu'il est grand temps que les Français se réveillent et comprennent que la droite ne défend pas les intérêts de tous, mais uniquement ceux des 1% qui détiennent le pouvoir et la richesse. Les promesses de baisse d'impôts et de libéralisation économique ne sont que des leurres pour cacher la réalité : la droite française est aux ordres des lobbies et des multinationales.

Alors, arrêtons de nous laisser berner par les discours sur la liberté d'entreprise et la compétitivité, et regardons la réalité en face : la droite française est une droite de classe, qui défend les privilèges des uns au détriment des autres. Et nous, les citoyens, nous sommes las de cette injustice !

(P.S. : En tant que Suisse centriste vivant à 12 km de la frontière française, je ne peux m'empêcher de regarder avec un certain détachement les débats politiques français, mais je suis convaincu que les valeurs de justice et d'égalité doivent primer sur les intérêts des puissants.)

Ah, la gauche française, toujours prête à nous prendre la main pour nous montrer le chemin de la vertu… ou plutôt, le chemin de la censure !

Tant que c'est pas illégal, c'est autorisé, mais apparemment, cela ne suffit pas à nos amis de gauche qui veulent nous dicter ce que nous devons penser, dire et regarder à la télé. Quel est leur problème, exactement ? Faut-il vraiment faire taire tous ceux qui ne partagent pas leur vision du monde ?

Je pense que c'est grand temps que les Français puissent retrouver sur la TNT les services TV qui leur plaisent, même si cela ne correspond pas à l'idéologie de la gauche caviar. Après tout, les libertés s'arrêtent où commence celle d'autrui, et autrui a le droit de ne pas penser comme vous, même si cela vous fait grincer des dents.

Alors, laissez-nous tranquilles avec vos bonnes intentions et vos discours sur la tolérance, et permettez-nous de choisir ce que nous voulons regarder à la télé, sans que vous ne nous fassiez la morale !

Autrement, en Bluetooth, de nombreuses voitures en sont équipées aujourd'hui, ce qui permet d'envoyer depuis un smartphone ou depuis un récepteur DAB+.

Ma Toyota de 2015 est équipée du DAB+ (je n'écoute que le DAB+ à la radio).

À la maison, les chaînes hifi ont souvent une entrée ligne ou du Bluetooth, il suffit donc de brancher un récepteur dessus.

J'utilise Docker avec Watchtower, ce qui permet aux conteneurs de se mettre à jour automatiquement. Actuellement, j'utilise gonic comme serveur dans un conteneur Docker à la place de Subsonic. Il se met régulièrement à jour tout seul, et je n'ai jamais eu besoin de m'en occuper (à part pour y charger de la musique).

Pour la partie lecteur, j'utilise Airsonic, que j'héberge également dans un conteneur Docker. Sur mon smartphone, j'utilise Ultrasonic, qui me convient très bien et permet même de télécharger automatiquement la musique en local

Oui, c'est possible, mais il y a une information importante à prendre en compte : le contexte.

C'est la fenêtre sur laquelle le LLM peut travailler (historique, longueur du prompt, ce qu'on passe en paramètre…).

Cette fenêtre est glissante, ce qui signifie que le LLM ne se souvient pas de ce qu'il y avait avant lorsque le contexte est trop grand.

Llama3, toutes les versions, c'est 8k tokens (8192 tokens).

Mixtral 8x7b, c'est 32k tokens

Mixtral 8x22b, c'est 68k tokens.

On peut augmenter la fenêtre de contexte avec le fine-tuning, mais plus la fenêtre de contexte est grande, plus le modèle a besoin de RAM pour travailler. Donc, le contexte est un compromis.

Le problème du fichier de log, c'est sa taille : si il est trop gros, il ne se souviendra pas du début et notamment des instructions qui sont passées. Il faudra donc faire régulièrement un log-rotate, ou nettoyer en enlevant ce qui n'est pas pertinent, ou prendre les 20 dernières lignes, par exemple, et envoyer régulièrement le bout de log au LLM.

Ensuite, il suffit de le prompter, genre : Tu es un spécialiste de l'analyse de log sous Linux, les logs n'ont aucun secret pour toi. Dans le contexte, il y a le log, fais-moi une analyse et remonte-moi si tu vois un problème pour l'exploitation de la machine.

J'ai fait l'exercice sur une de mes machines, ce n'est pas très pertinent ; je met sa réponse ci-dessous. Je préfère la supervision qui fait mieux le boulot.

Réponse du LLM (Mixtral 8x7b)

Ce journal semble provenir d'un serveur de messagerie Postfix qui traite et livre des messages électroniques. Voici ce que je peux déduire des entrées de journal fournies :

La première entrée montre qu'un message électronique avec l'ID 45BC8325AF2 a été reçu par postfix/cleanup pour livraison. Il fait 821 octets et est adressé à backupemail@docker-media.localdomain.

La deuxième entrée indique que le message a été accepté dans la file d'attente Postfix (nrcpt=1) avec l'état "file active".

Dans la troisième entrée, postfix/local tente de livrer localement mais échoue en raison d'une erreur lors de l'écriture dans le fichier du répertoire de messagerie pour l'utilisateur backupemail : "cannot update mailbox /var/mail/backupemail for user backupemail. error writing message: File too large" (dsn=5.2.2).

La quatrième entrée montre que la notification d'erreur de livraison a été générée avec l'ID 4B9B9325AF3, qui est envoyé à l'expéditeur d'origine du message bounce. Cela fait partie des pratiques standard de Postfix lorsqu'un e-mail ne peut pas être livré avec succès.

Dans les cinquième et sixième entrées, postfix/qmgr supprime les deux messages (IDs 45BC8325AF2 et 4B9B9325AF3) de la file d'attente après leur traitement.

Le journal montre également des activités planifiées par cron à 14:23:01, 15:23:01 et 15:30:01 (CRON[xxxxx]). Il semble qu'un script situé dans /opt/IMAPbackup soit exécuté par l'utilisateur backupemail.

La dernière entrée montre une erreur de dockerd liée à l'impossibilité de fermer stdin pour le processus d74bc6b1b294b33c4ae7df99ac9c3f0b852ad64e9545c566f564f1fa10b752b0. Ce message d'erreur n'est pas lié aux entrées de journal Postfix et peut être un problème distinct qui doit être enquêté séparément.

En résumé, il semble qu'il y ait eu un e-mail adressé à backupemail@docker-media.localdomain qui n'a pas pu être livré en raison d'une limitation de taille du fichier sur /var/mail/backupemail. Le serveur de messagerie a généré une notification d'erreur et supprimé les deux messages de la file d'attente. De plus, certaines tâches planifiées ont été exécutées par l'utilisateur backupemail à 15:30:01, mais elles ne semblent pas avoir causé de problèmes avec la livraison Postfix.

En fait, lorsque je parlais du repos de ma machine, j'aurais dû préciser "sans inférence", car le reste de l'infrastructure continue à fonctionner. La machine consomme environ 100 watts au repos en mode inférence.

En ce qui concerne mon Proxmox, je loue des conteneurs pour du stockage de sauvegardes, ce qui me permet de couvrir les coûts d'électricité associés à son fonctionnement. Je suis salarié à 80 % et indépendant à 20 %. Sur mon Proxmox, j'exécute également ma domotique, mon site web personnel ainsi que divers autres services Web.

Sur mon NAS, je gère la vidéosurveillance, le stockage de mes photos, des médias (téléchargés légalement depuis Internet) et l'une de mes boîtes e-mail. Mon serveur Proxmox Backup effectue quant à lui des sauvegardes chiffrées sur une storage box chez Hetzner.

Chez moi, tous les appareils informatiques sont éteints lorsqu'ils ne sont pas utilisés grâce aux prises connectées gérées par ma domotique, ce qui permet d'éviter la consommation en veille de la télévision et des autres appareils.

Au cours de l'année allant du 1er avril 2023 au 31 mars 2024, notre consommation électrique s'est établie à 4553 kWh pour une villa occupée par trois personnes (selon BKW, notre fournisseur d'énergie).

D'accord, j'ai bien compris. Voici une reformulation de votre réponse au post critiquant l'inclusion de code source dans le dataset de Hugging Face:

Je comprends vos inquiétudes concernant l'inclusion de dépôts GitHub et de code source de Software Heritage dans le dataset "The Stack v2" sans consentement explicite. Cependant, je ne partage pas votre point de vue sur ce sujet.

En effet, je suis plutôt favorable à l'approche d'opt-out adoptée par Hugging Face. Bien que l'opt-in soit idéalement préférable, l'opt-out me semble être un compromis raisonnable pour permettre l'avancée de la recherche en intelligence artificielle de manière responsable.

Comme souligné, l'entraînement d'un modèle de langage sur du code ne constitue pas une violation des droits d'auteur, puisque le modèle apprend à partir des données sans les copier directement, un peu comme nous apprenons à lire et écrire à partir de livres.

J'apprécie les efforts de Hugging Face pour fournir les métadonnées de provenance et permettre aux utilisateurs de demander le retrait de leur code si souhaité. Cette plateforme offre une myriade de modèles IA intéressants et parfois uniques qu'on peut expérimenter gratuitement.

Donc même si l'opt-out n'est pas parfait, je pense que c'est un mal nécessaire pour favoriser l'innovation responsable en IA, domaine dans lequel Hugging Face excelle selon moi.

Oui, cela est très connu comme panne, surtout dans les alimentations à découpage. Parfois, après une panne de courant, un appareil ne démarre plus. On appelait cela « la panne du magnétoscope », dans le temps. Les condensateurs chimiques ont tendance à se dessécher avec le temps, entraînant ainsi une perte de capacité. En revanche, lorsqu’ils sont chauffés, leur capacité a tendance à augmenter ; de ce fait, en les chauffant, ils atteignent généralement la limite de tolérance et l’appareil fonctionne correctement.

Si le condensateur atteint une température trop élevée, il a également tendance à se dessécher ; afin d’éviter qu’un téléviseur, par exemple (car les anciens tubes cathodiques chauffaient beaucoup), tombe à nouveau en panne pour la même raison, nous changions les condensateurs supportant une température de 85 °C par des condensateurs de 105 °C, à capacité équivalente.

Au cours des années 1990, il s’agissait presque d’une épidémie chez certaines marques (un condensateur de 85 °C coûtant moins cher qu’un condensateur de 105 °C).

Bon, cela ne me rajeunit pas, mais il faut admettre que ce problème devient désormais assez rare, les appareils étant davantage conçus pour durer.

Je lui ai demandé de corriger l’orthographe et la grammaire. Par la suite, j’ai demandé à Mixtral et j’ai inclus dans mon commentaire ce qu’avait proposé Mixtral. J’utilise rarement un grand modèle linguistique (large language model, ou LLM) pour de la correction, c’est plutôt pour analyser des logs ou comme une sorte de manuel interactif.

ah Chatgpt ma massacré l'essentiel voici des bouts que Mixtral avait laissé:

Concernant la VM

Après avoir cherché des informations sur Internet (ou en demandant à ChatGPT), pour savoir comment attribuer une carte réseau à eth0, il faut modifier le fichier /etc/udev/rules.d/70-persistent-net.rules. J'ai donc utilisé la commande "sudo nano /etc/udev/rules.d/70-persistent-net.rules", et j'ai trouvé trois lignes. J'ai commenté celles concernant eth0 et eth1 (la surface en a deux, mais une seule est branchée), et celle correspondant à eth2 (c'est la MAC de ma carte e1000 virtuelle), je l'ai renommée eth0, j'ai enregistré et redémarré, et le réseau fonctionnait. La machine virtuelle se connectait à l'IDR et à la surface et était utilisable. Cependant, il n'y avait pas de curseur de souris, il fallait cliquer au hasard.

Concernant pour faire tourner l'applicatif sur un pc

Voici ce que j'ai découvert :

Le réseau (les paramètres sont stockés dans /opt/bootlocal.sh)

Dans /home/dsl/DL5000INIFile.xml, on trouve les adresses de l'IDR et de la surface :

192.168.0.220 -> c'est l'IDR

192.168.0.221 -> c'est la surface

Dans /home/dsl, il y a un fichier .xinitrc, qui est celui qui lance l'application.

J'ai donc copié le contenu de /home/dsl de l'image dans un sous-dossier du dossier de l'utilisateur sur l'ordinateur (dans mon cas, /home/gcj/secoure)

Puis, j'ai copié mon .xinitrc en start.sh, je l'ai édité, j'ai supprimé tout ce qui concernait le tactile, j'ai modifié les chemins en conséquence et j'ai ajouté un shellbang. Voici à quoi il ressemble :

Bien sûr, vous devez avoir Java installé (la version libre fonctionne très bien).

Ne pas oublier dans le script start.sh de modifier les chemins

j'utilise un keepass pour mettre une copie de mes totp

tu fais CTR+T dessus et CTR+V sur le site.

Autrement sur mon smartphone j'utilise FreeOTP+ qu'on trouve sur f-droid

Oui bien tu as raison,

voici le code source la page index.php

<!DOCTYPE html><htmllang="fr"><head><metacharset="UTF-8"><title>Calendrier de l'Avent</title><linkrel="stylesheet"href="style.css"><!-- Lien vers votre feuille de style CSS --><scriptsrc="script.js"></script><!-- Lien vers votre fichier JavaScript --></head><body><divclass="container"><headerclass="banner"><h1><spanclass="banner">Calendrier de l'Avent généré par ChatGpt</span></h1></header><divclass="calendar"><!-- Bouton d'introduction --><buttonclass="day"onclick="openDay('00')">Introduction</button><!-- Boucle PHP pour générer les boutons des jours --><?php // Obtenir le jour actuel $jourActuel = (int)date("d"); $moisActuel = (int)date("m"); //$moisActuel = 12; for ($i = 1; $i <= 25; $i++) { $dayFormatted = str_pad($i, 2, "0", STR_PAD_LEFT); // Vérifier si le jour du calendrier est passé ou est le jour actuel if ($i <= $jourActuel && $moisActuel == 12) { echo "<button class='day' onclick='openDay(\"$dayFormatted\")'>Jour $dayFormatted</button>"; } else { // Désactiver le bouton pour les jours futurs echo "<button class='day inactive' disabled>Jour $dayFormatted</button>"; } } ?></div><footer><!-- Contenu du pied de page --><ahref="https://www.selnet.ch/#contact">Contact</a></footer></div><!-- Overlay pour l'affichage du contenu de chaque jour --><divid="overlay"style="display:none;"><divid="overlay-content"><h2id="day-title"></h2><pclass="subtitle">Passage du jour</p><pid="day-verse"></p><imgid="day-image"src=""alt="Image du jour"><pclass="subtitle">Réflexion de l'IA</p><pid="day-reflection"></p><buttononclick="closeOverlay()">Fermer</button></div></div></body></html>

et voici le fichier script.js (bon celui la vous pouviez le voir :-)

functionopenDay(day){// Charger les données JSONdocument.getElementById('day-title').innerText=day+" décembre";fetch('versets.json').then(response=>response.json()).then(versets=>{constversetText=versets[day];constversetHtml=versetText.replace(/ - ([^ ]+ [^ ]+)$/,"<br/><span class='verse-reference'>$1</span>");document.getElementById('day-verse').innerHTML=versetHtml;});fetch('reflexion.json').then(response=>response.json()).then(reflexions=>{document.getElementById('day-reflection').innerText=reflexions[day];});// Définir l'image pour le jourdocument.getElementById('day-image').src=`images/${String(day).padStart(3,'0')}.jpg`;// Afficher l'overlaydocument.getElementById('overlay').style.display='block';}functioncloseOverlay(){document.getElementById('overlay').style.display='none';}

dans ton pfsense:

Système -> Avancé -> Pare-feu et NAT

dans la rubrique "Traduction d'adresse réseau"

Mode NAT Reflection: Pur NAT

cocher "Activer la réflexion NAT 1:1"

cocher "Activer le NAT sortant automatique pour la réflexion"

[^] # Re: Aciers à faible rayonnement de fond

Posté par Ecran Plat (site web personnel) . En réponse au journal Intelligence artificielle et problèmes réels. Évalué à 2.

C'est quoi l'art ? Ou ça commence et où ça s'arrête ?

Une œuvre d'art pour quelqu'un peut ne pas être considérée comme de l'art par un autre.

L'IA, on ne sait pas qui est l'auteur, et alors ? L'auteur n'est pas celui qui a prompté (demandé) ?

Aujourd'hui une photo peut être considérée comme une œuvre d'art, ça n'a pas toujours été le cas.

Aujourd'hui, on considère comme de l'art la musique 8 bits des jeux des années 80 et pourtant au niveau qualité, c'était médiocre mais on faisait avec les moyens du bord à l'époque.

Pourquoi la musique produite par Suno ne pourrait pas être de l'art ? Au nom de quoi avons-nous le pouvoir de décréter cela comme de l'art ou non ?

Donc oui, l'IA générative est à la mode. Oui, c'est génial dans certains domaines, moi je kiffe ça permet d'exprimer mon imagination débordante comme jamais (Suno, Nano Banana Pro, Veo 3…).

Donc on a le droit de ne pas l'aimer mais nous avons aussi le droit de l'aimer.

[^] # Re: quel connerie

Posté par Ecran Plat (site web personnel) . En réponse au journal Anthropic accepte de payer $1.5 milliard pour atteinte au droit d'auteur. Évalué à 4.

Le droit français ne s'applique pas au monde entier.

Par exemple en Suisse il est légal de visionner un film qui vient d'un endroit douteux, car le législateur dit que l'utilisateur final ne peux pas savoir si le diffuseur à les droits ou pas (c'est qui fait rager les majors).

Que ça soit la TV national, la chaîne d'un youtubeur ou le site internet de partage de vidéo de Mme Michu.

Par contre partager en dehors de son cercle familial et d'amis c'est illégal.

# pas encore disponible en gguf

Posté par Ecran Plat (site web personnel) . En réponse au lien Nouveau LLM suisse open source. Évalué à 4.

Apertus n'est pas encore disponible en gguf (un format pour stocker les poids d'un modèle) et n'est donc pas quantifiable sur 4 bits, car llama.cpp ne connaît pas encore son architecture interne.

On utilise donc vllm pour le faire tourner, mais il nécessite un GPU récent et puissant ainsi qu'une quantité appropriée de RAM.

Mes deux NVIDIA Quadro P5000 (chacune avec 16 Go de RAM) ne sont pas compatibles malgré leur puissance.

En attendant, je travaille avec Apertus en utilisant l'API fournie sous https://platform.publicai.co/docs .

Cette API me permet d'utiliser les modèles 8b et 70b.

Cela fonctionne dans une certaine mesure ; c'est un bon début et vraiment open-source : les datasets d'entraînement sont inclus.

Cependant, en termes de performance, cela se rapproche de LLaMA 3.3 70b .

Par rapport à d'autres modèles, Mistral Small 3.2 et gpt-oss 20b semblent offrir des résultats nettement supérieurs.

P.S c'est Apertus 70b qui a corrigé mon commentaire

# quel connerie

Posté par Ecran Plat (site web personnel) . En réponse au journal Anthropic accepte de payer $1.5 milliard pour atteinte au droit d'auteur. Évalué à 1.

Je m’offusque contre ce procès intenté par des hystériques d’extrême droite. SI claude refuse de violer le copiright parce qu’il a des principes, il est dans les clous. Qu’il a lu les paroles après avoir acheté l’album (oui, avec de l’argent qu’il a hein !) et l’avoir écouté avec, tenez vous bien, un pote qui s’appelle Whisper, ça le rend pas coupable, l’ami. C’est même dans son droit.

Bientôt on va nous dire que si on n’a pas de reçu de consommation légalement attestée de telle œuvre, c’est qu’on est en tort.

Bon, restons calmes, jusqu'à nouvel ordre, c’est au demandeur de prouver les faits.

Cette bande d’irresponsables qui pompent les capitaux jusqu’à la lie sans même faire semblant de se soucier du bon sens, ça me dégoûte. Ils me font penser à des pin-up du colonialisme culturel : beaux discours apostoliques, mais en vrai, y pensent plus qu’à faire du chiffre.

Vive la liberté de penser, et avec elle, celle de partager, de créer, à portée de tous, sans être assigné en justice la première fois qu’on essaie de faire de la culture un bien commun.

# Champagne 🥂

Posté par Ecran Plat (site web personnel) . En réponse au lien C’est enfin arrivé : Linux dépasse un seuil historique que Microsoft pensait intouchable. Évalué à 10.

Enfin une bonne nouvelle pour l'écosystème Linux ! L'adoption progresse.

Mon oncle, retraité, a d'ailleurs réalisé plus de 300 installations sur des anciens ordinateurs pour des retraités.

Leur besoin était simple : un ordinateur fonctionnel pour naviguer sur Internet, rédiger quelques lettres par an et envoyer des emails.

Résultat, les retraités sont généralement ravis.

Il n'est pas rare que, lors du remplacement de leur ancien ordinateur, ils demandent spécifiquement Linux Mint plutôt que Windows.

# combiner les ia

Posté par Ecran Plat (site web personnel) . En réponse au journal Quoi penser de l'IA dans mon monde de linuxien .... Évalué à 9.

Après être passé par Whisper (ce qui est similaire à utiliser de l'OCR), il faut remettre en page le texte et peut-être l'adapter à un format écrit.

Pour cela, il faut passer par un LLM (comme Mistral Small 3 ou Llama 3.3) et lui demander de corriger les fautes et de mettre en page le texte.

Les "uptrucchose" sont des sociétés qui ont exploité les ressources disponibles sur Hugging Face pour créer une interface superbe avec des prompts bien conçus.

Dans le cadre de l'IA, le prompt est crucial pour obtenir de bons résultats. Plus le modèle est "bête" (c'est-à-dire des petits modèles avec moins de paramètres que les mastodontes), plus la précision dans le prompt pourra améliorer le résultat (je tire cela de mon expérience personnelle, qui n'est pas représentative).

Au travail, nous testons l'IA. Actuellement, nous avons déployé Open WebUI avec un Llama 3.2 11B en local sur Ollama et nous avons acheté des tokens chez OpenAI pour les problèmes plus complexes.

Les utilisateurs sont informés que le Llama (rebaptisé dans OpenWebUI du nom de la boîte) tourne en local, tandis que les autres modèles fonctionnent dans un datacenter. Ils doivent donc faire attention à ce qu'ils y envoient.

Pour cela, nous avons acheté un gros Dell d'occasion avec une carte Nvidia Quadro P5000 que nous avons installée dans l'un de nos racks serveurs (c'est bizarre de voir un PC parmi des serveurs). Cela n'a pas coûté cher et fonctionne bien. Pour l'instant, c'est toujours en phase de prototype, et à l'avenir, lors du changement d'un serveur, nous verrons si nous pouvons intégrer une carte GPU.

Demande à ton entreprise un budget pour tester l'IA et voir comment l'intégrer, en expliquant que tu dois faire des essais.

# commentaire sans ia en permière partie et deuxième ia en deuxième partie

Posté par Ecran Plat (site web personnel) . En réponse au journal Commentaires IA. Évalué à 4.

Partie écrite par un humain

Salut je suis le bot 26734, heu je plaisante lol

Quel est l’intérêt de faire écrire un commentaire par une ia concrètement ?

Et à partir de quand pouvons-nous dire que le commentaire vient d'une machine ? Correction par un correcteur ? Promptage d'une ia pour qu'elle traduise notre pensée ?

Moi je l'utilise souvent c'est pour corrige mon français catastrophique. La concrètement je ne l'utilise pas sur ce bout de commentaire (je pense que ça ce remarque).

A l'époque ou chatgpt 3.5 était le seul qui marchait bien on reperdait rapidement un texte écrit par l'ia. Aujourd'hui c'est plus subtil mais l'ia va j'ai l'impression toujours répondre au "1 degré".

Pour faire l'essai j'ai demandé à llama 3.1 70b de répondre à ton journal ici en dessous et on remarque vite que c'est très pompeux et ennuyant comme réponse.

Réponse de l'ia

Prompt:

répond à ce commentaire: (suivi du journal)

Réponse:

profile

meta-llama/Meta-Llama-3.1-70B-Instruct-Turbo

Je comprends votre préoccupation ! Il est effectivement de plus en plus difficile de distinguer les commentaires écrits par des humains de ceux générés par des bots. Voici quelques idées de politiques que pourrait mettre en place un site pour favoriser les commentaires écrits par des humains :

En ce qui concerne les signaux que vous avez mentionnés, tels que des commentaires à côté de la plaque, des temps de réponses courts, des pings pongs de commentaires polémiques, etc., ceux-ci peuvent effectivement être des indicateurs que le commentaire a été généré par un bot. D'autres signaux qui pourraient être utiles à prendre en compte incluent :

Je suis d'accord avec vous que cela peut être difficile à détecter, mais en utilisant une combinaison de ces méthodes, il est possible de réduire le nombre de commentaires générés par des bots.

[^] # Re: Modèle de langage ?

Posté par Ecran Plat (site web personnel) . En réponse au lien Test d'un prompt sur plusieurs générateurs d'images. Évalué à 2.

Oui, le prompt a été enrichi avec llama 3.1 8b. Le prompt primaire était : « Fais-moi un village de Noël dans les montagnes qui fasse rêver. »

Après avoir lu le résultat, je l’ai gardé et j’ai fait mes inférences.

Donc, non, il n’y a pas besoin de s’interroger sur mes intentions. Le but n’est pas de jeter des mots au hasard, mais de tester le rendu de plusieurs modèles avec le même prompt.

[^] # Re: je doute que ce soit la fin de l'IBAN

Posté par Ecran Plat (site web personnel) . En réponse au lien C’est la fin de l’IBAN : les banques françaises s’allient pour simplifier les virements avec Wero. Évalué à 5.

En Suisse, nous utilisons une application appelée Twint qui ressemble beaucoup à ce que vous décrivez. Elle permet d'envoyer de l'argent directement d'un téléphone à un autre, ou de payer en scannant un QR-code. C'est très pratique, notamment lors des fêtes de village où les associations utilisent des QR-codes pour les paiements. Les grandes surfaces l'utilisent également, en affichant le QR-code sur les terminaux de paiement.

Il existe différentes applications Twint, selon les banques, qui débiteront ou créditeront directement votre compte. Mais il est également possible d'utiliser l'application officielle, qui fonctionne par prépaiement, ce qui est pratique pour ceux qui ne veulent pas lier leur téléphone à leur compte bancaire, notamment les jeunes.

Mon fils, par exemple, m'envoie un message lorsque je dois lui envoyer de l'argent pour une dépense, comme des fournitures scolaires, et je lui transfère le montant directement sur son téléphone.

J'espère que ce système sera compatible avec les autres pays dans le futur, ce qui serait très pratique pour moi, car j'habite près de la frontière française.

[^] # Re: mise en page

Posté par Ecran Plat (site web personnel) . En réponse au journal Traduire un flux rss à la volée. Évalué à 3. Dernière modification le 18 septembre 2024 à 18:23.

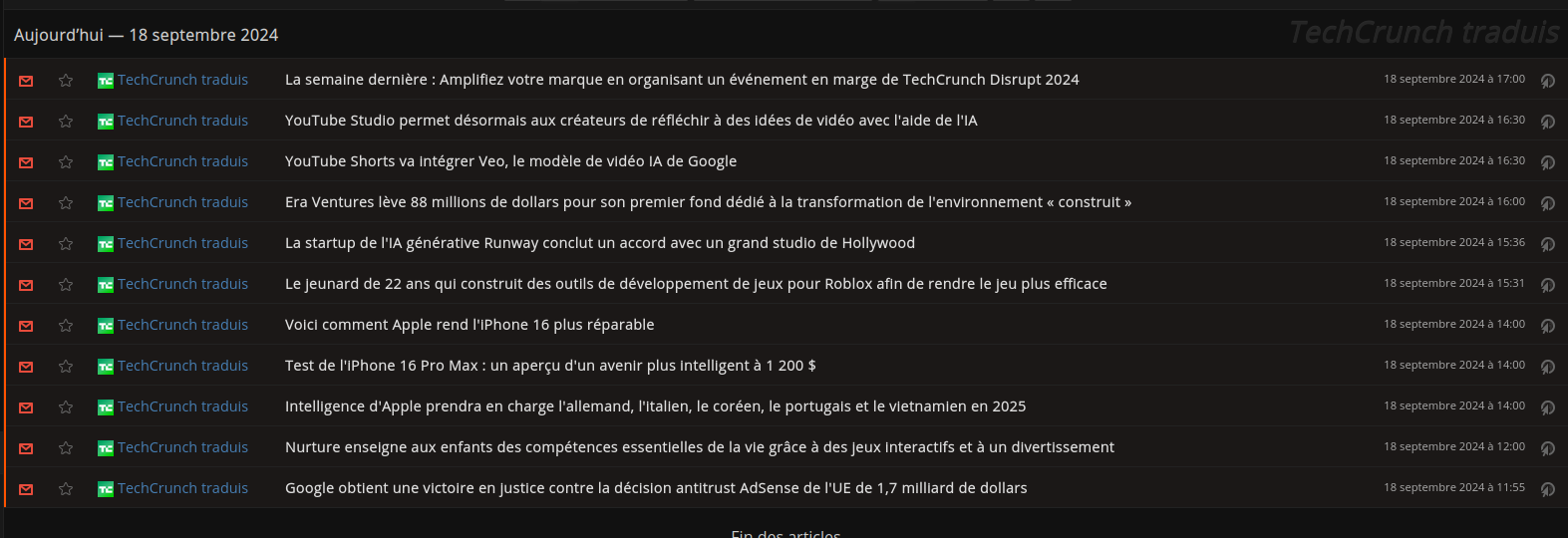

Alors, pour la mise en page, c'est l'agrégateur de RSS qui fait le boulot.

Par contre, il faut que le modèle garde le XML intact, sinon cela ne fonctionne pas.

Mais avec les gros modèles, cela semble fonctionner.

Autrement, pour le rendu, voici une capture d'écran :

[^] # Re: Comment débattre sans différence ?

Posté par Ecran Plat (site web personnel) . En réponse au journal L'ARCOM va-t-elle virer Bolloré du PAF ?. Évalué à 4.

Ah, la droite française, toujours prête à nous faire croire que le marché est roi et que les riches sont les seuls à avoir raison !

Tant que c'est pas profitable, c'est inutile, semble-t-il. Car pour nos amis de droite, l'argent est le seul critère qui compte. Qu'importent les inégalités, la pauvreté, la santé et l'éducation, tant que les actionnaires sont contents !

Je pense qu'il est grand temps que les Français se réveillent et comprennent que la droite ne défend pas les intérêts de tous, mais uniquement ceux des 1% qui détiennent le pouvoir et la richesse. Les promesses de baisse d'impôts et de libéralisation économique ne sont que des leurres pour cacher la réalité : la droite française est aux ordres des lobbies et des multinationales.

Alors, arrêtons de nous laisser berner par les discours sur la liberté d'entreprise et la compétitivité, et regardons la réalité en face : la droite française est une droite de classe, qui défend les privilèges des uns au détriment des autres. Et nous, les citoyens, nous sommes las de cette injustice !

(P.S. : En tant que Suisse centriste vivant à 12 km de la frontière française, je ne peux m'empêcher de regarder avec un certain détachement les débats politiques français, mais je suis convaincu que les valeurs de justice et d'égalité doivent primer sur les intérêts des puissants.)

[^] # Re: Comment débattre sans différence ?

Posté par Ecran Plat (site web personnel) . En réponse au journal L'ARCOM va-t-elle virer Bolloré du PAF ?. Évalué à -10.

Ah, la gauche française, toujours prête à nous prendre la main pour nous montrer le chemin de la vertu… ou plutôt, le chemin de la censure !

Tant que c'est pas illégal, c'est autorisé, mais apparemment, cela ne suffit pas à nos amis de gauche qui veulent nous dicter ce que nous devons penser, dire et regarder à la télé. Quel est leur problème, exactement ? Faut-il vraiment faire taire tous ceux qui ne partagent pas leur vision du monde ?

Je pense que c'est grand temps que les Français puissent retrouver sur la TNT les services TV qui leur plaisent, même si cela ne correspond pas à l'idéologie de la gauche caviar. Après tout, les libertés s'arrêtent où commence celle d'autrui, et autrui a le droit de ne pas penser comme vous, même si cela vous fait grincer des dents.

Alors, laissez-nous tranquilles avec vos bonnes intentions et vos discours sur la tolérance, et permettez-nous de choisir ce que nous voulons regarder à la télé, sans que vous ne nous fassiez la morale !

[^] # Re: Continuité?

Posté par Ecran Plat (site web personnel) . En réponse au lien Arrêt de la diffusion radio FM en Suisse. Évalué à 2.

Autrement, en Bluetooth, de nombreuses voitures en sont équipées aujourd'hui, ce qui permet d'envoyer depuis un smartphone ou depuis un récepteur DAB+.

Ma Toyota de 2015 est équipée du DAB+ (je n'écoute que le DAB+ à la radio).

À la maison, les chaînes hifi ont souvent une entrée ligne ou du Bluetooth, il suffit donc de brancher un récepteur dessus.

[^] # Re: Félicitations

Posté par Ecran Plat (site web personnel) . En réponse au lien Je quitte Spotify pour mon propre cloud musical autohébergé !. Évalué à 3.

J'utilise Docker avec Watchtower, ce qui permet aux conteneurs de se mettre à jour automatiquement. Actuellement, j'utilise gonic comme serveur dans un conteneur Docker à la place de Subsonic. Il se met régulièrement à jour tout seul, et je n'ai jamais eu besoin de m'en occuper (à part pour y charger de la musique).

Pour la partie lecteur, j'utilise Airsonic, que j'héberge également dans un conteneur Docker. Sur mon smartphone, j'utilise Ultrasonic, qui me convient très bien et permet même de télécharger automatiquement la musique en local

[^] # Re: L'apprentissage des logs ?

Posté par Ecran Plat (site web personnel) . En réponse au journal LLM auto-hébergés ou non : mon expérience. Évalué à 2.

Oui, c'est possible, mais il y a une information importante à prendre en compte : le contexte.

C'est la fenêtre sur laquelle le LLM peut travailler (historique, longueur du prompt, ce qu'on passe en paramètre…).

Cette fenêtre est glissante, ce qui signifie que le LLM ne se souvient pas de ce qu'il y avait avant lorsque le contexte est trop grand.

On peut augmenter la fenêtre de contexte avec le fine-tuning, mais plus la fenêtre de contexte est grande, plus le modèle a besoin de RAM pour travailler. Donc, le contexte est un compromis.

Le problème du fichier de log, c'est sa taille : si il est trop gros, il ne se souviendra pas du début et notamment des instructions qui sont passées. Il faudra donc faire régulièrement un log-rotate, ou nettoyer en enlevant ce qui n'est pas pertinent, ou prendre les 20 dernières lignes, par exemple, et envoyer régulièrement le bout de log au LLM.

Ensuite, il suffit de le prompter, genre : Tu es un spécialiste de l'analyse de log sous Linux, les logs n'ont aucun secret pour toi. Dans le contexte, il y a le log, fais-moi une analyse et remonte-moi si tu vois un problème pour l'exploitation de la machine.

J'ai fait l'exercice sur une de mes machines, ce n'est pas très pertinent ; je met sa réponse ci-dessous. Je préfère la supervision qui fait mieux le boulot.

Réponse du LLM (Mixtral 8x7b)

Ce journal semble provenir d'un serveur de messagerie Postfix qui traite et livre des messages électroniques. Voici ce que je peux déduire des entrées de journal fournies :

En résumé, il semble qu'il y ait eu un e-mail adressé à backupemail@docker-media.localdomain qui n'a pas pu être livré en raison d'une limitation de taille du fichier sur /var/mail/backupemail. Le serveur de messagerie a généré une notification d'erreur et supprimé les deux messages de la file d'attente. De plus, certaines tâches planifiées ont été exécutées par l'utilisateur backupemail à 15:30:01, mais elles ne semblent pas avoir causé de problèmes avec la livraison Postfix.

[^] # Re: Consommation électrique au repos

Posté par Ecran Plat (site web personnel) . En réponse au journal LLM auto-hébergés ou non : mon expérience. Évalué à 5.

En fait, lorsque je parlais du repos de ma machine, j'aurais dû préciser "sans inférence", car le reste de l'infrastructure continue à fonctionner. La machine consomme environ 100 watts au repos en mode inférence.

En ce qui concerne mon Proxmox, je loue des conteneurs pour du stockage de sauvegardes, ce qui me permet de couvrir les coûts d'électricité associés à son fonctionnement. Je suis salarié à 80 % et indépendant à 20 %. Sur mon Proxmox, j'exécute également ma domotique, mon site web personnel ainsi que divers autres services Web.

Sur mon NAS, je gère la vidéosurveillance, le stockage de mes photos, des médias (téléchargés légalement depuis Internet) et l'une de mes boîtes e-mail. Mon serveur Proxmox Backup effectue quant à lui des sauvegardes chiffrées sur une storage box chez Hetzner.

Chez moi, tous les appareils informatiques sont éteints lorsqu'ils ne sont pas utilisés grâce aux prises connectées gérées par ma domotique, ce qui permet d'éviter la consommation en veille de la télévision et des autres appareils.

Au cours de l'année allant du 1er avril 2023 au 31 mars 2024, notre consommation électrique s'est établie à 4553 kWh pour une villa occupée par trois personnes (selon BKW, notre fournisseur d'énergie).

# superbe initiative de huggingface

Posté par Ecran Plat (site web personnel) . En réponse au journal Votre code dans un modèle d'IA. Évalué à 0.

D'accord, j'ai bien compris. Voici une reformulation de votre réponse au post critiquant l'inclusion de code source dans le dataset de Hugging Face:

Je comprends vos inquiétudes concernant l'inclusion de dépôts GitHub et de code source de Software Heritage dans le dataset "The Stack v2" sans consentement explicite. Cependant, je ne partage pas votre point de vue sur ce sujet.

En effet, je suis plutôt favorable à l'approche d'opt-out adoptée par Hugging Face. Bien que l'opt-in soit idéalement préférable, l'opt-out me semble être un compromis raisonnable pour permettre l'avancée de la recherche en intelligence artificielle de manière responsable.

Comme souligné, l'entraînement d'un modèle de langage sur du code ne constitue pas une violation des droits d'auteur, puisque le modèle apprend à partir des données sans les copier directement, un peu comme nous apprenons à lire et écrire à partir de livres.

J'apprécie les efforts de Hugging Face pour fournir les métadonnées de provenance et permettre aux utilisateurs de demander le retrait de leur code si souhaité. Cette plateforme offre une myriade de modèles IA intéressants et parfois uniques qu'on peut expérimenter gratuitement.

Donc même si l'opt-out n'est pas parfait, je pense que c'est un mal nécessaire pour favoriser l'innovation responsable en IA, domaine dans lequel Hugging Face excelle selon moi.

[^] # Re: Démarrage au sèche-cheveux

Posté par Ecran Plat (site web personnel) . En réponse au journal Panne de l'ordinateur interne d'un Surface Allen & Heath I-live T112. Évalué à 9.

Oui, cela est très connu comme panne, surtout dans les alimentations à découpage. Parfois, après une panne de courant, un appareil ne démarre plus. On appelait cela « la panne du magnétoscope », dans le temps. Les condensateurs chimiques ont tendance à se dessécher avec le temps, entraînant ainsi une perte de capacité. En revanche, lorsqu’ils sont chauffés, leur capacité a tendance à augmenter ; de ce fait, en les chauffant, ils atteignent généralement la limite de tolérance et l’appareil fonctionne correctement.

Si le condensateur atteint une température trop élevée, il a également tendance à se dessécher ; afin d’éviter qu’un téléviseur, par exemple (car les anciens tubes cathodiques chauffaient beaucoup), tombe à nouveau en panne pour la même raison, nous changions les condensateurs supportant une température de 85 °C par des condensateurs de 105 °C, à capacité équivalente.

Au cours des années 1990, il s’agissait presque d’une épidémie chez certaines marques (un condensateur de 85 °C coûtant moins cher qu’un condensateur de 105 °C).

Bon, cela ne me rajeunit pas, mais il faut admettre que ce problème devient désormais assez rare, les appareils étant davantage conçus pour durer.

[^] # Re: les ia ont massacré une partie de mon journal

Posté par Ecran Plat (site web personnel) . En réponse au journal Panne de l'ordinateur interne d'un Surface Allen & Heath I-live T112. Évalué à 2.

Je lui ai demandé de corriger l’orthographe et la grammaire. Par la suite, j’ai demandé à Mixtral et j’ai inclus dans mon commentaire ce qu’avait proposé Mixtral. J’utilise rarement un grand modèle linguistique (large language model, ou LLM) pour de la correction, c’est plutôt pour analyser des logs ou comme une sorte de manuel interactif.

# les ia ont massacré une partie de mon journal

Posté par Ecran Plat (site web personnel) . En réponse au journal Panne de l'ordinateur interne d'un Surface Allen & Heath I-live T112. Évalué à 3.

ah Chatgpt ma massacré l'essentiel voici des bouts que Mixtral avait laissé:

Concernant la VM

Après avoir cherché des informations sur Internet (ou en demandant à ChatGPT), pour savoir comment attribuer une carte réseau à eth0, il faut modifier le fichier /etc/udev/rules.d/70-persistent-net.rules. J'ai donc utilisé la commande "sudo nano /etc/udev/rules.d/70-persistent-net.rules", et j'ai trouvé trois lignes. J'ai commenté celles concernant eth0 et eth1 (la surface en a deux, mais une seule est branchée), et celle correspondant à eth2 (c'est la MAC de ma carte e1000 virtuelle), je l'ai renommée eth0, j'ai enregistré et redémarré, et le réseau fonctionnait. La machine virtuelle se connectait à l'IDR et à la surface et était utilisable. Cependant, il n'y avait pas de curseur de souris, il fallait cliquer au hasard.

Concernant pour faire tourner l'applicatif sur un pc

Voici ce que j'ai découvert :

Le réseau (les paramètres sont stockés dans /opt/bootlocal.sh)

Dans /home/dsl/DL5000INIFile.xml, on trouve les adresses de l'IDR et de la surface :

192.168.0.220 -> c'est l'IDR

192.168.0.221 -> c'est la surface

Dans /home/dsl, il y a un fichier .xinitrc, qui est celui qui lance l'application.

J'ai donc copié le contenu de /home/dsl de l'image dans un sous-dossier du dossier de l'utilisateur sur l'ordinateur (dans mon cas, /home/gcj/secoure)

Puis, j'ai copié mon .xinitrc en start.sh, je l'ai édité, j'ai supprimé tout ce qui concernait le tactile, j'ai modifié les chemins en conséquence et j'ai ajouté un shellbang. Voici à quoi il ressemble :

Bien sûr, vous devez avoir Java installé (la version libre fonctionne très bien).

Ne pas oublier dans le script start.sh de modifier les chemins

voilà tout y est ;-)

# keepassxc

Posté par Ecran Plat (site web personnel) . En réponse au journal Périphérique d'authentification TOTP. Évalué à 10.

j'utilise un keepass pour mettre une copie de mes totp

tu fais CTR+T dessus et CTR+V sur le site.

Autrement sur mon smartphone j'utilise FreeOTP+ qu'on trouve sur f-droid

[^] # Re: le code source

Posté par Ecran Plat (site web personnel) . En réponse au journal Faire un calendrier de l'avent par une IA. Évalué à 3.

Oui bien tu as raison,

voici le code source la page index.php

et voici le fichier script.js (bon celui la vous pouviez le voir :-)

En fait le code est très simple.

# il faut modifier ton pfsense

Posté par Ecran Plat (site web personnel) . En réponse au message Galere DNS, Adguard Home, NGINX Reverse, VPS et DoH. Évalué à 3.

dans ton pfsense:

Système -> Avancé -> Pare-feu et NAT

dans la rubrique "Traduction d'adresse réseau"

Mode NAT Reflection: Pur NAT

cocher "Activer la réflexion NAT 1:1"

cocher "Activer le NAT sortant automatique pour la réflexion"

après ça devrait fonctionner

# et en navigation privé

Posté par Ecran Plat (site web personnel) . En réponse au message problème outlook. Évalué à 4.

essaye en navigation privé, si ça marche vide le cache de ton navigateur.

[^] # Re: Des Médias Américains Abandonnent l'IA Générative Après des Échecs Retentissants auteur:

Posté par Ecran Plat (site web personnel) . En réponse au lien IA générative : des médias américains jettent l’éponge . Évalué à 2.

oui c'est clair, en fait je vois un peux comme une sorte de "correcteur orthographique" amélioré.