Cette agitation politico-médiatique autour de l’IA générative frise le ridicule. Entre experts autoproclamés et ministres soudainement devenus visionnaires, le spectacle est affligeant. À force de buzz creux, on finit par discréditer une famille d’outils puissants et déjà essentiels en science et en ingénierie ; outils qui n’ont pas attendu la hype GPT pour exister, cf. scikit-learn

Dans la recherche scientifique, l’arrivée de TensorFlow et PyTorch a véritablement transformé le traitement des données massives issues des très grandes infrastructures de recherche. Du concret, pas du baratin creux sur fond de slides PowerPoint.

Tout ce bruit donne envie de partir sous d’autres cieux.

Mais j’avoue être très client des LLM. Technologie suffisamment avancée, magie, tout ça tout ça.

J'ai 2 GPUs dans ma machine, l'un des deux étant incompatible avec cuda compute > 6. Le serveur démarré à la main via ollama serve détecte bien le bon GPU, alors que daemon systemd détecte le vieux GPU et passe en fallback sur CPU.

Un export CUDA_VISIBLE_DEVICES=GPU-<ID DU GPU> dans .zshrc ne change rien. Argh !

Merci pour cette réponse rapide ; j'ai ajouté le user aux groupes render et video: sudo usermod -a -G render ollama, etc.

Pas de succès malheureusement.

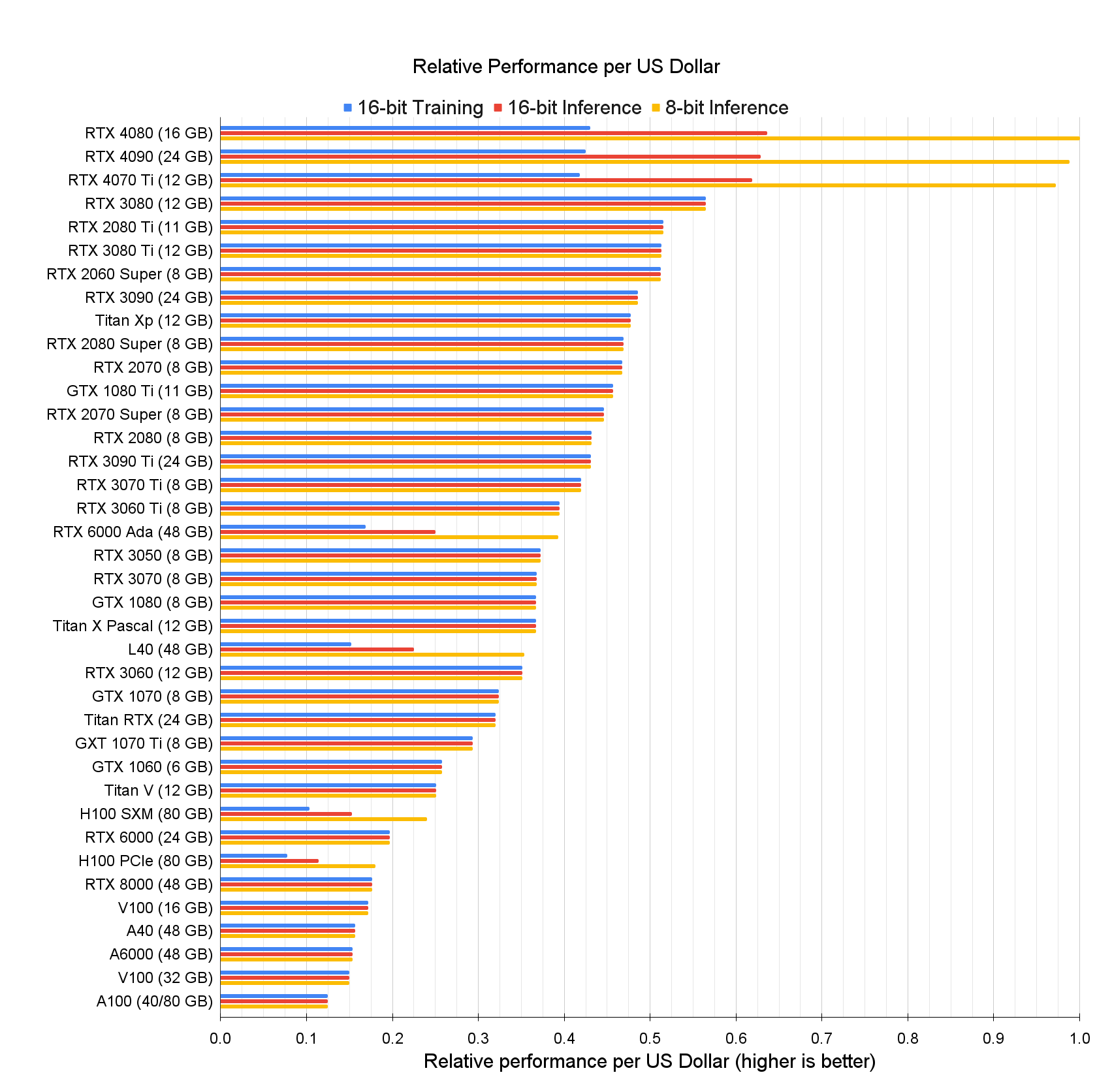

Je ne suis pas suffisamment expert en hardware pour répondre de façon affirmative à cette question. D'autant plus que la réponse va dépendre du type de calcul visé. Mais, de mon expérience sur des réseaux de neurones, j'aurais tendance à privilégier la vRAM. C'est très frustrant de ne pas pouvoir charger un modèle sur le GPU. Le graphique ci-dessous donne les modèles classés par rapport perf/prix. Donc une 4090 ou 3090.

La syntaxe c’est juste un signe inférieur et un signe supérieur.

Autres coquilles:

« Un lecteur attentif aura sans doute noté que le modèle Llama 13B (25Go) ne devrait tenir » c’est « ne devrait pas tenir »

« deux requêtes successives au même prompt varieront très fortement pour des températures élevées » devrait être « deux réponses successives au même prompt varieront très fortement pour des températures élevées »

« tracer une sinusoïde n'est pas une tâche un très complexe ». Il y a un « un » en trop.

J’ai vu que c’était possible via docker, mais je n’ai pas trouvé comment faire autrement. L’installation par défaut ne sollicite que mon CPU. Je veux bien la référence si tu l’as. Peut-être changer le modfile ?

Pour donner un style dans les réponses cela peut se faire à relativement faible coût en entraînant un LoRA (Low Rank Adapter). C’est faisable dans oobabooga. Je n’ai jamais essayé mais cela semble relativement simple.

Le second point est exactement la raison pour laquelle j’ai commencé à m’intéresser aux LLM, mais pour des questions de type scientifique. Ça a l’air plus complexe. Il est possible d’ajouter de la connaissance à un LLM via des RAG (Retrieval Augmented Generation).

Je m’interroge sur la quantité de données qu’on peut leur faire ingérer. Par ailleurs les questions de droit d’auteurs deviennent critiques car l’information n’est plus stockée dans des poids et biais, mais dans une base donnée de vecteur-tokens, donc quasiment en clair. Mais ça a l’air très utile en entreprise pour avoir un LLM qui fonctionne sur de l’information interne et en plus ça donne des références exactes de documents. Il me semble que le frontend PrivateGPT fait ça.

Si un spécialiste passe par là, je suis preneur de toute information.

Les iels, les points à la con, ça m'emmerde, c'est illisible

tu fais comme tu veux, mais vient pas pleurer si tu n'es pas lu comme tu le veux ou si ton discours ne passe pas.

C'est exactement ça le problème. C'est pas la féminisation de tel ou tel truc; personne sain d'esprit ne peut s'opposer en toute bonne foi à l'égalité entre les hommes et les femmes, à quelque niveau que ce soi (libertés, droits, travail, salaire, sécurité, santé,…). Le problème est que toutes ces fioritures ajoutées à l’existant (inventions de pronoms incompréhensibles, mettre des points au milieu des phrases, etc.) ne servent strictement à rien dans la défense de la cause féministe. Ça rend véritablement illisible, dans le sens: essaye de lire un texte écrit en inclusif à haute voix. Ça ne sert qu'à se donner, à très peu de frais, une image militante à 2 balles. C'est pratique pour s'acheter une bonne conscience et mettre de côté les vrais problèmes que rencontrent les femmes dans nos sociétés historiquement patriarcales. Ayant deux filles, j'espère que la société s'appuiera sur de vrais leviers pour faire progresser la cause des femmes plutôt que ces conneries débilitantes nourries aux réseaux sociaux états-uniens.

Même l'État Français, dont personne n'ignore la propension à l'utilisation d'artifices en carton pour se donner bonne image, a renoncé à cette débilité d'écriture inclusive.

Vous pouvez vous inscrire pour faire des tests: il est possible de générer 100 images sans abonnement.

Ou alors, pour travailler en local, installer stable diffusion. À noter qu’il existe une version graphique tournant dans un navigateur: stable diffusion webui.

Il faut un bon GPU, mais c’est à la fois très impressionnant et très amusant de lui faire générer tout et n’importe quoi.

Même chose ici. FF se met a jour tout seul indépendamment de la distro (kubuntu depuis plusieurs années) alors que c’est le paquet de la distro. J’ai jamais bien compris, mais n’étant pas compétent je me suis dis que j’avais du faire un truc pas catholique. Je me sent moins seul du coup.

Question: comme toi j’ai un userchrome.css pour virer la barre d’onglets (car j’utilise l’extension Tree Style Tab). J’ai cru voir passer quelque part que le support du userchrome allait être abandonné. As tu une info la-dessus ?

Les projets de rapprochement actuels (IDEX, Isite, etc.), qui touche toutes les universités, n'ont officiellement qu'un seul but : améliorer le classement de Shangai en regroupant des établissements, car la taille compte beaucoup dans ce classement.

Le gouvernement conditionne un gros paquet de pognon à l'obtention ces « labels » IDEX/Isite, dont les établissements dépendent, car déjà au bord de l’asphyxie budgétaire.

Très juste en effet.

Concernant ce classement, dont les biais méthodologiques sont clairement démontrés, ça me rappelle la réponse d'un collègue à un autre, lors d'une soutenance de thèse:

- mais ce modèle: il n'est pas un peu faux ?

- il est peut-être faux, mais il a le mérite d'exister et d'être simple.

Oui en effet, c'est ce que je voulais dire en écrivant que ce problème est très lié au mode de financement de la recherche par projets et l'évaluation de la recherche et des chercheurs. Les deux poussant à sur-publier, d'où l'explosion de revues médiocres et/ou prédatrices, de fraudes scientifiques, de métriques bibliographiques vides de sens (facteur d'impact par exemple) et autres joyeusetés.

Je partage ton opinion sur le classement de Shangai, à un détail près: à ma connaissance (pour les laboratoires du CNRS en tout cas) il n'est pas utilisé pour déterminer les maigres dotations récurrentes de l'état. Ça c'est en principe le travail de l'HCERES. Mais l'idée générale est la même : les différents gouvernements successifs ne font pas confiance aux instituts nationaux et préfèrent déléguer à des organismes tiers (comme l'ANR par exemple) la responsabilité de choisir quel projet va être financé, en mettant les laboratoires en compétition via des appels à projets hyper sélectifs (10% de réussite en moyenne). Ça représente des milliers d'heures de fonctionnaires perdues chaque année.

Maintenant, en informatique tout du moins, la plupart des auteurs mettent les articles à disposition. Il diffère de l'article publiée dans la revue en portant souvent la mention draft ou autre, mais c'est juste pour des raisons légales.

Absolument. Ce sont les "pre-print", c'est-à-dire la version de l'article tel qu'envoyé à l'éditeur. Pour ça, arXiv et HAL sont une bonne source également.

# Tristesse

Posté par aboulle . En réponse au journal Oseille l'IA. Évalué à 5.

Cette agitation politico-médiatique autour de l’IA générative frise le ridicule. Entre experts autoproclamés et ministres soudainement devenus visionnaires, le spectacle est affligeant. À force de buzz creux, on finit par discréditer une famille d’outils puissants et déjà essentiels en science et en ingénierie ; outils qui n’ont pas attendu la hype GPT pour exister, cf. scikit-learn

Dans la recherche scientifique, l’arrivée de TensorFlow et PyTorch a véritablement transformé le traitement des données massives issues des très grandes infrastructures de recherche. Du concret, pas du baratin creux sur fond de slides PowerPoint.

Tout ce bruit donne envie de partir sous d’autres cieux.

Mais j’avoue être très client des LLM. Technologie suffisamment avancée, magie, tout ça tout ça.

# Au revoir

Posté par aboulle . En réponse au journal KDE-Plasma, c'est fini pour moi. Évalué à 8.

Valery

[^] # Re: variable d'environnement

Posté par aboulle . En réponse au journal ollama et le GPU. Évalué à 4.

Effectivement! Ça fonctionne en ajoutant cette ligne dans la section [Service] du fichier d'unité systemd:

Merci.

[^] # Re: variable d'environnement

Posté par aboulle . En réponse au journal ollama et le GPU. Évalué à 2.

J'ai 2 GPUs dans ma machine, l'un des deux étant incompatible avec cuda compute > 6. Le serveur démarré à la main via

ollama servedétecte bien le bon GPU, alors que daemon systemd détecte le vieux GPU et passe en fallback sur CPU.Un

export CUDA_VISIBLE_DEVICES=GPU-<ID DU GPU>dans .zshrc ne change rien. Argh ![^] # Re: Goupes utilsateurs

Posté par aboulle . En réponse au journal ollama et le GPU. Évalué à 2.

Après vérification et reboot, ollama est bien dans les groupes en question:

Je vais sans doute lancer le service par un script de démarrage plutôt que par un daemon systemd.

Merci pour votre aide.

[^] # Re: Goupes utilsateurs

Posté par aboulle . En réponse au journal ollama et le GPU. Évalué à 2.

Merci pour cette réponse rapide ; j'ai ajouté le user aux groupes render et video:

sudo usermod -a -G render ollama, etc.Pas de succès malheureusement.

[^] # Re: Choix GPU

Posté par aboulle . En réponse au journal Introduction pratique aux grands modèles de langage / LLM. Évalué à 5.

Llama.cpp est compatible avec les cartes AMD via openCL. Discussion ici:

https://www.reddit.com/r/LocalLLaMA/s/hM95X972dW

[^] # Re: Choix GPU

Posté par aboulle . En réponse au journal Introduction pratique aux grands modèles de langage / LLM. Évalué à 6.

Je ne suis pas suffisamment expert en hardware pour répondre de façon affirmative à cette question. D'autant plus que la réponse va dépendre du type de calcul visé. Mais, de mon expérience sur des réseaux de neurones, j'aurais tendance à privilégier la vRAM. C'est très frustrant de ne pas pouvoir charger un modèle sur le GPU. Le graphique ci-dessous donne les modèles classés par rapport perf/prix. Donc une 4090 ou 3090.

Source: https://timdettmers.com/2023/01/30/which-gpu-for-deep-learning/

[^] # Re: il manque des mots il me semble à

Posté par aboulle . En réponse au journal Introduction pratique aux grands modèles de langage / LLM. Évalué à 2.

Merci.

« Leurs derniers modèles »

La syntaxe c’est juste un signe inférieur et un signe supérieur.

Autres coquilles:

« Un lecteur attentif aura sans doute noté que le modèle Llama 13B (25Go) ne devrait tenir » c’est « ne devrait pas tenir »

« deux requêtes successives au même prompt varieront très fortement pour des températures élevées » devrait être « deux réponses successives au même prompt varieront très fortement pour des températures élevées »

« tracer une sinusoïde n'est pas une tâche un très complexe ». Il y a un « un » en trop.

On ne se relit jamais assez…

[^] # Re: Support des GPU

Posté par aboulle . En réponse au journal Introduction pratique aux grands modèles de langage / LLM. Évalué à 3.

J’ai vu que c’était possible via docker, mais je n’ai pas trouvé comment faire autrement. L’installation par défaut ne sollicite que mon CPU. Je veux bien la référence si tu l’as. Peut-être changer le modfile ?

[^] # Re: il manque des mots il me semble à

Posté par aboulle . En réponse au journal Introduction pratique aux grands modèles de langage / LLM. Évalué à 2.

Oui j’ai vu ça. Il faudrait supprimer ce morceaux de phrase.

J’en corrige 2 autres.

Dans la phrase « Dans ce journal je me focaliserai sur des modèles optimisés pour de la génération » il manque « de code » à la fin.

« (entre les balises <) » devrait être « entre les balises <> »

[^] # Re: super article !

Posté par aboulle . En réponse au journal Introduction pratique aux grands modèles de langage / LLM. Évalué à 7.

Pour donner un style dans les réponses cela peut se faire à relativement faible coût en entraînant un LoRA (Low Rank Adapter). C’est faisable dans oobabooga. Je n’ai jamais essayé mais cela semble relativement simple.

Le second point est exactement la raison pour laquelle j’ai commencé à m’intéresser aux LLM, mais pour des questions de type scientifique. Ça a l’air plus complexe. Il est possible d’ajouter de la connaissance à un LLM via des RAG (Retrieval Augmented Generation).

Je m’interroge sur la quantité de données qu’on peut leur faire ingérer. Par ailleurs les questions de droit d’auteurs deviennent critiques car l’information n’est plus stockée dans des poids et biais, mais dans une base donnée de vecteur-tokens, donc quasiment en clair. Mais ça a l’air très utile en entreprise pour avoir un LLM qui fonctionne sur de l’information interne et en plus ça donne des références exactes de documents. Il me semble que le frontend

PrivateGPT fait ça.

Si un spécialiste passe par là, je suis preneur de toute information.

# Argh

Posté par aboulle . En réponse au journal Is return the new goto ?. Évalué à -5.

Quand je vois ça :

je me souviens pourquoi j’aime Python…

# Loi de Brandolini

Posté par aboulle . En réponse au journal le plus grand scandale sanitaire de tous les temps, c'est maintenant !. Évalué à 10.

Chers dlfpiens,

en vertu de la loi de Brandolini, j'ose émettre l'hypothèse que vous perdez votre temps :-)

# Flatseal

Posté par aboulle . En réponse au journal "dérives sécuritaires" : inconvénients des flatpacks, snap ou environnements sandbox.. Évalué à 10.

J’ai rencontré un problème similaire avec Flatpak il y a quelques temps. J’ai trouvé flatseal qui permet de modifier les permissions des paquets.

[^] # Re: que ce texte est long pour ne rien dire.

Posté par aboulle . En réponse au journal L’écriture inclusive sur linuxfr.org est-elle un crime ?. Évalué à 0.

Pas bête. Je vais tenter l’expérience ;-)

[^] # Re: que ce texte est long pour ne rien dire.

Posté par aboulle . En réponse au journal L’écriture inclusive sur linuxfr.org est-elle un crime ?. Évalué à 10.

C'est exactement ça le problème. C'est pas la féminisation de tel ou tel truc; personne sain d'esprit ne peut s'opposer en toute bonne foi à l'égalité entre les hommes et les femmes, à quelque niveau que ce soi (libertés, droits, travail, salaire, sécurité, santé,…). Le problème est que toutes ces fioritures ajoutées à l’existant (inventions de pronoms incompréhensibles, mettre des points au milieu des phrases, etc.) ne servent strictement à rien dans la défense de la cause féministe. Ça rend véritablement illisible, dans le sens: essaye de lire un texte écrit en inclusif à haute voix. Ça ne sert qu'à se donner, à très peu de frais, une image militante à 2 balles. C'est pratique pour s'acheter une bonne conscience et mettre de côté les vrais problèmes que rencontrent les femmes dans nos sociétés historiquement patriarcales. Ayant deux filles, j'espère que la société s'appuiera sur de vrais leviers pour faire progresser la cause des femmes plutôt que ces conneries débilitantes nourries aux réseaux sociaux états-uniens.

Même l'État Français, dont personne n'ignore la propension à l'utilisation d'artifices en carton pour se donner bonne image, a renoncé à cette débilité d'écriture inclusive.

[^] # Re: À ce propos...

Posté par aboulle . En réponse au journal Art généré par IA. Évalué à -1.

Anéfé

# Stable diffusion

Posté par aboulle . En réponse au journal Art généré par IA. Évalué à 8.

Ou alors, pour travailler en local, installer stable diffusion. À noter qu’il existe une version graphique tournant dans un navigateur: stable diffusion webui.

Il faut un bon GPU, mais c’est à la fois très impressionnant et très amusant de lui faire générer tout et n’importe quoi.

# Plus un

Posté par aboulle . En réponse au journal merci yunohost (mais pas que) !. Évalué à 10.

Je plussoye. Yunohost, sa facilité de s’auto-héberger et son écosystème de modules simples à installer, ça roxe.

A+

# Pareil

Posté par aboulle . En réponse au journal MAJ Firefox automatique : Mozilla veut-il faire fuir ses utilisateurs ?. Évalué à 4.

Même chose ici. FF se met a jour tout seul indépendamment de la distro (kubuntu depuis plusieurs années) alors que c’est le paquet de la distro. J’ai jamais bien compris, mais n’étant pas compétent je me suis dis que j’avais du faire un truc pas catholique. Je me sent moins seul du coup.

[^] # Re: Userchrome.css

Posté par aboulle . En réponse au journal nouvelle interface pour Firefox 89. Évalué à 3.

Et vivaldi également (mais basé sur chromium).

# Userchrome.css

Posté par aboulle . En réponse au journal nouvelle interface pour Firefox 89. Évalué à 9.

Question: comme toi j’ai un userchrome.css pour virer la barre d’onglets (car j’utilise l’extension Tree Style Tab). J’ai cru voir passer quelque part que le support du userchrome allait être abandonné. As tu une info la-dessus ?

[^] # Re: Publications, open-access, open-science

Posté par aboulle . En réponse au journal Journaux scientifiques en libre accès et foutoir avec les licences libres. Évalué à 4.

Très juste en effet.

Concernant ce classement, dont les biais méthodologiques sont clairement démontrés, ça me rappelle la réponse d'un collègue à un autre, lors d'une soutenance de thèse:

- mais ce modèle: il n'est pas un peu faux ?

- il est peut-être faux, mais il a le mérite d'exister et d'être simple.

-> imparable.

[^] # Re: Publications, open-access, open-science

Posté par aboulle . En réponse au journal Journaux scientifiques en libre accès et foutoir avec les licences libres. Évalué à 10.

Oui en effet, c'est ce que je voulais dire en écrivant que ce problème est très lié au mode de financement de la recherche par projets et l'évaluation de la recherche et des chercheurs. Les deux poussant à sur-publier, d'où l'explosion de revues médiocres et/ou prédatrices, de fraudes scientifiques, de métriques bibliographiques vides de sens (facteur d'impact par exemple) et autres joyeusetés.

Je partage ton opinion sur le classement de Shangai, à un détail près: à ma connaissance (pour les laboratoires du CNRS en tout cas) il n'est pas utilisé pour déterminer les maigres dotations récurrentes de l'état. Ça c'est en principe le travail de l'HCERES. Mais l'idée générale est la même : les différents gouvernements successifs ne font pas confiance aux instituts nationaux et préfèrent déléguer à des organismes tiers (comme l'ANR par exemple) la responsabilité de choisir quel projet va être financé, en mettant les laboratoires en compétition via des appels à projets hyper sélectifs (10% de réussite en moyenne). Ça représente des milliers d'heures de fonctionnaires perdues chaque année.

Absolument. Ce sont les "pre-print", c'est-à-dire la version de l'article tel qu'envoyé à l'éditeur. Pour ça, arXiv et HAL sont une bonne source également.