Sommaire

-

- Ma passion C++11, C++14, C++17…

- Comprendre le client et développer vite

- Intégrer l’utilisateur final dans son équipe

- Faire des sprints d’une journée

- Le C++ ne serait donc pas la panacée ?

- WebSocket en Python

- WebSocket en C++

- La compilation C++ est archaïque

- Construction logicielle C++

- Générateurs de configuration pour la construction logicielle C++

- Autres outils de construction logicielle C++

- Gestion de dépendances en C++

- Copier les dépendances dans son code source

- Microsoft me fait perdre deux jours

- Allez, on empaquette soi-même cette bibliothèque

- CMake gagne, Meson rentre à la maison

- Échec C++

- WebSocket en Node.js

- WebSocket en Go

- Valoriser l'échec

- Enseignements sur les langages

- Louanges sur la simplicité

- Je continue d’aimer le C++

- On embauche

Je profite de cette anecdote pour rédiger un long journal afin de partager mon expérience et mon apprentissage en espérant t’apprendre de nouveaux points de vue.

Peut-être cela vaut le coup d'en faire une dépêche… Dis-le moi dans les commentaires. 😉

Ma passion C++11, C++14, C++17…

Ma carrière professionnelle de développeur C a débuté en 1994 et j’ai naturellement adopté avec enthousiasme le C++ en 1999.

J’étais un développeur C++ heureux et j'avais considéré la nouvelle version du standard C++11 juste comme une évolution tant attendue.

Mais en 2015, je réalise enfin à quel point C++11 a révolutionné l’écosystème C++ et ses bouleversements dans l’état d’esprit de la communauté C++.

Je me passionne alors pour C++11, C++14 puis C++17, je m’implique beaucoup, je deviens un référent pour mes collègues, je donne des conférences sur le C++, j’organise des Meetups à Paris, je publie de nombreux articles C++ sur LinuxFr.org…

Comprendre le client et développer vite

Cependant, en 2018, une expérience change radicalement ma façon d’appréhender le développement logiciel.

À cette époque, une équipe C++ se retrouve surchargée et ne peut implémenter toutes les fonctionnalités attendues.

On réfléchit à une solution de secours, et me voilà chargé de développer une application en Python en intégrant des briques sous licence libre.

Je travaille alors en étroite collaboration avec les utilisateurs finaux et on sort l’application en quelques mois.

Ma nouvelle vision :

Il y a plus important que la technologie,

c’est de se mettre dans la peau du client final

et de comprendre ses frustrations au quotidien.

Et on y arrive mieux en intégrant l’utilisateur final

dans son équipe de développement.

L’application bricolée en Python donne entièrement satisfaction.

Les utilisateurs sont contents d’avoir eu très tôt leur outil, et cela a coûté moins cher par rapport à toute une équipe C++ dans sa tour d’ivoire.

Intégrer l’utilisateur final dans son équipe

Attention, je ne dénigre pas le C++, celui-ci peut être une bonne solution face à de nombreuses problématiques.

Mais avant de courir tête baissée, s’assurer que la technologie choisie répondra bien aux attentes non exprimées de l’utilisateur final.

J’écris « attentes non exprimées" car bien souvent le développeur se base sur sa propre interprétation

d’un document présenté comme LA spécification qui a en plus été rédigée par un intermédiaire (MOA, MOE, Business Analyste, Product Owner, Architecte…)

Nous l’avons peut-être déjà tous constaté, l’utilisateur final ne sait pas vraiment ce qu’il veut, et a beaucoup de difficulté à exprimer clairement par écrit ses attentes.

Un intermédiaire (MOA, MOE, BA, PO, Archi) est nécessaire pour lui permettre de prendre du recul

et pour traduire une demande fonctionnelle en exigence technique.

Mais l’intermédiaire rajoute une couche intermédiaire !

C’est humain, l’intermédiaire aura tendance à se rendre indispensable.

Et sans le faire exprès, l’intermédiaire évitera que développeurs et utilisateurs échangent en direct.

Le top est d’avoir l’utilisateur final dans son équipe de développement, même si ce n’est pas dans le même bureau. Avec les habitudes de travail à distance, développeurs et utilisateur peuvent clavarder (chat) régulièrement.

Faire des sprints d’une journée

La durée idéale d’un sprint c’est la journée.

Le matin on échange rapidement avec le client de ce que l’on pourrait faire, on s’attelle à la tâche, on livre, l’utilisateur peut tester, on re-livre…

Et, en fin de journée, on débriefe très rapidement.

L’intérêt du Python (par rapport au C++) dans ce mode de fonctionnement c’est la livraison :

on peut se permettre de livrer directement le code source et hop l’utilisateur exécute l’application !

Ainsi, dans mon cas, quand l’utilisateur lançait le démarrage de l’application, la branche master du dépôt Git était automatiquement mise à jour.

J’essayais quand même de le prévenir quand une nouvelle version était sur la branche master.

La joie de livrer souvent, rapidement, et d’avoir du feed-back dans la foulée :-)

Le C++ ne serait donc pas la panacée ?

Nous pourrions caricaturer :

- En C++, le développement est lent, mais l’application est très rapide ;

- En Python, le développement est rapide, mais l’application est très lente. ¹

¹ Utiliser Pythran/PyPy/Cython/Numba/… accélère l’exécution, mais cela ralentit le développement : compilation plus lente, développement plus complexe, bug difficile à investiguer…

Bien souvent, le client final a besoin rapidement d’une fonctionnalité, même si l'exécution n'est pas super optimisée.

En livrant rapidement cette fonctionnalité, le client gagne en maturité et a de nouvelles idées, de nouvelles façons pour optimiser son travail… et ainsi de suite avec des itérations courtes.

WebSocket en Python

Pour une application existante, nous avons besoin de fournir une interface WebSocket basique afin que nos clients puissent accéder à un service de Souscription/Publication.

Je développe la fonctionnalité en utilisant Python et Socket.io.

Les tests JavaScript sont concluants.

Cependant, nous nous apercevons que Socket.io rajoute son protocole par-dessus le protocole WebSocket.

Nous allons donc forcer les clients à devoir utiliser Socket.io ce qui n’est pas acceptable.

Nous voulons offrir une simple WebSocket afin que le client ne soit pas enfermé dans une technologie et soit libre d’implémenter son logiciel comme il le souhaite.

Je m’oriente alors vers WAMP avec Autobahn…

Mais rebelote le P dans WAMP signifie Protocol.

Pour ne pas réinventer la roue, je cherche alors une solution qui implémente déjà la fonctionnalité Souscription/Publication et idéalement avec des coroutines (async et await).

WebSocket en C++

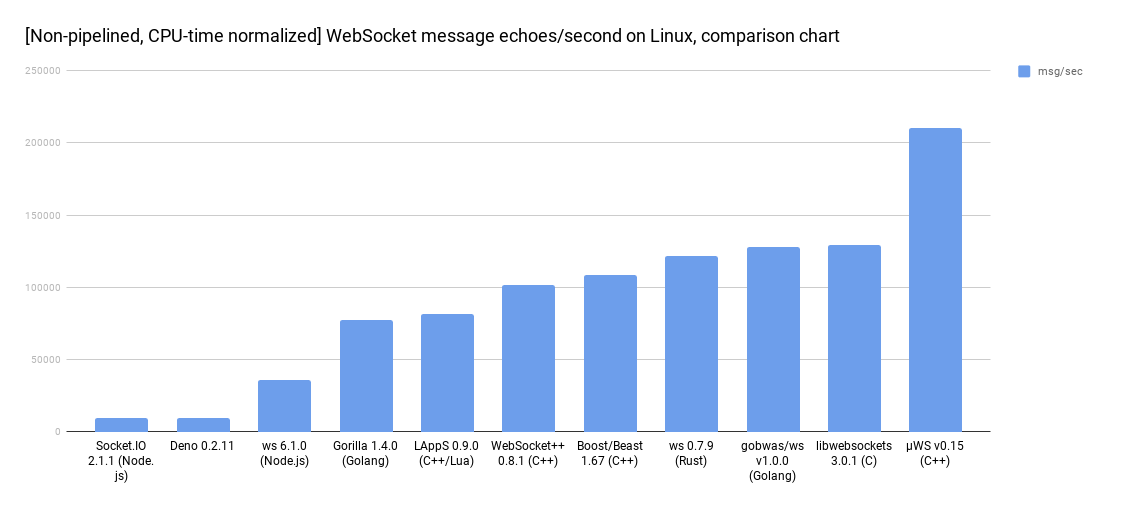

C’est alors que je découvre uWebSockets (µWS), une implémentation C++17 à couper le souffle qui intègre la fonctionnalité Souscription/Publication tout en conservant le protocole WebSocket de base. \o/

Mon équipe est enthousiaste. Je clone le projet, j’adapte un exemple C++ à nos besoins et je présente un résultat convainquant. C’est agréable de compiler un projet C++ qui ne tire pas des dizaines de dépendances :-)

Je précise que pour ce nouveau projet, je viens de rejoindre une autre organisation, et j’ai été embauché, en partie, pour mes connaissances pointues en C++17.

La compilation C++ est archaïque

En Python, Node.js, Ruby, Go, Rust on a pip, npm, gem, go-get, cargo qui simplifie le téléchargement des dépendances, et l’intégration au projet avec un import xxxx. De plus, certains IDE prennent en charge cette gestion des dépendances.

En C++, la gestion des dépendances et leur compilation ne sont pas standardisées. En fait, cela n’a pas beaucoup évolué depuis les origines : le C++ a 40 ans et se compile toujours dans le même esprit que le C qui a lui 60 ans.

Pour cela, nous avons le choix du compilateur, dont voici une sélection avec leurs dates de naissance :

-

GCC et son

g++(GNU, libre, 1987-2019) -

LLVM et son

clang++(Apple, libre, 2007-2019) -

AOCC et son

clang++(AMD, libre, 2017-2018) -

ICC et son

icc(Intel, non-libre, ????-2018) -

MSVC et son

cl(Microsoft, non-libre, 1993-2019) -

C++Builder et son

bcc64(Embarcadero, non-libre, 1997-2019)

Construction logicielle C++

Pour la construction logicielle (build), nous avons une dizaine d’outils pour nous abstraire du compilateur, en voici une petite sélection sous licence libre :

-

makeet sonMakefile -

Ninja et son

build.ninja -

Jam remplacé par Boost.build et leur

Jamfile - SCons et sa configuration en Python

- Waf qui ambitionne de remplacer SCons

Générateurs de configuration pour la construction logicielle C++

Et pour nous abstraire de ces outils de construction logicielle, nous utilisons des générateurs de configuration de build, dont voici des projets toujours actifs :

-

Autotools génère du

Makefile -

CMake génère

Makefile,build.ninjaet les fichiers projet pour de nombreux IDE - Premake en cours de réécriture active depuis une dizaine d’années

-

xmake génère

Makefileet les fichiers projet pour quelques IDE -

Meson génère

build.ninjaet est compatible avec quelques IDE

Autres outils de construction logicielle C++

Avec les outils ci-dessus, le build et les tests de non régression d’une importante application C++ peut parfois prendre une demi-journée.

C’est beaucoup trop pour attendre si ce que l’on a implémenté est correct !

D’autres outils de construction logicielle ont donc été développées dans le but de builder/tester en un minimum de temps :

- Bazel codé en Java et géré/financé par Google

- Buck codé en Java et géré/financé par Facebook

- Pants codé en Python et géré par une communauté

- Please codé en Go et géré/financé par Thought Machine

Ces projets ne réutilisent pas les outils de build cités plus haut, et ne génèrent pas les fichiers projet des IDE.

Par contre, ces outils analysent finement le graphe de dépendance, gèrent de gros dépôts de code source,

parallélisent la construction logicielle sur tous les cœurs (CPU) de nombreuses machines (cloud).

Les étapes du build sont mémoïsées pour éviter de refaire la même opération N fois (par exemple, pour éviter de compiler un fichier non modifié, ou de linker une bibliothèque inchangée).

Sans avoir à recourir à ces outils, on peut améliorer les temps de compilation C++ et d’édition de liens (link) avec ces deux bons vieux outils :

-

ccachepour éviter de recompiler (ou linker) un fichier inchangé -

distccpour distribuer le build sur plusieurs machines (voir aussi icecream)

Ces outils ccache et distcc sont pris en charge par CMake, SCons…

Gestion de dépendances en C++

Mais au fait, comment gérer les dépendances C++ ?

Quel est le gestionnaire de paquets C++ officiel ? (package manager)

Quel est l’équivalent C++ pour les commandes pip, npm, gem, go-get et cargo ?

Eh bien… disons que nous avons des initiatives encourageantes :

- Le groupe de travail SG15 (du comité de standardisation du C++) réfléchit à une nouvelle approche pour compiler le C++ (voir leurs propositions P1482 et P1484 en anglais) ;

- Le projet build2 est très bien pensé et dont son auteur avait proposé de standardiser arborescence des projets C++ avec P1204 ;

- Le projet conan utilise une configuration en Python et propose déjà 600 paquets C++ disponibles sur les deux dépôts publics principaux (conan-central et bincrafters)

- Le projet vcpkg se base sur CMake et propose 1000 paquets C++ dont une bonne partie sont compatibles Windows, GNU/Linux et macOS

- Le projet Hunter se base également sur CMake et propose environ 300 paquets C++

Attention à ne pas confondre l’exécutable b du projet build2 avec l’exécutable b2 du projet Boost.build cité plus haut.

Copier les dépendances dans son code source

Une autre façon de gérer très simplement ses dépendances C++ est de carrément copier le code source de celles-ci (et aussi le code source des dépendances des dépendances) avec le code source de l’application. Ça compile toujours.

Mais ce n’est pas une bonne pratique pour, au moins, deux raisons :

- Respecter les licences libres, c’est avant tout éviter de mélanger des codes sources de licences et d’auteurs différents

- Mixer les codes source complique leur mise à jour (par exemple, comment intégrer la correction d’une faille de sécurité ?)

Microsoft me fait perdre deux jours

Je teste différents moyens pour obtenir le paquet uWebSocket : le package manager de ma distribution, Conan, Hunter… et finalement, le paquet uWebSocket a fraîchement été intégré au dépôt vcpkg. Je teste, et, au miracle, cela télécharge le code source et me l’installe sur ma distribution GNU/Linux !

L’outil vcpkg fonctionne avec CMake, donc ce sera CMake qui gérera la construction logicielle.

Le temps de se documenter et bien prendre en main vcpkg, de tenter une intégration dans mon CMakeLists.txt, d’échouer, de recommencer…

Pourtant l’exemple avec SQLite3 fonctionne chez moi… Arg… En fait, c’est mal empaqueté, le find_package() ne pourra jamais trouver la bibliothèque uWebSocket fournie par vcpkg.

J’essaye de le faire moi-même. Puis, je me rends compte au second jour que vcpkg est un outil amateur, a ne surtout pas utiliser pour aller en production : pas de version des dépendances, impossible de décider des options de compilation des dépendances…

Allez, on empaquette soi-même cette bibliothèque

Bon, je connais bien C++, alors empaqueter proprement une bibliothèque qui ne dépend de rien ne devrait pas poser problème.

Je retrousse mes manches et je commence à chercher si quelqu’un a déjà empaqueté uWebSockets…

Je trouve surtout que le mainteneur principal a supprimé les fichiers CMakeLists.txt et meson.build en 2017.

Et celui-ci semble envoyer bouler les contributeurs proposant la compatibilité avec CMake, supprime le titre des Pull Request et on trouve même des commentaires supprimés.

On trouve une explication dans la FAQ :

I don't accept any specific build systems because I know from experience that doing so opens up hell. People simply cannot agree on which build system to use, or even how to use one particular build system.

That's why I no longer accept any such PRs. I've had too many CMake PRs dragging in completely different directions to know this is the only solution.

You'll have to clone the repo and create a new project in whatever build system you want to use.

En gros, le mainteneur principal refuse tout système de construction logicielle, car les développeurs veulent utiliser différents outils et que pour un même outil, les développeurs ne se mettent pas d’accord de la bonne façon de faire.

Un commit très étonnant est le Not my problem qui change la licence et remplace dans tous les fichiers la ligne :

Copyright 2018 Alex Hultman and contributors.

par:

Authored by Alex Hultman, 2018-2019.

Intellectual property of third-party.

CMake gagne, Meson rentre à la maison

Mon IDE préféré pour le C++ est QtCreator, mais celui-ci ne prend pas encore en charge Meson. Et je n’ai plus beaucoup de temps pour prendre en main GNOME Builder.

Et j’obtiens un joli CMakeLists.txt qui fonctionne sur deux différentes distributions GNU/Linux et aussi sur GitLab.

Je me rends aussi compte que GCC-8 ne compile pas cette bibliothèque, et que nous devons utiliser seulement Clang.

Mais, mon plus gros problème est que je n’arrive plus à faire compiler cette bibliothèque par QtCreator, alors qu’avec la ligne de commande cela fonctionne parfaiement… Arg… J’investigue encore du temps…

Échec C++

Mes collègues ne comprennent pas pourquoi je mets autant de temps pour faire l’équivalent d’un pip install en C++. De plus, je vais devoir refaire ce même travail dès que j’intégrerai les autres bibliothèques : base de donnée, file d’attente de message, journalisation…

Nous décidons ensemble d’arrêter de s’obstiner, de relever la tête, et de lister les possibilités :

- Continuer l’intégration de uWebSockets avec CMake

- Utiliser seulement les paquets Conan ou Hunter comme

boost::beastpour la websocket (c’est même disponible avecapt install) - Revenir sur le Python et implémenter la Souscription/Publication

- Passer sur Node.js et intégrer la bibliothèque C++ uWebSockets avec la simplicité de

npm(uWebSockets.js) - Prendre le virage Rust, seul rival au C++ avec la simplicité de

cargo - Go to the langage Go qui est simple comme Python et est une des technos les plus performantes

WebSocket en Node.js

J’ai plusieurs collègues très compétents en Node.js, alors c’est parti. Effectivement, l’installation de la dépendance est très simple et on implémente rapidement l’application.

Le grand avantage de Node.js (et de JavaScript en général) est la taille de la communauté et l’esprit de partage et d’innovation incroyables. Alors qu’il est nécessaire d’une décénie en C++ pour se décider, la communauté JavaScript décide en quelques mois. Les projets, les concepts de programmation, les méthodes de travailler ne cessent d’évoluer.

J’entre dans un vaisseau qui se déplace à la vitesse de la lumière. En C++, la durée de vie d’un projet peut être d’une dizaine d’années. En Node.js, c’est plutôt 10 mois. C’est aussi l’inconvénient, il faut s’adapter vite.

Mais, nous nous apercevons que le projet uWebSockets.js ne prend pas en charge la Souscription/Publication de la bibliothèque sous-jacente uWebSockets. Ça ne marche pas.

Stop, nous venons de gagner en maturité, voyons voir les possibilités :

- Node.js (implémenter la Souscription/Publication en JavaScript…)

- Rust

- Go

WebSocket en Go

Nous prennons concience que la partie WebSocket risque d’être un point sensible au niveau performance. Finalement, nous mettons entre parenthèses notre tentative Node.js.

Le Rust est encore trop jeune (peu de développeurs maîtrisant Rust sur le marché). Et nous avons un collègue devops fan du Go.

Notre collègue maîtrisant Go n’étant pas très disponible, on apprend se débrouille seul. Finalement, le principal du langage Go s’acquiert en quelques heures de programmation. Le test WebSocket est un succès et nous implémentons une première version basique de la Publication/souscription en Go.

Nous mettrons en place des tests de performance reproductibles, et seulement après nous pourrons décider quelles sont les parties qui nécessitent d’être optimisées.

Valoriser l'échec

- C'est grâce à nos échecs successifs que nous avons pu trouver notre solution pour les WebSockets

- Nous aurions pu décider qu'il fallait éviter les échecs

- Mais nous avons plutôt chercher à se planter car l’échec est un très bon moyen d’apprendre (de ses erreurs)

- Se planter plus rapidement/souvent permet donc d’apprendre plus vite/souvent

- Donc, essayons d'augmenter nos échecs (car c'est augmenter notre apprentissage)

- Pour encourager à tester une idée, nous devons valoriser l'échec

- Tester simplement/rapidement une idée permet de gagner en maturité

Enseignements sur les langages

- Ce n’est pas une bonne idée de coder dans son langage de programmation (C++) quand on est le seul dév. de l’organisation qui connaisse ce langage

- JavaScript et Node.js ça décoiffe

- Go c’est vraiment simple (car c’est limité)

Louanges sur la simplicité

- La simplicité permet de se concentrer sur l’essentiel

- Faire simple est souvent compliqué

- Avoir une IT simple permet d’intégrer de nouvelles contraintes/idées plus facilement

- Dans un monde de plus en plus concurrentiel et qui s’accélère, la simplicité évite de se perdre dans le brouillard

Je continue d’aimer le C++

Mais, non, je n’abandonne pas le C++ !

J’apprécie d’acquérir de nouvelles cordes à mon arc,

de m’ouvrir l’esprit sur de nouvelles pratiques.

Certaines technologies sont plus adaptées à certains contextes.

N’ayons pas de dogme, choisissons la bonne techno selon la situation.

Cependant, je ne sais pas quand je coderai à nouveau en C++…

Peut-être quand on aura un C++ package manager standardisé… :-)

On embauche

Un peu de publicité : Tu apprécies cet état d’esprit et que tu aimes coder en Python, Node.js, JavaScript/TypeScript/Angular ou Go ? N’hésite pas à me contacter sur oli (à) Lmap (point) org. Nous avons des postes à Paris et à Metz. On peut s’arranger pour le télétravail. Pour le moment, on ne publie rien sous licence libre. Mais je pousse pour libérer quelques briques intéressantes…

# Et par rapport au C ?

Posté par AlexTérieur . Évalué à 8.

N'étant que développeur amateur et ayant appris et déjà programmé en C, je vois défiler ici une quantité de journaux sur le C++. J'ai eu tenté d'apprendre le C++ mais j'ai très vite déchanté devant sa complexité. Quelqu'un pourrait-il m'expliquer les différences entre C et C++ qui justifieraient de passer au C++ ?

[^] # Commentaire supprimé

Posté par Anonyme . Évalué à 3.

Ce commentaire a été supprimé par l’équipe de modération.

[^] # Re: Et par rapport au C ?

Posté par Jérôme Flesch (site web personnel) . Évalué à 10.

À vue d'œil:

(PS: J'ai 10 ans de C derrière moi, mais clairement pas autant en C++)

[^] # Re: Et par rapport au C ?

Posté par Nicolas Boulay (site web personnel) . Évalué à 4.

Passer à C++ serait pour utiliser Qt ? Cela serait ma principal motivation. La deuxième serait un besoin énorme de performance et devoir jouer avec le SIMD, les directive OpenMP, gérer finement la mémoire( même si Rust fait mieux).

"La première sécurité est la liberté"

[^] # Re: Et par rapport au C ?

Posté par El Titi . Évalué à 9.

Certains te l'ont déjà évoqué mais la principale motivation pour passer au C++ est le support du paradigme objet.

De base le C n'est qu'un langage procédural. Lorsque tu programmes dans certains domaines l'approche objet est assez "naturelle".

Même si c'est théoriquement possible avec le C tu te retrouves très vite limité par le langage. Si tu es intéressé cet ouvrage est fait pour toi: https://www.cs.rit.edu/~ats/books/ooc.pdf)

Simuler un héritage rudimentaire et le polymorphisme à base de "cast" est à peu près tout ce que tu peux atteindre, simplement.

Au delà tu réinventes tellement de truc qu'il vaut mieux se poser la question de savoir s'il ne faut pas passer à autre chose. C'est la vocation de C++ et d'ObjectiveC

Avec le C++ tu auras automatiquement:

* la redéfinition des méthodes, statiques ou virtuelles (bon courage avec les pointeurs de fonction dans tes structures en C)

* l'héritage multiple

* La généricité qui te permet d'instancier de nouveaux types abstraits

* la surcharge des opérateurs ainsi que de nouveaux (>>)

…

Il y aussi tous les frameworks autours qui peuvent te faciliter la vie (ramasse-miette, …)

Tu as une belle base de comparaison aujourd'hui avec les 2 toolkits graphiques mainstream sur Linux: GTK ecrit en C prouve que c'est possible. Qt a fait le choix de s'appuyer sur le C++ et déborde largement le cadre de l'interface graphique aujourd'hui.

C'est donc à toi d'évaluer ton besoin sachant que ça peut-être superflu. Par exemple le multi-héritage a aussi ses inconvénients et on peut s'en passer simplement avec la notion d'interfaces. Java est là pour en attester. (Et je n'aborde pas les design pattern, composition vs héritage, …)

De même l'approche objet ne résout pas tout. Aujourd'hui, le paradigme fonctionnel revient en force et on s'appuie aussi beaucoup sur la programmation par aspect pour compléter l'approche objet de manière orthogonale (Spring AOP en java, …).

En revanche si tu n'appréhendes pas la programmation objet et que tu veux comprendre, je ne suis pas certain que le C++ soit le langage le plus adapté étant donné sa complexité. GTK est peut-être un 1er point d'entrée pour ça.

Mais il vaut peut-être mieux aussi commencer par des langages plus simple et plus productifs (l'auteur m'en est témoin) comme le Ruby (pur objet) et le python (qui prend quelques libertés avec le duck typing par exemple) et qui offrent en plus l'avantage d'être multi-paradigme et moins contraignants au début de par leur typage dynamique .

A partir de là, peut-être que l'abord du C++ sera moins rugueux.

[^] # Re: Et par rapport au C ?

Posté par Gof (site web personnel) . Évalué à 4.

Le C++ est peut être plus complexe, mais il n'est pas plus compliqué que le C.

Par exemple, le Brainfuck est extrêmement simple (seulement 8 instruction à apprendre en 2 minutes), mais il est en fait très compliqué de faire des programmes avec.

Le C++ demande peut être un peu plus d'apprentissage, mais permet de faire des programmes plus facilement qu'en C.

[^] # Re: Et par rapport au C ?

Posté par dinomasque . Évalué à 4.

Je me souviens de mon partiel de C++ à la fac il y a >15ans et notamment d'un délicieux exercice sur les supplices syntaxiques du langage.

Je me dis que C++ a du être une belle source d'inspiration pour Brainfuck ;-)

BeOS le faisait il y a 20 ans !

[^] # Re: Et par rapport au C ?

Posté par Gof (site web personnel) . Évalué à 3.

Il me semble que tu n'as pas compris ce que je voulais dire alors je vais essayer de mieux expliquer.

Brainfuck justement à une syntaxe très simple et très facile à apprendre. Chacune des huit instructions s'explique en une phrase. Après deux minute tu es un expert dans le langage. Un expert ? Pas vraiment, car la difficulté du langage n'est pas dans la syntaxe, mais dans son utilisation.

C++ a peux être une syntaxe qui prends un chouia plus de temps à apprendre, mais, en pratique, est plus facile d'utilisation que le brainfuck, et que le C, pour faire des programmes.

Quand à ton partiel à la fac, n'importe quel professeur peux te faire des délicieux exercices sur la syntaxe de n'importe quel langage s'il le veux. Chaque langage à ses coins difficiles et ses subtilités. Mais il n'est pas non plus nécessaire de connaître touts les recoins les plus reculés d'un langage pour pouvoir écrire et lire des programmes en pratique.

[^] # Re: Et par rapport au C ?

Posté par barmic . Évalué à 9.

Ce n'est pas si compliqué, sa notoriété est galvaudée. C'est juste une syntaxe embêtante. Malbolge est vraiment complexe.

[^] # Re: Et par rapport au C ?

Posté par Nucleos . Évalué à 1.

Ton message m'a fait chercher d'autres exemples… Et je suis tombé sur une belle liste Wikipedia de langages de programmation exotique

# L'herbe est toujours plus verte dans le pré du voisin

Posté par Zenitram (site web personnel) . Évalué à 10.

bah… Pas toujours en effet, mais bon à chaque fois que j'ai eu à me taper un autre langage au bout d'un moment j'en ai vu des limites, des galères (entre autre les perfs!), des incompatibilités dans le temps (le passage de Python 2 à 3 a été quand même bien laborieux), des changements de mode etc… Au final avec mon code C++ j'ai quand même l'impression que je peux l'adapter à de nouvelles plate-formes plus facilement, le code traverse le temps plus facilement, après faut avoir besoin de ce "fonctionnalité".

Bref, effectivement il y a des trucs gavant en C++ mais l'herbe est toujours plus verte dans le pré du voisin (tant qu'on n'y a pas goutté donc), c'est surtout une question de goût des membres de l'équipe plutôt que de choix rationnels.

Si déjà on pouvait commencer par des repos Linux standardisés… Ha ben non, ça vit et personne n'arrive à se mettre d'accord, on a toujours rpm vs deb vs arch vs etc! Bref, ce n'est pas unique à C++ (mais oui, ça me gonfle ce manque).

Ca, c'est un bon point! Dommage que tu ne cherches pas de dev C++, j'aurai peut-être postulé ;-).

# Commentaire supprimé

Posté par Anonyme . Évalué à 10.

Ce commentaire a été supprimé par l’équipe de modération.

[^] # Re: Oui, mais non

Posté par Colin Pitrat (site web personnel) . Évalué à 7.

Vu comme tu décris ton expérience avec Agile, je pense que ça s'est passé pour toi de la même manière que pour moi dans ma boîte précédente. Un dinosaure de l'informatique (ta boîte pas toi) voit la mode de l'Agile et se dit "tout le monde fait ça, il faut faire pareil". Alors ils collent le mot Agile sur tout et n'importe quoi.

Si le client n'est pas impliqué dans le projet, si il ne teste pas régulièrement (je dirais 1 fois par semaine au moins) les délivrables pour faire des retours et changer l'orientation de l'équipe, ce n'est pas de l'Agile et il y'a peu de chances qu'il en ressorte quoi que ce soit de positif.

[^] # Re: Oui, mais non

Posté par totof2000 . Évalué à 5.

A mon avis c'est comme ça pour plus de la moitié des boites qui disent être agiles : pour elles lorsqu'elles ontpassé le délai de mise à disposition d'une nouvelle appli de 6 mois à 4 mis, elles peuvent se prétendre agile.

[^] # Re: Oui, mais non

Posté par barmic . Évalué à 3.

C'est surtout une agilité mal maîtrisée, il me semble. L'idée principal de l'agilité c'est d'avoir une boucle de rétroaction sur la façon de travailler d'une équipe. Pour ça, une façon de faire (celle de scrum) est de mettre en place des segments courts (les sprints) que l'on évalue via les rétrospectives. Mais ce n'est pas la seule façon.

Se concentrer sur les outils (trello, des post-it, jira, whatever) ce n'est pas agile du tout :)

Donc vous n'avez pas de documentation, ok. Ça ce n'est pas la faute de l'agilité, comment vous faites pour vous en sortir sans ? L'agilité peut justement donner des clef sur comment se débrouiller sans documentation (la mise en place de démo pour échanger sur une fonctionnalité, d'autres types de réunions comme l'eventstorm peuvent aussi aider).

Mon point ce n'est pas qu'il faut forcément faire de l'agile, juste reprendre ton point pour donner des pistes sur comment ça aurait pu mieux se passer pour vous.

[^] # Commentaire supprimé

Posté par Anonyme . Évalué à 6.

Ce commentaire a été supprimé par l’équipe de modération.

[^] # Re: Oui, mais non

Posté par barmic . Évalué à 4. Dernière modification le 03 juin 2019 à 10:33.

Tu dis « l'agilité ça ne marche pas chez nous à cause de la doc », c'est qu'il y a bien un moment où quelque chose à fonctionné. Sinon tu n'a aucune idée de si c'est l'agilité qui n'a pas fonctionné ou juste vous qui êtes une équipe de shadoks (rien de personnel).

Si rien n'a jamais fonctionné, alors oui c'est qu'on vous a vendu l'agilité comme une solution miracle et que vous y avez cru.

[^] # Re: Oui, mais non

Posté par Nicolas Boulay (site web personnel) . Évalué à 10.

L'agilité sans "le client", dans la boucle, n'est pas de l'agilité.

"La première sécurité est la liberté"

[^] # Re: Oui, mais non

Posté par flagos . Évalué à 9.

Et un manager ne peut pas remplacer le client…

[^] # Re: Oui, mais non

Posté par Nicolas Boulay (site web personnel) . Évalué à 5.

Le manager ne respecte en général jamais sa part de contrat dans l'agilité : le contenu d'un sprint est décidé au début de celui-ci.

Si cela casse, tout ce qui est rythmé par le sprint casse (genre l'équipe de teste qui valide le sprint précédent, va se tourner les pouces)

"La première sécurité est la liberté"

[^] # Re: Oui, mais non

Posté par El Titi . Évalué à 10.

Je vais profiter de ton commentaire pour rebondir sur celui-ci quelques autres ainsi que sur une remarque de l'auteur :)

Même si tu donnes quelques éléments pour étayer, on peut pas laisser passer çà :)

L'agilité n'a jamais prétendu qu'il fallait se "passer" de la documentation, bien au contraire.

Le principe, comme pour le reste, est de faire ce qui est suffisant au bon moment çar le changement peut, enfin non, va, arriver. Tout comme on n'se fait pas plaisir avec une archi géniale qui servira jamais (overdesign) et qu'on fait "juste ce qu'il faut".

Voilà, ca tombe bien, pour l'agilité non plus. Si tu as des contraintes réglementaires, on ne va pas te dissuader d'en faire.

Une US c'est juste morceau de fonctionnalité dont on peut mesurer la valeur ajoutée et qu'on peut livrer à temps pour plaire à celui qui paye, le métier. Point barre

Qu'on en fasse une unité de tâche n'empêche pas qu'on puisse la découper en sous-tâches ou même qu'on la retravaille.

https://www.youtube.com/watch?v=rP9AlpFwvSM

Petit "test":

- On est super agile, on a des sprints de 2 semaines

- Vous avez des tests ?

- Bin non tu rigoles avec le pressing de l'AMO , on n'a pas le temps

- J'ai une bonne nouvelle comme vous êtes agile, on va se lancer dans un petit refactoring des familles, parce que là ça pue le syndrome du copier-coller

- OMG!

Allez, on reprend les bases: le manoifesto

Working software

withoutover comprehensive documentationCustomer collaboration over contract negotiation

Voilà, on privilégie ce qui marche plutôt que la paperasse inutile: un doc de spec de 500 pages que l'AMO n'ose pas tamponner de peur de s'être planté ou à balancer parce que le business a déjà changé. Un modèle UML aux petits oignons que le métier pige pas et qui sera complètement obsolète au moment de la livraison.

Si documentation il y a, il faut qu'elle reflète l'état du projet à l'instant t, bref qu'elle soit "vivante" ET qu'elle serve. Quoi de mieux qu'un exemple élaboré avec toutes les parties prenantes pour être sûr qu'on a tous pigé le même truc sans "intermédiaire". S'autoriser à challenger le PO sur cette base pour être sûr qu'il sait ce qu'il veut ou lui montrer que ça tient pas debout.

Allez un petit rituel pour bien s'accorder sur les règles métier avant de valider que la US est "Ready" et s'assurer qu'on va pas (moins) se planter sur le planning (la "cistomer collaboration"):

https://www.youtube.com/watch?v=gID0boETxJQ

https://cucumber.io/blog/example-mapping-introduction/

Le PO/AMO est pas jouasse ? Et bin on se protège:

https://www.youtube.com/watch?v=C9XoZQdnKbA&list=PLxTb_ZC4kmrSBKSyz3N4rtYjdE7EaI0Uu

Et comment qu'on fait pour s'assurer que ces règles sont bien respectées ?

Et bin on les teste (non la vocation du BDD Bevaviour Driven Design n'est pas le test mais bien piger ce que veut le client), on les rend "executables". La voilà la living documentation:

https://www.youtube.com/watch?v=p1Tl8kfkjGM

Et ca veut pas dire qu'il faut "tout" tester en Cucumber et écrire des tests d'IHM en Ghekin, hein

Allez, on pousse encore un peu le truc avec l'archi. Un peu de sketch modeling pour le début du sprint (ton exemple est quand même très orienté EDA ca correspond pas à tout les projets)

Et puis pour le newbie, quoi de mieux que de lire les TUs pour se mettre dans le code ? En voilà une autre de belle "living documentation" à base d'exemples pour peu qu'on soigne un peu le présentation (Clean code, domain driven). Oui on soigne ses tests et on les refactore avec le même soin que le code.

https://www.amazon.com/Clean-Code-Handbook-Software-Craftsmanship/dp/0132350882

Le "Done Done", c'est pas pour la déco, …

Voilà le truc, c'est de faire du bottom-up et plus du top-down (on oublie le MDA)

Ca tombe bien, un petit français nous a fait un super talk dessus:

https://www.youtube.com/watch?v=Tw-wcps7WqU&list=PLTbQvx84FrAS5clN9i8_LFUQxcMY7qXAO&index=118

et a même pondu un bouquin au financement libre:

https://leanpub.com/livingdocumentation

A consommer sans modération, avec par exemple comment rétrogénerer de la doc d'archi avec un bon framework des famille et quelques annotations, DDD, Documenation by convention, …

Une mine d'or.

Alors c'est sûr la 1ere fois si on fait l'impasse sur tout ça, l'AMO, le PO, il s'habitue: "Vous avez pulsé , les gars!" et on ne pourra pas revenir dessus. Les bugs tombent, la dette technique s'accumule on fait l'impasse sur la doc en crachant sur la méthode et l'agilité Ultime et Universelle se met en place aka:

http://www.la-rache.com/

[^] # Re: Oui, mais non

Posté par barmic . Évalué à 2.

Mon point n'était pas qu'il ne faut pas de doc, mais que des approches agiles donnent des approches différentes de la documentation et justement les 2 points que j'ai donné servent à produire de la documentation.

[^] # Re: Oui, mais non

Posté par El Titi . Évalué à 4.

Je l'ai bien saisi. J'ai d'ailleurs mis un bémol. Juste que la formulation était ambigüe et l'idée reprise par d'autres.

Accessoirement, c'était aussi un prétexte pour placer ma tirade ;-)

[^] # Re: Oui, mais non

Posté par Cᴬᴾᵀ Samavor . Évalué à 2.

Et le jour ou il faut partager une lib entre Kotlin et Swift le plus simple sera… de la faire en C++ ! Ben oui, aujourd'hui ton code va se promener sous Android, iOS, Node etc. Et si à peu près tous les langages """modernes""" permettent d'appeler une fonction dans une lib native d'une façon ou d'une autre (Java JNI, Node N-API…) les interfacer entre-eux reste beaucoup plus difficile.

# CI/CD

Posté par Moonz . Évalué à 10. Dernière modification le 03 juin 2019 à 08:55.

Tu devrais pouvoir faire la même chose facilement en C++ avec une solution de CI/CD type gitlab-ci/drone/sourcehut : il suffit d’automatiser la compilation d’un .exe et sa publication au push sur master.

# Performance

Posté par barmic . Évalué à 10.

Je sais que c'est une caricature, mais une démarche en python est un peu différente. Elle dit que la majeure partie de ton application n'a pas besoin d'une performance importante. Donc coder la partie qui demande une grosse performance en c/c++/go/rust/julia et l'interfacer1 avec le reste de ton application en python peut être pertinent. Ça permet en plus d'avoir de coder la partie métier dans un langage de très haut niveau et la partie technique dans un langage qui permet d'accéder au très bas niveau.

pas forcément dans un wrapper python comme vous utilisez des broker de messages ça peut passer par là ↩

[^] # Re: Performance

Posté par Firwen (site web personnel) . Évalué à 4. Dernière modification le 04 juin 2019 à 08:16.

Exactement. Python et C++ ne joue pas dans la même court.

D'ailleurs ironiquement python et ses modules sont principalement fait en C et C++ (CPython, Cython, numpy, tensorflow, SSL layer, pycurl, ….). Le restant étant un joli layer de scripts au dessus

[^] # Re: Performance

Posté par barmic . Évalué à 2. Dernière modification le 04 juin 2019 à 08:53.

Je ne suis pas d'accord avec ça :

[^] # Re: Performance

Posté par fearan . Évalué à 4.

If it works, don't fix it !!!

Le code entre C++ 98 (ou 2003), est compatible avec le C++11, mise à part quelques cas marginaux comme des using namespace std et using boost::shared_ptr, pas besoin de mettre à jour le code. Lors de modifications de code (évolution), il est tout à fait possible de faire la mise à jour du code dans le cadre de l'évolution.

il y a pas mal de composant de test (cppunit, google test suit) qui rendent l'écriture de test très aisée.

Il ne faut pas décorner les boeufs avant d'avoir semé le vent

[^] # Re: Performance

Posté par barmic . Évalué à 6. Dernière modification le 04 juin 2019 à 09:19.

On voit ici des gens qui n'ont pas du tout envie de bosser sur ta vielle base de code.

On ne parle pas des même magnitude. Je viens du monde Java du test on en a plus que ce que peut imaginer en C++ (une bibliothèque de test qui fait référence avec un format qui fait standard de fait dans le reporting de tests, des bibliothèques d'assertion et de mock on en a pleins), mais le typage de java (ou du C++) rendent l'écriture de test bien moins pratique qu'en python/go. En java on a la chance d'avoir un runtime extrêmement flexible ce qui permet d'avoir spock, mais il faut remercier groovy et sa compatibilité avec java.

[^] # Re: Performance

Posté par Anthony Jaguenaud . Évalué à 8.

Moi je vois des managers, des chef de département qui n’ont pas 100k€ à dépenser pour une mise à jour de code qui :

Lorsqu’il y a une bonne base de code qui marche, de bibliothèque qui fonctionne, pourquoi prendre le risque de tout changer ?

[^] # Re: Performance

Posté par barmic . Évalué à 6. Dernière modification le 04 juin 2019 à 09:51.

Je comprends ton point, je dis juste qu'il te suffit de regarder plus haut ou plus bas pourvoir un certains nombre d'exemples de développeurs qui n'ont pas envie de toucher à cette base de code. Ils sont prêt à changer de boulot plutôt que d'y toucher. Le manager fait bien ce qu'il veut de son coté. Je ne parle que de ce que je vois.

Après il y a un tas de raisons à mettre à jour sa base de code :

[^] # Re: Performance

Posté par totof2000 . Évalué à 5.

Ben juste parce que le mec qui a fait ça avant il est mauvais. Le nouveau développeur qui a réussi son stage de fn d'année réussira mieux que le dino qui a écrit tout ça avant lui. LEs nouveautés du langage lui permettront de simplifier et de mieux faire marcher le code.

Cette mode de réparer ce qui marche, surtout dans le monde du libre me gave depuis des années. Je me dis parfois que le code payant a du bon : au moins on réinvente pas la roue tous les 6 mois parce qu'un pneu est dégonflé.

[^] # Re: Performance

Posté par Anthony Jaguenaud . Évalué à 9.

Je ne suis pas d’accord, le truc écrit dans les années 90 (pour des vieilles bases de code) on été écrite avec des contraintes de l’époque. L’ancien dev. n’est pas nécessairement plus mauvais.

Je vois plutôt l’inverse, les jeunes qui sortent de l’école ne savent utiliser que des IDE qui font tout à leur place, si la fonction n’existe pas, oups ! Le jeune va te refaire tout un super design car le langage permet plein de nouveau truc. Sauf que par manque d’expérience, il va se prendre les pieds dans le tapis de cas tordu : « Ah bon, ça peut arriver ? ».

Je fais passer des entretiens techniques dans ma société pour des embauches, j’ai eu mon premier candidat qui a su me dire que le c++ avait des normes, il a même réussi à me les nommer… mais pas à me dire, même vaguement, ce qu’elles apportent.

Je crois qu’ici on est dans un petit monde clos avec un niveau technique supérieur à la moyenne… ça fausse le débat.

[^] # Re: Performance

Posté par Tit . Évalué à 5.

je pense que si vous êtes d'accord, tu as juste loupé le deuxième degré de totof2000, il me semble.

[^] # Re: Performance

Posté par Anthony Jaguenaud . Évalué à 3.

Je suis parfait, je ne peux rien rater ! 😇 même si je pense que tu as raison…

[^] # Re: Performance

Posté par totof2000 . Évalué à 3.

Il te semble bien :)

[^] # Re: Performance

Posté par SpaceFox (site web personnel, Mastodon) . Évalué à 6.

Une réflexion intéressante sur le cout de faire de la qualité dans le développement, et sa rentabilité (en anglais).

La connaissance libre : https://zestedesavoir.com

[^] # Re: Performance

Posté par rewind (Mastodon) . Évalué à 4.

Il y a tout un tas de test que tu fais en python qui sont simplement inutiles en C++ du fait du typage statique de C++.

Il existe aussi des outils pour t'aider à améliorer ton code (il te propose même de patcher ton code directement).

[^] # Re: Performance

Posté par barmic . Évalué à 5.

Le typage ? Tu n'écrit pas un test en python pour vérifier ton typage. Sinon c'est que tu n'utilise pas l'outil comme il faut. Le principe même du duck-typing fais que la notion de type n'a rien à voir et que tu ne fais pas les mêmes hypothèses sur ce qui t'es donné. La vérification du type n'est qu'un effet de bord de tes tests fonctionnels.

Par contre on ne teste pas la cohérence de la mémoire en python. Donc pas besoin de valgrind et vu la complexité de mise en place de valgrind (il faut jouer des scénarios etc). Je pense que tu y gagne.

Trop cool ! J'espérais voir apparaître un outil comme ça avec llvm l'ouverture de gcc, ils ont fini par le créer c'est super. Il est même capable de te pousser à faire du code moderne c'est parfait :) La dernière fois que j'avais cherché je n'avais rien trouvé.

[^] # Re: Performance

Posté par Firwen (site web personnel) . Évalué à 2.

Presque plus personne n'utilise valgrind de nos jours, sauf pour du debugging. ASAN et BSAN de g++ et clang++ font 95% pourcent du boulot de valgrind, sans les problèmes de performances, et sans la complexité de mise en oeuvre.

[^] # Re: Performance

Posté par Julien Jorge (site web personnel) . Évalué à 2.

Tiens justement, aurais-tu une solution pour lancer Valgrind sur une app lié à libasan ? De souvenir c'était incompatible et l'app plantait tristement au lancement avec Valgrind.

[^] # Re: Performance

Posté par barmic . Évalué à 1.

Si je comprends bien ça reste runtime. Je présume que ce n'est pas utilisé pour du code de prod, il faut passer les tests avec l'instrumentation qui va bien. Même si c'est cool, ça reste une classe de bug que l'on trouve en C++ et qu'on ne trouve pas en python.

[^] # Re: Performance

Posté par Zenitram (site web personnel) . Évalué à 2.

Bah… Si tu es prêt à accepter la perte de vitesse et la consommation de RAM de l'équivalent en Python, j'imagine que tu es prêt à garder ASAN (perf divisée par 2, mémoire consommée multipliée par 4, "rien" par rapport à Python souvent :-D ) en prod.

Bref, comparer ce qui est comparable, quand on accepte des impacts de l'autre côté. Juste qu'en C++, la perte de perf est optionnelle ;-).

Ca a déjà été dit par ailleurs, mais cette bataille de "classe de bug" est toujours biaisée par la personne qui attaque, elle "oublie" comme par hasard les classes de bugs (ou la conso) dans son langage préféré qui ne se trouve pas dans le langage attaqué.

[^] # Re: Performance

Posté par barmic . Évalué à 2.

AMHA tu te trompe de comparaison. Sinon en comparant ce qui est comparable, tu peux implémenter le runtime python en C++ et là tu es comparable. Il me semble que la démarche que nous poursuivions avant que tu arrive consistait à comparer les pratiques dans divers langages. Dis autrement on tente de répondre à la question : « Comment est-ce que les développeurs python et C++ s'assurent de la qualité de logiciel ? » (ce qui est différent de la question « Comment on peut réimplémenter l'un dans l'autre »1). Je ne vois pas en quoi ça ne serait pas comparable.

Je doute que les développeurs C++ laissent l'instrumentation asan en prod. Ça pose tout de même un sacré paquet de problème. Et au contraire je ne vois pas en quoi une instrumentation qui va alerter et/ou crasher ton programme serait équivalent à un runtime qui gère la mémoire pour toi.

qui ne peut que mener à un « toute chose est égale par ailleurs » pas particulièrement intéressante. ↩

[^] # Re: Performance

Posté par Troy McClure (site web personnel) . Évalué à 4.

Wat ? ça fait plusieurs fois que je lis ce genre de chose et y'a un truc qui m'echappe. Quel sanitizer tu utilises pour chopper les problemes de variable non initialisées ? Valgrind les choppe bien, mais ni asan ni ubsan ne signalent un probleme avec:

int main(int argc, char **argv) {

int i;

std::cout << "i=" << i << "\n";

return 0;

}

# g++-8 -fsanitize=address,undefined t.c && ./a.out

i=0

# g++-8 t.c && valgrind ./a.out

Conditional jump or move depends on uninitialised value(s) (…)

Accessoirement, le gain de temps d'execution pour moins il est perdu en temps de compilation et de link qui est au bas mot 2x plus long que sans sanitizers.

[^] # Re: Performance

Posté par grim7reaper . Évalué à 2.

L’option

-Wuninitializedde GCC ou Clang :pMais ouais, pour les cas plus complexe Valgrind est bon, et les différents

sanitizerne supportent par encore tout ce que fait Valgrind.Mais bon utiliser l’un n’empêche pas d'utiliser l’autre (par contre pas en même temps xD) : tu peux faire exécuter ta test suite sous Valgrind puis refaire une exécution compilé avec les sanitizer.

[^] # Re: Performance

Posté par Philippe F (site web personnel) . Évalué à 8.

Ca, c'est du troll pur non ?

J'ai beau réfléchir, sur 15 ans de Python, les fois où j'ai du faire un test de typing pur en Python doivent se compter sur les doigts d'une main. Par contre, je profite régulièrement de la souplesse du typage de Python dans mes fonctions pour faire des trucs assez complexes qui, à faire en C++, demanderaient soit une classe dédiée, soit des template, soit d'être un expert C++18, soit les trois en même temps. Il y a beaucoup moins de boilerplate en Python.

Et mes tests Python sont souvent bien plus poussés que ceux que j'écris en C++ pour des fonctionnalités équivalentes, et ce pour plusieurs raisons:

Ca tombe bien, Python aussi. Ca va du simple Linter à MyPy ou PyCharm qui te permet de vérifier la cohérence des types utilisés dans ton projet (à peu près comme un compilo C++). D'ailleurs, il y a un français qui a fait une super conférence à ce sujet au PyData Paris 2018: https://www.youtube.com/watch?v=URP2e7hEUFw&list=PLzjFI0G5nSsry3cm_k1tPOi9SRaAXsZAt&index=6 (disclaimer: c'est moi qui présente).

[^] # Re: Performance

Posté par chimrod (site web personnel) . Évalué à 8.

En fait il y a typage et typage, et derrière ce mot il n'y a pas forcément les même notion.

Le premier niveau, celui que tout le monde connaît, consiste à décrire la manière dont la donnée est représentée en mémoire.

int,string,voidetc. Sur ce sujet, je pense que tout le monde est d'accord on ne fait pas de test :)Le deuxième niveau, consiste à ajouter de l'information supplémentaire. Par exemple en C,

intetunsigned intont la même représentation mémoire, mais le fait d'avoir deux types différents permet (ou devrait permettre…) les erreurs bêtes. Il y a quelques années, un journal sur les types fantômes avait été posté, mais on peut imaginer des usages variés : par exemple une chaîne de texte (typestring) ne donne pas d'information sur son contenu (encodage local, UTF-8 etc). En précisant cette information dans son type, on évite les erreurs bêtes d'encoder un texte qui l'est déjà. Et comme l'information est précisée au niveau du typage, cela est fait sans surcoût en mémoire, ni perte de performance à l'exécution, c'est le compilateur qui s'occupe de contrôler que les données sont adéquates.Je prend autre un exemple : dans un arbre rouge noir, il y a des propriétés à respecter pour garantir que l'arbre soit équilibré. Ces propriétés ne sont pas liées à la données contenue dans chaque nœud, et l'on pourrait penser que cela n'est pas lié à notre propos. Sauf qu'avec des notions de typage avancé, on peut laisser le compilateur garantir que le programme utilise notre arbre de façon appropriée. Cela veut dire que le programme ne compilera pas si un nœud rouge est inséré sous un autre nœud rouge. Le développeur n'a pas besoin de faire de test sur ces propriétés, elle sont garanties par le code.

Cela ajoute de la complexité au code écrit, mais avec l'habitude, ça n'est pas un problème supplémentaire.

[^] # Re: Performance

Posté par barmic . Évalué à 3.

Tu utilise l'une des approche du typage celle du typage statique et oui on peut encoder potentiellement ce que l'on veut dans les types et le typage est prouvé par le compilateur.

Là où une approche structurelle plutôt que par nom se démarque c'est que l'approche structurelle ne regarde pas la forme de la donnée en mémoire mais les propriétés qu'elle possède. Si je peux appeler les la méthode

foo()sur ta variable on ne s'intéresse pas à qu'elle est la forme de cette donnée. C'est une souplesse qui est très structurante et elle évite d'avoir des arborescences de classes complexes et pas toujours pertinentes. On peut le vérifier dynamiquement comme en python ou statiquement comme en go.Avec le typage dynamique on a beaucoup plus d'informations de typage au runtime. C'est très utile quand tu fais des programmes configurés par les données par exemple.

Après tu parle de cas général le typage du C++ est relativement pauvre, on peut faire des circonvolutions pour tenter d'encoder des choses en plus dans les types à coup de templating, mais plus aucun humain ne sera en mesure de reprendre le code en question.

[^] # Re: Performance

Posté par chimrod (site web personnel) . Évalué à 5.

Pour être franc, j'avais plutôt en tête les langages fonctionnels (OCaml, Haskell), mais je répondais surtout à la question de savoir si le typage pouvait éviter de faire des tests ou non.

Je ne vois pas trop où tu veux en venir quand tu dis :

avec le typage dynamique on a beaucoup plus d'informations de typage au runtime(ou alors j'ai peur de comprendre ce que tu proposes. Mon avis personnel est que le typage dynamique induit des risques et ne garantie pas que le programme soit sûr, mais c'est un autre débat dont il n'est pas l'objet ici).Pour ton dernier point, je ne suis pas expert en C++ (et je ne souhaite pas l'être), mais quand je vois que certains prennent plaisir à écrire du brainfuck, je me dit que l'on peut tout à fait prendre plaisir à écrire ce genre de code via template (en tout cas certains le font en java) :)

[^] # Re: Performance

Posté par barmic . Évalué à 2.

Oui mais tu réponds à une comparaison entre C++ et python. Donner un exemple pourquoi pas venir dire que le langage foobar lui il est mieux, c'est hors sujet.

Le RTTI pour parler avec des termes plus précis. Le typage dynamique ne convient pas à toutes les situations et certaines approches statiques peuvent résoudre des problèmes auparavant traitées par le typage dynamique, mais il y a des fois où tu ne peux faire que peux d'hypothèses sur les données d'entrées par exemple, d'autres fois tu va vouloir cloner une structure sans pour autant la connaître initialement, tu as aussi des approches qui vont se rapprocher de l'AOP ou des proxy qui peuvent être infiniment plus simples,…

La question n'est pas de savoir si toi ou moi on aime ça (j'aime le turquoise, je présume que ça te fait une belle jambe), mais de savoir à quoi sert le typage dynamique et donc comment s'en servir et quand est-ce qu'il est pertinent. Le plus mauvais système de type, c'est celui qui est mal utilisé.

[^] # Re: Performance

Posté par chimrod (site web personnel) . Évalué à 2.

Je n'ai pas annoncé que tel langage était mieux qu'un autre, et je suis d'accord pour dire que la question n'est pas de savoir ce que l'on aime ou non (tu noteras que je disais déjà dans mon commentaire que ça n'était pas l'objet).

Ce que tu dis sur le RTTI est peut-être juste, mais je te trouve agressif dans ta réponse. Vu que c'est mon ressenti, et qu'il figure dans une discussion sur le typage, c'est peut-être également hors sujet ? (je t'avoue que j'ai hésité à répondre ne voulant pas ajouter du bruit dans cet échange qui prend d'un coup une tournure désagréable…)

[^] # Re: Performance

Posté par barmic . Évalué à 2.

Tu m'en vois sincèrement désolé, ce n'était vraiment pas mon objectif. J'ai essayé d'apporter réellement quelque chose dans mes commentaires. Notamment on assez peu de gens qui explique à quoi sert un typage dynamique par ici, donc ça me paraissait intéressant. Si j'ai paru agressif ce n'était pas du tout mon intention.

[^] # Re: Performance

Posté par Dr BG . Évalué à 3.

Je n'ai pas bien vu ce qu'apporte le typage dynamique. Les avantages me semblent liés au typage structurel qui peut être vérifié statiquement comme en Ocaml.

[^] # Re: Performance

Posté par barmic . Évalué à 4. Dernière modification le 04 juin 2019 à 18:32.

Je pense que l'exemple le plus parlant sera le proxy.

Le proxy en POO c'est le fait de créer un objet qui s'utilise comme l'objet proxifié. On utilise le proxy sans savoir qu'il s'agit du proxy et pas de l'objet d'origine. Le proxy va pouvoir faire quelque chose avant, après et/ou à la place de l'objet qu'il proxyfie.

Il peut y avoir différents cas d'usage à ça : ajouter un cache à un objet, faire des vérifications de sécurité, mettre en place un circuit breaker, avoir du log, mettre en place un pattern stratégie,…

Pour faire ça en POO tu as besoin de faire de la délégation, mais j'ai pas vu beaucoup de langages courants qui permettent vraiment de faire de la délégation propre. Avec un langage dynamique, c'est assez simple à mettre en place.

Il existe d'autres façons de faire (java a une API de proxy par exemple), mais c'est un point qui est tout de même facilité par un typage dynamique.

[^] # Re: Performance

Posté par YBoy360 (site web personnel) . Évalué à 1.

Je pense que tu connais déjà, c'est moyen "propre" (je ne l'utilise pas des masse), il y a l'annotation

Delegatedirectement en Groovy.SelectOptionList s'utilise comme une liste.

I use Arch BTW

[^] # Re: Performance

Posté par barmic . Évalué à 2.

Qui est un langage dynamique :p

Mais je ne dis pas qu'il n'existe pas d'autres façon de faire. Par contre la solution que tu montre ne permet pas (il me semble) d'ajouter du code autour des appels délégués.

[^] # Re: Performance

Posté par YBoy360 (site web personnel) . Évalué à 1.

Tu veux dire faire de l'AOP (version générale du Proxy)?

ça se fait en Java, avec AspectJ par exemple. C'est vrai que ce n'est pas simple.

I use Arch BTW

[^] # Re: Performance

Posté par barmic . Évalué à 2.

Les aspcts sont une façon d'implémenter des proxy, mais ce n'est ni la seule façon ni la façon la plus logique.

En java standard tu as la classe Proxy par exemple (qui fait grand usage des RTTI). Spring implémente ces proxies soit via Proxy soit via de l'AOP (AOP par défaut depuis la version 5).

Au dessus il est question de groovy, le metaobject protocol peut aussi servir à ça.

[^] # Re: Performance

Posté par Guillaum (site web personnel) . Évalué à 2.

C'est en effet un exemple intéressant !

Si tu veux un proxy parfait qui prend n'importe quel objet et remplace toutes les méthodes par une méthode wrappée qui ajoute du comportement, en effet, tu feras cela très facilement en python, plus difficilement que dans d'autres langages moins dynamiques.

Si tu en veux faire un proxy de seulement une méthode / fonction. C'est assez simple (et tu peux le faire de façon assez générique) en C++ en créant un "functor" et en exploitant des templates variadics. Cependant le type de l'objet va changer (i.e. ce sera celui du Proxy) et donc il faudra que tes fonctions acceptants l'objet initial puisse accepter le nouveau. Si tes fonctions sont initialement "templatées", c'est faisable, sinon, c'est mort. Point de plus pour le langage dynamique.

Un point où un langage statique s'en sort très bien ce serait le cas du proxy d'une fonction. En prog fonctionelle, on a très souvent tendance à passer des fonctions en argument d'autres fonctions. Le type d'une fonction étant défini juste par ses arguments / valeur de retour, si ton proxy à la même interface, cela passera sans problème.

Par exemple, en Haskell, la fonction

databaseQuery :: DbHandle -> Query -> IO DBResultqui prend une requete SQL et retourne un résultat, pourra être remplacée en ajoutant du log de la façon suivante:Ainsi, que tu passes

dataBaseQuery handleoulog (dataBaseQuery handle)(i.e. ton proxy) en argument d'une autre fonction, le système de type sera satisfait.Cependant cela demande de penser son interface en avance et c'est donc moins souple. De mon expérience, je suis rarement limité par ce point, mais j'admet cette limitation.

Merci de m'avoir fourni un exemple valide de l’intérêt d'un typage dynamique.

[^] # Re: Performance

Posté par barmic . Évalué à 2.

C'est pas le dynamisme qui joue là, mais le stypage structurel/duck typing.

Elles bénéficient d'un typage structurel. C'est la forme de la fonction qui donne son type et pas son nom. On peut imaginer des langages où tu peut définir le type

injectionIntqui est un type de fonction qui pour tout entier te renvoie un entier et qui t'obligerais à déclarer des fonctionsadd,mult,… comme étant du typeinjectionInt. Tu n'aurais plus de typage structurel et les même problèmes qu'avec les objets.C'est un usage qui arrive pour ceux qui font de grosses bibliothèques (injection de dépendance par exemple).

De rien :)

[^] # Re: Performance

Posté par Claude SIMON (site web personnel) . Évalué à 1.

Vu la définition et les cas d'usage que tu cites, un proxy ne serait-il pas implémentable avec une classe abstraite en C++ ?

Je pose cette question pas tant pour faire avancer le débat que pour voir s'il n'y a pas quelque chose qui m'échappe…

Zelbinium: Your Devices, Your Rules!

[^] # Re: Performance

Posté par barmic . Évalué à 2.

Le découplage entre le proxy et l'objet proxifié. Tu peux vouloir proxifier des objets d'une bibliothèque dont tu n'a pas la charge du code source et tu voudrais alors que l'évolution de cette bibliothèque ne te coûte le moins possible (ajout, suppression, changement des méthodes de cet objet).

De l'autre coté d'un point de vu utilisateur le fait que l'objet soit proxifié devrait être transparent (par définition un proxy doit avoir un contrat équivalent, sinon c'est un adapteur). Donc tu ne devrais pas toucher au typage pour ça.

Ce sont 2 grosses contraintes mais elles donnent une grande flexibilité et ce n'est pas des cas théoriques. Spring est très largement basé sur des proxies par exemple (il ne le fait pas comme ça, mais s'ils pouvaient ils le ferraient).

Dans les autres façons de faire que je vois il y a :

__call()de php peut faire la même chose) intercepter les appels vers ton objet[^] # Re: Performance

Posté par Firwen (site web personnel) . Évalué à 3. Dernière modification le 09 juin 2019 à 13:18.

Corrige moi si je me plante quelque part :

Est-ce que ce snippet ne ferait pas le boulot pour une re-definition statique ET proxyfié que tu recherches en C++ ?

L'intégralité des methodes et propriétés de "Proxified" sont disponible dans l'interface de ton objet proxy.

Tu peux override à souhait toute methode de "Proxyfied".

Le tout a un impact en terme de performance null si ta classe supporte correctement le move-semantic.

[^] # Re: Performance

Posté par barmic . Évalué à 2.

Ça peut faire l'affaire :)

Les défauts que je vois :

Je pense sincèrement que c'est l'un des cas où l'AOP a du sens (je suis contant d'avoir trouvé un cas d'usage amha pertinent à l'AOP :) ). Ça permet de remplir tous les critères : souplesse d'un langage dynamique sans aucun coût à l'exécution.

Merci sincèrement pour l'exemple qui peut être pertinent dans beaucoup de cas.

[^] # Re: Performance

Posté par chimrod (site web personnel) . Évalué à 2.

Pas de soucis, c'est le lot des échanges sur le net, ça n'est jamais simple… et pourtant ça marche !

:)

[^] # Re: Performance

Posté par kantien . Évalué à 3.

Ce n'est pas vraiment hors-sujet à mon avis. Philippe Fremy répond à rewind en postant une vidéo d'une de ses conférences sur le typage statique en python. Le slide de conclusion est :

Là où c'est déjà étrange, c'est que dans sa réponse il laisse entendre que rewind cherche à troller, alors que c'est justement ces avantages du typage statique que rewind et chimrod ont cherchait à mettre en avant.

Ensuite, oui cela relève d'une plus grande sûreté que le recours aux tests unitaires. Quand on pousse jusqu'aux systèmes à types dépéndants, non seulement on ne fait plus de tests unitaires mais en plus on obtient une sûreté que ne pourront jamais atteindre ces derniers : un test peut montrer l'existence d'un bug (dans le respect à la spécification) mais jamais son absence.

Typer son code permet effectivement de le documenter (point 2 du slide de conclusion) car le langage de types est un langage formel d'écriture de spécification du code, et permet donc d'exprimer en partie ce que doit faire la fonction. D'où mon point précédent, avec des types dépendants on peut totalement spécifier formellement le code et donc vérifier qu'il est conforme à sa spécification.

Pour le typage structurel, on peut tout à fait faire cela statiquement et sans écrire d'annotation. Quelques exemples issues de la conférence de Philippe Fremy :

Enfin, pour ce qui est des objets et du typage structurel, la façon dont ils sont globalement utilisés en pratique cela en fait surtout des modules du pauvre. En OCaml on utilisera plutôt des modules, en Haskell des type classes, en Rust des traits et en C++ des template.

Sapere aude ! Aie le courage de te servir de ton propre entendement. Voilà la devise des Lumières.

[^] # Re: Performance

Posté par barmic . Évalué à 3.

C'est ce que fait go. Typescript a un typage structurel vérifié à la compilation, mais il est optionnel.

L'intérêt c'est de pouvoir avoir un polymorphisme qui ne soit pas nommé. Quand on veut créer une méthode qui va manipuler des données qui ont un

idqui est un UUID par exemple. Le typage structurel peut permettre d'avoir des données qui ne sont pas liées entre elles, mais qui possèdent toutes unidde la bonne forme.Je ne connais pas les autres, mais je ne suis pas certains que C++ permettent d'être aussi souple que go. En go (et c'est pour moi le gros intérêt), ta structure n'a pas a connaître la structure nécessaire à ta méthode pour être utilisable.

Le type

Ploufn'a aucun rapport avec l'interfaceUser. Ça permet d'écrire après coup des fonctions qui définissent des interfaces décrivant le contrat que doivent remplir leur arguments sans impact sur les types créé ailleurs. Dans l'usage on peut généraliser une fonction à un ensemble de type qui sont dans différentes bibliothèques. Je sais pas si c'est très clair…En java je fais un hack a coup de lambda pour ça.

[^] # Re: Performance

Posté par kantien . Évalué à 4. Dernière modification le 05 juin 2019 à 17:59.

Ça l'est : tu veux faire du polymorphisme ad-hoc; mais je ne vois pas où on a besoin de typage dynamique pour cela.

L'idée du polymorphisme ad-hoc est d'avoir des fonctions qui ont le même nom (ici

Greeting) mais qui opère sur différents types et selon des logiques différentes (à la différence du polymorphisme paramétrique). Ensuite à l'usage (comme dans ta fonctionfoo) la fonction effectivement utilisée est choisie en fonction du type du paramètre (type base dispatch). C'est exactement ce que font les type classes de Haskell et les traits du Rust. Cette manière de faire est bien plus intelligente (j'ai envie de dire moins inepte) que l'approche de l'orienté objet. En OCaml on passe par des modules et foncteurs pour faire cela (avec une perte de l'implicite) et il me semble (mais là je suis moins sûr) que les template du C++ peuvent servir à cela.Pour présenter grossièrement l'idée, il s'agit d'associer à un type un dictionnaire de fonctions pour opérer dessus, c'est l'interface contre laquelle on veut programmer de manière générique. En fonction du type du paramètre, le compilateur choisira le dictionnaire qui lui a été associé. Néanmoins, le système des interfaces du Go reste trop limité à mon goût : j'en ai déjà parlé sur un ancien journal de gasche.

Prenons l'exemple de la structure d'anneaux en mathématiques : un anneau c'est un type de données que l'on peut ajouter, soustraire et multiplier avec deux éléments neutres pour l'addition et la multiplication. Autrement dit, c'est cette interface de module :

Plutôt que de dire que l'on peut les soustraire, je préfère exprimer l'axiomatique en disant que l'addition est une opération inversible d'où la fonction :

:

neg. À partir de là, dès que l'on a une telle structure, on peut définir dessus le polynômeLe principe derrière les type classes de Haskell ou les traits de Rust est de dire que pour un type donnée on ne peut définir qu'une interface

Anneausur ce type. Autrement dit, ils considèrent que le typeAnneau with type type t = aest un singleton pour tout typea(où plutôt le compilateur garantie que l'on ne définit pas deux valeurs distinctes de ce type), ce qui est trivialement faux mais en pratique largement suffisant. Les interfaces de Go, c'est un peu la même idée mais en beaucoup moins bien : tu ne peux pas définir l'interface Anneau par exemple, il n'est pas possible de définir des opérateurs binaires sur le typetdans les interfaces de Go.En OCaml, comme le type en question est rarement un singleton, il faut explicitement passer le dictionnaire en argument à la fonction

f, même s'il y a déjà eu des propositions pour le rendre implicites dans certaines situations.Sapere aude ! Aie le courage de te servir de ton propre entendement. Voilà la devise des Lumières.

[^] # Re: Performance

Posté par barmic . Évalué à 2. Dernière modification le 05 juin 2019 à 18:03.

Mon exemple utilise un langage avec un typage statique ;)

[^] # Re: Performance

Posté par kantien . Évalué à 4. Dernière modification le 10 juin 2019 à 13:14.

Je sais bien que Go fait du typage statique (même s'il fait fait du typage dynamique pour la généricité avec l'interface {}). Ce que je voulais dire c'est que le problème que tu cherchais à illustrer ne relève pas de la distinction typage dynamique vs. typage statique, mais d'une limitation du paradigme objet et de la façon dont il gère le polymorphisme ad-hoc. Go n'est pas orienté objet, tout comme Haskell ou Rust ne le sont pas. En Haskell ton code passera par des type classes :

En Rust, ce sera par des traits, ce qui n'est pas de l'orienté objet.

Pour illustrer la distinction entre l'approche objet et celle de Go, Haskell et Rust, faisons cela en OCaml.

Selon le paradigme objet, on aurait une méthode

greetingssur notre objetet la fonction

fooappellerait cette méthode sur notre objetDans l'approche objet, les opérations sur le triplet de

stringne sont pas dissociables du types : c'est un tout. Ce que tu exprimais dans ton commentaire ainsi :Dans l'approche objet, le dictionnaire de méthodes (ici

User) et le type sur lequel elles opèrent (iciPlouf) sont indissociables. Dans l'approche de Go, Haskell ou Rust le dictionnaire de méthode et le type sont dissociés. C'est ce que j'ai cherché à expliquer dans ma réponse précédente, et c'est aussi la raison pour laquelle en OCaml on passera par des modules et non des objets pour modéliser une telle problématique.La différence ici, avec les trois autres langages, est que l'on peut définir plus d'un dictionnaire pour un même type : il doit donc être passer explicitement à la fonction

foo. Là où, dans les autres langages, le dictionnaire étant unique pour un type donné, il est déterminé univoquement à partir du type de la variablex.Pour bien illustrer la différence avec le paradigme objet, c'est cela le type d'un objet :

c'est la donnée conjointe d'une valeur de type

'a(les attributs de l'instance) et des méthodes sur ces attributs, conjonction que l'on ne peut séparer en ses composantes au niveau du système de type.Ceci étant, bien que je trouve ce paradigme plus intelligent que celui du paradigme objet, la façon dont il existe en Go reste très limitée : tu ne peux pas surcharger des opérateurs binaires avec (addition, comparaison, test d'égalité…).

Sapere aude ! Aie le courage de te servir de ton propre entendement. Voilà la devise des Lumières.

[^] # Re: Performance

Posté par flan (site web personnel) . Évalué à 1.

J'ai beaucoup de mal à croire qu'il suffise de bien typer pour supprimer tous les bugs… Un peu comme si en physique, toute formule homogène était juste.

[^] # Re: Performance

Posté par rewind (Mastodon) . Évalué à 5.

Ça tombe bien, personne n'a dit ça, et c'est une bêtise. Ce que beaucoup disent (dont moi), c'est qu'un typage explicite permet d'éviter des bugs à la compilation parce qu'il y a une vérification du typage correct. Donc pas tous mais certains.

[^] # Re: Performance

Posté par kantien . Évalué à 3.

Je crois que c'est moi qui l'est dit, et ce n'est pas une bêtise : c'est ce qu'offre les langages avec types dépendants. Du moins il dispense de tests unitaires, sauf pour ce qui est des erreurs dans la formalisation des spécifications du code.

L'exemple le plus parlant est celui-ci :

Laissant de côté le mot clef

Theorem, le termetransform_c_programm_preservationest un terme du langage dont le type est l'énoncé exprimant que CompCert C est bien un compilateur C optimisant qui préserve la sémantique. Le terme, ou programme, est construit grâce à l'assistant de preuve Coq et il y a bien vérification statique qu'il a le bon type. Comme son type quantifie sur la totalité des programmes C (la varibalepdu forall), qui est potentiellement infinie, il garantie des choses inaccessibles aux tests unitaires.Par contre, il reste la question : la formalisation de la sémantique de l'Asm (utilisée dans le terme

Asm.semantics tp) est-elle conforme à la réalité ? Question dont la réponse est inaccessible aux méthodes formelles. De même pour ce qui est de la question sur la correction de la formalisation du C.Au niveau de la traduction en français, le type s'exprime ainsi : pour tout programme C

p, tout programme assembleurtpet tout comportement observablebeh, si la fonctiontransf_c_prgramappliquée àprenvoie le programmetpet quebehest un comportement observable detpen accord avec la sémantique ASM, alors il existe un comportement observablebeh'depconforme à la sémantique du C et tel que beh améliore beh'.Autrement dit le type affirme que

transf_c_programest un compilateur optimisant du C vers l'ASM.Ce cas extrême n'était pas pour inciter à l'usage des types dépendants, mais pour montrer que plus on introduit de typage statique et d'expressivité dans le système de types, moins on a besoin de tests unitaires (au point de ne plus en avoir besoin) : ce qui était bien ton propos initial. ;-)

Sapere aude ! Aie le courage de te servir de ton propre entendement. Voilà la devise des Lumières.

[^] # Re: Performance

Posté par flan (site web personnel) . Évalué à 2.

Mais en pratique, c'est rare (ou plutôt rarissime) d'avoir des spécifications formalisées au point de pouvoir prouver quoique ce soit (déjà qu'avoir des spécs n'est pas donné à tout le monde)…

[^] # Re: Performance

Posté par kantien . Évalué à 4. Dernière modification le 06 juin 2019 à 01:04.

C'est certain, mais dans certaines fonctions de bibliothèques les spécifications sont bien connues et c'est ce que l'on teste avec les tests unitaires. Si je reprend, par exemple, mon interface Anneau d'un commentaire précédent, on doit avoir comme propriété que

add x (neg x) = zeropour tout valeur dex. Ça s'exprime et se prouve en Coq, ce qui est hors de portée des tests unitaires.Ceci étant, la référence aux systèmes avec typage dépendant avait pour seul but de justifier la proposition : plus on enrichit le système de types, moins on a besoin de tests unitaires. Proposition implicitement soutenue par rewind qui est à l'origine de cette sous discussion dans les commentaires.

Sapere aude ! Aie le courage de te servir de ton propre entendement. Voilà la devise des Lumières.

[^] # Re: Performance

Posté par El Titi . Évalué à 2.

J'aurais plutôt pensé à de la programmation pas contrat comme le proposait Eiffel pour ma part:

https://www.eiffel.com/values/design-by-contract/introduction/

Ou alors je n'ai pas bien compris.

[^] # Re: Performance

Posté par Firwen (site web personnel) . Évalué à 3. Dernière modification le 05 juin 2019 à 10:25.

Le typage en C++ est tout sauf pauvre, le typage du C est pauvre.

Il s'approche au fil des standard de ce que tu peux avoir en Haskell et OCaml, qui sont des références dans le domaine.

std::variant autorise même maintenant à avoir une forme de pattern matching.

std::optional apporte lui aussi son lot d'avantages.

[^] # Re: Performance

Posté par Philippe F (site web personnel) . Évalué à 5.

Dans ma vie de développeur C et C++, je suis régulièrement confronté au fait que les entiers soient un type "faible", c'est à dire sans limite précise.

Typiquement, j'ai un offset dans un tableau de taille fixe, mais il est représenté par un unsigned int (et encore, c'est quand je fais propre, le reste du temps, c'est un signed int). Et il peut circuler d'une fonction à une autre sous forme d'entier non signé, perdant complètement la notion de limite intrinsèque pour laquelle il a été défini. Le buffer overflow nous tend les bras et le compilateur ne peut rien faire pour le prévenir, c'est dans la définition du langage.

Beaucoup de bugs découlent de cette absence de typage, et les langages C/C++/Java ne font rien pour y remédier. Elle se retrouve sous plein de variantes : les Enum qui sont gérés comme des int par le compilateur, une structure définie avec des types ouverts (int, float, std::string), alors qu'en fait, seul un petit nombre de valeur sont autorisés pour ces champs, etc etc.

J'ai entendu dire que le bon langage pour tenir compte de ce genre de contrainte s'appelle Ada. J'ai encore jamais pris le temps ni l'énergie de m'y mettre, mais je suis persuadé que si je dois écrire un programme "sur", c'est vers lui que le me tournerai.

Quand on me dit que le C++ est typé, c'est vrai mais je me sens toujours pas en sécurité quand je l'utilise. Les buffers overflow et les déréferencements de pointeurs ont encore une longue vie devant eux.

Jusqu'à récemment, j'avais aussi la sensation de prendre des risques à coder un gros projet en Python. Depuis l'arrivée de Mypy et du typage dynamique, je suis plus tranquille. Je n'ai pas encore la sureté d'un langage compilé mais je trouve que le compromis "sureté / rapidité de développement / facilité de test" est très correct.

Quand je retourne au C et C++, je perds beaucoup sur les deux derniers points, et de mon point de vue, je ne gagne pas assez en sureté.

[^] # Re: Performance

Posté par totof2000 . Évalué à 4.

Oui.