La dernière dépêche traitant du jeu Xonotic sur LinuxFr date de 2018, la dernière annonce d’une nouvelle version date de 2017, il y a 6 ans ! Beaucoup de choses se sont passées depuis, et il y a donc beaucoup de choses à raconter !

Xonotic est un jeu totalement libre (code et données) de tir à la première personne en arène. Il propose de très nombreux modes de jeu, les classiques combat à mort et capture du drapeau, mais aussi de capture de base ou de course contre la montre.

Depuis la version 0.8.2 sortie en 2017, deux versions sont sorties : la 0.8.5 et la 0.8.6, Xonotic a fêté ses dix ans, les brevets sur les textures DXTC ont expiré, l’éditeur NetRadiant suit désormais son propre cycle de publication, et Xonotic a eu quelques histoires avec Wikipédia. De quoi parler de jeu, de technique, et de drama, tous les ingrédients d’une bonne recette de lecture passionnante sur LinuxFr.org !

Sommaire

- Première décennie pour Xonotic, et 18 ans de jeu libre

- La version 0.8.5 qui s’est tant fait attendre

- Et la version 0.8.6, vite vite

- NetRadiant, revenu d’entre les morts

- Merci S2TC pour le service rendu

- Xonotic enfin dans la Wikipédia francophone

- Xonotic comme outil de travail ?

- Jouer à Xonotic !

Première décennie pour Xonotic, et 18 ans de jeu libre

Xonotic a eu 12 ans en septembre 2023 ! Xonotic a en effet soufflé ses 10 bougies le 8 septembre 2021. Xonotic étant lui-même un fork et une continuation du jeu Nexuiz, on peut aussi fêter depuis le 31 mai 2023, les 18 ans de développement et de jeu libre que ces deux projets successifs ont apporté au monde ! 18 ans ? À quand le droit de vote ?

L’histoire de Xonotic ne fut pas de tout repos et avec de nombreux hauts et bas ! Après une première version de Nexuiz en 2005 et une croissance spectaculaire, la vente du nom Nexuiz en 2010 avait contraint les contributeurs à trouver un nouveau nom, Xonotic, pour continuer à faire vivre le jeu, perdant immédiatement toute la renommée acquise associée à la marque, l’image de marque et la notoriété de la marque. Mais le phœnix a su renaître de ses cendres (d’où le logo de Xonotic) ! Le projet Xonotic peut désormais se vanter d’avoir publié pendant trois fois plus longtemps (déjà 12 ans) que ne l’a fait Nexuiz (4 ans).

La version 0.8.5 qui s’est tant fait attendre

La dernière version annoncée dans ces pages fut la version 0.8.2, publiée en avril 2017. La version suivante, sautant directement à la version 0.8.5, ne fut publiée qu’en 2022, le 30 juin exactement, 5 ans plus tard ! Ce qui est très long. Cette version 0.8.5 se fit beaucoup attendre. Il semble qu’un certain creux a affecté plusieurs projets de jeux libres ces années-là, comme Unvanquished qui avait attendu entre 2018 et 2021 (trois ans !) pour sortir une nouvelle version et revenir sur des publications moins espacées. Pourtant, le développement ne s’est jamais arrêté et fut très actif pour ces deux projets, mais les ressources pour faire aboutir le processus de publication semblent avoir manqué dans ces années-là !

| Bromine | Opium |

|---|---|

|

|

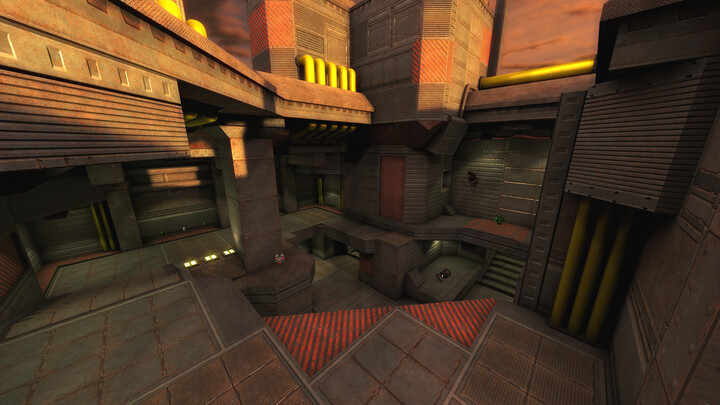

Les nouvelles cartes Bromine et Opium.

La version 0.8.5 avait apporté beaucoup de polissage du game play, et le mode duel était devenu un mode de jeu à part entière (et pas seulement un match à mort à deux). Ça signifie qu’il est possible de définir des paramètres propres aux duels et de traiter les statistiques séparément. Le mode de jeu Freeze Tag avait reçu plein de petites améliorations. Du côté des bots, le niveau de compétence a été augmenté et la navigation sous-marine corrigée, et pour la navigation terrestre, la capacité à sauter et s’accroupir fut implémentée. Deux cartes furent ajoutées : Bromine par packer et Opium par cityy. Les cartes Drain et Oilrig furent conservées mais cachées par défaut en vue d’un retrait lors d’une version future. Les autres cartes avaient reçu plein de correctifs et d’améliorations. De très nombreux modèles avaient été refaits par Morphed. Du côté de XonStat, le logiciel de statistique des parties, des joueurs et des serveurs Xonotic, eh bien… il fut entièrement réécrit de zéro ! Le code est passé de Python à Go et beaucoup d’erreurs de conception corrigées. Le système de calcul de comparaison d’expérience de joueur est passé de Elo à Weng-Lin. Le jeu affiche désormais un dialogue « Terms of Service » lors de la première utilisation expliquant quelles données sont requises et lesquelles sont optionnelles. Du côté du moteur, un mode d’accélération de souris à la Quake Live a été ajouté. L’éditeur de niveau NetRadiant qui a subi un fort regain d’activité pendant le cycle de développement de la version 0.8.2 a désormais son propre site et son cycle de développement, mais ça on en reparlera dans le chapitre dédié.

Il est impossible de tout mentionner, donc les curieux et les historiens pourront consulter l’annonce de la version ici.

Et la version 0.8.6, vite vite

Xonotic 0.8.6 est sortie le 20 juin 2023, tout juste un an après la version 0.8.5. Un bug affectant les versions inférieures à la version 0.8.6 fut découvert et corrigé, bug qui pouvait être exploité par des administrateurs de serveurs malintentionnés pour faire planter les clients, et éventuellement, s’ils parvenaient à contourner certaines protections, à exécuter du code arbitraire. Aucun code exploitant cette faille n’est connu, mais il ne fallait pas attendre plus longtemps pour sortir une mise à jour et encourager tout le monde à faire cette mise à jour !

| Go | Trident |

|---|---|

|

|

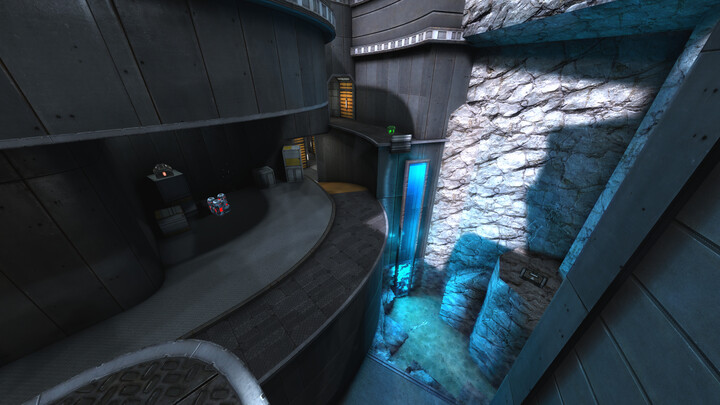

Les nouvelles cartes Go et Trident.

La version 0.8.6 a ajouté deux nouvelles cartes : Go par dublpaws et Debugger et Trident par proraide. Il est possible de proposer une carte pour inclusion qui sera alors soumise à un vote, il est nécessaire que la carte et ses données soient entièrement libres. Comme prévu depuis la 0.8.5, les cartes Drain et OilRig sont désormais retirées. Trois nouveaux modes de jeux furent ajoutés : Mayhem, Keepaway et Survival. D’autres modes de jeux déjà existants ont reçu beaucoup de soin. La campagne solo a reçu un gros travail de refonte ! De nouvelles fonctionnalités de bannissement et de modération furent ajoutées, en particulier la capacité d’ignorer les paroles d’un autre joueur. De nombreux effets visuels ont été retravaillés, et les annonces sont désormais placées dans une queue pour éviter que deux annonces soient exprimées simultanément. En continuation de la version 0.8.5, la compatibilité avec les cartes de Quake III Arena a été améliorée.

Autour de la version 0.8.5 et la version 0.8.6 le développement du moteur de jeu DarkPlaces a reçu de nombreuses contributions, rendant moins nécessaire la migration précédemment planifiée vers le moteur Dæmon (le moteur du jeu Unvanquished). Xonotic se recentre donc sur DarkPlaces !

Du côté de l’éditeur de niveau NetRadiant, l’expérience d’édition et l’intégration du jeu Xonotic fut améliorée.

NetRadiant, revenu d’entre les morts

Si Xonotic est un Phœnix, que dire de NetRadiant, l’éditeur de niveau des jeux comme Xonotic, Smokin' Guns ou Unvanquished ? NetRadiant est un très ancien projet à l’histoire très compliquée, fork communautaire de GtkRadiant, lui-même libération de Q3Radiant par id Software, aussi connu sous le nom de QERadiant, héritant son nom de QuakeEd, l’éditeur de niveau pour Quake interne à id Software… qui tournait sous NextStep. De NextSTEP à GTK en passant par les MFC de Windows, déjà on se dit que le code en a vu et pas que des belles. Mais si je commence à parler des forks… en fait non, ne parlons pas des forks, encore un logiciel conçu pour être forké, ça alors…

L’éditeur NetRadiant était LE projet communautaire à l’époque de Nexuiz : l’éditeur de choix pour Nexuiz bien entendu, mais aussi pour Tremulous, Warsow, et autres jeux héritant du code d’id Software (générations Quake 1 à 3 et Doom 3). Bien qu’utilisé par les mappeurs de Nexuiz, il n’était pas officiellement maintenu par Nexuiz. Lorsque le projet Xonotic a repris et continué le développement du jeu Nexuiz sous le nom Xonotic, il fallait bien un éditeur et le projet Xonotic a adopté NetRadiant. Mais le développement de l’éditeur était vraiment secondaire, et avait beaucoup ralenti. Sous l’impulsion du projet Unvanquished, le développement a reçu un sérieux gain d’activité !

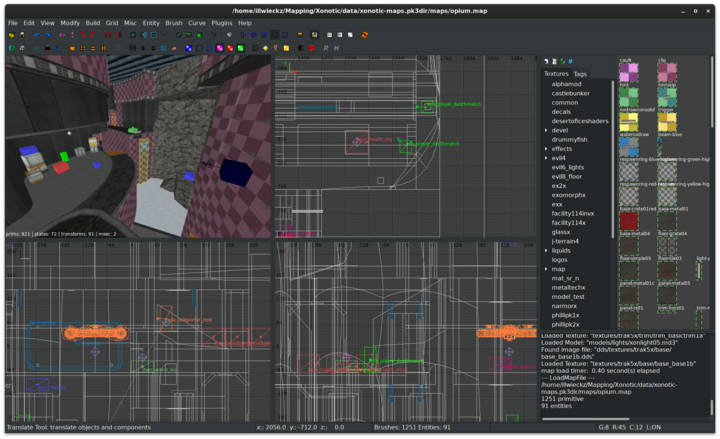

NetRadiant éditant la carte Opium de Xonotic.

NetRadiant est désormais fonctionnel non-seulement sous Windows et Linux mais aussi sous macOS et ce sans XQuartz, ce qui requiert des bidouilles très sales mais qui fonctionnent.

Un peu plus tard après la reprise du développement, un fork a fait surface, NetRadiant-Custom, basé sur une version ancienne de NetRadiant, et difficile à fusionner : le projet NRC était non seulement basé sur une ancienne version déjà incompatible, mais le développement s’est fait pendant des années sans VCS, et l’historique plus ou moins reconstruit est un enfer à fusionner. Certains changements du fork NetRadiant-Custom ont été fusionnés récemment, mais il faudra penser à de nouvelles façons d’opérer cette fusion car actuellement la masse de travail est plus élevée que ce que la main d’œuvre peut encaisser.

Merci S2TC pour le service rendu

L’impact de certains projets libres sur le monde est parfois plus grand qu’il n’y parait. Saviez-vous que la police Xolonium, créée tout spécialement pour Xonotic par sev (un développeur de longue date de Xonotic), est utilisé par Asus pour la sérigraphie de certains de ses claviers de sa gamme ROG (Republic of Gamers) ? Mais ce n’est pas de cela que l’on va parler.

Les plus jeunes l’ignoreront peut-être, les plus vieux l’auront oublié, mais la quasi-totalité des jeux étaient injouables sous Linux sans se soumettre à certains brevets. Les brevets logiciels en cause ? Ceux utilisés dans l’algorithme de compression de texture S3TC. S3TC est un algorithme de compression très ancien (ça existe depuis au moins OpenGL 1.3 et DirectX 6) tellement utilisé que même s’il n’a jamais fait partie du tronc d’une version d’OpenGL, un pilote qui implémenterait complètement le standard mais qui n’implémenterait pas cette extension serait perçu comme incomplet.

Le grand avantage des textures S3TC (S3 Textures Compression) c’est qu’elles sont non-seulement compressées sur les supports de stockages (CD, disque dur…) avec le gain de place en stockage ou de temps de téléchargement du jeu si le jeu est téléchargeable, mais ces textures sont également envoyées compressées à la carte graphique (gain de temps au chargement du jeu !), et mieux encore, elles sont conservées compressées dans la mémoire de la carte graphique et les calculs se font directement à partir des textures compressées à l’intérieur de la carte graphique ! Ça signifie un gain de place en mémoire graphique et donc la capacité d’utiliser de hautes résolutions avec un coût en mémoire mesuré. Ça explique pourquoi quasiment tous les jeux utilisent ce genre de technique. Un conteneur populaire pour ces images sont les fichiers .dds, DDS pour DirectDraw Surface.

Mais voilà, les brevets logiciels ne sont pas illégaux partout, et il était donc impossible d’implémenter S3TC dans Mesa, la collection de pilotes libres de carte graphique utilisés sous Linux.

Il existait une bibliothèque tierce qui prenait en charge S3TC et que les pilotes Mesa savaient utiliser si par un heureux hasard elle se trouvait installée à côté, mais ça ne résolvait toujours pas le problème de la distribution et donc elle n’était pas installée par votre distribution, c’était à vous de vous la procurer où vous savez.

Xonotic faisant un usage intensif de ces textures S3TC, mais Xonotic étant un jeu libre, entièrement libre, requérir un pilote non-libre (comme les pilotes Nvidia ou fglrx d’ATI à l’époque) ou nécessiter que les joueurs bricolent leur système, ça n’était pas satisfaisant et c’était très gênant au quotidien. Deux développeurs de Xonotic, Maik Merten et Rudolf Polzer (divVerent) se sont mis en tête d’implémenter une fonctionnalité similaire et compatible, mais en évitant de mettre les pieds dans ces brevets !

Et ils y ont réussi, le logiciel s’appelait S2TC (Super Simple Texture Compression). S2TC est arrivé en 2011. Le logiciel fournissait une bibliothèque capable de lire des fichiers S3TC de manière suffisante pour que ça ressemble au résultat attendu, ainsi qu’un convertisseur d’image capable de compresser des images de manière à ce qu’elles soient lisibles par la fonctionnalité S3TC des pilotes et cartes graphiques, quand bien même la qualité ne serait pas aussi bonne, mais suffisante. Les plus taquins parmi les plus anciens pourront rétorquer avec malice que de toute façon, ça ne pouvait pas être pire que ce que ce que produisait le bug matériel des GeForce de chez Nvidia qui réduisait à 16-bits la précision des images DXT1 32-bits.

Sur le plan technique, comparé à S3TC l’implémentation S2TC avait des avantages et des inconvénients. Par exemple il n’y avait pas d’interpolation entre les couleurs, donc le résultat était moins léché, mais puisque l’implémentation était plus simple, elle était aussi plus performante. Mais la victoire incontestable est qu’il était désormais possible de produire des images compatibles S3TC avec un logiciel libre et sans brevet, et qu’il était possible de lire des images S3TC avec un logiciel libre et sans brevet ! C’était il y a 11 ans déjà et antistress nous en avait parlé dans une dépêche.

En 2012 Valve (l’éditeur de Steam et opérateur du marché éponyme) avait fait pression sur Ubuntu pour distribuer S2TC, car ils en avaient besoin pour étendre sous Linux leur marché de jeu vidéo ! Les autres distributions avaient suivi.

On mesure parfois assez peu comment certaines personnes et certains projets peuvent changer la face du monde de manière aussi profonde. Si vous avez joué à un jeu acquis sur Steam ces dix dernières années, vous pouvez remercier Xonotic d’avoir participé à rendre cela possible. En produisant S2TC le projet Xonotic a fait gagner 6 ans aux joueurs sous Linux, y compris à tous ceux qui n’ont jamais joué à Xonotic mais ont joué à certains des milliers d’autres jeux sur le marché. C’est considérable. Sans S2TC, la viabilité de Steam sous Linux aurait été très différente et aurait probablement dû attendre 2017 au lieu de 2013 pour être utilisable au déballage dans nos distributions favorites.

En 2017, les derniers brevets sur S3TC ont expiré. Mesa intègre désormais une implémentation complète de S3TC et l’implémentation S2TC n’est plus nécessaire dans les pilotes.

Pour son outil de compression pour produire ses images DDS, le projet Xonotic est passé de l’outil s2tc à Crunch, qui produit des images compressées de meilleure qualité. La chaine de production utilise la branche maintenue par le projet Unvanquished pour le moteur de jeu Dæmon, cette branche intègre les améliorations réalisées par les développeurs du moteur de jeu (propriétaire) Unity. Crunch est un logiciel libre (license Zlib).

Au revoir donc, et merci à toi S2TC pour ce temps passé à rendre possible tant de parties de jeu vidéo pendant tant d’année, et merci à toi S2TC d’avoir rendu possible de produire des images compatibles S3TC pendant tant d’années.

Et merci au projet Xonotic et à ses développeurs Rudolf Polzer et Maik Merten d’avoir réalisé tout cela !

Xonotic enfin dans la Wikipédia francophone

En janvier dernier, les lecteurs assidus auront repéré dans les journaux un bien curieux article intitulé si on ne fait rien, Xonotic va disparaitre de Wikipedia FR.

Il se trouve que la page Xonotic dans la Wikipedia francophone avait déjà été supprimée deux fois, le 4 mai 2010, et le 5 juillet 2015. Il semble que la première suppression avait été faite sans discussion et avec pour motif invoqué « Critères d’admissibilité non atteints », et la seconde suppression avait fait l’objet d’un débat avec des arguments de type « peu de source notable » ou encore « pas d’intérêt encyclopédique ». La troisième tentative de suppression fut initiée le 25 janvier 2023 avec pour simple argument que la page avait déjà été supprimée avant. Ce ne fut d’ailleurs pas le seul argument où la suppression pouvait motiver la suppression : la suppression précédente de la page Xonotic ayant entrainé le détournement de la page Nexuiz pour y rédiger les informations au sujet de Xonotic, le constat que la page Xonotic n’apportait donc rien de plus que ce que la page Nexuiz rapportait de Xonotic aurait pu servir à supprimer la page Xonotic…

Cela a suscité divers débats dans les commentaires sur LinuxFr, par exemple sur le fait qu’il est plus facile de supprimer un article au prétexte qu’il ne référence pas encore assez de sources plutôt que de référencer ces mêmes sources, ou encore qu’un partisan de la suppression peut lancer un vote de suppression et attendre simplement que personne ne réponde, avec le déséquilibre que les acteurs de la suppression soient potentiellement les seuls à être au courant de l’enjeu. Les discussions ont aussi porté sur le désintéressement des membres de la communauté des utilisateurs de logiciels libres à la rédaction sur Wikipédia, ce qui semble inattendu et contradictoire étant donné que Wikipédia est une œuvre libre et le logiciel de Wikipédia, un logiciel libre. Certaines personnes ont relevé des problèmes spécifiques à la communauté Wikipédia francophone, recommandé de préférer l’anglais ou rapporté ne plus contribuer qu’aux pages anglophones en conséquence, ce qui conduit à considérer l’encyclopédie Wikipédia francophone comme moins fiable, ayant plus confiance dans la version anglaise passée au filtre d’un traducteur et de l’intelligence artificielle que dans la version francophone.

La page Xonotic a finalement été conservée, peut-être en partie grâce aux sources recherchées et référencées pendant des années, mais surtout parce que cette fois-ci aucun vote en faveur de la suppression n’a été enregistré, alors que le précédent vote n’avait enregistré que des votes en faveur de la suppression, ce qui ressemble plus à un rapport de force au tir à la corde qu’au fruit d’un travail intellectuel. Il aura fallu 11 ans entre la perte du nom Nexuiz et la capacité à avoir une page sur la Wikipédia Francophone pour le nouveau nom Xonotic. C’est comme si seule la notoriété de la marque n’avait pu compter pendant ces 11 années. Mais tout est bien qui finit bien !

Xonotic comme outil de travail ?

Mais si, je t’assure que je travaille, là… Mode « CTS » (complete the stage) lors de l’édition 2023 de la Xonotic Defrag World Championship.

Si l’intérêt encyclopédique de Xonotic a été remis en cause, son intérêt académique a toujours été pleinement considéré et apprécié. En tant que logiciel libre, Xonotic permet entre autres l’étude, l’extension et le prototypage, ce qui permet de l’intégrer très facilement à un autre travail. Xonotic sert régulièrement de support de recherche ou comme environnement de projet de recherche. Le jeu est cité dans de nombreux papiers, traitant de sujets pas toujours informatiques (exemple : reconnaissance d’émotion, étude de réponse physiologique…), mais aussi de manière plus attendue comme banc d’essai d’étude de prédiction réseau, de techniques de rendu ou de traitement graphiques, de consommation énergétique ou de virtualisation.

De nombreuses références sont désormais citées dans la page Wikipédia francophone au sujet de Xonotic, et puisque cette page existe désormais, profitons-en et laissons-lui la charge d’aiguiller le lecteur vers ces articles. L’article Xonotic en français sur Wikipédia est désormais l’article le plus étoffé et le plus sourcé sur ce sujet comparé à toutes les autres langues, alors autant qu’il serve !

Et si vous êtes vous-même chercheur et que vous avez travaillé avec Xonotic, n’hésitez pas à partager votre expérience et à référencer votre travail ! Et si vous cherchez un jeu pour implémenter vos expérimentations, vous savez que des jeux libres comme Xonotic, Unvanquished et d’autres sont de parfaits candidats !

Jouer à Xonotic !

En attendant d’autres nouvelles, que ce soit de Xonotic, ou d’un autre jeu, on peut télécharger Xonotic et y jouer !

Aller plus loin

- Télécharger et jouer à Xonotic (184 clics)

- Xonotic dans l’encyclopédie Wikipédia francophone (86 clics)

- L’annonce de Xonotic 0.8.6 (61 clics)

- Les 10 ans de Xonotic (41 clics)

# Les vrais savent… 😎️

Posté par Thomas Debesse (site web personnel, Mastodon) . Évalué à 8.

Cette dépêche est un complot ! 🤭️

Plus sérieusement, je suis content d’avoir trouvé le temps de rédiger et soumettre cette dépêche qui me trottait dans la tête depuis plusieurs années. Merci à la modération pour le travail de relecture, etc.

Si un jour se présente l’occasion de prendre un pot avec l’équipe de modération, pourrais-je dire que je consomme avec modération ?

J’ai repéré une petite erreur dans le chapô:

ce commentaire est sous licence cc by 4 et précédentes

[^] # Re: Les vrais savent… 😎️

Posté par Benoît Sibaud (site web personnel) . Évalué à 6. Dernière modification le 18 novembre 2023 à 17:20.

C'est le mieux-dixans qui l'emporte. Corrigé, merci.

[^] # Re: Les vrais savent… 😎️

Posté par deuzene (site web personnel) . Évalué à 2.

Tu aurais dû mettre ton nal sous licence Beerware, je t'aurais payé un jus de pomme (je ne fais pas partie des modos).

« Il vaut mieux mobiliser son intelligence sur des conneries que mobiliser sa connerie sur des choses intelligentes. »

# Wikipédia

Posté par abriotde (site web personnel, Mastodon) . Évalué à 8.

J'ai déjà été confronté à ce problème, c'est assez ridicule et scandaleux cette volonté "élitiste" de ne garder que les articles très complet et sur des sujets bien documentés et très "connu".

J'ai plusieurs pages qui ont été supprimé pour ces motifs alors même que les pages existaient sur la version anglophone.

Une encyclopédie est censé représenté tout le savoir existant de l'humanité…

Sous licence Creative common. Lisez, copiez, modifiez faites en ce que vous voulez.

[^] # Re: Wikipédia

Posté par papap . Évalué à -9.

je confirme qu'il y a des nombreux problèmes sur Wikipédia qui, de ce fait, ne peut plus être considérée comme une source fiable.On en a déjà parlé ici même.

[^] # Re: Wikipédia

Posté par Thomas Debesse (site web personnel, Mastodon) . Évalué à 10. Dernière modification le 19 novembre 2023 à 09:26.

C’est un risque qui guette les initiatives communautaire, et je ne serais pas surpris si culturellement il n’y aurait pas une forme de prédisposition bien française. C’est un risque qui guette LinuxFr aussi : la publication d’un article de qualité et fouillé rend plus exigeant. Les lecteurs, les rédacteurs avec eux-même, les modérateurs, au risque de se retrouver piéger soi-même : difficile de faire moins recherché que le précédent. On l’a vu avec les dépêches sur le noyau ou les dépêches GNOME : on a eu des articles excellents et incroyablement recherchés, rédigés et détailles, mais il est extrêmement difficile de passer après ça. Je me souviens d’avoir un jour imprimé un tel article en livret pour le lire pendant mon voyage. C’est excellent, mais on ne peut exiger à chaque rédacteur de produire cela. Sur les même sujets d’article la comparaison en souffre immédiatement, et sur les autres sujets, par effet de bord, on peut en ressentir la pression. Le simple fait que que ce qui serait un dossier complet dans un magazine est appelé « dépêche » ici témoigne de cette tendance. Certains diront que j’ai pu contribuer par certains de mes articles à nourrir cette pression. 🤭️ C’est aussi pour ça que je suis lucide, un jour (il y a longtemps déjà) je me suis pris une remarque en rédaction que mon article pourrait creuser plus (oups 😅️). Et vraiment, je peux dire que ça a changé ici. Sur LinuxFr ça a été discuté plusieurs fois et je vois clairement un effort de combattre ce risque : certaines dépêches largement suffisantes sont désormais publiées même si moins fouillées et c’est très bien de revenir à ça. Un avantage qui profite à LinuxFr mais pas à Wikipédia est que puisque LinuxFr est un site d’actualité, les articles se suivent dans le temps et se remplacent dans les mémoire. Un article qui a relevé le niveau il y a 10 ans est un article qui est 10 ans derrière dans les archives, alors que sur Wikipédia un tel article est toujours au premier plan et met toujours la même pression sur les nouveaux articles.

Tiens d’ailleurs, ça me donne une idée pour LinuxFr, de laisser la possibilité à la modération d’apposer une étiquette « dossier » sur certains articles, afin de montrer que certains articles n’en sont pas et que c’est tout à fait normal. Je ne pense pas qu’il faille dissocier les dépêches en deux fils d’actus différents, un seul fil pour les publications modérées est très bien, mais on pourrait visuellement marquer les gros dossiers et les dépêches plus « dépêches ».

Wikipédia pourrait aussi faire quelque chose de similaire : tous les articles n’ont pas besoin d’être des thèses universitaires, les récompense de qualité basées sur la taille du texte et le nombre de sources ne sont pas nécessairement des objectifs pour tous les articles. Une information factuelle courte est largement suffisante pour de très nombreux sujets, et parfois c’est même plus efficace.

ce commentaire est sous licence cc by 4 et précédentes

[^] # Re: Wikipédia

Posté par thoasm . Évalué à 6.

Pour nuancer, la volonté n’est pas forcément une volonté d’élitisme, en tout cas pour tout le monde, mais la véritable contrainte est sur la fiabilité.

Contrairement à ce que raconte papap< en dessous, la fiabilité n’est pas vraiment remise en cause par l’exigence de qualité, plutôt le contraire, parce que la volonté est d’éviter les sources non fiables comme les sites de désinformations. Du coup il y a de nombreux sites ou sources qui sont un peu dans une zone ou on ne peut pas forcément assurer qu’ils ont des exigences de filtrage qui permet de filtrer la désinformation qui peuvent être affectés. Par effet de bord, comme pour juger de l’admissibilité on jauge de la qualité des sources, des sujets pas couverts par des sources avec des exigences minimales comme un comité de lecture ou autre, peuvent être jugés non suffisant. C’est potentiellement le cas de sites communautaires peu connus ou de contenus venant uniquement des partis-prenantes d’un projet qui peuvent être soupçonnés de manque de recul ou d’autopromotion bien souvent.

Évidemment des profils comploplo comme papap< vont être en désaccord avec ce type de politiques, vu que les sites comploplo ne passent pas la barre, et c’est dénoncé par ces gens comme une invisibilisation de leur point de vue. Mais Wikipédia n’a jamais voulu refléter les points de vues farfelus tenus uniquement par leurs promoteurs sur des bases faibles, c’est ce qui fait qu’il résiste un peu à la désinformation ambiante … mais il peut y avoir des dégâts collatéraux. Pas une barre sur la qualité des sujets, bien qu’il puisse y avoir eu ce genre de tendance, la véritable barre est à mon avis la barre pour juger de la fiabilité dans un monde post-vérité.

[^] # Re: Wikipédia

Posté par papap . Évalué à -10. Dernière modification le 19 novembre 2023 à 15:32.

Bien faut voir quelle est la définition d'un site ou d'une information "complotiste" ou "les points de vues farfelus". C'est Elon Musk qui a dit il y a peu : "tous les complots dénoncés par Twitter se sont avérés vrai"…

[^] # Re: Wikipédia

Posté par thoasm . Évalué à 7.

Notoirement celui des juifs vampires qui violent le sang des vierges pour le revendre aux reptiliens pédophiles wokistes.

[^] # Re: Wikipédia

Posté par papap . Évalué à -6.

quand on commence à dire des âneries, on ne s'arrête pas…

[^] # Re: Wikipédia

Posté par thoasm . Évalué à 4.

Ça c'est les gens complètement incapables d'admettre qu'ils peuvent parfois avoir tort, ou que les blagues mêmes bonnes sont meilleures quand elles ont une fin !

[^] # Re: Wikipédia

Posté par papap . Évalué à -1. Dernière modification le 21 novembre 2023 à 15:10.

"Notoirement celui des juifs vampires qui violent le sang des vierges pour le revendre aux reptiliens pédophiles wokistes." Parce que ça c'est une blague "même bonne" ? On n'a pas le même sens de l'humour.

[^] # Re: Wikipédia

Posté par thoasm . Évalué à 6.

C’est une exagération qui se veut en principe manifestement ridicule pour tout le monde par son côté excessif, mais qui reprend des choses qu’on peut lire sur Twitter et ailleurs.

Si ce genre de choses ridicules et sans fondement circule sur Twitter, autant dire que non, tout ce qui se passe par X ne se révèle pas vrai. C’était supposé mettre en lumière, évidemment pas sérieux, après ça n’en fait pas forcément une blague pour autant.

[^] # Re: Wikipédia

Posté par Thomas Debesse (site web personnel, Mastodon) . Évalué à 10.

Bon j’avais écrit ce commentaire hier, puis j’ai eu d’autres priorités dans ma vie™ et je ne l’ai pas posté.

Quand je reviens, je retrouve un échange de « c’est toi qui le dit c’est toi qui l’y es » de cour de récré, ce qui me confirme ce que j’avais pressenti : que ton commentaire ne pouvait conduire qu’à un échange stérile, de par la façon dont tu antagonises et essentialises les parties. En simple : tu supposes qu’il y a un complot de complotiste, donc tu ne fais pas mieux, tu obtiens exactement ce que tu recherches, et j’espère que tu ne pensais pas donner une bonne image de Wikipédia avec ton commentaire parce que l’idée de Wikipédia que tu présentes est précisément cause de tels antagonismes et essentialismes stériles. Dans mon commentaire, ci-après, je prends volontairement un exemple dit « comploplo » et d’autres non, pour montrer que le nœud du problème est bien plus profond que ça. S’arrêter en surface c’est s’assurer de ne pas pouvoir traiter les problèmes de fonds.

Je peux ajouter à mon commentaire : Brandir le drapeau « comploplo », c’est s’assurer que le débat ne porte que sur ce sujet, ce qui permet de ne pas traiter les autres sujets, ou les sujets plus profonds, ce qui construit, volontairement ou non, une forme de déni.

Pour moi la véritable vulnérabilité de Wikipédia, ce ne sont pas les jeux de pouvoir, mais le déni de ces jeux de pouvoir.

Par exemple là tu dis que « la véritable contrainte est sur la fiabilité », puis tu parles de « comploplo », ce qui est un peu le point Godwin des œuvres de connaissances à la Wikipédia. Atteindre un point Godwin ou brandir l’argument qui le fait atteindre c’est abdiquer devant ces jeux de pouvoirs et donc leur laisser les pleins pouvoirs. Tu dis également qu’« il y a de nombreux sites ou sources qui sont un peu dans une zone ou on ne peut pas forcément assurer qu’ils ont des exigences de filtrage qui permet de filtrer la désinformation », comme si le seul enjeu était un duel information/désinformation, que la seule cause d’erreur dans Wikipédia proviendrait d’une volonté de désinformation et que le seul outil contre les erreurs dans Wikipédia ou dans les sources de Wikipédia est le filtrage. C’est extrêmement réducteur. Il me semble que Wikipédia est un outil et une œuvre de recueil et de consolidation de la connaissance, le fait que cette connaissance soit une information, une désinformation ou une réinformation est déjà dans un degré second, c’est un rapport à cette connaissance, pas la connaissance elle-même. La connaissance ça se construit, et il peut y avoir des erreurs, des approximations, des intentions de nuire, et des erreurs sincères, ça s’affine, ça se discute, ça se confronte. Un chercheur qui contredit quelque chose de considéré comme acquis ou qui redéfinit les limites d’un élément de connaissance, il ne se place pas dans une dialectique information/désinformation, et son outil ce n’est pas le filtrage, mais un exercice de pensée qui analyse, confronte, vérifie, etc. Et la raison produit bien plus d’outils que le simple filtrage (lui-même vulnérable par ailleurs).

Pour revenir au déni, illustrons un point particulier dont peut souffrir Wikipédia en tant que champ de bataille de jeux de pouvoirs, avec des exemples grand-public. Si je dis « blanchiment d’information », il y a quelques années, certains auraient prêtés une oreille attentive, peut-être même parmi les wikipédistes qui ont pour volonté de faire de Wikipédia une source d’information sure et fiable, peut-être même toi. Mais ce terme a été employé par une personnalité bien connue (certains diront controversée) : Idriss Aberkane. Et donc maintenant utiliser cette expression est suspecte. Je prends pour exemple cet article de 2022 dans Libération. Titre : « «Blanchiment de fausses informations» : comment Idriss Aberkane fantasme Wikipédia », citation : « L’essayiste controversé a accusé le site de fact-checking «Fact & Furious» d’avoir été créé pour produire de fausses informations destinées à être reprises dans la presse, pour pouvoir être citées dans l’encyclopédie en ligne. ». Plus loin l’article parle de « trame complotiste ». C’est pour ça que je prends cet exemple exprès parce que c’est un exemple qui correspond à ton expression « comploplo ». L’expression « blanchiment d’information » parce qu’utilisée par telle personnalité, devient un marqueur « comploplo ».

Pourtant cette expression existait bien avant. Dans la galaxie Wikpédia, le wiktionary francophone a une entrée pour cette expression, avec une citation tirée d’un article du Monde de 2019, donc trois ans avant que cette expression ne devienne un marqueur « comploplo ». Titre : « Marlène Schiappa et le « blanchiment » de l’information parodique », citation : « Le blanchiment d’information est un phénomène de plus en plus courant. Les administrateurs du célèbre Gorafi, par exemple, en ont fait l’expérience le 24 avril 2017, lorsqu’une interview imaginaire d’Emmanuel Macron rédigée un an plus tôt avait resurgit en tête des articles les plus lus du site à la faveur de nombreux relais sur des pages Facebook d’extrême droite. ».

Brandir le drapeau « comploplo » et tout voir sous l’angle de l’information/désinformation, c’est passer à côté du problème et donc ne pas pouvoir y faire face correctement : Wikipédia fait partie d’un monde soumis à des jeux de pouvoirs, et donc Wikipédia subit ces jeux de pouvoirs et est le terrain de ces jeux de pouvoirs. Des tas de gens bien intentionnés pourront en toute honnêteté reporter une information, peut-être même abondement sourcée, qui pourrait ne pas être totalement juste ou même être totalement fausse, et chacun pourra être intimement convaincu de ce qu’il apporte. Et les idéologues de tout bord d’être persuadés d’être dans le camp du bien. Brandir le drapeau « comploplo » c’est simplement abdiquer devant ces jeux de pouvoirs. C’est aussi une posture « comploplo » en fait. C’est supposer que Wikipédia est un camp du bien alors que ce n’est pas un camp, Wikipédia est un terrain où s’affrontent des camps qui pensent tous être des camps du bien.

Le risque c’est que dire que Wikipédia est soumis à des jeux de pouvoirs soit désormais vécu comme une attaque envers Wikipédia. Le risque c’est qu’au lieu de se servir de ce constat pour mettre en œuvre des méthodes de travail pour encaisser les jeux de pouvoir et ressortir par le haut, et produire une meilleure expression et synthèse de la connaissance, certains se positionnent alors comme victimes et fassent entrer Wikipédia dans de ce jeu de pouvoir.

Avant, dire que Wikipédia peut servir à du blanchiment d’information était vécu comme un constat constructif pour faire de Wikipédia une œuvre mieux vérifiée en étant plus rigoureux dans la rédaction, la relecture, la compréhension de l’information rapportée, et la vérification des sources.

Aujourd’hui, dire que Wikipédia peut servir à du blanchiment d’information est vécu par certain comme une attaque contre Wikipédia et contre leur personne, attaque qui mérite une défense, ou un déni.

Ce sont deux manières de vivre le même événement, le second est celui qui est le moins constructif pour Wikipédia, et la seconde manière est la plus propice à ce que les uns traitent les autres de « comploplo » comme tu le fais.

Dire que Wikipédia est le terrain de jeux de pouvoirs n’est pas « comploplo », c’est un fait public. Pour poursuivre dans la défense de cette idée je vais ajouter deux exemples.

Premier exemple, avec d’abord un rappel factuel sur le fonctionnement de Wikipédia : Wikipédia externalise la production de l’information (le travail original doit être en référence, pas sur Wikipédia, donc la production de l’information est externalisée de fait). Les articles de presse sont donc des lieux privilégiés de production d’information, et le rédacteur d’un article de presse est soustrait à l’exigence « référence nécessaire » de Wikipédia et peut mettre cela à profit. Dire cela n’est pas « comploplo », c’est observer le fonctionnement des diverses entités dans l’environnement où elles évoluent, ce qui permet d’identifier les failles possibles, y compris pour y remédier (par exemple en étant plus exigeant avec ce que produit la presse si on désire que Wikipédia soit plus fiable). Ceci rappelé, je prends pour référence cet article de Fakir de 2022, intitulé « Moi, journaliste fantôme au service des lobbies » où un journaliste témoigne des commandes qu’il reçoit. L’auteur commence son article en témoignant d’une une commande qu’il a reçue pour « dézinguer François Ruffin ». On n’est pas du tout dans la sphère Aberkane, là. Cet article ne parle même pas de Wikipédia en fait, donc ça n’est pas censé être vécu comme un article à charge contre Wikipédia, mais ça parle du processus de fabrication de ce que Wikipédia considère comme une source. Je produis ici une observation conduisant à identifier une vulnérabilité dans le processus de rédaction de Wikipédia, non pour attaquer Wikipédia, mais pour y chercher un traitement adéquat dans le but de rendre Wikipédia meilleure. Cet article identifie une faille dans la production de ce que Wikipédia considère comme la garantie de l’inclusion et du maintien d’une connaissance dans Wikipédia.

Deuxième exemple, très explicite, il n’y a qu’à citer littéralement. Je prends pour référence l’article de Consultor de 2022 et intitulé « Bad buzz : McKinsey cherche un pompier pour nettoyer sa réputation ». Je cite : « C’est dans ce contexte que La Lettre A […] s’est procuré un document de 15 pages signé par la directrice de la communication de McKinsey […]. Il indique que ce marché doit être attribué avant la fin du mois de décembre. […] Objectif pour les cabinets sollicités […] : « infléchir la perception de McKinsey en ligne », notamment dans les résultats Google et sur l’encyclopédie en ligne Wikipédia, identifier des influenceurs bienveillants, réseauter auprès de relais d’opinion, exploiter plus intensivement les réseaux sociaux de la firme en France […] ».

Le monde dans lequel on vit a parfaitement intégré comment faire apparaître une information dans Wikipédia, ça fait des appels d’offre en ce sens, ça recrute en ce sens, ouvertement. Le métier d’infléchisseur d’opinion par l’usage d’intermédiaires (ici appelés « influenceurs » mais ça peuvent être des journalistes comme on le voit avec l’article de Fakir) qui produiront du contenu qui pourront servir à faire modifier le contenu de Wikipédia. Produire les références de Wikipédia est un véritable métier.

À une volonté qui prétend être soumise à une « contrainte de fiabilité » mais qui parlerait de « comploplo » pour ses adversaires, je peux poser la question : est-ce que cette volonté fait partie de ces jeux de pouvoirs, ou est-ce que cette volonté est témoin de ces jeux de pouvoirs ?

Il me semble que Wikipédia est témoin de ces jeux de pouvoirs, ou du moins, il vaut mieux qu’elle le soit. Wikipédia subit nécessairement ces jeux de pouvoirs, mais antagoniser Wikipédia comme tu le fais est problématique. Il me semble plus efficace et constructif d’accepter cet état de fait que de travailler à placer Wikipédia dans un camp du bien (et donc de faire partie de ces jeux de pouvoirs), en plus du fait que ce placement t’est subjectif et donc en partie arbitraire. Il me semble pourtant que c’est plus constructif car ça permet d’être moins affectif dans l’exercice de rédaction, de relecture, de reformulation. Se placer comme observateur extérieur c’est être moins vulnérable à ces jeux de pouvoir, c’est aussi se permettre d’être mieux capable de décrire ces jeux de pouvoirs.

Je contribue à Wikipédia depuis au moins 2006 (20 ans dans 3 ans, déjà plus de 6000 jours…) et l’utilise depuis 2003 (déjà 20 ans, donc), et j’ai observé plusieurs changements de comportement de la communauté, et l’antagonisation « camp du bien vs comploplo » est probablement la plus toxique, parce qu’elle laisse plus de place à la conviction qu’à la raison, et déplace les débats sur d’autres choses que l’information elle-même.

Il m’est arrivé récemment de reformuler des phrases d’articles que j’y lisais, depuis des formulations comme « telle chose est mauvaise comme rapporté par untel dans tel article » par « untel dans tel article considère que telle chose est mauvaise », ce qui permet d’extraire l’information du jeu de pouvoir tout en décrivant le même jeu de pouvoir, apporter l’information plutôt qu’en être le porte-parole.

Penser Wikipédia comme acteur de ces jeux de pouvoirs c’est prendre le risque de nourrir une paranoïa qui ne contribue pas à faire de Wikipédia un espace accueillant :

Tout d’abord les contributions contradictoires sont alors perçues comme des attaques envers Wikipédia et les personnes, et nourrissent donc des conflits entre personnes. Ton commentaire en est un parfait exemple : tu as besoin d’attaquer une personne pour légitimer l’information que tu apportes. Pourtant ton information doit pouvoir être défendue par elle-même.

Ensuite, les informations pas encore bien sourcées sont vécues comme des menaces et encouragent au délétionnisme et à la bureaucratie et découragent donc la rédaction, etc. Cela transforme le processus de rédaction de Wikipédia depuis le bazar vers la cathédrale (relire à ce sujet « La Cathédrale et le Bazar » d’Eric Raymond).

Pour donner un exemple avec la Wikipédia anglophone (comme ça on prend un peu de distance affective avec la Wikipédia francophone), quand la console Atari VCS est sortie, des personnes se sont battues pour maintenir certaines informations qui étaient fausses parce qu’elles étaient sourcées par des articles qui dataient de l’annonce du projet, avant le financement, avant la production, et avant la commercialisation. Le produit finalement livré était un peu différent du produit initialement annoncé, chose qui peut tout à fait arriver dans le cycle de vie d’un projet. Pourtant même les tentatives de reformuler les phrases façon « ça avait été annoncé comme ça » n’étaient pas bienvenues. Le produit était sorti, les gens avaient le produit dans les mains, mais la page Wikipédia disait un truc faux, parce que c’était sourcé. Tout acheteur pouvait vérifier cette information comme fausse, mais partager cette vérification c’était faire un travail original. Je pense que ça vient d’une forme de paranoïa, comme si toute contradiction proviendrait nécessairement d’un complot, justement.

Au final, cet article sur l’Atari VCS sur la Wikipédia anglophone était la victime collatérale de cette expérience victimaire de certains membres de la communauté de Wikipédia, où certains ont tellement peur de la désinformation qu’ils préfèrent une source qui dit quelque chose de faux à un fait matériellement vérifiable.

Il me semble que les petits articles ou les articles sur des sujets plus spécifiques comme celui de Xonotic sont également des victimes collatérales de ce genre de posture, ou peuvent le devenir, si un de ces contributeurs victimaires passe par là et décide d’appliquer la bureaucratie la plus stricte.

L’article Wikipédia francophone sur les fougères (la plante), ne donne pas de sources pour son chapitre Taxonomie, l’article mentionne même que « Les relations phylogénétiques entre les différentes familles de fougères font encore l'objet de discussions et la classification suivante est donnée à titre d’exemple ». La phylogénie est sourcée, pas la classification. Je n’irai pas supprimer ce chapitre pour autant, je n’ai pas d’élément me faisant craindre que ce sujet soit le terrain d’un conflit, et j’ai toute raison de penser que ce qui est rédigé là est correct, tout comme les faits rapportés dans l’article Xonotic, ou d’autres logiciels libres.

Pour les logiciels libres, à part certains cas spécifiques, il me semble que le seul risque serait la sur-représentation due à l’auto-promo, ce qui n’est pas un problème de fausse information, et dans ce cas j’ai envie de dire, et alors ? Si l’information est juste ? Ce qui motive la conviction qu’une page à sa place est très subjective, il y a certainement plein de sujets qui motivent une conviction similaire. Il existe peut-être même des sujets tout à fait anodins mais qui génèrent beaucoup plus de sources que des sujets moins anodins, de par la façon de traiter ces sujets, ou les habitudes et pratiques de leurs spécialistes. Ce qui serait encore un autre biais, permettant une sur-représentation similaire mais moins attaquable sur le front de la bureaucratie.

Par exemple les spécialistes des logiciels libres sont surtout des blogueurs, peut-être même auto-hébergés, là où un spécialiste d’histoire pourra écrire dans une revue ou un magazine. Les deux seront peut-être du même niveau dans leur domaine respectif, mais leurs usages de publications diffèrent, et un biais apparaît. Quand Dave Airlie fait un exposé sur un blog sur la façon d’interagir avec du code source libre, cet article a autant de valeur et peut-être plus de valeur que certains articles d’historien dans Le Figaro Histoire sur certains sujets d’histoire. Wikipédia favorisera le second parce qu’il s’inscrit dans le processus de publication attendu, alors que le support de la publication n’est ici que le reflet d’une différence comportementale de la population étudiée, pas un critère de discernement de fiabilité. On ne discute plus de la fiabilité des sources, on fait de la sociologie.

Mince, j’ai écrit un journal ! 😅️

ce commentaire est sous licence cc by 4 et précédentes

[^] # Re: Wikipédia

Posté par thoasm . Évalué à 5.

Imagine la page de Jean-Jacques Crèvecœur avant la pandémie sans critère de filtrage. Le gars propose des pseudo thérapies dangereuses ou il incite à arrêter la chimio pour se soigner à la seule force de la volonté, par exemple. Perso je pense que ça ne fait pas partie de la connaissance humaine et que les filtres de Wikipédia ne doivent pas laisser passer ce genre de choses.

Le truc c’est que tu proposes uniquement des choses subjectives ou dépendant du jugement. Quand tu dis que le logiciel libre étant un sujet connexe à la connaissance libre d’origine commune et que donc il y a une présomption de sympathie, c’est une opinion que d’autres wikipédiens ne sont pas obligés de partager. Ils verront que potentiellement il y a de l’argent ou des lobbys et intérêts financiers associés, par exemple, et que par conséquent dans une encyclopédies ouvertes certaines sociétés avec des moyens relativement importants pourraient être incitées à tenter de se valoriser et de masquer les infos dérangeantes. Et une communauté de bénévole peut avoir des faiblesses ou se laisser déborder voire infiltrer face à ce genre d’opérations. On peut penser aussi à les lobbys qui ont pu pousser les logiciels proprios et ses licences comme le BSA, à une époque, comme phénomène inverse.

Le TI, il est à mettre en rapport avec les sujets ou la crédibilité est jugée par les pairs comme la recherche académique. La crédibilité de la recherche académique est assurée par des mécanismes comme la revue par les pairs, les synthèses de connaissances académiques et le recul du temps sur les travaux publiés. Il ne s’agit pas de postures victimaires mais de constater que d’une manière générale l’acquisition de la connaissance est un phénomène complexe, et que même des choses relativement simples comme la consultation de documents anciens en histoire demandent des compétences pour en faire l’historiographie et trier le bon grain de l’ivraie (hagiographies pour les biographie par exemple, dont les historiens modernes sauraient que bien des éléments sont faux) ou les interpréter correctement. Les historiens qui publient sont formés pour ça … Sur d’autres sujets on bute vite sur des problématiques de ce style ou l’expertise technique moderne par exemple ne suffit plus pour relire des documents anciens (histoire des sciences par exemple, c’est une discipline académique à part entière). Si tu demandes à un universitaire, les publications académique ou les bouquins de vulgarisation ou de magazines ne sont pas à mettre sur le même plans parce que les rédacteurs de vulgarisation sont pas forcément relus par des scientifiques, et leur POV n’est pas à mettre sur le même plan.

Ben tout est dans le "peut-être", encore un jugement subjectif de compétence. Wikipédia privilégiera la revue académique au magazine, parce que justement le jugement de fiabilité de l’auteur n’est pas un jugement subjectif mais garantie que la publi a passé la revue par les pairs, filtre du domaine. Je ne suis pas pour exclure les blogs par principe en tant que sources, mais la nature même d’un blog n’offre pas de garanties. La stature de référence du domaine de l’auteur, le fait que le post soit référencé doivent être des critères. Mais c’est plus difficile à démontrer et donc bien plus subjectif. La nature collaborative de Wikipédia fait que si un rédacteur a un doute et conteste ce côté subjectif, si il n’y a rien de réellement probant pour justifier la subjectivité, c’est difficile de défendre la vérifiabilité (au delà de juste "c’est écrit" parce que c’est pas suffisant).

C’est difficile de faire une Wikipédia sans hiérarchiser les sources, et hiérarchiser les sources nécessite des critères. On pourrait agrémenter les sources d’un niveau de "risque" en fonction des sujets, mais il faut quand même les qualifier et les trier. Mettre la barre un peu moins haut sur certains sujets, mais il faut alors justifier les différences de traitements et ça peut être compliqué. Tu peux savoir qu’un auteur de blog est particulièrement compétent à titre personnel, encore faut-il pouvoir le justifier, et je pense pas qu’on ait trop d’outil pour le montrer. C’est faire passer la preuve du processus de publication qui filtre au filtrage par la réputation de l’auteur … mais on peut difficilement objectiver ça.

La phylogénie en classification phylogénétique moderne, c’est kif-kif vu que les taxon sont généralement des clades, la classification est le reflet de la phylogénie, généralement.

Suivre le flux des commentaires

Note : les commentaires appartiennent à celles et ceux qui les ont postés. Nous n’en sommes pas responsables.