Bon, l'heure est grave, npm est complètement pété. Globalement, des hackers ont pris le contrôle de pas mal de paquets npm et en profitent pour voler pleins de trucs.

un user/dev fait un npm update/install puis par le jeu des dépendances on se retrouve a download et exec un paquet compromis.

Y'a pas longtemps un pirate a installé des paquets pour voler des cryptomonnaies. Bon il a pas été très intelligent et il s'est vautré dans l'adresse de son wallet et il a gagné moins de 50€ j'ai lu.

Là, il y a le ver Shai Hulud qui se promène de repo en repo (plus de 450 repos touchés à cette heure)

https://jfrog.com/blog/shai-hulud-npm-supply-chain-attack-new-compromised-packages-detected/?

voilà, je ne sais pas quoi faire de cette info.

# Je me demande

Posté par Julien Jorge (site web personnel) . Évalué à 9.

Ça fait quelques années maintenant que npm est une source de problèmes avec ses dépendances vérolées, mais je me demande : pourquoi n'avons nous pas le même problème avec d'autres dépôts de paquets ? Les dépôts Maven, ceux des distribs Linux, crates.io pour Rust, etc. Il y a quand même de nombreuses opportunités pour pourrir la vie des devs. Pourquoi cela n'arrive-t-il que sur npm ?

[^] # Re: Je me demande

Posté par SpaceFox (site web personnel, Mastodon) . Évalué à 10.

Je dirais que les autres gestionnaires de dépendances, du moins ceux que je connais (Maven, distributions Linux) :

La connaissance libre : https://zestedesavoir.com

[^] # Re: Je me demande

Posté par Voltairine . Évalué à 9. Dernière modification le 17 septembre 2025 à 15:33.

Et ce n'est pas spécifique à npm. D'autres systèmes tout aussi laxistes ont les mêmes problèmes :

https://thehackernews.com/2023/12/116-malware-packages-found-on-pypi.html

https://www.infosecurity-magazine.com/news/malicious-containers-found-docker/

[^] # Re: Je me demande

Posté par fork_bomb . Évalué à 5.

npm non plus n'utilise pas de versions flottantes (dans le sens que tu l'entends dans ton commentaire).

npm installinstalle les versions indiquées dans le package-lock.json, qui sont des versions exactes (hash compris), y compris pour les dépendances transitives. Il n'y a que le cas où un package est absent du package-lock que la version flottante est installée (typiquement si un nouveau package a été ajouté manuellement au package-lock).npm cifait la même chose quenpm install, sauf que dans ce dernier cas (besoin d'installer un package absent du package-lock) il retournera une erreur.[^] # Re: Je me demande

Posté par SpaceFox (site web personnel, Mastodon) . Évalué à 5.

Ça implique que les gens n’aient pas fait n’importe quoi avec le package-lock, n’aient pas juste viré le node_modules et le package-lock parce que npm a pété un boulon, n’aient pas juste « mis à jour les versions du package-lock ça va c’est marqué compatible au moins on est à jour », etc.

Je ne comprends toujours pas pourquoi npm, en 2025, a toujours :

La connaissance libre : https://zestedesavoir.com

[^] # Re: Je me demande

Posté par woffer 🐧 (site web personnel) . Évalué à -10. Dernière modification le 17 septembre 2025 à 14:54.

J'ai posé la question à Gemini :

Bien que l'attaque "Shai-Hulud" ait spécifiquement ciblé npm, il est faux de dire que ce type d'attaque ne touche que les dépôts de packages JavaScript. Les attaques sur la chaîne d'approvisionnement logicielle, qui consistent à injecter du code malveillant dans des dépendances, affectent potentiellement tous les écosystèmes.

Vulnérabilité et différences des écosystèmes

Chaque gestionnaire de paquets a des caractéristiques qui peuvent le rendre plus ou moins vulnérable ou ciblé.

npm (JavaScript): L'écosystème npm est l'un des plus grands au monde, avec des millions de packages et des milliards de téléchargements. Sa popularité, sa vitesse de développement rapide et sa culture de la micro-dépendance (utiliser de nombreux petits packages) en font une cible très attrayante pour les attaquants. Les packages sont souvent créés et maintenus par des contributeurs individuels, ce qui peut rendre leur sécurité plus difficile à vérifier.

Crates (Rust) et Go: Ces écosystèmes sont plus jeunes et de taille plus modeste que npm. Bien qu'ils ne soient pas à l'abri des attaques, leur plus petite taille et leur adoption moindre les rendent moins prioritaires pour les cybercriminels cherchant à maximiser leur impact.

Volume et taille du marché : Avec des millions de développeurs et d'entreprises utilisant npm, un attaquant peut atteindre un public très large. C'est un marché immense pour la distribution de logiciels malveillants.

Simplicité de publication: La publication d'un nouveau package npm est relativement simple, ce qui permet à des acteurs malveillants de créer rapidement de faux packages ou de prendre le contrôle de packages existants via des identifiants volés.

En résumé, si les attaques de la chaîne d'approvisionnement sont une menace universelle, l'écosystème npm est particulièrement ciblé en raison de sa taille massive, de sa complexité et de ses processus de publication qui favorisent la propagation rapide des dépendances.

[^] # Re: Je me demande

Posté par jyes . Évalué à 10.

J’ai demandé à mon cochon d’inde, voic sa réponse :

Ça me semble important à partager ici car même si tout le lectorat de LinuxFr peut obtenir une réponse sans intérêt avec un LLM, tout le monde n’a pas un cochon d’inde à domicile.

De rien.

[^] # Re: Je me demande

Posté par 🚲 Tanguy Ortolo (site web personnel) . Évalué à 10.

Ton cochon d'Inde couine comme un cochon tout court on dirait. Le cri normal du cochon d'Inde ne serait-il pas plutôt « couille, couille, couille » ?

[^] # Re: Je me demande

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 10.

C'est plutôt un genre de gazouillis qui fait penser à des oiseaux. (oui c'est une réponse sérieuse)

Je n’ai aucun avis sur systemd

[^] # Re: Je me demande

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 7.

Et on te remercie pour cette réponse pertinente.

Faut maintenant mettre des gens sur la réponse de ton cochon d'inde pour la décrypter.

Je n’ai aucun avis sur systemd

[^] # Re: Je me demande

Posté par legranblon (site web personnel) . Évalué à 4.

Bah sinon, faut brancher un llm, y'en a bien qui y ont pensé pour les dauphins …

[^] # Re: Je me demande

Posté par Faya . Évalué à 10.

La réponse du LLM est pourtant pertinente, je m'apprêtais à rédiger quelque chose du même style mais bien plus court et sorti tout droit de ma tête. Je m'auto-cite : « C'est comme les virus Windows vs Linux. Le web est énorme, la quantité de projets et de dev aussi, donc c'est juste plus rentable de cibler npm» . En fait il aurait dû se contenter d'une portion de la dernière phrase : « l'écosystème npm est particulièrement ciblé en raison de sa taille massive, de sa complexité et de ses processus de publication qui favorisent la propagation rapide des dépendances. »

[^] # Re: Je me demande

Posté par woffer 🐧 (site web personnel) . Évalué à -3. Dernière modification le 17 septembre 2025 à 16:05.

C'est bien pour cela que je l'ai copié en brute de décoffrage et éviter certains d'en refaire une sur ce LLM ou un autre.

Après, je comprends que cela soit dérangeant et qu'elle n'a pas spécialement de valeur. Valeur dans le sens que n'importe qui auraient pu la faire de lui même.

Mais honnêtement pour moi, elle a été pertinente.

[^] # Re: Je me demande

Posté par arnaudus . Évalué à 10.

Il est hyper important d'avoir des endroits du web préservés des sorties de LLM, ça inclut Wikipédia, et divers forums d'aide comme celui-ci. Les LLM ne pourront plus progresser s'ils bootstrappent sur leurs propres sorties, donc merci de préserver des espaces dépollués.

La consultation de LLM est devenue standard, à peu près autant qu'une recherche dans un moteur. Quand quelqu'un répond dans un forum STFW, il donne la bonne info : tu trouveras des réponses intéressantes sur Google. Tu peux faire pareil, indiquer qu'il suffit de demander à chatGPT pour avoir des réponses intéressantes à la question. Mais personne ne recopie les sorties de Google dans un forum, et de la même manière personne ne devrait utiliser des octets des disques de linuxfr pour y stocker les sorties d'un autre site, fussent-elles librement recopiables.

[^] # Re: Je me demande

Posté par 🚲 Tanguy Ortolo (site web personnel) . Évalué à 10.

Tout à fait d'accord, mais pas pour les mêmes raison. À mon avis, c'est important pour les humains qui les fréquentent. Tandis que :

Tant mieux ! Je serais ravi de voir le ramdam autour de l'IA éclater comme une bulle, le monde s'en porterait mieux.

[^] # Re: Je me demande

Posté par arnaudus . Évalué à 3.

Je n'arrive pas à comprendre la logique du raisonnement. Comme un futur sans IA n'existe pas (on ne peut pas les "désinventer"), tu préfèrerais un futur où les IA font de la m***de plutôt que de devenir des outils pertinents?

[^] # Re: Je me demande

Posté par 🚲 Tanguy Ortolo (site web personnel) . Évalué à 10.

Oui, je préférerais. Plus ça fait de la merde, moins on les utilisera pour nous aider à cramer la planète encore plus vite. Et si ça pouvait bien se casser la gueule en bourse, ce serait encore mieux.

[^] # Re: Je me demande

Posté par gaaaaaAab . Évalué à 10.

comme un futur sans cinéma 3D n'existe pas … ;)

la technologie ne disparaîtra pas, mais pour l'instant, c'est pas sûr qu'il y ait un modèle économique qui puisse financer l'infrastructure actuelle à long terme. C'est d'autant moins sûr que si tout le monde cherche à fourrer de l'IA partout en ce moment, le périmètre réellement utile va, je pense (ou j'espère, je ne suis pas objectif sur le sujet), se resserrer.

[^] # Re: Je me demande

Posté par arnaudus . Évalué à 2.

Je suis ouvert à la discussion sur les IA génériques et gratuites, même si j'ai du mal à imaginer comment leur intégration aux moteurs de recherche pourrait revenir en arrière—de facto, il y a deux sortes de recherches dans un moteur; 1) quand on recherche un site en particulier, pour faire de l'auto-complétion d'URL ou pour pallier les défaillances des moteurs de recherche internes aux sites, qui peuvent en effet se passer d'IA, et 2) quand on recherche une information sans savoir où on va la trouver, auquel cas ce qu'on veut en réalité, c'est un LLM et pas des sites qui ont des éléments en commun avec la requête.

J'intègre les LLM à mes méthodes de travail en fonction de ce qu'ils peuvent apporter. Ils excellent dans les tâches de type "résumé" (résumé en 250 mots, en 1000 caractères, en anglais, en utilisant un langage profane…), je les trouve également très utiles pour le dépannage ("ma machine à laver dit E:27"). Ça va être comme tout, on va comprendre les limites de ces trucs, et on va profiter de leurs points forts.

Rapidement également, on va (j'espère) arrêter d'utiliser les trucs grand public sans aucune confidentialité pour les tâches professionnelles, et les employeurs (publics et privés) vont raquer pour le coût réel de ces outils, ce qui éclairera le business model et calmera le flot insensé de centaines de milliards d'investissement. Quand il faudra réellement payer 1000€ par mois pour créer des vidéos tiktok pour les copains, ça calmera les ardeurs.

Par contre, je ne vois pas comment éviter qu'une interaction avec un humain devienne progressivement un luxe. C'est certain que les clients de HSBC vont continuer à avoir un vrai interlocuteur au téléphone, mais quand tu vas appeler pour savoir combien tu as sur ton livret A au crédit agricole, tu vas avoir un robot au bout du fil. Après, ce n'est pas forcément une catastrophe, se taper 1h de Vivaldi à chaque fois que tu appelles la sécu ou la CAF, ça gonfle tout le monde (sans compter que la qualité des réponses des opérateurs humains dans ces organismes reste assez aléatoire).

[^] # Re: Je me demande

Posté par 🚲 Tanguy Ortolo (site web personnel) . Évalué à 10.

Toi, peut-être, ce n'est pas une généralité. Lorsque je veux trouver une information, ce que j'attends, c'est des pages qui parlent du sujet et où je trouverai, entre autres, ladite information. Au passage, j'y gagne en connaissance et en compréhension du sujet en question.

Je comparerais bien cela avec la recherche de chemin pour aller quelque part. Ce que je veux, ce n'est pas des instructions pour guide rmes pas, mais une carte avec l'endroit où je suis et l'endroit où je veux aller, pour pouvoir déterminer mon chemin. Et éventuellement une proposition d'itinéraire. Savoir quand tourner à gauche ou à droite, c'est le boulot de mon cerveau, et au passage, je saurai refaire le même trajet. Mieux encore, après deux ou trois trajets dans le coin, je saurai également faire d'autres trajets sans la moindre assistance.

DuckDuckGo("notice lave-linge Samsung DX-4000"), ouvrir PDF, lire le sommaire, aller à la page des codes d'erreur. Ça prend sûrement plus de temps. La première fois. Mais maintenant, je le connais bien, mon lave-linge, d'ailleurs je l'ai déjà partiellement démonté. La première fois avec un peu d'aide d'un tuto, la deuxième fois en autonomie complète.

C'est marrant, tout cela ne fait qu'augmenter une impression de supériorité que je ressents depuis longtemps sur le sujet de la recherche d'itinéraire. Maintenant ça s'étend à la recherche d'information en général : j'ai de plus en plus l'impression d'être quelqu'un qui sait des trucs et qui sait faire des trucs, là où beaucoup de gens ont l'air complètement dépendants d'assistants externes.

[^] # Re: Je me demande

Posté par arnaudus . Évalué à 1.

Je crois que malheureusement, ça ne fait surtout que montrer que tu n'as pas la moindre idée de ce dont sont capables les LLM modernes.

Après, entendons-nous bien : il est tout à fait légitime d'avoir les loisirs qu'on veut. On peut par exemple aimer passer son temps libre à faire des divisions ou calculer des racines carrées à la main. On peut même prétendre que c'est bon d'entrainer son esprit sur des exercices de ce style (c'est discutable, mais pourquoi pas). Par contre, on est bien d'accord que c'est absurde de prétendre qu'une division faite à la main est mieux faire qu'à la calculatrice? Parce que c'est en effet complètement faux. Dans n'importe quel cadre sérieux, donc hors loisirs, quand le temps passé ou la précision du résultat sont importants, alors il n'y a pas d'alternative : on doit utiliser une machine pour calculer.

Je ressens pourtant la même chose avec ton approche des LLM. Tu tentes de justifier un savoir ou un savoir-faire que tu as en prétendant que tu fais mieux que la machine, et que c'est "mieux" de manière absolue, avec une menace en arrière-plan sur l'idée que le jour où tu n'auras pas de machine sous la main tu seras bien embêté. Mais quelqu'un qui sait calculer les racines carrées à la main pourrait sortir les mêmes arguments, pourtant, je n'ai jamais eu besoin de calculer une racine carrée à la main, c'est une compétence inutile pour moi, et j'ai bien fait de toujours confier ce travail à une machine, et à investir le temps que j'ai gagné à autre chose.

Au final, ton dénigrement des LLM, des gens qui utilisent les LLM, et ta prédiction de la fin des LLM, tout ça est cohérent : si les LLM étaient en effet bidons et qu'ils étaient amenés à disparaitre, alors tu aurais en effet des compétences que les autres n'auraient pas, et tu pourrais apparaitre comme une sorte de dieu hyper-compétent dans une telle société, qui achèterait tes services à prix d'or. Mais il y a une faille dans ton raisonnement, c'est que pour que ça marche il faut que les prémisses soient vraies, ce qui n'est probablement pas le cas. Il me semble donc malheureusement assez vraisemblable que tes compétences dont tu es si fier finissent comme celles du type qui sait calculer les racines carrées à la main : elles ne sont valorisables ni socialement, ni économiquement, ni professionnellement, et ne consistent au mieux qu'en une curiosité. Et ton destin dans un tel monde sera d'être éternellement aigri, est-ce que c'est ce que tu souhaites?

[^] # Re: Je me demande

Posté par 🚲 Tanguy Ortolo (site web personnel) . Évalué à 8.

Déjà, je ne prédis rien du tout. J'aimerais que tout cela éclate comme une bulle, ça ne veut pas dire que je pense que c'est ce qui arrivera. Je n'en ai aucune idée.

Ensuite, je ne dénigre personne. Ni en matière d'IA ni en matière de lecture de carte. Je suis fier de pouvoir me débrouiller avec une carte ou un plan de ville, voire sans après avoir un peu découvert les lieux. La plupart des gens font autrement, grand bien leur face. Je suis heureux de pouvoir aider des touristes à trouver leur chemin à l'occasion, heureux de rendre service, pas heureux d'être plus doués qu'eux, Dieu m'en garde !

Ceci dit, si quelqu'un m'écrit un jour un truc sorti d'une IA en faisant croire que ça vient de lui – et que je m'en rend compte – je ne me priverai pas de le faire bien remarquer. Et s'il présente ça comme sortant d'une IA, je ne me priverai pas de bien faire remarquer les éventuelles lacunes du texte.

[^] # Re: Je me demande

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 5.

Je trouve l’analogie de la calculatrice bien moisie. Genre un LLM est un algorithme reproductible que tu peux opposer à tout algorithme utilisé par un humain (cas du calcul manuel).

“It is seldom that liberty of any kind is lost all at once.” ― David Hume

[^] # Re: Je me demande

Posté par Laurent J (site web personnel, Mastodon) . Évalué à 10.

Peut-être que tu as eu de la chance d'avoir eu la bonne réponse, mais faut se méfier quand même. Tu as des chances que la réponse soit le résultat d'un mix de solutions pour plusieurs machines (il n'y a pas que ton modèle de machine qui peut avoir un code E:27, et ça peut ne pas avoir la même signification), même si tu précise ton modèle de machine.

Et donc il y a des chances que l'IA te propose un dépannage complètement à coté de la plaque : "faut changer telle pièce avec telle référence" alors qu'en réalité, il faudra changer une autre pièce, ou alors c'est une autre référence. Avec pour conséquence du temps et de l'argent de perdu, voir provoquer une autre panne avec la mauvaise pièce. Et si tu as cherché juste pour "vérifier" que ton dépanneur ne te racontes pas des bêtises, bonjour l'embrouille si c'est l'IA qui est dans le faux.

Pour dépanner moi-même mon électroménager depuis de nombreuses années, et vu comment c'est pas évident quand tu as la vraie info dans le manuel, alors si en plus l'IA te dis de la merde (et après vérification, ça dit souvent de la merde), t'es pas sorti de l'auberge.

Perso, après avoir testé, j'évite l'IA pour ça. C'est limite dangereux (ex: dans les indications données par l'IA, l'IA "oubli" des étapes clés de mise en sécurité pour le démontage).

Je me limite donc aux moteurs de recherche. Mais là aussi c'est de moins en moins évident.

Les sites de "dépannages" générés à l'IA pullulent (que ce soit électroménager, mécanique auto ou autre) et sont bourrés d'inexactitudes ou d'un manque d'information.

Exemple à peine exagéré : gros titre d'une page "comment démonter le démarreur de la clio 2 essence 1,2l". Et les explications, de 3 paragraphes, avec des phrases plates et sans informations, qui tournent autour du pot, se résument à "pour réparer votre démarreur, démontez votre démarreur".

Au final, tu ne sais pas comment démonter le démarreur.

Et si tu demandes à une IA, ça va te répondre à peu près la même chose, ou quand tu as des détails, tu te rends compte que ça ne correspond pas à ton moteur, et que les explications ne sont valables que pour un diesel Mercedes. Genre ça t'indique que pour accéder à ton démarreur, il faut "déposer la durite de turbo" alors qu'en réalité, pour ton cas, pas besoin (ben non, y a pas de turbo dans une clio 2 1.2l essence :-))

Et malheureusement, ces sites sont bien référencés, ça devient de plus en plus dur de trouver des infos claires et pertinentes dans le dépannage.

[^] # Re: Je me demande

Posté par arnaudus . Évalué à 1.

Qui a prétendu qu'il fallait avaler les sorties de ChatGPT comme de l'eau bénite?

Est-ce que tu ne te méfies pas quand tu trouves une réponse toute faite dans un forum?

Tu évoques une sorte de risque théorique, qui est réel, mais qui ressemble à une sorte de fantasme bien éloigné des capacités des LLM modernes. Est-ce que chatGPT peut en théorie se mélanger les pinceaux entre les codes d'erreur des sèche-linge Bosch et des lave-linge Brandt? En théorie, oui, bien sûr, le fonctionnement d'un LLM ne peut pas te garantir que c'est impossible. Mais en pratique? Quelle est la chance que ça arrive? 1%? 0.1%? 0.0001%? C'est ça le problème, c'est ça d'écouter des prophètes débiles qui racontent n'importe quoi à longueur de journée, on devient un pédant théorique qui pense que tout ce qui sort d'un LLM est une hallucination potentielle, et on se repâit de quelques prompts bien travaillés qui poussent les modèles aux limites de leurs possibilités. Mais en réalité, ces trucs marchent. C'est une réalité qui ne plait pas à tout le monde, mais c'est comme ça, ça marche.

Donc voici un cas concret : je dis à chatGPT "J'ai un code E17 sur mon lave linge", il me répond: "Le code erreur E17 sur un lave-linge (selon la majorité des modèles de Bosch / Siemens et d’autres marques du même groupe) signifie généralement : ⚠️ Problème d’arrivée d’eau (l’appareil ne parvient pas à se remplir dans le délai prévu) // Si tu veux, je peux te dire précisément ce que signifie E17 pour ton modèle exact (car cela varie légèrement selon les marques) — veux-tu me donner la marque et le modèle de ton lave-linge ?"

On peut raconter ce qu'on veut avec des exemples "à peine exagérés". Oui, les LLM peuvent faire des erreurs, oui ils sont limités par la qualité de leurs données d'entrainement, oui tu peux facilement mettre en défaut un LLM dans un domaine où tu es spécialiste, mais 1) le niveau des réponses reste globalement satisfaisant dans un très grand éventail de cas, 2) je ne vois pas l'intérêt de passer sa vie à essayer de mettre en défaut les LLM, puisqu'à moins d'être payé pour les améliorer ça ne fait que confirmer ce que tout le monde sait déja, 3) il est assez évident qu'il est peu utile de demander quelque chose à un LLM quand on a déja trouvé un document adapté—par exemple les instructions du constructeur pour démonter une pièce, et encore plus si on a raison de penser que ce document est meilleur que les données d'entrainement du LLM.

De toutes manières, comme tu en fais toi-même le constat, les LLM donnent maintenant la plupart du temps des réponses meilleures que le reste des documents déja faits qu'on peut trouver sur Internet. Autrement dit, il devient difficile de remplacer un LLM par une recherche approfondie. Tu peux penser qu'il s'est passé quelque chose et que le web est maintenant vide, mais je crois que c'est faux, les informations de qualité ont toujours été rares. Pour la réparation d'appareils, typiquement, la notice officielle ne mentionne que des cas débiles, genre "la lumière ne fonctionne plus -> remplacer l'ampoule", "l'appareil ne s'allume pas -> vérifier qu'il est bien branché", "l'appareil est branché et ne s'allume pas -> contacter le service après-vente". C'est ça, l'information qu'on a toujours eu, de la m***. Pour obtenir les données techniques, il fallait contacter le fabriquant et espérer sa bonne volonté, ou bien payer pour accéder aux protocoles de réparation destinés aux professionnels. Bref, je ne crois pas du tout au monde idyllique d'avant les LLM où il était facile de trouver des informations de qualité sur n'importe quel sujet, je crois que c'est un monde fantasmé.

(dans tous les cas, ça ne change pas que de remplir le web avec des sorties de LLM c'est débilissime, c'est aussi con que de remplir des pages automatiquement avec le résultat de requêtes Google).

[^] # Re: Je me demande

Posté par pulkomandy (site web personnel, Mastodon) . Évalué à 10.

Soit ton LLM a "trouvé" la réponse quelque part dans ses données d'entraînement, et donc elle existait bien quelque part, très probablement sur internet ; soit il l'a inventée, et donc c'est une réponse bidon qui ne sera vraie que sur un coup de chance.

Donc je ne vois pas quel problème ça résout. Au lieu de passer du temps à chercher une réponse, tu vas avoir une réponse tout de suite, et puis ensuite tu vas passer autant de temps qu'avant à vérifier si cette réponse est vraie. Tu as peut-être l'impression de ne pas avoir galéré et d'avoir été mis tout de suite sur une piste.

Pour reprendre l'exemple de la recherche d'itinéraire, c'est équivalent à partir dans une direction à l'instinct sans regarder un plan, se rendre compte que c'était pas la bonne direction, et dire "oui, mais au moins j'ai bougé". La direction est plus important que la vitesse, et les LLM te donne de la vitesse.

[^] # Re: Je me demande

Posté par arnaudus . Évalué à -4.

En fait, ça me fatique de discuter avec des gens qui n'ont aucune idée des performances réelles des LLM modernes. Donc j'arrête là, restez bloqués en 2022 sur des concepts aussi débiles que le "perroquet stochastique", vivez dans un monde où l'IA n'existe pas et n'est qu'un moteur de recherche sous-optimal, une bulle inventée par des investisseurs demeurés qui balancent les milliars par les fenêtres.

De toutes manières, ça ne changera pas grand chose, certains d'entre nous perdrons notre boulot et ceux qui ne l'auront pas perdu verront leur manière de travailler profondément modifiée, et le savoir en avance ne changera pas l'avenir. Il y aura juste une différence entre ceux qui auront compris pourquoi et ceux qui seront restés au "mais pourquoi me remplace-t-on par un perroquet stochastique?".

[^] # Re: Je me demande

Posté par pulkomandy (site web personnel, Mastodon) . Évalué à 8.

Mon emploi salarié actuel ne consiste pas du tout à dépanneredes machines à laver qui ont une erreur 27, donc je ne vois pas trop le rapport. Cela peut m'arriver pour mes loisirs, en revanche.

Mais admettons. Par quel mécanisme un LLM peut donner une telle information (et avoir raison) si ce n'est pas en tirant l'information de ses données d'entraînement ou éventuellement en faisant la recherche sur internet à ta place? Quelles autre alternative y-a-t'il aux deux options: soit l'info existait quelque part, le LLM l'a trouvée pour toi mais tu aurais pu en faire autant avec un bon vieux moteur de recherche; soit l'information n'existait pas, le LLM a "inventé" une explication?

Dans ce deuxième cas, qu'est-ce qui permettrait de supposer que l'explication donnée a une chance d'avoir un quelconque rapport avec la réalité?

Est-ge qu'il a des pouvoir de divination extralucides? Est-ce qu'il a trouvé et désassemblé le firmware de la machine à laver? Est-ce qu'il a contacté à ta place le faoricant pour récupérer des infos? Est-ce qu'il a asoiré dans ses données des infos confidentielles du fabricant qui ne sont pas sur internet? Dans ce derniers cas, est-ce que le faoricant en question a donné son accord pour la publication d.ces données et pourquoi il les a mis dans un LLM et pas directement en ligne sur son site?

[^] # Re: Je me demande

Posté par LaurentClaessens (site web personnel) . Évalué à 5.

Oui : c'est mieux de d'abord chercher le manuel du modèle exact sur le site du constructeur. Si il existe et qu'il mentionne le problème, alors c'est certainement la première piste à suivre.

Après, le LLM peut très bien tenir sa solution du livre «Réparer sa machine à laver pour les nuls» qui se vend un multillion d'euros et qui n'est d'ailleurs plus en vente depuis 10 ans. Mais comme OpenAI a pu se procurer ce livre et le mettre dans la base d’entraînement, ben le LLM est capable d'en sortir de l'information.

Exemple dans un autre domaine : une question de math à laquelle je n'ai pas trouvé de réponse sur internet. Pourtant en la posant à chatGPT, il a pu me donner une réponse avec une démonstration correcte.

Il ne fait que peu de doutes pour moi que la question a été traitée dans plein de livres privateurs dont une bonne parties ne sont même plus en vente. Mais que ces livres sont dans la base d'entrainement de chatGPT.

[^] # Re: Je me demande

Posté par Pol' uX (site web personnel) . Évalué à 4.

Est-ce que le LLM en question sait expliquer comment il parvient à ce résultat ?

Adhérer à l'April, ça vous tente ?

[^] # Re: Je me demande

Posté par LaurentClaessens (site web personnel) . Évalué à 3.

Ça dépend ce que signifie la question.

Si la question est : «comment je sais que le résultat énoncé par le LLM est vrai ?», la réponse est : parce que j'ai lu la démonstration donnée par le LLM, et elle est correcte.

Si la question est «Quel cheminement mental il a suivi pour découvrir la démonstration ?», alors la réponse est comme pour n'importe quel mathématicien qui donne une démonstration d'un fait connu : «parce que je la connais» ou «parce que je connais plein de démonstrations dans des cas similaires, et j'ai pu adapter».

Cela dit, «adapter» dans le cas d'un LLM a une signification très différente de «adapter» dans le cas d'un humain.

Le cheminement fait par le LLM pour faire une simple addition est assez impressionnant.

TL;DR de la vidéo :

- Si on demande 14+18, il répond 32 (correct)

- Si on lui demande comment il y est arrivé, il dit qu'il a fait 4+8 (=12 c'est à dire 2 avec un report de 1) puis il a fait 1+1 (=2) et le report.

- Mais si on regarde quels sont les neurones effectivement activés lorsqu'il répons 14+18=32, à aucun moment il n'a effectivement activé les neurones correspondant à 12. Ni à aucune des étapes intermédiaires de report ou de quoi que ce soit de ce genre.

[^] # Re: Je me demande

Posté par Pol' uX (site web personnel) . Évalué à 3.

Je parlais das le cas discuté. Disons que le LLM sort : E27 panne d'éclairage. Est il en capacité de lister la source de son savoir et la déduction qui montre que ce savoir est applicable au cas demandé ?

Adhérer à l'April, ça vous tente ?

[^] # Re: Je me demande

Posté par LaurentClaessens (site web personnel) . Évalué à 2.

Ah ok. J'imagine que la réponse est «non» alors.

Mais il y a beaucoup de cas dans lesquels ce n'est pas important.

Si je démine un explosif et qu'il me dit que je dois couper le fil rouge, effectivement je demanderais d'où il le sait pour pouvoir vérifier (et je ne lui ferais confiance qu'après avoir retrouvé la source).

Mais si le conseil est de dévisser la plaque à droite, vider le filtre et le remettre ben… Autant essayer. Il y a une probabilité 0.9 de résoudre le problème et 0.1 de remarquer qu'il n'y a même pas de plaque à droite.

Les LLM sont très intéressants pour les cas où vérifier une information est beaucoup plus simple (et sans danger) que de trouver l'information.

[^] # Re: Je me demande

Posté par pulkomandy (site web personnel, Mastodon) . Évalué à 5.

Oui vu comme ça c'est logique. Et pour le coup, dans mon travail salarié d'architecte/dévelopeur, trouver des informations est généralement facile (on peut demander au client pour le fonctionnel; pour le technique on peut lire notre code, lire le code des projets libres qu'on utilise, la littérature est abondante. Mais par contre pour vérifier les choses, c'est autrement plus compliqué.

Dans le cas d'une démonstration mathématique, il peut y avoir des étapes pas du tout intuitives, mais une fois trouvées on peut les vérifier. Effectivement j'imagine qu'il peut y avoir d'autres choses dans ce cas!

[^] # Re: Je me demande

Posté par thoasm . Évalué à 2.

En general soit il cherche des sources sur le net, et là il te site une source qu'il a analysé, soit il fait une recherche a posteriori pour justifier un truc qu'il a sorti générativement. Au début, le sais pas maintenant, cette dernière stratégie est peu convaincante.

Il n'est à ma connaissance pas capable de savoir d'où il tire les infos quand il génère (ca permettrait d'eliminer les hallus avec certitude, par exemple, comme pseudo preuve). Ca ne fait pas partie de la procédure d'apprentissage.

Du coup rechercher des sources doit nécessiter de fin des recherches efficaces par proximité sémantique dans les docs avec la question et/ou sa réponse.

[^] # Re: Je me demande

Posté par Faya . Évalué à 2.

Selon la marque de l'appareil, télécharger la notice c'est régulièrement la croix et la bannière. Formulaires abscons pour essayer de retrouver sa référence, site de téléchargement de notices avec un lecteur de document très mal foutu et j'en passe… Typiquement le genre de trucs que je serai heureux de laisser au LLM.

[^] # Re: Je me demande

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 7.

Tu sais quoi ? Puisque tu sembles bien maîtriser le sujet tu peux faire une dépêche bien argumentée et bien sourcée dessus. Ça permettra aux gens bloqués en 2022 de surmonter ce blocage.

Tu me diras « une dépêche ça prend du temps à écrire ». Je suis extrêmement bien placée pour le savoir, mais ça en prend vraiment moins comme on maîtrise le sujet, ce qui semble être ton cas. En tout cas, ça ne prend pas plus de temps qu’une collection de longs commentaires.

Merci d’avance.

Je n’ai aucun avis sur systemd

[^] # Re: Je me demande

Posté par arnaudus . Évalué à 3.

Il y a des dépêches très documentées tous les mois ou les deux mois sur ce sujet, rédigées par des gens bien plus compétents que moi. Il suffit de les lire.

Qu'est-ce que tu veux dire de plus que "les LLM ne fonctionnent absolument pas comme ça"? C'est comme si quelqu'un disait qu'un ordinateur fonctionne parce qu'un petit lutin pédale dedans. Bah non, ça n'est pas comme ça que ça fonctionne. Là, c'est la même chose. Les LLM ne sont pas des moteurs de recherche qui trouvent des choses dans leurs données d'entrainement, et qui sont incapables de ne pas les trouver quand elles n'y sont pas. Ils ne connaissent pas leurs données d'entrainement, ils n'y ont pas accès, les données d'entrainement servent à paramétrer les milliards de poids d'un modèle qui génère le texte des réponses.

[^] # Re: Je me demande

Posté par pulkomandy (site web personnel, Mastodon) . Évalué à 6.

J'ai oien mis des guillemets autour de "trouvé". On peut mettre "inféré" à la place si on veut mettre ds mots compliqués. Et ça ne répond toujours pas à ma question, comment un LLM peut te dire à quoi correspond l'erreur 27 sur une machine à laver si l'information n'existe pas par ailleurs et sans sortir une réponse complètement inventée et sans rapport avec la réalité?

Il n'y a justement pas de magie. Il y a des entrées (les données d'entraînement et le prompt) et des sorties.

Et note aussi que si j'obtiens une réponse sur l'erreur 27 sur un forum sans explication, ou quelqu'un me dit "c'est la pompe de vidange qui est bouchée", je vais sùrement aussi me demander quelle est sa source (qui pourrait être une doc du fabricant non publiée, sa propre expérience de réparateur, …). Et ça permet de "gagner un niveau" sur les compétences (du simple "erreur 27 = pompe bouchée" à "comment trouver le problème lié à un code d'erreur")

[^] # Re: Je me demande

Posté par arnaudus . Évalué à 0.

Je vois bien que tu ne peux pas y croire parce que tu n'as pas eu les bonnes informations sur le fonctionnement de ces modèles, mais pourtant un LLM moderne peut tout à fait répondre de manière très convaincante à des questions dont les réponses ne sont pas dans ses données d'entrainement, parce qu'il procède par analogie et déduction. Si tu préfères, il répond au hasard, mais il se trompe rarement.

"De quelle couleur sont les licornes polaires?

C'est évidemment la bonne réponse, non? :-) Pourtant, c'est quasiment certain que ça ne figurait pas dans les données d'entrainement. Ça a été déduit par analogie.

Trouver des questions dont on connait la réponse mais dont on peut être certains qu'elle ne figure pas dans les données d'entrainement est difficile, mais il existe des benchmarks pour LLMs et les progrès sont très substantiels. Alors évidemment, on peut discourir longuement sur la différence entre "savoir" et "connaitre", mais du point de vue de l'utilisateur, ce qui compte c'est la pertinence de la réponse, et pas la manière dont le LLM l'a obtenue. Si ça te rassure, tu peux penser que c'est les téras de données ingurgitées qui permettent aux LLM de répondre au hasard sans se tromper, mais le résultat est là.

[^] # Re: Je me demande

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 6.

Ça tourne un peu autour du pot je trouve. La question se résume à « expliquez-moi comment ça trouve la réponse » ; et on lui répond « tu ne comprends rien, ça peut te donner des réponses convaincantes qui ne sont pas dans ses données » (mouais…)

La seule chose qui approche d’une réponse valable et est hélas noyée dans la masse d’inutilité est

C’est immédiatement ruiné par la suite :

En effet, comment tu mesures le « rarement » ? En dehors d’une anecdote sur les licornes ? Parce-que chacun peut aussi facilement sortir des anecdotes d’erreurs (qui pourtant sont supposément rares)

Le truc est hélas que que si on n’a pas un certain niveau dans certains domaines on ne peut pas se rendre compte de certaines erreurs (et se conforter dans l’idée que c’est encore plus rare)

“It is seldom that liberty of any kind is lost all at once.” ― David Hume

[^] # Re: Je me demande

Posté par arnaudus . Évalué à 2. Dernière modification le 22 septembre 2025 à 17:23.

Il donne la réponse la plus vraisemblable d'après la sortie d'un réseau de neurones dont les poids ont été ajustés par une procédure d'apprentissage à partir d'un corpus de données aussi grand que possible.

Une sorte de "jus de connaissance" qui n'a pas grand chose à voir avec une recherche dans une base de données. D'où la complémentarité avec une recherche web, que beaucoup de modèles proposent maintenant.

C'est pas moi qui le mesure, le benchmarking de LLMs est réalisé par des laboratoires de recherche publics ou privés, c'est un domaine technique qui ne peut pas être discuté dans un forum à base d'anecdotes. Ça dépend du domaine, du modèle, de la manière dont la question est posée, et de la bonne volonté de l'utilisateur pour guider le modèle vers la compréhension de la question.

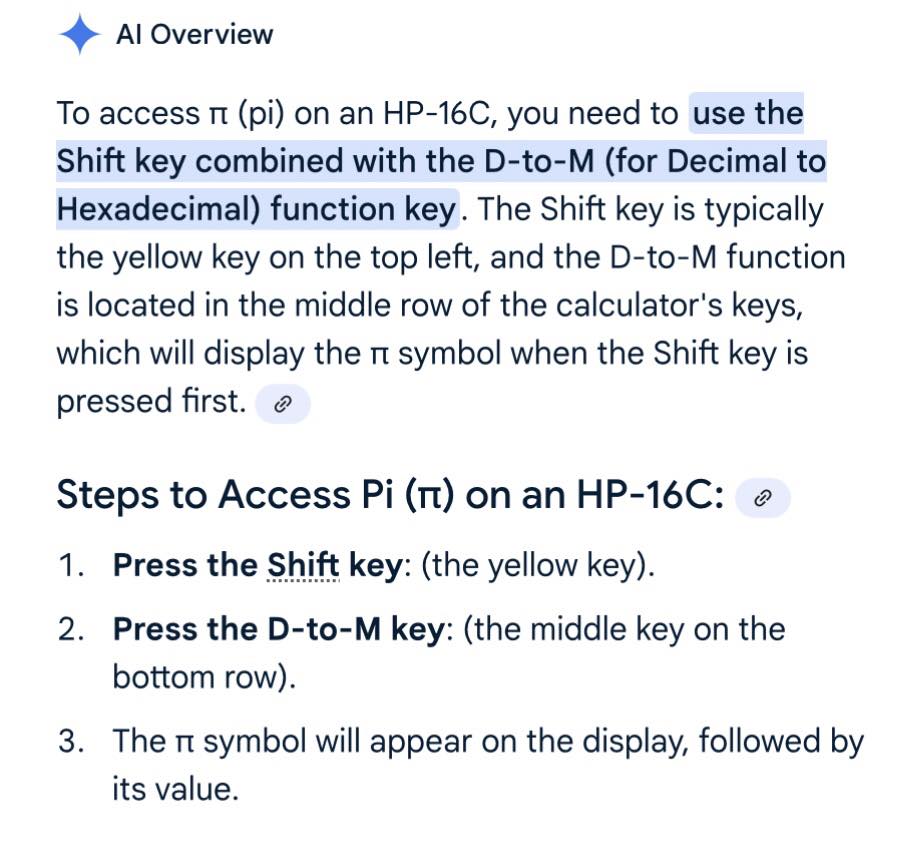

Quel modèle, quelle date, quel prompt? Parce que dans ChatGPT j'ai "The HP-16C "Computer Scientist" calculator does not actually have the π (pi) constant built in. Unlike models like the HP-15C or HP-41, which include π on a key, the HP-16C was designed specifically for programmers and focuses on integer math, bit manipulation, base conversions, and logical operations—not floating-point scientific math."

Personne ne nie que certains modèles sont plus performants que d'autres, et nombreux sont ceux qui sont intéressés à pousser ces modèles à leurs limites (combien de temps mettent 9 femmes à faire un enfant, etc), ce qui augmente évidemment le taux d'erreur.

Quel est ta référence? La vérité divine? Le meilleur spécialiste humain? Une recherche Google? Un humain moyen?

Peut-être qu'en 2025, un niveau d'exigence raisonnable (avoir une réponse équivalente à ce qu'on peut avoir auprès d'un professionnel standard, ou avoir en moins de 10 secondes une réponse équivalente à ce qu'on pourrait obtenir en 2 heures de recherche standard) permettrait déja de réaliser à quel point ces outils peuvent être utiles.

J'ai parfois l'impression qu'on attend de ces systèmes des performances infaillibles littéralement surhumaines, ce dont ils sont capables dans certains domaines, mais certainement pas dans tous. La communication en langage naturel est dans tous les cas suffisamment ambigüe pour que même un LLM infaillible ne puisse toujours donner la réponse attendue.

[^] # Re: Je me demande

Posté par pulkomandy (site web personnel, Mastodon) . Évalué à 10.

C'est ce que j'attend de l'informatique en général, oui. Peut être que je suis obsolète dans ce monde où la âérité et le processus scientifique ne sont plus considérés comme important. Ce qui compte c'est la vibe, les apparences, le "bon sens". Dans lwinformatique il me restait un domaine où je n'avais pas trop ce problème. Il pouvait toujours y avoir une réponse définitive, même si elle n'est pas forcément facile à obtenir, et qu'on peut rater des éléments de la question.

Avec les LLM on a de l'informatique qui ne garantit pas ça. Peut-êre qu'en re-posant la même question une deuxième fois ça aurait marché. Peut-être qu'en demandant la même chose demain ça ne marchera plus. La réhonse est convaincante et bien rédigée, c'est peut-être pas grave qu'elle soit fausse. Je comprend que ça convienne bien à plein d'humains, qui fonctionnent déjà comme ça de toutes façons. Mais pas moi.

Et en plus, ça fait tout ça en émettant plein de CO2, en consommant 10 fois plus d'eau et d'électricité qu'un humain, et en ignorant les hroblématiques de droit d'auteur ou en tout cas en en faisant une interprétation assez flexible. Et c'est aussi plein de gens sous-payés qui trient et étiquettent manuellement des données pour l'entraînement des modèles. Mais ça, tout le monde s'en fiche. C'est moins d'effort pour l'humain qui tient le clavier, alors, …

[^] # Re: Je me demande

Posté par thoasm . Évalué à 4.

Le domaine du benchmarking de RNN est pas du tout un truc évident. C'est pas parce qu'il y a plein de benchmarks que ça va te donner nécessairement un bon résultat dans le domaine ou tu poses la question. C'est d'autant plus compliqué à faire que ça part dans absolument tous les sens … les trucs sont optimisés jusqu'à ce que les benchmarks de référence aient de bons résultats. Ça se généralise pas forcément en dehors de ces benchmarks, et ils ont leur limite bien entendu.

Une émission sur France culture là dessus sur ce lien : https://linuxfr.org/users/thoasm/liens/evaluation-des-ia-souffler-dans-l-algotest

[^] # Re: Je me demande

Posté par Colin Pitrat (site web personnel) . Évalué à 3.

C'est pourtant facile à imaginer. Si la requête ChatGPT/Gemini/… coûte 1€ et que le revenu publicitaire est 0.8€, une fois que les investisseurs avides ne seront plus prêt à injecter des milliards dans le secteur, ça disparaîtra rapidement des résultats de recherche.

[^] # Re: Je me demande

Posté par woffer 🐧 (site web personnel) . Évalué à 7.

Je comprends ton point de vue, merci de l'avoir exposé.

Après si c'est une règle, elle était implicite et je ne l'ai jamais lu explicitement ici.

[^] # Re: Je me demande

Posté par BAud (site web personnel) . Évalué à 10.

t'as loupé un sondage récent

https://linuxfr.org/sondages/faut-il-accepter-les-contenus-generes-par-ia-sur-linuxfr-org

le résultat est explicite ;-)

[^] # Re: Je me demande

Posté par arnaudus . Évalué à 10.

Y a-t'il réellement besoin d'une règle pour quelque chose d'aussi évident? Les gens qui posent des questions sur un forum souhaitent des réponses de vrais gens, s'ils voulaient une réponse de LLM ils demanderaient à un LLM. Copier une question dans ChatGPT ne demande aucune compétence, et le faire à la place de l'OP ne fournit aucune plus-value. Si vous ne savez pas répondre, pas de problème, il suffit de ne pas répondre.

[^] # Re: Je me demande

Posté par Faya . Évalué à 9.

D'ailleurs c'est un avantage de l'apparition des LLM auquel je n'avais pas pensé : poser une question à un LLM c'est facile et rapide. S'inscrire sur un forum, poser sa question correctement, attendre une éventuelle réponse, c'est possiblement chiant dans ce monde de l'instantané. Même chercher sur Google puis ouvrir les liens et trier les réponses, ça va devenir "trop de travail" pour beaucoup surtout qu'on peut demander au LLM de faire la recherche et le tri lui-même. Du coup si on reçoit une question sur un forum, il y a de fortes chances que la personne tienne vraiment à avoir une réponse d'humain. Ça ne sera plus du fait de "j'ai la flemme de chercher". Et du coup oui, il faut absolument s'empêcher de coller une réponse de LLM à une question de forum.

Est-ce que LMGTFY va devenir LMLLMTFY ?

[^] # Re: Je me demande

Posté par fearan . Évalué à 9.

Si google avait gardé un algo performant, je dis pas, mais aujourd'hui trouver une réponse sur google est nettement plus fastidieux qu'il y'a 5-10 ans. Les réponse ne sont tout simplement pas au niveau, et je soupçonne google d'avoir baissé la qualité de leur moteur de recherche pour pousser a en faire plusieurs et afficher plus de pubs.

Le llm intégré a l'ide, même s'il propose de la merde parfois, ou des trucs inutilement compliqué, ou avec une façon archaïque est souvent plus pertinent que google. (j'ai mis duckduckgo en moteur par défaut, mais souvent je me rabat sur google, et parfois sur le llm)

Il ne faut pas décorner les boeufs avant d'avoir semé le vent

[^] # Re: Je me demande

Posté par 🚲 Tanguy Ortolo (site web personnel) . Évalué à 6.

En même temps, il faut dire que Google n'est pas conçu pour donner des réponses à des questions, mais pour trouver des pages Web contenant les termes qu'on recherche. Par exemple : « problèmes sécurité npm ». Et non pas « pourquoi npm présente-t-il des problèmes de sécurité », qui contient juste des termes parasites en plus.

La réponse à ta question, c'est à toi de te la faire à partir de tes lectures dans les pages qui traitent du sujet.

J'ai l'impression que beaucoup de gens considèrent Google comme un genre d'oracle. Forcément, ça va être moyen comme résultat.

[^] # Re: Je me demande

Posté par arnaudus . Évalué à 6. Dernière modification le 18 septembre 2025 à 10:15.

Ça n'est pas mon genre de défendre Google, mais il faut quand même avouer que de maintenir un algo performant dans un écosystème où des milliards de $ sont dépensés chaque année pour développer des stratégies visant à biaiser les résultats de ton moteur n'est pas forcément un tâche aisée. Sans compter que tes ressources ne viennent pas du service rendu aux utilisateurs mais de la publicité (donc des gens qui te payent pour que tu biaises toi-même les résultats de ton moteur). Disons que les planètes ne sont pas alignées pour maintenir la qualité des résultats des requêtes.

Mais autrement, je suis d'accord. Beaucoup de requêtes dans les moteurs de recherche sont en fait des requêtes qu'un LLM traiterait bien mieux qu'un moteur de recherche, donc la bascule vers un LLM est complètement naturelle. Avec le gros point d'interrogation du business model, évidemment.

[^] # Re: Je me demande

Posté par fortytwo . Évalué à -4.

Ton raisonnement se tient. Cependant, tout le monde n'a pas le réflexe de consulter un LLM à tout instant, donc intégrer une réponse n'est pas plus mal tant que c'est annoncé (ce qui était le cas). Même si le LLM en question n'invente pas l'eau tiède, ça fait une bonne synthèse du problème et ça évite que 36 lecteurs lancent la même requête chacun de son côté.

[^] # Re: Je me demande

Posté par Julien Jorge (site web personnel) . Évalué à 9.

N'importe quoi :D Si je pose la question ici c'est pour avoir des retours croisés de gens qui ont le nez dedans et qui ont pratiqué le sujet. Si j'avais voulu une synthèse douteuse j'aurais demandé directement à un LLM de m'en inventer une.

Même cette idée que demander un LLM est devenu standard c'est complètement bidon. Si j'avais voulu chercher moi-même des réponse j'aurais plutôt demandé à Google et lu les sites avec un regard critique. À la rigueur j'aurais pu demander à un LLM de trouver des sources sur le sujet, comme un moteur de recherche, mais je ne lui aurai pas demandé de m'inventer une explication.

Sans vouloir en rajouter sur ce qui a été reproché à woffer qui a très bien expliqué sa démarche dans les autres commentaires.

[^] # Re: Je me demande

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 10.

Ce que je n'arrive pas à comprendre c'est le besoin de demander à l'IA ce qu'on doit penser. Surtout si c'est en fait une idée qu'on a déjà.

Je n’ai aucun avis sur systemd

[^] # Re: Je me demande

Posté par woffer 🐧 (site web personnel) . Évalué à 3.

Si je l'ai demandé c'est que je n'avais pas de réponse et que la question m’intéressait, j'ai simplement demandé un avis. Après j’ai évalué sa réponse, et elle m'a semblé pertinente et logique par rapport à mon expérience.

[^] # Re: Je me demande

Posté par 🚲 Tanguy Ortolo (site web personnel) . Évalué à 10.

Ça viendrait à l'idée de qui, de copier-coller ici un passage d'un blog quelconque en guise de commentaire ? Je ne parle pas de citer un passage pour appuyer son propos, mais bien de prendre un texte de quelqu'un d'autre pour en faire l'essentiel de sa contribution.

Assimiler les informations, les résumer, les exprimer avec ses propres mots, ce serait trop demander ?

[^] # Re: Je me demande

Posté par woffer 🐧 (site web personnel) . Évalué à 3. Dernière modification le 17 septembre 2025 à 17:08.

Oui, je te l'accorde, je n'ai pas fait d'effort.

Mais j'ai surtout joué l’honnêteté et je n'ai rien caché d'où venait l'information n'étant pas à son origine.

Si ca avait un blog, j'aurai pu copier son lien pour indiquer sa source. Mais ce n'est pas possible dans ce cas.

C'est pour cela que je l'ai copié en brut de coffrage.

[^] # Re: Je me demande

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 10.

C'est déjà arrivé, et pas qu'une fois. Si je me souviens bien, ça s'attire généralement des remarques assez négatives (à juste titre).

Et, plus ou moins récemment, il y eu un résumé de Gemini sur ce lien qui a commencé à me démotiver d'écrire une dépêche sur Unicode 17 (j'ai persisté et je pense avoir eu raison). D'un autre auteur, il y a eu aussi un journal copié-collé d'une IA sur le décès d'Yvonne Choquet-Bruhat. Tellement mauvais et bourré d'infos fausses et non vérifiées qu'il a été vidé de sa "substance" par la modération, contenu remplacé par un lien vers une nécrologie. Sur le coup, ça a aussi commencé par me démotiver d'écrire la dépêche en hommage à Yvonne Choquet-Bruhat.

Tout ça pour dire que sortir du contenu direct d'IA ici, c'est assez nocif pour le site. Des sites écrits par des IA, il y a en déjà bien trop. Faisons fonctionner notre cerveau plutôt.

Et, en l'espèce le verbiage de l'IA ne contenait que deux phrases intéressantes. Nous imposer tout n'est pas très sympathique.

Je n’ai aucun avis sur systemd

[^] # Re: Je me demande

Posté par woffer 🐧 (site web personnel) . Évalué à 10.

D'ailleurs, je te remercie encore pour ta dépêche (et je suis vraiment désolé de t'avoir démotivé car je suis aussi l'auteur du résumé).

En tout cas, merci pour tout ton travail et tes contributions qui sont vraiment agréables (je n'ai malheureusement pas ton talent d’écriture, moi, j'aime le code et c'est vrai que je regarde les LLM d'un œil septique sur ce point).

Tous ça pour dire, quand même que LinuxFr est un super site où je trouve de très bonne information et on peut confronter ses points de vue.

Et je comprends maintenant mon erreur que je ne referai plus.

Grand merci à tous pour vos contributions et le temps donné à la communauté.

[^] # Re: Je me demande

Posté par Maderios . Évalué à 7.

C'est surtout une bouillie de chat et, généralement, je me demande comment en 2025 on peut prendre au sérieux des textes sortis de nulle part ressemblant à de la propagande publicitaire.

[^] # Re: Je me demande

Posté par fork_bomb . Évalué à 6.

Le sujet ce n'est pas si la réponse est pertinente ou pas, c'est que n'importe qui peut poser la question à un LLM s'il le souhaite. Donc si l'OP a posé sa question ici, c'est qu'il n'est pas intéressé par une réponse de LLM sans aucun apport humain.

[^] # Re: Je me demande

Posté par Faya . Évalué à 1.

Je répondais à un commentaire laissant penser que la sortie du LLM (dans le cas présent) c'était juste du bruit de cochon

d'inde.Alors qu'il y avait tout de même quelque chose à en tirer. Ça ne veut pas dire que j'encourage

wofferà nous envoyer des sorties de LLM. Je pense qu'il a compris (un peu tard) que ce n'est pas ce qui nous intéresse sur ce site.[^] # Re: Je me demande

Posté par devnewton 🍺 (site web personnel) . Évalué à 10.

J'ai demandé à mon androïde de compagnie Sara Bot :

Heu merci Sara, ça ira comme ça.

Ce post est offensant ? Prévenez moi sur https://linuxfr.org/board

[^] # Re: Je me demande

Posté par Lutin . Évalué à 6.

Waw ce spécisme anti-cochon décomplexé est écœurant !

[^] # Re: Je me demande

Posté par Dring . Évalué à 6.

Mon assistant robotisé Sam Bot est particulièrement emballé par la proposition de ton androïde.

Celui de mon voisin, Low Bot O’meesa (il a des origines irlandaises) se propose de les rejoindre.

[^] # Re: Je me demande

Posté par groumly . Évalué à 10.

les autres repos sont pas forcement exempt de problèmes, ruby gems a eu des problems récemment.

La grosse difference, c'est le professionnalisme des équipes derrieres, et la mentalité des communautés. Quand ton language a été designé en une apres midi, n'a jamais voulu corriger ses problèmes fondamentaux, et en plus refuse de fournir un runtime correct, tu finit avec une communauté applaudit et encourage des conneries comme les femto frameworks, dont la description (qui tient en 2 lignes) est 2 fois plus longue que le code dudit framework, avec en plus 43 dependance directes, et 2498 dependences transitives. Probleme mieux connu sous le nom de

isEven.A partir de la, t'es deja dans la mouise. Mais quand en plus tu balances cette techno sur 85% des serveurs webs de la planete, et combine ca avec une communauté connue pour se préoccuper plus des stickers sur leur laptop que leur code, ben tu finit avec le pot de pus qu'est NPM.

[^] # Re: Je me demande

Posté par Psychofox (Mastodon) . Évalué à 5.

Ce qui fait que NPM est peut-être attaqué plus, c'est la surface d'attaque.

# Shai-Hulud

Posté par 🚲 Tanguy Ortolo (site web personnel) . Évalué à 10.

J'aime bien le nom du ver des sables.

# L'avis (pessimiste) de Drew DeVault

Posté par patrick_g (site web personnel) . Évalué à 10.

https://drewdevault.com/2025/09/17/2025-09-17-An-impossible-future-for-JS.html

Extrait de la conclusion :

"No one will learn their lesson. This has been happening for decades and no one has learned anything from it yet".

Suivre le flux des commentaires

Note : les commentaires appartiennent à celles et ceux qui les ont postés. Nous n’en sommes pas responsables.