Alors dans le milieu amateur ou semi-professionnel, ils n'ont pas les mêmes fonds, mais ils sont tout de même habitué à mettre plus que le particulier dans leur matériel vidéo et audio.

Et par curiosité, quel est le besoin d'une caméra 4K pour un tel public ?

Ben écoute, y a pas si longtemps, je suis sûr que plein de gens se demandaient l'utilité du téléphone portable pour le grand public (hors professionnels). La technologie avance, et le grand public aussi aime l'idée de pouvoir y accéder, plutôt que cela soit réservé à une "élite" professionnel qui revendique son irremplaçabilité par du matériel hors de prix.

Donc oui, maintenant on fait de la super méga définition au ciné. Alors pourquoi des amateurs n'auraient pas envie, ni le droit, de pouvoir y accéder aussi (en "actif", avec création perso, et plus juste en "passif", devant sa télé)?

C'est bien ça aussi l'OpenHardware: donner accès aux gens à la connaissance et à l'action pour des choses qui étaient réservés aux "pros" jusque là (de même que le FLOSS a fait la même chose pour le logiciel).

Ensuite ça dépend des passions et intérêts. Certains aiment les véhicules et vont dépenser plus d'argent dedans, pourquoi d'autres ne pourraient aimer faire des films?

Aussi je fais clairement la différence entre professionel/amateur et qualité. Dans tous les domaines, je connais des professionnels (= des gars dont "c"'est le métier) totalement incompétent et des amateurs d'un niveau à faire pâlir nombre des dits professionnels. Une fois cela mis en place, je soutiens donc qu'il n'y a pas de raison à ce que les amateurs n'aient pas accès à du matériel de qualité si c'est techniquement/financièrement possible.

Alors pour les amateurs de l'espace, il est clair qu'ils n'auront pas accès à une navette spatiale de sitôt (cas du "pas financièrement possible"), comme ceux amateurs de l'énergie ne pourront s'amuser à faire leur mini-centrale nucléaire à la maison (cas "pas techniquement, voire légalement, possible"). Par contre, franchement avec la technologie d'aujourd'hui, limiter le matos vidéo de qualité aux pros par des prix exorbitants, c'est une limitation artificielle maintenue par des intérêts financiers. Les pros pourront toujours avoir plus de toutes façons: quand tu loues une caméra dans le cinéma, ce qui coûte cher, c'est pas seulement la caméra, c'est aussi les garanties, le service (la caméra tombe en panne, t'en reçois un remplacement dans les 2/3 heures). Le particulier doit faire bien plus gaffe à son matos, doit se débrouiller seul en cas de problème, doit bidouiller, etc. Dans toute technologie, ce qui coûte le plus cher, c'est l'humain (service, support), pas le matos, et c'est très bien (je trouve en effet que le temps qu'un être humain va partager pour régler le problème d'autrui a beaucoup plus de valeur qu'un bout de métal/plastique).

Donc quel est le "besoin"? Y en a pas. Comme y a pas non plus de "besoin" chez les pros (des pros peuvent faire sans 4K aussi. C'est même un concept chez certains. J'ai vu des films pros tournés entièrement sur des téléphones, et c'était le concept du film). Par contre "envie", oui, il peut ou non y en avoir. Et dans ce cas là, si c'est techniquement possible de donner accès au plus grand monde par l'OpenHardware, je dis: ben c'est cool.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

En ce moment ce sont plutôt les "ingénieurs hardware" qui ont oeuvrés,

Oui mais uniquement car ils n'ont que cela. Je peux te dire que sur la liste de développement du projet, à chaque fois qu'un développeur se présentait, on lui sautait dessus pour l'accueillir. Mais à ma connaissance aucun n'a réellement fait de contribution approfondie. Par contre y a plus de mecs dans le hardware qui sont arrivés et qui ont effectivement livré quelque chose. Alors bien sûr, les mecs du hardware, ils peuvent aussi développer. Mais bon avoir aussi d'autres gens plus spécialisés en software serait pas un mal.

Ensuite clairement le hardware est la priorité pour le moment, donc c'est pas le pire des cas. Mais je peux te dire que vu de l'intérieur, ne pas avoir plus avancé aussi au niveau software, en parallèle, c'était pas un choix.

Donc l'Axiom Beta qui est opérationnelle va être lâchée dans la nature et l'une des cibles (l'autre étant les vidéastes) est clairement celle des développeurs.

Comme dit plus bas, c'est Alpha qui est opérationnelle. Beta sera le résultat du financement.

Sinon la cible de Beta, côté vidéaste, c'est seulement une partie d'entre eux, ceux qui ont pas peur du côté technique et de devoir un peu plus bidouiller que la moyenne. Pour les vidéastes de manière général (ceux qui veulent pas trop se poser de question également), ce sera plutôt Gamma.

Par contre oui les développeurs, ingénieurs, techniciens, scientifiques et cinéastes bidouilleurs sont plus la cible directe de Beta. Ensuite faut pas croire, les cinéastes qui veulent pas de caméra trop expérimentale, mais ont des sous et sont prêts à faire avancer le schmilblick pour arriver plus tard à Gamma qu'ils pourront alors acquérir sont aussi invités à financer le projet!

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Bref, l’Axiom utilisera très probablement un capteur APS-C 22.8×16.9mm qui a l’avantage de contenir le format Super 35. Et même s’il était de très bonne qualité, ça ne pourrait pas séduire un photographe exigeant qui a l’habitude d’utiliser au minimum du Plein-Format 24×36mm, surtout que les optiques haut de gamme sont faites pour, et là, on trouve des boîtiers à 2000€.

Ça c'est ce qu'ils ont fait avec l'AXIOM Alpha (prototype actuel). L'AXIOM Beta (le résultat du financement) sera le Truesense KAC12040 de base, mais ils prévoient de proposer des options pour d'autres capteurs (lire AXIOM Beta). Cependant cela dépendra du succès du financement (des "stretch goals").

En fait ça dépendra donc beaucoup de ce que les gens sont prêts à mettre pour passer un cran dans la qualité d'image.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

1) peuvent se permettre de mettre plusieurs milliers d'euros pour une caméra professionnelle?

D'après moi clairement. Dans le milieu du cinéma, ils mettent vraiment des sommes faramineuses. Alors dans le milieu amateur ou semi-professionnel, ils n'ont pas les mêmes fonds, mais ils sont tout de même habitué à mettre plus que le particulier dans leur matériel vidéo et audio.

Ensuite le financement parviendra-t-il à son but? L'avenir nous le dira mais même un échec ne pourra être interprété comme un échec plus générique de l'open-hardware dans le cinéma. Plein d'autres raisons peuvent expliquer cela. De toutes façons, perso j'y crois.

2)qui ne l'auraient pas déjà fait en s'achetant un autre appareil du commerce,

Bah les gens sont prêts à changer de matos s'il le faut. Et puis c'est pas comme si y a pas des nouveaux tous les ans (comme dans tous les métiers: les jeunes sont les futurs vieux!). C'est absurde de supposer que tous les cinéastes ont déjà leur matos pour les prochaines années. Dans ce cas là, y aurait pas qu'Apertus dans la merde. Le marché des caméras de cinéma serait verrouillé et plein de boites couleraient! uhuh

3)prendraient le risque, pour un tel montant, d'un appareil non éprouvé?

Ben ça reste raisonnable pour beaucoup de gens au contraire. Une location de caméra pour un film ciné à petit budget est déjà plusieurs fois ce prix là.

L'AXIOM BETA est la BETA d'une caméra qui va évoluer pour arriver à l'ALPHA

Euh non c'est l'inverse. Alpha, c'est fait, c'est maintenant. C'est le prototype qui est présenté maintenant tout de suite, les premiers tests, les premiers essais. Puis on s'est rendu compte des erreurs de conception, de jeunesse, le fait que ce premier prototype est trop cher et compliqué à dupliquer, que plusieurs des choix et designs électroniques n'étaient pas idéaux, etc. Beta sera donc le résultat suite au financement collaboratif, bénéficiaire de ce qu'on apprend de nos erreurs, et sera ce que les "financeurs" recevront à la fin.

Plus tard y aura gamma, qui devrait être un modèle plus "prêt à l'emploi". Et j'imagine que si ça continue comme ça, un jour il pourrait y avoir delta, etc. ;-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

C'est bizarre, la page dit "Laptops are currently unsupported". Quelle est la différence entre un ordi portable et de bureau? C'est la même chose fondamentalement. C'est la première fois que je vois un programme faire une telle différence, et je me demande si le programme refusera de marcher si je le lance depuis un portable, ou bien si le site refusera mes rapports de compatibilité s'il détecte que je les ai envoyé depuis un portable…

Sinon la seconde chose qui me chagrine est que pour rapporter du matériel, il est écrit qu'on doit utiliser une des distribs appuyées par la FSF (c'est à dire pas grand chose d'utilisé, ça fait vraiment un micro pourcentage des utilisateurs), ou une Debian avec seulement le dépôt "main" activé (là y en a plus, mais ce choix est arbitraire).

Encore une fois, je me demande ce qu'il se passe si on envoie un rapport de matos fait depuis une autre distrib. Sera-t-elle refusée? Non parce que cela rend le site beaucoup moins utile si quelques pourcents des utilisateurs GNU/Linux seulement peuvent rapporter.

Bien sûr, je comprends tout à fait qu'ils limitent leur site aux matos qui ne marchent qu'avec du Libre, tout comme je comprends qu'ils appuient particulièrement les distribs qui prennent le parti de ne rien accepter de non-Libre. C'est la FSF, c'est leur rôle. Par contre tout le monde aurait à y gagner si tout le monde pouvait faire des rapports de matos. Y a des moyens de savoir si un matériel donné utilise des drivers/firmware non-Libre.

Sans compter que ça veut rien dire si les dépôts non-Libres d'une Debian sont pas activés au moment du test: il suffit qu'ils aient été activés à un moment pour avoir installé des drivers proprios à ce moment là. De même qu'il est possible aussi de désactiver les dépôts non-Libre sur toute (ou presque, je sais pas si y a des distribs qui ne séparent pas le non-Libre dans un dépôt à part, mais ce serait l'exception) distrib GNU. Sur le coup, ils mettent uniquement Debian à part parce que c'est une collaboration entre FSF et eux. Mais c'est loin d'être une différenciation justifiée.

D'ailleurs même les distribs 100% Libres, les utilisateurs ont pu installer "à la main" des drivers non-Libres à un moment.

Enfin voilà, ce serait bien plus logique de faire une détection automatique du driver utilisé pour un composant particulier, de l'envoyer avec le rapport, et là les utilisateurs qui savent peuvent flagger le driver comme Libre ou non (et ne pas afficher sur le site tout rapport avec un driver non-Libre). Y aurait donc une table dans la base pour les drivers qui dise s'il est Libre ou non et s'il utilise un blob binaire ou non. L'utilisateur n'aura donc pas à se poser de question et pourra envoyer son rapport, qui sera automatiquement ajouté si on sait que le driver associé est Libre, ou refusé avec message explicatif dans le cas contraire. Si c'est un driver inconnu, le rapport peut rester en attente d'autres membres de la communauté à même de dire si c'est un driver Libre ou pas.

D'ailleurs je suis à peu près sûr que leur client envoie déjà automatiquement le driver utilisé au serveur (en tous cas, je vois qu'ils listent les drivers par périphérique sur le site), y a plus qu'à (comme on dit) implémenter le système de validation sur le site. Deuxième chose serait de s'assurer qu'ils l'acceptent et qu'ils soient pas trop arrêté sur leur décision de privilégier certaines distribs.

Je jetterai un œil plus tard, y a peut-être un patch à faire et à leur envoyer. :-)

Mais comme je dis toujours, si quelqu'un aime l'idée et veut proposer avant moi, faites vous plaisir! J'ai pas exclusivité sur les idées et je serais pas contre utiliser mon temps autrement.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Pour répondre au message originel: c'est bien leur but de coupler ce projet avec un projet de montage. En fait ils sont très ouverts sur "comment", ils veulent juste un bon logiciel. Cela pourrait être un logiciel existant qu'ils pourraient améliorer pour le rendre pro et compatible à leurs exigences; cela pourrait être faire un logiciel eux-même qui répondra parfaitement au cahier des charges (oui je sais, c'est trop gros, mais en même temps, ils font aussi une caméra à partir de zéro, ça aussi c'est gros!); cela pourrait se mettre en collaboration avec un projet existant pour travailler main dans la main (y a eu un tel rapprochement avec une société qui faisait un logiciel de montage OpenSource dont j'avais jamais entendu parler. Mais ça n'est jamais allé plus loin que la discussion, sauf si j'ai loupé qqch).

Dans tous les cas, il manque une chose dans leur projet: des développeurs. C'est marrant mais de notre côté dév, on a toujours l'impression qu'on n'a que des développeurs et qu'il manque tous les autres. Ben de leur côté, ils ont réussi à chopper plein de mecs super compétents en électronique, qui ont même déjà participé à des élaborations de caméras du marché pour certains, mais les dévs? Que dalle. Oh y a eu pas mal de mecs qui se sont proposés (dont moi), mais au final sans vrai résultat (j'ai d'autres priorités malheureusement dans l'immédiat). C'est donc assez drôle et même socialement intéressant de constater que le problème n'est pas qu'il manque de mecs pour le hardware, mais c'est juste qu'on n'arrive pas à se mettre ensemble plus.

Enfin oui, tout ça pour dire: c'est l'idée, mais ils n'attendent que les dévs. Qu'attendez-vous?! :-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Pourrait-on rajouter cette info dans la dépêche. Voici l'email envoyé sur la mailing liste communautaire:

To participate in the "hopefully" very successful launch of the campaign tomorrow you are all invited to the IRC Launch party starting 1 hour before the campaign launches at 9 AM (Central European Summer Time)

I will share some treasures from the AXIOM development history like renderings how we anticipated the camera to look over 3 years ago and we can just have a good time, like a real party just without seeing each other :)

Hope to see you on IRC!

En gros, une heure avant la fin du décompte, ils proposent à toute la communauté de se rendre sur IRC pour discuter, et ils partageront quelques "trésors" de l'histoire du développement d'AXIOM.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Je suis assez d'accord. Pour moi cinelerra, cela fait longtemps que je ne le considère même plus dans mes comparaisons et tests de logiciels de montage vidéo.

Les dernières fois où j'ai essayé de l'utiliser, il y a peut-être 2/3 années de cela, il était tout simplement instable. Il crashait toutes les 10 secs pour un oui ou un non. Donc franchement j'ai laissé tomber avant même de savoir si le logiciel "pourrait" être bien ou non, s'il ne se crashait pas constamment.

Les fois où j'ai essayé de le compiler, à peu près à la même période, soit 2/3 ans auparavant aussi (donc peut-être qu'à l'époque je m'y connaissais moins aussi), c'était la croix et la bannière.

Il n'est même plus dispo de base dans pas mal de distributions. Déjà parce qu'il dépend fondamentalement de la libfaac qui a des problèmes de brevets (or si certains logiciels ont une dépendance optionnelle, cinelerra apparemment ne peut pas faire grand chose sans libfaac). Donc les distribs qui n'ont pas de dépôts teintés ne proposent pas cinelerra (par exemple: mageia). D'ailleurs je viens de vérifier, même si ma Linux Mint propose libfaac, elle, ben y a pas de cinelerra pour autant dans les dépôts. C'est clairement plus un logiciel prioritaire pour personne.

Enfin regarde le résumé des commits du projet communautaire sur les dernières années sur ce site: https://www.openhub.net/p/cinelerra/commits/summary

Y a eu quasi absence de commits entre 2007 et 2014! C'était donc un projet mort. Je remarque d'ailleurs que ça reprend seulement depuis avril 2014 (tout frais! Je jetterai un œil de temps en temps pour voir si le projet se relance vraiment ou si c'est juste un soubresaut. Si ça continue à un tel rythme de dizaines de commits par mois pendant des années, ça peut revenir dans la danse).

Bon apparemment cinelerra est aussi développé par une société, Heroine Virtual LTD, mais bon la page de download indique tout de même « Downloads have no support or warranty and are not community approved. Linux derivatives are so incompatible, don't be surprised if the source code requires some tweeks and the binary doesn't work. » ce qui donne pas confiance dans leur qualité de développement (chez moi avec les bons outils, y a pas d'incompatibilités extraordinaires entre les diverses distrib GNU/Linux. Qu'on dise "attention testé seulement sur…" ok, mais là c'est bizarre comme tournure). Mais bon on peut s'attendre dans ce cas à ce que le logiciel s'améliore?.. À voir… Dans tous les cas, le problème de manque d'ouverture et d'absence de dépôt de source accessible au public rend ce développement plus hasardeux (ils font juste des sorties).

Et on peut clairement lire que ce n'est plus la priorité de cette boîte. Ils l'ont présenté à quelques "shows" entre 2000 et 2004, puis plus rien, d'après leur site. Je parle même pas du copyright de bas-de-page: «(C) 2013 Unemployed, flat broke Programmers»

Je constate aussi qu'il y a deux site web pour la version communautaire: le site originel cinelerra.org, qu'ils ont et un nouveau site web: http://cinelerra-cv.org/

Apparemment cinelerra.org n'a pas été renouvelé et quelqu'un s'en est emparé. Mais de façon amusante, ça parle toujours de Cinelerra, mais seulement de la version pro, j'ai l'impression (est-ce la société Heroine Virtual qui a racheté? Le whois ne dit pas). Et il n'y a rien pour télécharger (par contre, on nous demande notre email pour un "download update").

Enfin bon, tout ça m'a l'air bien compliqué. Peut-être cinelerra mérite-t-il de nouveaux tests? Mais j'espère vraiment qu'ils ont amélioré la stabilité car c'est vraiment là où ça pêchait.

Tout ça pour dire que cela ne m'étonne pas qu'on ne considère plus cinelerra dans la course. Blender aussi à l'époque les gens disaient qu'ils avaient un UI dur à prendre en main, etc. Ben ils ont bossé comme des dingues pour s'imposer (et changer ce qu'il fallait) et ils sont loin de cette époque maintenant. Cinelerra aurait pu faire la même chose, mais j'ai l'impression que cela fait longtemps qu'ils se sont laissé aller.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Ok.

Je serais personnellement pour prévenir l'association LinuQ, et retirer le lien de linuxfr (éventuellement temporairement le temps qu'ils trouvent le problème) avec un petit message expliquant pourquoi. Je doute qu'un lien en première page de linuxfr qui redirige sur un site de cul soit vraiment idéal.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Uh! J'ai eu exactement la même page que toi à l'instant (sauf que la mienne, y avait pas de culotte)! Mais si je réessaie immédiatement après, ça me donne dorénavant la bonne page. Y a un problème quelque part là, le système de redirection de linuxfr n'aurait-il pas été corrompu et redirigerait de temps en temps vers ce site? Ou alors c'est le site du lien lui-même qui aurait ce problème. Mais dans les deux cas, je doute que ce soit normal.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Sur testing c'est ce que tu as (les paquets n'entrent jamais directement dans testing, ils entrent sur sid (= unstable) puis après une semaine arrivent dans testing.

Ah ok. On entends tout de même pas mal d'histoires terribles sur les problèmes rencontrés en utilisant Debian testing. C'est pour cela que je faisais cette distinction.

Je me demande d'ailleurs à quel point on peut tester un build en une seule semaine. Dans Gentoo, je sais pas combien de temps les paquets restaient "unstable", mais cela pouvait durer longtemps, surtout pour les petites applications pas très utilisées (qui parfois restent même indéfiniment "unstable" si le peu d'utilisateurs fait que personne ne remonte rien). Évidemment les gros logiciels connus eux passent stable bien plus rapidement (mais en combien de temps? Une semaine me paraît tout de même un chouille court, non? Quoique si c'est Firefox, les retours doivent être par dizaines au bout de quelques jours…).

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Ah ok, bon ben voilà. S'ils inventent encore d'autres trucs pour contourner le fait qu'ils prennent pas de fichiers… C'est pourtant simple les fichiers. Un concept que tout le monde comprend parmi les développeurs, non? Pourquoi remplacer cela par un service de copier-coller en ligne?

bla bla mailing list

La plupart des mailing-list accepte les mails des gens hors-ml (souvent après modération dans 99% du temps). Donc ce n'est pas un grave problème. D'autant plus que si c'est un simple "bug + patch", le bugtracker est plus approprié (et celui-ci ne spam pas grand chose en général).

Effectivement ça peut déranger d'envoyer ton patch sur la mailing list, mais donc uniquement parce que c'est pas vraiment l'endroit (c'est dur de faire du suivi dans un contexte de flot d'emails. On perdrait les patchs!). D'ailleurs certains projets filtrent même les fichiers des emails (pour éviter les gens qui mettent d'énormes fichiers, ou bien les fichiers à but malveillant, etc.). Sur les mailing lists GIMP par exemple, ton email arriverait sans le patch. Tout ça pour dire que c'est vraiment pas l'endroit.

Ensuite oui, je suis d'accord que ça veut dire devoir s'inscrire encore à un énième site pour déposer son rapport de bug. Et ça c'est chiant. C'est un problème qui existe depuis l'aube de l'internet. Mais centraliser tout dans les mains d'une unique entreprise n'est pas, et ne sera jamais selon moi, la solution (même si c'est effectivement celle que poussent comme par hasard toutes les entreprises, entre les "connect by Facebook" et autres trucs du même acabit). Les solutions acceptables seraient plus dans l'optique openid, avec le succès (peu) qu'on connaît (mérité peut-être car je ne trouve pas la solution technique si adéquate). En attendant, faut faire avec. Je préfère tout de même faire un énième compte sur le site d'un projet auquel j'ai décidé de faire confiance (sinon je leur enverrais pas de patch probablement), plutôt que pousser l'ensemble des développeurs du Libre à s'enfermer dans un unique "réseau social développeur", propriétaire et sous le contrôle d'une unique société.

Note que j'ai rien contre les sociétés qui font cela. C'est une très bonne idée et un plutôt ok service dans le cas de github. Je suis juste pour la diversité, et je refuse de mettre tous mes œufs dans un même panier. Donc je ne ferai jamais la promotion publique d'un service en particulier. Enfin si, je peux dire "c'est bien, ça marche" (c'est le cas de github: "c'est bien, ça marche", mais ça a vraiment rien d'une révolution et leur workflow est tordu et mal-foutu par endroit. Cf. cette discussion), si on me demande, mais ça s'arrête là. :-)

Mais il illustre un autre avantage (mineur je le reconnais) de cette incitation au fork : même si un jour le dev initial décide (sur un coup de tête, problème légal,…) de tout supprimer, le code est toujours là. Avantage que n’auront pas les petits projets sur des trucs genre sourceforge.

Euh, par définition, tous les gens qui ont le dépôt git ont la même chose, pas besoin de github …

Tout pareil: c'est le principe de git. Je vois pas le rapport avec le fait que ce soit sous github, sourceforge, auto-hébergé ou autre. À te lire, on dirait que github a inventé git!

[Note: pour être clair, je réponds à Moonz, pas à Zul. Mais comme je suis globalement d'accord avec Zul, j'ai pris son message comme base.]

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Moi, quand je dis "rolling release", j'entends "stable". Je sais pas comment c'est sur Arch, mais en lisant la description plus haut, cela m'a l'air similaire à ce que j'avais sur Gentoo: des paquets stables et déjà testés. Mon expérience Gentoo fut vraiment très satisfaisante. C'était très stable. Une mise à jour ne pêtait pas tout.

Ça ne dit pas qu'il ne peut y avoir un problème innattendu qui pête ta machine, mais comme pour toute autre distribution stable: ce serait une erreur passée entre les mailles du filet, et à corriger rapidement, non la norme.

Debian testing au contraire, c'est de l'expérimental (d'où le nom "testing"). Les utilisateurs sont des contributeurs qui acceptent d'être les premiers à essayer des paquets non-testés, pour ensuite remonter les problèmes, avec tous les risques que cela comprend. Ensuite c'est peut-être à considérer "rolling release" aussi, mais c'est juste pour dire que c'est pas du tout la même catégorie. C'est pas fait pour être sur ta machine principale (enfin tu peux, mais à tes risques et périls). Gentoo par contre si (note que sous Gentoo aussi, on peut récupérer les paquets non-testés si on veut, et on se retrouverait alors dans le cas Debian testing. Ce qui est super bien ceci dit, c'est la gestion fine des tests: un flag au niveau des paquets. Donc on peut télécharger certains paquets en tests, et le reste en stable par exemple).

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Ce qui t'embète sans doute, c'est de simplifier la vie de mainteneur (sur GitHub, il accepte ou pas ton patch, tout est prêt, pas à s'embeter, ton nom tout ça tout comme il faut, la discussion a eu lieu ailleurs).

La discussion, qu'elle ait lieu dans une mailing list, sur un bugtracker ou sur github, je vois pas la différence.

Ensuite j'ose espérer que les mainteneurs github testent les patchs sur leur dépôt local, et se contentent pas de croire sur parole un inconnu. Quand ça vient d'un contributeur habituel ou que c'est un patch très mineur (changement de string ou autre), ok, se contenter de regarder la syntaxe peut suffire. Mais sinon, même un patch d'une ligne peut casser des choses, et la plupart du temps, ne pas tester n'est pas conseillé.

Donc déjà à partir de là, faut quitter son navigateur et appliquer le patch. Une fois fait, testé et approuvé, y a juste à git push. Avec github, il faudrait revenir dans son navigateur pour faire le changement.

Ensuite quand tu me dis "pas à s'embeter, ton nom tout ça tout comme il faut", j'ai tendance à penser que tu n'as jamais fait ou reçu de patch git, ou alors je comprends pas ce que tu veux dire.

Quand quelqu'un m'envoie un patch git, je le git am, et j'ai un git log parfaitement "comme il faut", avec le nom de l'auteur et son email, la date de son commit (pas seulement la date à laquelle j'ai appliqué le patch, qui elle correspond au CommitDate), et finalement le message de commit qu'il avait déjà préparé. "Pas à s'embêter", comme tu dis. Une fois bien testé et approuvé, j'ai juste à git push, et c'est fini. On gère un patch envoyé en deux commandes (avec les commandes de build, etc. et tests entre-deux normalement, mais ça, c'est pareil quelque soit le workflow si on fait les choses consciencieusement), en restant dans sa console.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

ça me paraît normal que ce sot le mainteneur qui définisse le workflow qu’il préfère — après tout c’est lui qui a à gérer des patchs tous les jours.

Ça je suis d'accord. Je ne me suis d'ailleurs jamais plaint à un mainteneur d'un projet sur github directement, et je suis le processus demandé douloureusement mais silencieusement. Je répondais juste à la remarque générale comme quoi tu trouvais ce nouveau workflow git (car non ce n'est pas le workflow prévu pour git, j'y reviens plus bas) révolutionnaire.

Gist est fait pour ce genre de choses.

Tututut. Demandons par exemple au développeur originel de git, Linus Torvalds: https://github.com/torvalds/linux/pull/17#issuecomment-5654674

Donc non clairement, ce n'est pas le workflow prévu par git.

Ensuite il y a des logiques de workflow différentes, et chacun est libre, encore une fois. Je n'arrive pas avec mes gros sabots voir un mainteneur d'un projet et lui dire que son workflow pue et qu'il devrait changer. Mais lire que git est fait pour ce workflow, ben non clairement. Là faut pas abuser, surtout quand l'auteur de git a déjà dit maintes fois que c'est pas le cas et refuse tout "pull request" passant par le système complètement cassé de github.

Comme dit juste au dessus, c'est pas vrai. Cette façon de faire est une spécificité github. Mais effectivement quand on reste dans la "communauté" github de gens qui ne connaissent que cette façon de faire, on a l'impression que tout le monde aime cela. Ben moi en dehors de cette communauté, je rencontre aussi plein de gens qui n'aiment pas.

Je fais des branches à part pour à peu près tout (je suis un grand partisan d'un workflow par "branche de fonctionnalité"), mais il y a plein de cas pour lesquels ne pas avoir 2 branches séparées est valable, ne serait-ce que pour 2 patchs mineurs sans aucun rapport, et sur des fichiers totalement différents (ils ne peuvent pas interférer). En gros faut quand même distinguer une branche de fonctionnalité d'un bug fix de quelques lignes.

Ensuite, dans mon précédent message, je parlais pas de cherry-pick (j'ai pas compris pourquoi tu m'en parlais). On ne fait pas de cherry-pick tout le temps, effectivement ce serait très lourd. Non on git am (on peut le git apply d'abord s'il s'agit d'un patch compliqué et qu'on veut le tester en profondeur sans avoir peur de le pousser par erreur) un patch proprement formatté par github, avec message, auteur et tout. On teste, puis on pousse.

Pour des petits contributeurs, il est normal de faire les choses par fichiers. Rends toi compte que le système à la github est en train de pousser les gens à mettre en ligne un dépôt public, pour des fois un patch d'une ligne, et qu'ils ne reviendront jamais sur ce dépôt? C'est le marteau pour écraser la mouche. Github simplifie cela en rendant cette partie facile, mais la contrepartie c'est qu'on se retrouve à avoir des dizaines de clones publiées pour plein de projets (les fameux "forks") qui sont juste des zombies laissés à l'abandon.

Donc non le coup de merger des branches, c'est bien entre contributeurs importants, ceux pour qui effectivement cela devient plus pratique d'avoir une branche publique. Tu penses que combien de personnes ont leur propre branche sur les projets énormes comme linux? Les divers mainteneurs, et quelques contributeurs très prolifiques. Et encore souvent, eux se feront des branches sur un même dépôt, pas leur propre dépôt!

Et tu penses que faire son propre dépôt devrait être la norme, même pour les contributeurs mineurs? C'est de la folie. C'est pas pour rien que git send-email a été inventé. C'est parce que contribuer par patch est la norme des petits contributeurs, les branches publiques, on les laisse aux gros contributeurs.

Encore une fois, de la littérature par l'auteur de git: https://www.kernel.org/doc/Documentation/SubmittingPatches

Comme tu le vois, les pull requests sont un seul point, le dernier, pour envoyer des patchs (point 16 de la section 1). Tout le reste se concentre sur le formattage de patch en fichier à envoyer par email (note que lu comme ça, ça a l'air compliqué, mais je pense que c'est parce que c'est un vieux texte. De nos jours, quasi tout ce blabla se fait en une ligne: git format-patch origin/master, "master" à remplacer par une autre branche selon la branche qui sert réellement d'origine). Parce que franchement faire un dépôt public pour un patch, c'est vraiment en faire un peu trop.

Je pense que github a même cet effet pervers d'empêcher les gens à apprendre à connaître vraiment git et son fonctionnement. On rencontre régulièrement des gens qui veulent qu'on fasse tout sur github, mais c'est uniquement parce qu'il ne connaissent que cela et qu'ils se rendent compte qu'il ne savent pas utiliser git en dehors des boutons du navigateur (sérieusement, le fait que tu me répondes "cherry-pick" à un "format-patch" par exemple me fait des doutes quant à ta compréhension de comment marchent les patchs formattés par git; le fait que tu me parles de "branches" alors que github fait même carrêment des clones de partout aussi).

c’est vachement plus simple pour rebase (rebase sur master c’est une très très mauvaise idée)

Oulaaaaah! C'est une très mauvaise idée… sur toutes les branches publiques! Encore une fois, il y a plusieurs logiques. Certains vont effectivement rebaser des branches de fonctionnalités, même publiques (il y a effectivement 2 écoles majeures: les rebaseurs fous, et les mergeurs fous. Curieusement tu m'as l'air d'être un mix des deux…). Mais c'est loin de faire l'unanimité. Encore une fois, tu dis ça à Linus, il t'insultera allégrement. Sa logique, qui est le workflow du projet du noyau linux, et donc probablement très répandue, est de ne jamais rebaser une branche de fonctionnalité publique. C'est exactement la même chose que master, dont tu parlais plus bas. Une branche publique, quelle qu'elle soit, se retrouve copiée dans les dépôts locaux de tous ceux qui ont cloné le dépôt. Et il est tout à fait possible que quelqu'un ait commencé à bosser dessus. Rebaser dans ce cas fout le bordel (oblige de créer une série de patchs et/ou stasher pour ce qui n'est pas déjà sous la forme de commits, supprimer sa branche locale, la recréer, et ré-appliquer tous ses propres patchs. Très lourd). En outre tu casses un historique de hash de commit, ce qui peut créer des problèmes de discussions. À partir du moment où une branche a été rendue publique, on a pu discuter certains commits sur une mailing-list/chat/tracker/etc. Et on rend tout nommage de commit inutile si on se permet de renommer (par rebase) à tout va.

Heu… tu vas sur https://github.com/joincamp/flp.mobi/ par exemple, et juste en dessous du nom tu as « forked from fmap/flp.mobi ». Tu vas sur https://github.com/joincamp/flp.mobi/network/members et tu as le graphe des forks, avec l’upstream en tant que racine de l’arbre. Le seul truc un peu mal fait c’est que c’est pas clair du tout pour un mainteneur de dire « je passe la maintenance à x » (je sais même pas si c’est possible autrement que par un README en fait). Mais c’est pas tellement dramatique dans la mesure ou tu peux autoriser celui à qui tu passes le lead à push dans ton dépot :)

Mouais je comprendrais jamais comment on peut trouver sain cette nouvelle mode de tout forker. Comme tu le confirmes, rien n'est clair. Et je suis désolé, même le "forked from" est loin d'être la première chose que tu vois en arrivant sur la page (encore une fois, pour ceux qui passent leur temps dans github, c'est peut-être évident, mais pour les autres…).

Avec ton exemple, je suis en effet totalement dans le flou. Y a une vingtaine de forks, la plupart quasi les mêmes, mais parfois avec une petite différence, rarement mais parfois avec beaucoup de différences. Et ironiquement, le dépôt original a été vidé (et le README ne passe pas la maintenance justement). Donc si t'es un dév, ou un utilisateur, tu fais quoi? Tu testes les 21 forks un à un pour voir ce qui a changé?

Franchement ce système de fork, c'est plus du réseau social qu'autre chose (plein de gens me forkent! Oh oui allez y, forkez moi! ;-p), mais je trouve cela anti-productif.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Sérieux, je suis pas d'accord. Github marche bien quand on est toujours dedans, et qu'on ne bosse qu'avec ça. C'est d'ailleurs le but de la plateforme: enfermer les développeurs à l'intérieur et faire en sorte qu'ils n'en sortent pas.

J'ai essayé l'autre jour de patcher des bugs dans un projet hébergé par github. Au début, je fais un rapport de bug, me disant que je vais y uploader mon patch (correctement formaté avec git format-patch origin/master). Ah pas possible. On peut seulement uploader des images. Sérieux?!

Je me suis retrouvé à devoir "forker" le projet (sur le site web seulement), modifier mon .git/config pour ajouter mon remote, pousser mes commits, retourner sur le site, et finalement faire une demande de pull (on peut même pas faire une demande par commits, mais pour tous les commits d'une branche donné. Uh?!). Sérieux, on trouve ça plus simple?!? En plus si je veux suivre le projet, je me retrouve à devoir gérer 2 remotes depuis mon dépôt local. Note que c'est courant voire normal de gérer plusieurs remotes si t'es un mainteneur d'un gros projet, mais c'est lourd pour un contributeur intermittent (qui envoie un patch tous les 36 du mois) car on peut se retrouver vite à s'emmêler les pinceaux. Avoir des branches locales et se baser sur un seul remote est bien plus facile.

Bien sûr la raison est de te pousser à gérer tout cela dans ton navigateur, sur le site web, puisque leur UI a un workflow adapté à ces logiques incongrues. Mais franchement je préfère de loin gérer le plus de truc possible dans ma console.

Je parle même pas de la sémantique. C'est pas un fork que je veux faire! Je veux juste patcher un projet, pas le forker. C'est d'ailleurs terrible pour les petits projets: combien de fois (des dizaines!) je me suis retrouvé sur un projet github à me demander s'il s'agit de l'upstream ou non. Pour des petits projets, un moteur de recherche peut répondre plusieurs pages github et la première n'est régulièrement pas l'upstream.

Non, moi si je veux publier un projet, je reste sur tuxfamily ou autre petit hébergeur. Au moins, ils essaient pas de se faire passer pour du réseau social.

Et je dis tout ça, mais j'ai pas mal utilisé Github, quotidiennement et des milliers de commits lorsque je bossais pour une startup qui l'utilisait. Ça marche très bien tant qu'on reste dedans et qu'on s'adapte à leur logique bizarre de fork, y a pas à dire. Mais c'est loin d'être la meilleure logique de contribution.

Sinon pour répondre, moi aussi, c'est pour moi: je veux réparer des logiciels ou avoir des fonctionnalités, je les code. J'ai appris à ne plus me reposer sur et attendre les autres, mais à faire les choses moi-même.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

C'est vrai, y a de quoi se poser la question. D'ailleurs quelque chose d'autre m'a intrigué: pour les utilisations "routinières" dont tu parles (signer, déchiffrer, authentifier), s'il n'y avait pas la carte, les logiciels de cryptage (GnuPG en tête donc) tirerait profit de /dev/(u?)random, non? Donc finalement, ton programme ne pourrait-il pas tout simplement remplacer Scdaemon de manière transparente? GnuPG ne communiquerait plus directement avec la carte, mais en cherchant de l'aléa dans les /dev/(u?)random, il utiliserait indirectement la carte en fait, sans même avoir à le savoir.

Ou alors la carte a d'autres fonctionnalités et son rôle n'est pas uniquement de produire de l'aléa rapidement. Y a un processeur dédié pour accélérer des calculs de crypto aussi, peut-être?

Comme je le disais, je connais rien à ces cartes, donc ces questions sont peut-être un peu ridicules, mais bon. C'est bien pour ça qu'on demande un article supplémentaire dessus. ;-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Mais ce type de carte ne marche qu'avec GNUPG? J'imagine que c'est quand même plus générique et que cela peut avoir d'autre usage, non? Parce que si c'est le cas, je préférerai un article sur ce type de carte et ses différents usage, à quoi ça sert, à quoi ça ne sert pas (par ex si j'ai bien compris, cela ne rend pas les choses plus sûrs, mais plus rapides, etc.), quels logiciels peuvent en tirer profit, etc.

Ça empêche pas de faire aussi un article séparé sur GNUPG si vous voulez, mais je ne voudrais pas que cela éclipse le sujet de ce type de carte, perso. Donc 2 articles, c'est peut-être mieux. Un qui focalise sur les cartes, l'autres sur GNUPG. Car GNUPG, bon je suis pas expert, mais je connais déjà un peu. Par contre ces cartes, ça m'intrigue. Je savais que ça existait, mais c'est la première fois que je lis un cas d'utilisation.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

C'est vachement intéressant, mais je me demandais si le but est seulement d'améliorer la vitesse d'utilisation des logiciels qui utilisent /dev/random et /dev/urandom ou si cela en améliorait aussi la "qualité" d'aléatoire. De l'aléa de meilleur qualité que ce qu'il y a en général dans ces interfaces.

Aussi quand tu crées une clé, pour reprendre ton exemple, la clé peut-elle être plus "sûre" avec du bon aléa? Y a-t-il une notion de qualité d'une clé, deux clés de la même taille peuvent-elles avoir intrinsèquement une sécurité différente?

Sinon oui, comme le commentaire au dessus, je suis curieux de connaître l'utilité générale d'une telle carte, car je n'ai jamais eu affaire à quiconque qui en avait une. Comment ça s'utilise, etc.

En tous cas, ton outil a quand même l'air extra et améliore grandement l'utilité existante de ces cartes en les rendant utile génériquement (transparent pour toute application qui utilise /dev/(u?)random et qui utilisera donc la carte indirectement sans le savoir). C'est génial. Si ce n'est déjà fait, tu devrais t'associer avec un projet plus gros, probablement GNUPG, et leur soumettre ton utilitaire pour que cela soit installé par défaut chez toute autre personne qui aurait une telle carte.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

j'ai déjà eu une réflexion similaire: il serait relativement facile d'automatiser la recherche de fonctionnalités disponibles dans des clients. Des batteries de tests par XEP seraient intéressantes aussi, mais un peu plus compliquées à mettre en place. Malheureusement c'est un gros boulot que personne n'a le temps de faire. Ça serait bien dans le rôle de la XSF de faire ça, mais je pense qu'ils ont d'autres chats à fouetter.

Et c'est bien dommage. Je trouve qu'il y a un gros gâchis de compétences à la XSF. J'y ai été membre quelques années, j'ai vraiment cru à XMPP. Note que j'aime toujours XMPP et que j'aimerais toujours que cela remplace les réseaux proprios, mais désormais j'y consacre moins de temps et suis passé d'acteur à spectateur. On verra. Comme tu dis, je pense qu'ils ont raté non pas un seul virage, mais une succession de virages les uns après les autres. Il faut voir si la communauté est capable de revenir dans la course. Des fois je pense que je reviendrai peut-être dans le cercle des gens qui poussent ce proto, et à développer dessus, mais je sais pas. J'aimerais bien. Qui vivra verra. :-)

Quand j'étais à la XSF, je voulais participer et faire des choses (je dis pas ça en l'air, d'ailleurs mon nom est dans la section "Acknowledgements" ("Remerciements") des RFC 6120 et 6121 pour justifier que quand je dis que je veux contribuer, je contribue). Mais je n'avais pas le temps ni l'envie non plus de le faire à temps plein (j'avais mes propres projets, certains en rapport avec XMPP d'ailleurs, mais je voulais aussi participer à l'effort de la fondation: code/scripts, doc, promotion, ce qu'on pouvait avoir à faire selon les projets du moment!). Nombreux peuvent se permettre le temps plein, car c'est leur emploi. Que ce soit Peter Saint André ou d'autres, ils sont payés pour cela (en plus d'aimer!). Moi j'aimais et je voulais aussi participer, mais en amateur, en contributeur régulier. C'était un choix. Au final, rien ne se passait jamais. Notre seule activité de membre était de voter 4 fois par ans pour les nouveaux membres. Régulièrement j'envoyais des emails pour proposer de l'aide pour ceci ou cela, mais rien ne se passait non plus. Je ne voulais pas être leader. Comme je disais, je ne voulais pas bosser dessus à temps plein. Je voulais "contribuer". Je voulais un projet organisé où je puisse "patcher", non pas "maintenir". Mais non, vraiment rien. D'ailleurs je proposais même des participations plus grosses de temps en temps. J'avais par exemple fait un plugin wordpress pour s'identifier sans mot de passe, de manière très sécurisé (basé sur la XEP-0070). Je trouvais que c'était un super cas d'utilisation de XMPP en dehors du chat, et que la XSF pouvait l'utiliser pour promouvoir le concept. D'ailleurs y avait aussi une partie visible par les utilisateurs puisqu'on pouvait aussi commenter sur le site en s'authentifiant par son compte IM. C'était donc un super moyen de lutter aussi contre le spam tout en promouvant le protocole! Mon code marchait du tonnerre, je leur proposais de l'intégrer et de le maintenir; et même s'il avait fallu, je leur ai dit que je pouvais donner mon copyright sur ce code à la fondation. Je n'ai jamais eu de refus (ce qui aurait été ok! J'accepte un refus clair), mais pas non plus d'engouement. Au final, comme tout à la XSF, ça finissait en eau de boudin, sans vraiment de fin claire.

Au final je me suis lassé. J'ai eu l'impression qu'être membre de la XSF n'avait aucun sens puisqu'ils ne nous utilisaient pas à notre plein potentiel (c'est peu dire!).

Les batteries de test dont tu parles, je ne sais pas ce qu'il en est de nos jours, car je ne suis plus les activités de la XSF, mais cela fut en projet à un moment. Je me rappelle que Bear, un contributeur important de la XSF, avait lancé le projet, annoncé qu'il avait commencé à le coder en python, et fait un appel à contributeurs. J'avais été un des premiers à répondre, et à demander où était le code. Bear m'a répondu qu'un dépôt de source allait être créé. J'attends toujours. C'était en 2011. La page wiki ne montre aucun historique depuis. J'attends.

Au final, il y a beaucoup de gâchis de potentiel. La XSF a énormément de membres qui n'attendent que ça: aider. Ils veulent des petites tâches, et ils se proposent sans cesse pour cela. Mais ils ne veulent pas faire du leadership. Ça tombe bien, y en a aussi d'autres à la XSF qui adorent cela. C'est comme cela que ça se passe habituellement dans les projets Libres: certains veulent juste envoyer des patchs; d'autres veulent organiser, faire de la revue, décider; d'autres encore veulent faire de l'infra, monter des serveurs, etc.. Et c'est très bien comme ça! À la XSF, en tous cas à l'époque, le problème était que les leaders ne savaient pas utiliser leur communauté. Ceux qui voulaient participer aux projets. C'est dommage, tout le monde sait que les petits contributeurs sont extrêmement importants dans le Libre.

Donc voilà. Tout ça pour dire que c'est bien dommage. J'aimerais bien que la XSF fouette ce chat là (violence animale!), comme pleins d'autres, et je vous assure qu'ils auraient les ressources humaines pour le faire s'ils s'organisaient pour gérer les contributeurs, qui n'attendent que ça.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

A priori, l'article dit qu'ils ont modifié GNU radio pour communiquer avec la sonde (je sais pas si ça a été remonté upstream, une courte recherche ne me donne pas trop d'info dessus. Peut-être aussi que c'était des changements trop spécifiques à cette sonde qui poseraient problème pour les usages plus courants). Si cela avait été un logiciel proprio, ils n'auraient pas eu accès aux sources vraisemblablement, donc ils n'auraient pas pu modifier. Même s'ils avaient eu accès aux sources, ils n'auraient probablement pas eu le droit de les modifier, même pour leur utilisation personnelle. Ou alors c'eût été par un système de plugin qui permettrait de spécifier le protocole de la sonde, et donc limité en fonctionnalité. Et puis il aurait fallu voir le tarif éventuel de ce logiciel propriétaire (la radio n'étant pas quelque chose de commun, donc dit "logiciel métier", quelque chose me dit que des logiciels proprios de radio, ça doit coûter bonbon). Je dis pas que c'est impossible, mais cela fait beaucoup de "si" et de barrières potentielles, éventuellement dangereux juridiquement.

En choisissant un logiciel Libre, ils se sont tout de même vraiment simplifié la tâche.

Quant à réécrire tout un logiciel de radio à partir de rien, c'est possible aussi bien sûr, mais il faut bien voir que c'est pas la NASA justement. Il s'agit d'un groupe d'amateur, qui y ont sûrement passé beaucoup de temps, mais en auraient passé 100 fois plus s'il fallait tout refaire (et donc probablement n'auraient pas fait).

C'est ainsi que je vois les choses. Certes tout le monde peut théoriquement tout faire. On n'a pas besoin de logiciels Libres pour faire quelque chose. Mais dans la pratique, on ne peut pas tout faire. Déjà par manque de temps, puis d'argent, ensuite par connaissance, etc. Or le Logiciel Libre a permis a donner aux mondes accès à des activités qui avaient été jusque là impossible pour des particuliers, des petits groupes de personnes, associations, petites entreprises, etc. Par exemple contrôler des sondes dans l'espace! Tu penses vraiment que sans GNU radio, ce groupe d'amateur (en regardant sur le site, il s'agit apparemment d'un organisme non-lucratif sur l'éducation en exploration spatiale, qu'ils ont créé cette année à l'occasion de ce premier projet) aurait monté ce projet? Pas complètement impossible, mais beaucoup moins probable.

Donc je reviens sur ce que j'ai dit plus haut: on n'a pas fondamentalement besoin de Logiciels Libres pour survivre, mais c'est quand même une grande avancée pour l'humain en matière de partage, d'accès aux connaissances, d'auto-enseignement, etc. Et donc au final, je trouve que la FSF a bien raison de présenter cet article ainsi. Car si ce projet est un très bel exemple de ce qu'il est possible de faire de nos jours avec les LL, notamment sans être riche, un organisme gouvernemental ou une multi-nationale.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Ben de manière général, c'est le Libre qui est pas encore un grand succès. Pour ça que les utilisateurs d'OS libres tournent autour des 2% (moins ou plus selon les stats). Donc quel que soit le pays, c'est normal de pas avoir l'impression d'un esprit "ouvert en informatique", si par "ouvert", on entend "quelqu'un pour qui les licences FLOSS importe, ou les formats importent, etc.". La vérité est que la plupart des gens s'en foutent, et ce quelque soit le pays.

Ensuite la France est pas si mal. J'arrive pas à avoir de statistiques sur les contributeurs libristes par pays (en même temps, c'est dur à faire, je pense que la plupart des contributeurs ne disent pas leur pays. Je sais que personnellement, je ne me sens pas défini par ma nationalité. Ceci dit, des sites comme Ohloh doivent avoir les données pour faire des stats pas trop loin de la réalité), mais mon ressenti général est qu'y a quand même pas mal de français dans les contributeurs de pas mal de projets majeurs.

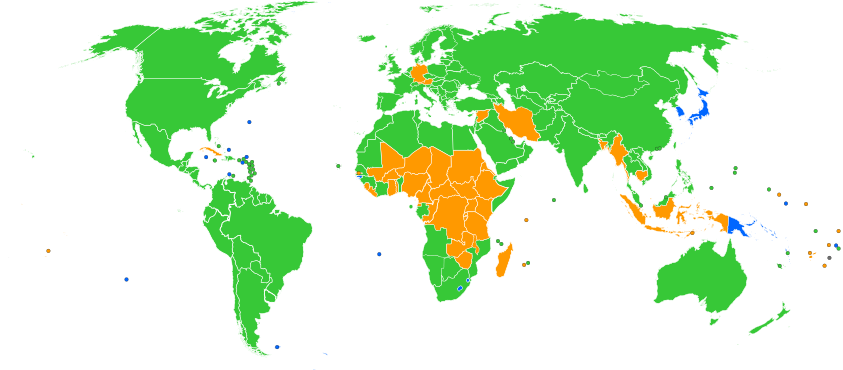

De manière générale, l'Europe est vraiment pas mal. On a pas de quoi avoir honte. L'US est pas trop mal non plus, notamment par leur culture forte de start-up, je pense. L'Extrême Orient maintenant est à l'heure actuelle un gros trou-noir du Libre. Le Libre là-bas est anecdotique, si ce n'est quasi inexistant (attention, je dis pas que ça existe pas! On rencontre, rarement mais ça arrive, quelques contributeurs sur la toile, et j'ai même visité Mozilla Japan. Donc je sais qu'ils ont une présence. Simplement elle me paraît bien moindre comparé à la France par ex). Tiens cette carte du navigateur web le plus utilisé par Pays (source Wikipedia - CC BY-SA 3.0 - Roke, Altes, and Peeperman) est assez explicite:

En bleu, IE, vert Chrome et Orange Firefox.

Bon bah on voit que l'Europe et l'US, c'est globalement Chrome, avec Firefox qui domine anecdotiquement dans quelques pays. L'Afrique et les îles du Pacifique, beaucoup de Firefox, mais je me demande si cela n'a pas à voir avec la forte présence d'aides et accompagnements humanitaires là-bas (dont notamment des assoces qui veulent apporter l'informatique en promouvant des solutions Libres). Puis y a soudain ce gros pavé bleu qui comprend Chine, Corée et Japon (+ quelques autres pays, mais je garde le focus sur l'Extrême-Orient). Cette petite partie du monde qui n'a pas abandonné IE, qui s'accroche encore à un univers purement propriétaire (et Windows uniquement).

Alors c'est bien, y a des annonces, y a des projets (la Chine avait aussi des projets d'OS basé sur Linux si je me souviens, et y a de plus en plus de startup là-bas aussi), mais le chantier est vaste et loin d'être terminé.

En France aussi, le chantier est vaste, mais on l'a commencé plus tôt, je pense. C'est la différence. Et on est peut-être pas les meilleurs, mais c'est pas grave: c'est pas une compétition. ;-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

J'ai vécu en Corée pendant un an, il y a très peu. Je réagissais donc à maclag qui voyait la Corée comme "future championne du Libre", pour relativiser un peu ses dires.

De son côté, la France est plutôt bonne élève pour le Libre et les formats ouverts (malgré quelques couacs tout de même de temps en temps), comme tu le fais très bien remarquer Kerro. C'est justement ce que je disais. :-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

C'est une bonne nouvelle, mais ça reste qu'une annonce. On a aussi pas mal d'annonces officielles en faveur du Libre ou des formats ouverts en France, par divers organismes publics. Et même si ça avance globalement dans le bon sens, on voit que cela reste lent, avec parfois des à-coups en arrière (contrats avec Microsoft sans appels d'offres, etc.).

Donc pour la Corée, c'est plutôt bien, mais ça reste un sacré chantier. Quasi aucune banque ne permet la banque en ligne avec autre chose que Windows; et même sous Windows, ça oblige à utiliser IE, aucun autre navigateur, faut télécharger un plugin opaque avec autorisation de s'exécuter sur l'ordi (ce que je trouve vraiment contraire à tout bon principe de sécurité, mais pas le choix: c'est ça ou pas de gestion de ses comptes en ligne).

Et de manière générale, c'est vrai pour énormément de sites, notamment la plupart des trucs officiels, ou les universités (télécharger des attestations de diplôme, etc.), etc. L'autre jour par exemple, mon amie coréenne voulait regarder une chaîne de télé en streaming. Elle a dû lancer Windows en VM car elle est sous Linux (et que pareil, il fallait obligatoirement IE, ça télécharge un truc à accepter, etc.).

Donc je dis: c'est cool et oui, ça va dans le bon sens. Mais la situation est si terrible là-bas du côté du Libre que de toutes façons, c'est dur d'aller dans l'autre sens (car on est à l'extrême déjà). C'est loiiin d'être le paradis du Libre et la Corée est loin d'être championne du Libre pour au moins quelques années. C'est vrai de manière générale pour le Japon aussi d'ailleurs. Pareils, ils sont retardés du Libre, et trouver des libristes par chance là-bas tient du miracle.

Maintenant reste à voir si l'effet d'annonce est suivi d'actes, mais faut pas s'attendre à ce que ça arrive d'un seul coup (faut déjà qu'ils refassent tous les sites web!).

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Cible ?

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Lancement de la campagne de financement de la caméra libre AXIOM Beta 4K. Évalué à 3.

Ben écoute, y a pas si longtemps, je suis sûr que plein de gens se demandaient l'utilité du téléphone portable pour le grand public (hors professionnels). La technologie avance, et le grand public aussi aime l'idée de pouvoir y accéder, plutôt que cela soit réservé à une "élite" professionnel qui revendique son irremplaçabilité par du matériel hors de prix.

Donc oui, maintenant on fait de la super méga définition au ciné. Alors pourquoi des amateurs n'auraient pas envie, ni le droit, de pouvoir y accéder aussi (en "actif", avec création perso, et plus juste en "passif", devant sa télé)?

C'est bien ça aussi l'OpenHardware: donner accès aux gens à la connaissance et à l'action pour des choses qui étaient réservés aux "pros" jusque là (de même que le FLOSS a fait la même chose pour le logiciel).

Ensuite ça dépend des passions et intérêts. Certains aiment les véhicules et vont dépenser plus d'argent dedans, pourquoi d'autres ne pourraient aimer faire des films?

Aussi je fais clairement la différence entre professionel/amateur et qualité. Dans tous les domaines, je connais des professionnels (= des gars dont "c"'est le métier) totalement incompétent et des amateurs d'un niveau à faire pâlir nombre des dits professionnels. Une fois cela mis en place, je soutiens donc qu'il n'y a pas de raison à ce que les amateurs n'aient pas accès à du matériel de qualité si c'est techniquement/financièrement possible.

Alors pour les amateurs de l'espace, il est clair qu'ils n'auront pas accès à une navette spatiale de sitôt (cas du "pas financièrement possible"), comme ceux amateurs de l'énergie ne pourront s'amuser à faire leur mini-centrale nucléaire à la maison (cas "pas techniquement, voire légalement, possible"). Par contre, franchement avec la technologie d'aujourd'hui, limiter le matos vidéo de qualité aux pros par des prix exorbitants, c'est une limitation artificielle maintenue par des intérêts financiers. Les pros pourront toujours avoir plus de toutes façons: quand tu loues une caméra dans le cinéma, ce qui coûte cher, c'est pas seulement la caméra, c'est aussi les garanties, le service (la caméra tombe en panne, t'en reçois un remplacement dans les 2/3 heures). Le particulier doit faire bien plus gaffe à son matos, doit se débrouiller seul en cas de problème, doit bidouiller, etc. Dans toute technologie, ce qui coûte le plus cher, c'est l'humain (service, support), pas le matos, et c'est très bien (je trouve en effet que le temps qu'un être humain va partager pour régler le problème d'autrui a beaucoup plus de valeur qu'un bout de métal/plastique).

Donc quel est le "besoin"? Y en a pas. Comme y a pas non plus de "besoin" chez les pros (des pros peuvent faire sans 4K aussi. C'est même un concept chez certains. J'ai vu des films pros tournés entièrement sur des téléphones, et c'était le concept du film). Par contre "envie", oui, il peut ou non y en avoir. Et dans ce cas là, si c'est techniquement possible de donner accès au plus grand monde par l'OpenHardware, je dis: ben c'est cool.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Je suis tout fou-fou à l'idée que ça marche! :)

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Lancement de la campagne de financement de la caméra libre AXIOM Beta 4K. Évalué à 3.

Oui mais uniquement car ils n'ont que cela. Je peux te dire que sur la liste de développement du projet, à chaque fois qu'un développeur se présentait, on lui sautait dessus pour l'accueillir. Mais à ma connaissance aucun n'a réellement fait de contribution approfondie. Par contre y a plus de mecs dans le hardware qui sont arrivés et qui ont effectivement livré quelque chose. Alors bien sûr, les mecs du hardware, ils peuvent aussi développer. Mais bon avoir aussi d'autres gens plus spécialisés en software serait pas un mal.

Ensuite clairement le hardware est la priorité pour le moment, donc c'est pas le pire des cas. Mais je peux te dire que vu de l'intérieur, ne pas avoir plus avancé aussi au niveau software, en parallèle, c'était pas un choix.

Comme dit plus bas, c'est Alpha qui est opérationnelle. Beta sera le résultat du financement.

Sinon la cible de Beta, côté vidéaste, c'est seulement une partie d'entre eux, ceux qui ont pas peur du côté technique et de devoir un peu plus bidouiller que la moyenne. Pour les vidéastes de manière général (ceux qui veulent pas trop se poser de question également), ce sera plutôt Gamma.

Par contre oui les développeurs, ingénieurs, techniciens, scientifiques et cinéastes bidouilleurs sont plus la cible directe de Beta. Ensuite faut pas croire, les cinéastes qui veulent pas de caméra trop expérimentale, mais ont des sous et sont prêts à faire avancer le schmilblick pour arriver plus tard à Gamma qu'ils pourront alors acquérir sont aussi invités à financer le projet!

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: conception modulaire… photographie ?

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Lancement de la campagne de financement de la caméra libre AXIOM Beta 4K. Évalué à 2.

Ça c'est ce qu'ils ont fait avec l'AXIOM Alpha (prototype actuel). L'AXIOM Beta (le résultat du financement) sera le Truesense KAC12040 de base, mais ils prévoient de proposer des options pour d'autres capteurs (lire AXIOM Beta). Cependant cela dépendra du succès du financement (des "stretch goals").

En fait ça dépendra donc beaucoup de ce que les gens sont prêts à mettre pour passer un cran dans la qualité d'image.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Cible ?

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Lancement de la campagne de financement de la caméra libre AXIOM Beta 4K. Évalué à 4.

D'après moi clairement. Dans le milieu du cinéma, ils mettent vraiment des sommes faramineuses. Alors dans le milieu amateur ou semi-professionnel, ils n'ont pas les mêmes fonds, mais ils sont tout de même habitué à mettre plus que le particulier dans leur matériel vidéo et audio.

Ensuite le financement parviendra-t-il à son but? L'avenir nous le dira mais même un échec ne pourra être interprété comme un échec plus générique de l'open-hardware dans le cinéma. Plein d'autres raisons peuvent expliquer cela. De toutes façons, perso j'y crois.

Bah les gens sont prêts à changer de matos s'il le faut. Et puis c'est pas comme si y a pas des nouveaux tous les ans (comme dans tous les métiers: les jeunes sont les futurs vieux!). C'est absurde de supposer que tous les cinéastes ont déjà leur matos pour les prochaines années. Dans ce cas là, y aurait pas qu'Apertus dans la merde. Le marché des caméras de cinéma serait verrouillé et plein de boites couleraient! uhuh

Ben ça reste raisonnable pour beaucoup de gens au contraire. Une location de caméra pour un film ciné à petit budget est déjà plusieurs fois ce prix là.

Euh non c'est l'inverse. Alpha, c'est fait, c'est maintenant. C'est le prototype qui est présenté maintenant tout de suite, les premiers tests, les premiers essais. Puis on s'est rendu compte des erreurs de conception, de jeunesse, le fait que ce premier prototype est trop cher et compliqué à dupliquer, que plusieurs des choix et designs électroniques n'étaient pas idéaux, etc. Beta sera donc le résultat suite au financement collaboratif, bénéficiaire de ce qu'on apprend de nos erreurs, et sera ce que les "financeurs" recevront à la fin.

Plus tard y aura gamma, qui devrait être un modèle plus "prêt à l'emploi". Et j'imagine que si ça continue comme ça, un jour il pourrait y avoir delta, etc. ;-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: hcl + client

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal h-node.org : GNU/Linux matériel compatible, base de données. Évalué à 6.

C'est bizarre, la page dit "Laptops are currently unsupported". Quelle est la différence entre un ordi portable et de bureau? C'est la même chose fondamentalement. C'est la première fois que je vois un programme faire une telle différence, et je me demande si le programme refusera de marcher si je le lance depuis un portable, ou bien si le site refusera mes rapports de compatibilité s'il détecte que je les ai envoyé depuis un portable…

Sinon la seconde chose qui me chagrine est que pour rapporter du matériel, il est écrit qu'on doit utiliser une des distribs appuyées par la FSF (c'est à dire pas grand chose d'utilisé, ça fait vraiment un micro pourcentage des utilisateurs), ou une Debian avec seulement le dépôt "main" activé (là y en a plus, mais ce choix est arbitraire).

Encore une fois, je me demande ce qu'il se passe si on envoie un rapport de matos fait depuis une autre distrib. Sera-t-elle refusée? Non parce que cela rend le site beaucoup moins utile si quelques pourcents des utilisateurs GNU/Linux seulement peuvent rapporter.

Bien sûr, je comprends tout à fait qu'ils limitent leur site aux matos qui ne marchent qu'avec du Libre, tout comme je comprends qu'ils appuient particulièrement les distribs qui prennent le parti de ne rien accepter de non-Libre. C'est la FSF, c'est leur rôle. Par contre tout le monde aurait à y gagner si tout le monde pouvait faire des rapports de matos. Y a des moyens de savoir si un matériel donné utilise des drivers/firmware non-Libre.

Sans compter que ça veut rien dire si les dépôts non-Libres d'une Debian sont pas activés au moment du test: il suffit qu'ils aient été activés à un moment pour avoir installé des drivers proprios à ce moment là. De même qu'il est possible aussi de désactiver les dépôts non-Libre sur toute (ou presque, je sais pas si y a des distribs qui ne séparent pas le non-Libre dans un dépôt à part, mais ce serait l'exception) distrib GNU. Sur le coup, ils mettent uniquement Debian à part parce que c'est une collaboration entre FSF et eux. Mais c'est loin d'être une différenciation justifiée.

D'ailleurs même les distribs 100% Libres, les utilisateurs ont pu installer "à la main" des drivers non-Libres à un moment.

Enfin voilà, ce serait bien plus logique de faire une détection automatique du driver utilisé pour un composant particulier, de l'envoyer avec le rapport, et là les utilisateurs qui savent peuvent flagger le driver comme Libre ou non (et ne pas afficher sur le site tout rapport avec un driver non-Libre). Y aurait donc une table dans la base pour les drivers qui dise s'il est Libre ou non et s'il utilise un blob binaire ou non. L'utilisateur n'aura donc pas à se poser de question et pourra envoyer son rapport, qui sera automatiquement ajouté si on sait que le driver associé est Libre, ou refusé avec message explicatif dans le cas contraire. Si c'est un driver inconnu, le rapport peut rester en attente d'autres membres de la communauté à même de dire si c'est un driver Libre ou pas.

D'ailleurs je suis à peu près sûr que leur client envoie déjà automatiquement le driver utilisé au serveur (en tous cas, je vois qu'ils listent les drivers par périphérique sur le site), y a plus qu'à (comme on dit) implémenter le système de validation sur le site. Deuxième chose serait de s'assurer qu'ils l'acceptent et qu'ils soient pas trop arrêté sur leur décision de privilégier certaines distribs.

Je jetterai un œil plus tard, y a peut-être un patch à faire et à leur envoyer. :-)

Mais comme je dis toujours, si quelqu'un aime l'idée et veut proposer avant moi, faites vous plaisir! J'ai pas exclusivité sur les idées et je serais pas contre utiliser mon temps autrement.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Je suis tout fou-fou à l'idée que ça marche! :)

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Lancement de la campagne de financement de la caméra libre AXIOM Beta 4K. Évalué à 6.

Salut,

Pour répondre au message originel: c'est bien leur but de coupler ce projet avec un projet de montage. En fait ils sont très ouverts sur "comment", ils veulent juste un bon logiciel. Cela pourrait être un logiciel existant qu'ils pourraient améliorer pour le rendre pro et compatible à leurs exigences; cela pourrait être faire un logiciel eux-même qui répondra parfaitement au cahier des charges (oui je sais, c'est trop gros, mais en même temps, ils font aussi une caméra à partir de zéro, ça aussi c'est gros!); cela pourrait se mettre en collaboration avec un projet existant pour travailler main dans la main (y a eu un tel rapprochement avec une société qui faisait un logiciel de montage OpenSource dont j'avais jamais entendu parler. Mais ça n'est jamais allé plus loin que la discussion, sauf si j'ai loupé qqch).

Dans tous les cas, il manque une chose dans leur projet: des développeurs. C'est marrant mais de notre côté dév, on a toujours l'impression qu'on n'a que des développeurs et qu'il manque tous les autres. Ben de leur côté, ils ont réussi à chopper plein de mecs super compétents en électronique, qui ont même déjà participé à des élaborations de caméras du marché pour certains, mais les dévs? Que dalle. Oh y a eu pas mal de mecs qui se sont proposés (dont moi), mais au final sans vrai résultat (j'ai d'autres priorités malheureusement dans l'immédiat). C'est donc assez drôle et même socialement intéressant de constater que le problème n'est pas qu'il manque de mecs pour le hardware, mais c'est juste qu'on n'arrive pas à se mettre ensemble plus.

Enfin oui, tout ça pour dire: c'est l'idée, mais ils n'attendent que les dévs. Qu'attendez-vous?! :-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

# Fête de lancement IRC

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Lancement de la campagne de financement de la caméra libre AXIOM Beta 4K. Évalué à 2.

Salut,

Pourrait-on rajouter cette info dans la dépêche. Voici l'email envoyé sur la mailing liste communautaire:

En gros, une heure avant la fin du décompte, ils proposent à toute la communauté de se rendre sur IRC pour discuter, et ils partageront quelques "trésors" de l'histoire du développement d'AXIOM.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Je suis tout fou-fou à l'idée que ça marche! :)

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Lancement de la campagne de financement de la caméra libre AXIOM Beta 4K. Évalué à 6.

Je suis assez d'accord. Pour moi cinelerra, cela fait longtemps que je ne le considère même plus dans mes comparaisons et tests de logiciels de montage vidéo.

Les dernières fois où j'ai essayé de l'utiliser, il y a peut-être 2/3 années de cela, il était tout simplement instable. Il crashait toutes les 10 secs pour un oui ou un non. Donc franchement j'ai laissé tomber avant même de savoir si le logiciel "pourrait" être bien ou non, s'il ne se crashait pas constamment.

Les fois où j'ai essayé de le compiler, à peu près à la même période, soit 2/3 ans auparavant aussi (donc peut-être qu'à l'époque je m'y connaissais moins aussi), c'était la croix et la bannière.

Il n'est même plus dispo de base dans pas mal de distributions. Déjà parce qu'il dépend fondamentalement de la libfaac qui a des problèmes de brevets (or si certains logiciels ont une dépendance optionnelle, cinelerra apparemment ne peut pas faire grand chose sans libfaac). Donc les distribs qui n'ont pas de dépôts teintés ne proposent pas cinelerra (par exemple: mageia). D'ailleurs je viens de vérifier, même si ma Linux Mint propose libfaac, elle, ben y a pas de cinelerra pour autant dans les dépôts. C'est clairement plus un logiciel prioritaire pour personne.

Enfin regarde le résumé des commits du projet communautaire sur les dernières années sur ce site: https://www.openhub.net/p/cinelerra/commits/summary

Y a eu quasi absence de commits entre 2007 et 2014! C'était donc un projet mort. Je remarque d'ailleurs que ça reprend seulement depuis avril 2014 (tout frais! Je jetterai un œil de temps en temps pour voir si le projet se relance vraiment ou si c'est juste un soubresaut. Si ça continue à un tel rythme de dizaines de commits par mois pendant des années, ça peut revenir dans la danse).

Bon apparemment cinelerra est aussi développé par une société, Heroine Virtual LTD, mais bon la page de download indique tout de même « Downloads have no support or warranty and are not community approved. Linux derivatives are so incompatible, don't be surprised if the source code requires some tweeks and the binary doesn't work. » ce qui donne pas confiance dans leur qualité de développement (chez moi avec les bons outils, y a pas d'incompatibilités extraordinaires entre les diverses distrib GNU/Linux. Qu'on dise "attention testé seulement sur…" ok, mais là c'est bizarre comme tournure). Mais bon on peut s'attendre dans ce cas à ce que le logiciel s'améliore?.. À voir… Dans tous les cas, le problème de manque d'ouverture et d'absence de dépôt de source accessible au public rend ce développement plus hasardeux (ils font juste des sorties).

Et on peut clairement lire que ce n'est plus la priorité de cette boîte. Ils l'ont présenté à quelques "shows" entre 2000 et 2004, puis plus rien, d'après leur site. Je parle même pas du copyright de bas-de-page: «(C) 2013 Unemployed, flat broke Programmers»

Je constate aussi qu'il y a deux site web pour la version communautaire: le site originel cinelerra.org, qu'ils ont et un nouveau site web: http://cinelerra-cv.org/

Apparemment cinelerra.org n'a pas été renouvelé et quelqu'un s'en est emparé. Mais de façon amusante, ça parle toujours de Cinelerra, mais seulement de la version pro, j'ai l'impression (est-ce la société Heroine Virtual qui a racheté? Le whois ne dit pas). Et il n'y a rien pour télécharger (par contre, on nous demande notre email pour un "download update").

Enfin bon, tout ça m'a l'air bien compliqué. Peut-être cinelerra mérite-t-il de nouveaux tests? Mais j'espère vraiment qu'ils ont amélioré la stabilité car c'est vraiment là où ça pêchait.

Tout ça pour dire que cela ne m'étonne pas qu'on ne considère plus cinelerra dans la course. Blender aussi à l'époque les gens disaient qu'ils avaient un UI dur à prendre en main, etc. Ben ils ont bossé comme des dingues pour s'imposer (et changer ce qu'il fallait) et ils sont loin de cette époque maintenant. Cinelerra aurait pu faire la même chose, mais j'ai l'impression que cela fait longtemps qu'ils se sont laissé aller.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Lien ?

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Lancement de la campagne de financement de la caméra libre AXIOM Beta 4K. Évalué à 4.

Clairement oui, le lien est manquant. C'est un peu inutile sans lien. Lien vers le site du projet avec décompte: https://www.apertus.org/

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Les liens qui surprennent

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Journée du logiciel libre 2014 : des activités gratuites à Québec. Évalué à 2.

Ok.

Je serais personnellement pour prévenir l'association LinuQ, et retirer le lien de linuxfr (éventuellement temporairement le temps qu'ils trouvent le problème) avec un petit message expliquant pourquoi. Je doute qu'un lien en première page de linuxfr qui redirige sur un site de cul soit vraiment idéal.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Les liens qui surprennent

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Journée du logiciel libre 2014 : des activités gratuites à Québec. Évalué à 2.

Uh! J'ai eu exactement la même page que toi à l'instant (sauf que la mienne, y avait pas de culotte)! Mais si je réessaie immédiatement après, ça me donne dorénavant la bonne page. Y a un problème quelque part là, le système de redirection de linuxfr n'aurait-il pas été corrompu et redirigerait de temps en temps vers ce site? Ou alors c'est le site du lien lui-même qui aurait ce problème. Mais dans les deux cas, je doute que ce soit normal.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Pourquoi ne pas prendre une "rolling release" comme ArchLinux

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal OpenMandriva Lx 2014, sortie presque inaperçu…. Évalué à 2.

Ah ok. On entends tout de même pas mal d'histoires terribles sur les problèmes rencontrés en utilisant Debian testing. C'est pour cela que je faisais cette distinction.

Je me demande d'ailleurs à quel point on peut tester un build en une seule semaine. Dans Gentoo, je sais pas combien de temps les paquets restaient "unstable", mais cela pouvait durer longtemps, surtout pour les petites applications pas très utilisées (qui parfois restent même indéfiniment "unstable" si le peu d'utilisateurs fait que personne ne remonte rien). Évidemment les gros logiciels connus eux passent stable bien plus rapidement (mais en combien de temps? Une semaine me paraît tout de même un chouille court, non? Quoique si c'est Firefox, les retours doivent être par dizaines au bout de quelques jours…).

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Pour ma gueule, et je partage ensuite