L'association LILA (Libre comme L'Art) est sur un .info: libreart.info.

Nous promouvons l'Art Libre, c'est à dire les logiciels Libres créatifs (Blender, GIMP, Inkscape, Scribus, Krita, MyPaint, etc.), les licences Libres, et de manière générale la liberté et tout activité créative bénéfique. N'hésite pas à jeter un œil sur notre site: http://libreart.info/fr/

On a expliqué notre gros projet en cours sur linuxfr: http://linuxfr.org/users/jehan/journaux/presentation-du-projet-film-d-animation-zemarmot-et-appel-a-musiciens

On a aussi d'autres projets dans la besace, mais comme on n'est pas nombreux pour le moment, c'est pas facile de tout mettre en avant! D'ailleurs n'hésitez pas, si quelqu'un a des projets qui rentrent dans le contexte et veut les faire sous notre bannière, nous en serions ravis. Devenez membre, on est ouvert! :-)

Enfin voilà, donc si ton .info gratuit marche aussi pour un renouvellement (en changeant de registrar puisqu'on n'est pas chez Gandi), on est preneur.

Si c'est seulement pour une création malheureusement, on laissera à d'autres. On ne prévoit pas de multiplier les domaines. :-)

Et pis je pense qu'on rentre bien dans tes critères "un projet sympa, culturel, ou en rapport la liberté, et/ou le logiciel libre", non? :-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

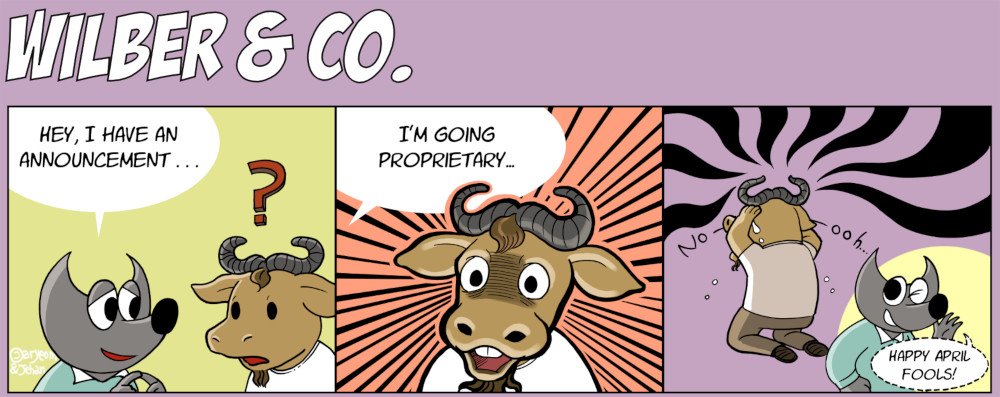

Ahahahah! En effet! Mais pour être tout à fait honnête, j'espère que ça ne va pas rester une blague trop longtemps. Donc je voudrais pas faire de cette blague une réalité en la dessinant! :p

Je pense qu'il faut commencer à stabiliser les fonctionnalités et à arrêter d'en accepter de nouvelles très bientôt. Je crois que je vais proposer cela lors de LGM en fin de mois, tiens.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Quand tu parles de film, tu parles d'un long métrage (genre plus de 1h) ?

Mon début de script actuel tient plutôt du moyen métrage. Je mise sur 45 min.

Maintenant c'est plus un "but", un idéal, et je reste réaliste, je pense que les chances sont faibles de lever suffisamment (mais sait-on jamais! Je fais tout ce qui dans mes faibles compétences marketing pour essayer tout de même et je touche du bois). Si on arrive à lever juste 10 000 EUR par exemple, faut pas s'attendre à 45 min. Ce sera plus de l'ordre de quelques minutes. À ce moment, on transformera peut-être le projet en une mini anecdote de quelques minutes, qui pourrait donner lieu à une mini série (dans ce cas, avec une suite de petits financements?).

L'idée, c'est d'arriver à payer des gens. Or on sait tous combien coûte un mois de salaire en gros (même sans grande ambition).

Sur votre site je n'ai pas vu la composition de l'équipe

Oui pour l'instant le site du film est plus "en construction" qu'autre chose. Faut que je prenne le temps et mes journées sont pas assez longues! :P

en plus de toi et d'Ahryeom, combien êtes-vous pour faire l'animation ?

Ce projet est d'abord personnel. Donc à l'heure actuelle, l'équipe, c'est juste cela. Pour l'instant, personne n'est rémunéré (pas même nous, on fait ça en puisant sur nos moyens), et on met les choses en place pour un financement pour justement espérer recruter et rémunérer des gens. On essaie déjà de voir à droite, à gauche les gens intéressants, et on a lié quelques contacts, mais on ne demande à personne de bosser gratos sur le projet. Bon si quelqu'un souhaitait intégrer et nous aider dès maintenant avec des compétences d'animation et de dessin, en acceptant de ne pas être rémunéré en espérant que le financement soit un succès, on dirait pas non. On est un peu comme un projet de Logiciel Libre. Mais personne ne nous a demandé. Y a je crois beaucoup plus de libristes parmi les développeurs que parmi les animateurs 2D! :-/

C'est aussi un peu l'un des points de notre association de présenter un nouveau mode de pensée parmi les artistes, d'ailleurs (qui pour la plupart ne vont jurer que par Adobe et autres logiciels proprios, ainsi que les modes de distribution classique de film).

Encore une fois, cela dépendra donc principalement du montant que nous arriverons à lever. Dans mon exemple fictif de 10 000 EUR plus haut par exemple, on n'aura pas les moyens de payer un autre animateur, c'est clair.

Ensuite plus on récoltera, plus cela permettra d'avoir un film long, et d'avoir des animateurs.

Lorsque vous mettrez en place la campagne de financement, y aura-t-il ne serait que quelques secondes d'animation (genre mini bande annonce) pour se rendre compte de la qualité de l'animation finale ?

Bien entendu. Sans un aperçu, on n'aurait aucune chance. On est en train de préparer cette "bande annonce" (qui tiendrait plus du "teaser" que de la bande annonce d'ailleurs, mais aucune idée comment traduire ce terme convenablement en français).

Nous présenterons notre teaser lors du Libre Graphics Meeting 2015 à Toronto, au début du mois de mai (notre présentation est prévue le samedi 2 mai pour être précis) et nous prévoyons de démarrer le financement au même moment. C'est le plan. :-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Bien sûr, on est intéressé. Par contre l'un des prérequis pour bosser à distance est — je pense — d'être un minimum sûr de soi et de savoir ce qu'on fait. On a beaucoup d'idées nous même, mais dans un tel projet, il faut aussi clairement que les musiciens soient réactifs et proposent des choses auxquelles on ne pense pas, par exemple, explorent d'autres voies, etc. Je dis juste ça parce que tu m'as eu l'air un peu incertain dans ton message. Ça peut être fatal lors d'une entrevue d'embauche. Quand tu veux te vendre, tu dois te vendre comme le meilleur (ou au moins quelqu'un de bon, si tu veux faire le modeste), pas comme "je ne m'engage pas sur la qualité musicale du résultat". Juste un petit conseil quoi. :P

Enfin bon, envoie moi un email à jehan chez girinstud.io et on pourra parler plus en détail sur "la manière de procéder", et si on décide de bosser ensemble (j'ai reçu pas mal de propositions depuis hier, faut que je prenne le temps de tout écouter!).

Aussi tu me parles de tes contacts, vérifie bien que ces derniers ne soient pas affiliés SACEM, comme j'en parle dans mon journal, car la plupart des musiciens, même amateurs, s'y inscrivent. C'est vraiment pas moi qui fais les règles. J'aurais aucun problème à bosser avec quelqu'un à la SACEM (même si j'approuve pas, je comprends parfaitement la peur de l'inconnu et le besoin de faire comme tout le monde), mais ces derniers ont juste pas le droit. Donc pas la peine de discuter plus avant dans ce cas.

Enfin voilà, contacte moi. Ah et je veux bien écouter quelques enregistrements, si t'as aussi!

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Voilà, tout à fait.

Pour démo, voici le premier lien que je trouve quand je cherche la durée de vie moyenne de l'obturateur de mon appareil photo: http://www.olegkikin.com/shutterlife/canon_eos50d.htm

Basé apparemment sur quelques centaines de rapports utilisateurs, mon Canon EOS 50D tiendrait en moyenne ~ 70 000 clics (= photos, grosso modo) +/-. Or imagine un film d'une heure à 24 images seconde: il me faudrait 86400 photos! Sans compter toutes les photos ratées, les tests, les scènes enlevées éventuelles…

En gros, si tu fais un film de 2h, tu es sûr d'user 2, 3, voire 4 obturateurs!

C'est le problème de travailler avec de l'optique mécanique au lieu d'électronique, car ça s'use par la force des choses (ça s'ouvre, ça se ferme, ça s'ouvre, ça se ferme, etc.).

Note que quand ton obturateur lâche, tu n'es pas obligé de racheter un appareil. Tu peux faire changer l'obturateur (d'après le web, pour mon appareil, ça coûterait dans les 200 € pièces + main d'œuvre, ce qui reste bien moins cher que d'acheter un nouvel appareil de cette qualité, même d'occase). Ça limite l'utilisation de ce type d'appareil pour la stop-motion, ce qui est dommage car ça donne de la très bonne qualité!

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

On est sur Paris. L'assoce a un local dans le 11ème. En cliquant là tu trouveras l'adresse, le tél, etc.. Si tu es sur Paris ou proche, n'hésite pas à passer nous voir (appelle avant ou envoie un email pour être sûr qu'on y est! Ce serait bête d'arriver devant une porte fermée).

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Il n'est probablement pas français, mais ça ne dois pas être un problème du coup.

Non si la personne est capable de bosser en collaboration en ligne, ça n'est pas un problème.

Ensuite il est clair que pouvoir rencontrer les artistes et bosser proche pour discuter et faire du détail, ça aide et c'est plus sympa. Mais si jamais on a un coup de cœur pour un artiste, ou simplement qu'on trouve quelqu'un très bien mais à l'autre bout du monde, on fait avec. :-)

Et puis des fois, on n'a juste pas le choix!

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Nous aimons beaucoup la stopmotion également! On vient d'ailleurs d'aller voir "Shaun le Mouton", il y a une semaine, c'était vraiment cool et toujours aussi impressionnant techniquement.

À vrai dire, c'est quasi certain que — si notre premier financement de projet est un succès — notre projet de film d'animation suivant sera un film en stopmotion (notre premier projet a failli en être un d'ailleurs, nous avons hésité entre plusieurs propositions). Le logiciel candidat idéal pour faire de la stopmotion sur Linux est Entangle, sur lequel j'ai d'ailleurs contribué plusieurs patchs déjà. Entangle n'est pas fait initialement pour la stopmotion, mais est un logiciel de prise de vue photographique (tu branches ta caméra DSLR en USB, tu la mets sur un pied et tu prends les photos depuis l'ordi). Cela permet donc de prendre des photos de qualité (car depuis des appareils DSLR haut de gamme), et c'est donc idéal pour du stopmotion de qualité professionnel. Les autres logiciels "spécialisé stopmotion" sur Linux sont tous faits pour les webcams, ce qui est cool pour s'amuser et faire des films rapides, mais montre ses limites immédiatement pour un film pro. Et puis surtout ils sont soit abandonnés (Luciole), soit même si un dév a repris (comme Linux-Stopmotion), l'UI est mauvaise et surtout le logiciel instable (Linux-Stopmotion crashe pour un oui ou un non). En tous, le dév d'Entangle prévoit a terme d'ajouter aussi un support pour les webcam, ce qui permettra tout dans un seul logiciel. :-)

Mon dernier patch en date pour Entangle fut de simuler de "l'obturateur électronique", ce qui épargne la durée de vie de l'obturateur lorsque de la grande qualité n'est pas nécessaire, ce qui est le premier frein pour utiliser un DSLR en stopmotion. D'ailleurs dès que j'ai une caméra open-hardware AXIOM, l'un des premiers trucs que je ferai probablement sera d'ajouter sa prise en charge dans Entangle! On aura alors de la haute qualité, avec obturateur électronique. Idéal!

Et puis tiens pour le fun, voici une vidéo de mon patch pour ajouter un début d'UI pour stopmotion sur Entangle: https://www.youtube.com/watch?v=_bAzOTttYkM

Ce n'est pas encore dans les sources officielles, mais je peux assurer que si on se met à faire de la stopmotion après ZeMarmot, on aura enfin un logiciel digne de ce nom pour la stopmotion sous Linux. Surtout que le mainteneur n'est pas opposé à l'utilisation d'Entangle pour de la stopmotion.

Enfin voilà, tout ça pour dire, n'hésitez pas à nous suivre puis à donner, pour les amoureux de la stopmotion, car clairement on aime ça aussi et c'est le prochain sujet qu'on bichonnera, mais seulement si on nous en donne les moyens! :p

Je suivrais la campagne de financement avec attention.

Cool.

Par ailleurs, je joue de l'harmonica et improvise/compose des morceaux depuis peu. L'idée d'en composer/enregistrer pour votre projet me tente énormément. Mes styles de prédilections : blues, jazz, musique de l'est, parfois un mélange des genres. Je vais mettre en ligne quelques morceaux démo sous peu pour que vous puissiez vous faire un avis.

Super, j'attends cela avec impatience.

Pour info, je suis aussi harmoniciste. C'est un bon instrument pour un vagabond. Cela m'a permis de jouer dans pas mal de pays du monde sans trimballer un gros instrument. Et ça m'a aussi payé pas mal de repas et de nuits. :-)

Et en fait si notre financement ne monte pas jusqu'à nos espérances, il y a des chances pour qu'on fasse aussi nous-même la musique. Mais je n'ai aucun problème pour payer un autre harmoniciste qui fait de meilleures choses. D'ailleurs j'ai déjà beaucoup à faire, donc ce serait tant mieux. Je dis juste ça pour faire la conversation. ;-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Ça a l'air cool, mais clairement destiné à un public averti qui connaît déjà tout le vocabulaire (Thiele & Small, etc.) et qui construit déjà des enceintes. Pour les moins avertis (comme moi!), qui s'intéresse potentiellement à ce type de sujet, t'as un lien détaillé sur la construction d'enceintes? :-)

Je sais pas si j'en construirais jamais (ça dépendra probablement de la complexité, mais surtout du type de matériel nécessaire; mais pareil, je le saurais uniquement si j'ai le texte explicatif adéquat), mais si un jour j'ai un peu de temps, il pourrait m'en prendre l'envie si j'ai un tutoriel adéquat pour m'expliquer ce qu'il en est.

Merci!

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Mais au moins ça veut dire qu’il est possible d’avoir une version, avec l’option activée, dans vos distros si vous négociez bien avec le mainteneur du paquet!

Bien sûr! C'est du Logiciel Libre! :-)

Aussi je voudrai pointer du doigt que nous listons le paquet de lisanet sur notre page de Download pour OSX, juste à côté de notre propre paquet officiel upstream. En plus clairement le texte utilisé pour décrire cette version alternative donne plus envie de la choisir, plutôt que la version officielle.

Ça c'est pour faire taire un peu toutes les mauvaises langues qui semblent vouloir faire de nous d'horribles tyrans qui essayons de faire taire la masse. On n'a rien contre les gens qui sont pas d'accord avec nous. On a juste une décision collective d'équipe (avec bien sûr un pouvoir particulier du mainteneur, mais je vous assure qu'il écoute quand on n'est pas d'accord et est prêt à revenir sur des décisions quand on argumente bien) et c'est cette décision. C'est tout. Si quelqu'un souhaite faire autrement (fork, plugin, etc.), grand bien leur fasse, c'est le Logiciel Libre! Et s'ils font un travail de qualité (et pas juste du troll "bouh les méchants de GIMP"), nous n'hésiterons pas à les lister sur notre page de téléchargement comme version alternative.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Pour ce faire, pas besoin d'un enregistrement par défaut en .xcf.

Quel autre format prend en charge les calques, tous les modes de merge pris en charge par GIMP, les vecteurs, les guides, les sélections, les profondeurs de couleur jusqu'à 64 bit par canal (pour la version à venir), et j'en oublie probablement encore?

D'ailleurs, le concurrent commercial de Gimp […]

Désolé, Photoshop n'est pas notre référence, et on n'est pas là pour essayer de faire un clone.

D'ailleurs j'utilise quasi jamais Photoshop (les seules fois où cela m'arrive encore, c'est quand je suis chez des gens qui veulent que je leur explique un truc. En général c'est d'ailleurs un Photoshop piraté qu'ils ont…).

Des utilisateurs ont proposé que l'on puisse avoir le choix dans la conf entre les deux modes de sauvegarde, rien à faire, c'est le nouveau mode d'enregistrement de Gimp, point barre… Circulez…

Cela ne me dérangerait pas plus que cela perso, mais franchement je comprends aussi le refus. Déjà parce que les gens ne "proposent" pas. En général ils "réclament" en disant qu'on est des connards qui se fichent des utilisateurs. Un peu comme tu le dis à demi-mot depuis quelques messages, il me semble. Ça donne pas envie d'écouter déjà. Ensuite passons sur la manière, soit, et voyons le fond: si la proposition a du sens, on peut toutefois l'adopter et passer outre les insultes. Mais voilà il se trouve qu'on a décidé ("on" générique de l'équipe, car perso je me fiche de ce sujet) que cela était un mauvais choix design. Et cela ajoute du code, donc des possibilités de bug futur que personne d'entre nous n'est prêt à maintenir puisqu'on est soit pas d'accord, soit on s'en fiche. Donc se donner du travail pour quelque chose qu'on pense être une mauvaise idée, sur un sujet qui a été beaucoup débattu, qui est le résultat de tests d'utilisabilité effectué par un designer professionnel, etc. Tu nous excuseras de ne pas vouloir maintenir ce code. Si encore c'était proposé par quelqu'un qui vient avec de vrais raisons, d'autres tests d'utilisabilité effectué par un panel d'utilisateurs dans un contexte professionnel (et venant donc contredire les premiers résultats), poliment, du code et un mainteneur, là on y réfléchirait.

Note qu'il y a plein de choix designs que je déplore, dans GIMP aussi d'ailleurs même si j'en suis développeur, tout comme dans d'autres logiciels que j'utilise (par exemple certains changements de Firefox). Mais voilà, je ne peux pas imposer ma vision partout. Des fois j'essaie de proposer constructivement (dans un rapport de bug, parfois même avec patch, pas avec du sarcasme ou des insultes), parfois ça ne prend pas, je prend sur moi et je passe à autre chose (soit en essayant d'autres logiciels si le problème rend mon utilisation impossible, soit en m'adaptant).

Peut-être que certains pourraient faire la même chose pour GIMP…

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Je pense que tu utilises GIMP sous OSX et que tu l'as téléchargé sur lisanet, non? Il me semble que c'est l'un des patchs qu'elle applique à l'arbre des sources avant de faire son paquet.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Rien que l'étape tracer une droite relève de bac+12 et encore je suis gentil.

Tu traces une ligne droite avec shift-click (avec tous les outils qui permettent de peindre). C'est un classique de logiciels de dessin. Donc oui, faut le savoir, mais c'est normal dans un logiciel avec tant de fonctionnalités, y a des choses à apprendre pour le maîtriser.

Pour l'épaisseur de 3 pixels, c'est dans les options de l'outil. Pour la taille de l'image, tu choisis ça en créant l'image. Et pour le format png, tu choisis au moment d'exporter.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Je connais beaucoup d'utilisateurs avancés qui ne seraient pas d'accord avec ton propos. Si tu veux faire des statistiques au doigt levé, j'aurais même tendance à dire que ceux qui sont pas d'accord, c'est plutôt l'inverse: les utilisateurs non pros qui utilisent GIMP pour faire des bidouillages vite fait et ne sauvegardent jamais leur travail. En effet pour eux, le nouveau système a apporté une régression puisqu'ils ont un clic supplémentaire à faire.

Mais un utilisateur avancé ne se plaindra en général pas du nouveau système au contraire, car un utilisateur avancé ne fera pas un travail sans le sauvegarder.

De la même manière que lorsque je développe un logiciel, je ne garde en général pas que le binaire (mais aussi le fichier source), que lorsque j'écris un courrier dans LibreOffice ou LateX, je ne garde en général pas que le pdf (mais aussi le .odt/.tex), que lorsque je fais un projet 3D dans blender, je ne garde en général pas que le fichier vidéo (mais aussi le .blend), eh bien lorsque je travaille sur une image, je ne garde en général pas que l'image finale (mais aussi le fichier de travail .xcf). Et même je ne prends pas de risque de me tromper en affirmant que plus d'un utilisateur avancé a un jour remercié GIMP de lui avoir rappelé qu'il a oublié de sauver le .xcf en sortant du logiciel (lui évitant ainsi de perdre des heures de travail que le rendu final en jpg ou autre n'aurait absolument pas sauvé).

Les utilisateurs qui ont été les plus embêtés sont — de ce qu'il m'a semblé dans les quelques uns qui se plaignent sur la mailing list — plutôt des gens qui font une opération basique en masse sur des dizaines d'images (ex: redimensionner des centaines d'images), et qui veulent uniquement garder l'image finale. Dans ce cas, ils détestent cette popup supplémentaire qui leur rappelle qu'ils n'ont pas sauvé (donc perte de temps puisqu'ils travaillent sur une quantité phénoménale de photo). Mais franchement ceci n'est pas une utilisation avancée de GIMP. GIMP n'est pas fait pour traiter à la chaîne des dizaines d'images avec une opération simple. Pour cela, ils devraient utiliser ImageMagick, ou G'Mic il me semble (ils ont un outil de ligne de commande qui est assez similaire à ImageMagick, à ce que j'ai compris), ou même gegl directement (qui a aussi un outil en ligne de commande et permet de traiter aussi des images facilement avec l'ensemble des opérations GEGL accessibles).

Ensuite effectivement je pense qu'il y a beaucoup de ce type d'utilisateur, des gens qui font juste des petites modifs par ci par là (parfois sur de grosses quantités), souvent de façon absolument pas efficace (GIMP n'est pas adapté, en tous cas pour ceux qui travaillent sur de grosses quantité), probablement plus que des pros qui font un travail poussé avec GIMP. Donc ça a mécontenté une certaine tranche d'utilisateur, c'est sûr.

Ensuite pour ton attaque sur les dévs GIMP "repliés sur leurs idées", je dirais qu'au contraire l'équipe de GIMP est une équipe extrêmement accueillante, en particulier son mainteneur (même s'il est pas tellement bavard, donc ça se voit pas). Ensuite oui il y a quelques fortes têtes, et pas forcément ceux qui contribuent le plus au code, bien au contraire. Mais ça c'est dans tous les projets. Je peux t'assurer que si tu viens avec des idées et du code, on t'écoutera. C'est ainsi que cela s'est passé dans mon cas.

Ensuite oui, venir avec du code pour inverser cette fonctionnalité particulière de sauver/exporter qui a vraiment du sens, a sauvé beaucoup de travail à plein de gens et qui est devenu un troll, oui là ça ira pas.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Tu as raison, mais en même temps, c'est ce que l'auteur veut: une séparation de certains logiciels du reste du système. Et je suis pas sûr que ce soit beaucoup plus chiant que les alternatives proposées (sandboxing!).

Et si on utilise toujours le même préfixe alternatif, alors on n'a pas à mettre a jour les variables d'environnement 100 fois, juste la première fois. En fait tout dépend vraiment du type d'utilisation que l'auteur du journal avait en vue, ce qui n'est pas très clair pour moi. Si c'est juste pour utiliser un logiciel stable régulièrement et que la seule chose qu'elle souhaitait éviter était de mélanger des données et binaires installés manuellement avec le système principal (ce qui serait en effet une très mauvaise idée), alors un --prefix est je pense le plus simple.

Ensuite comme quelqu'un propose plus bas, y a aussi la solution de faire un paquet pour le système cible, ce qui permet à la fois d'installer avec le reste du système (et donc de n'avoir aucune variable à mettre à jour) tout en ayant une (dés)installation propre.

Par contre ça implique de savoir rapidement faire un paquet (là encore ça va, c'est comme tout, ça s'apprend; mais ça reste tout de même un point de complexité supplémentaire par rapport à un simple --prefix), mais surtout ça rend les modifications plus dur, ce qui est embêtant si le but était aussi de pouvoir modifier le programme (ce qui est souvent la raison pour laquelle je compile moi-même certains logiciels).

Bien sûr, si ce n'est pas le cas de Mildred et qu'elle n'a aucune intention de modifier le logiciel, alors c'est aussi une alternative intéressante.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Corrige moi si je me trompe, mais ta problématique est simplement d'installer un programme auto-compilé, que tu comptes vraiment utiliser (et pas juste tester)?

Parce que le sandbox, c'est plus pour des tests, par exemple pour sécuriser tes données si tu n'as pas entièrement confiance au programme exécuté, ou si c'est une version de dév un peu instable, ou que sais-je encore. Mais si ta problématique est uniquement que tu veux pas faire d'install crade, ça me paraît disproportionné.

Si ton programme utilise les autotools, il suffit de mettre l'option --prefix au script configure:

./configure --prefix=$HOME/.local --autre --options

make && make install

Les autres systèmes de compilation ont (tous ceux qui se respecte, à ma connaissance) aussi un moyen de spécifier le préfixe d'installation, par exemple lors de la phase cmake, etc.

$HOME/.local est un préfixe assez classique pour installer des logiciels pour ton user seulement (mais ça mélangera les divers logiciels si tu en installes d'autres avec ce même préfixe). Tu n'as même pas besoin d'être root pour le make install (en fait, de manière général, je déconseille d'installer quoi que ce soit d'auto-compilé en root, sauf si vous êtes vraiment sûr de vous).

Sinon souvent on va installer dans /opt/nom-du-logiciel/ ou quoi que tu veuilles. Il suffit juste de bien mettre à jour la variable d'environnement $PATH.

Par exemple dans ton ~/.bashrc:

export PATH="$HOME/.local/bin:$PATH"

Ensuite quand tu veux désinstaller, si tu as utilisé un préfixe unique avec aucun autre logiciel installé dedans, tu peux juste effacer tout le répertoire.

Note que DESTDIR fait quelque chose de similaire, sauf que ce n'est absolument pas fait pour une installation finale. C'est plutôt fait pour créer votre arborescence, préfixe compris, dans un répertoire pour ensuite le déplacer ailleurs, cette fois au bon préfixe. L'utilisation la plus commune est la création de paquet, pour une utilisation sur plusieurs machines, par exemple dans un parc informatique, ou bien pour une distribution Linux, etc.

En gros on donne à --prefix l'emplacement qui sera utilisé au final par le logiciel dans la machine cible, alors que DESTDIR n'est qu'un emplacement temporaire, en préparation du paquet, sur la machine de compilation et ne doit avoir absolument aucun impact sur l'installation finale.

En fait c'est même sujet à bug d'utiliser DESTDIR pour une installation finale. En effet, le logiciel peut potentiellement utiliser le préfixe déterminé à la configuration (qui peut alors être inclus dans les sources avant compilation); par exemple pour connaître l'emplacement de données (permettant ainsi les binaires et les données d'être dans un préfixe différent notamment).

DESTDIR par contre ne sert à rien et ne sera jamais utilisé par le logiciel final. Tu risques donc de "casser" le logiciel si ton installation repose sur l'usage de DESTDIR.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

À part si tu utilises la version de dév (dépôt git), la version "release" n'a pas encore ce concept.

Pour l'instant y a juste le concept de plateforme cible (w32, w64), mais la version à venir a des projets nommés par cible. Donc la cible "w64" pourra avoir le projet "akagoria", et d'autre projets (nommés différemment), chacun avec son propre environnement séparé, car on ne veut pas mélanger les binaires de plusieurs projets indépendants en général.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Cool de lire que tu utilises enfin crossroad, et apparemment avec succès! J'ai pas beaucoup de retours et ne savais pas si y avait vraiment des utilisateurs, hormis moi-même. N'hésite donc pas à faire des retours.

Aussi il y aura encore quelques changements de syntaxe de ligne de commande avec la prochaine version (qui arrivera quand je trouverai enfin le temps de finaliser le tout), car j'ai ajouté quelques paradigmes, notamment pour pouvoir travailler sur plusieurs projets en même temps, avec des environnements de cross-compilation indépendants.

Rien de terrible, ceci dit. :-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Je suis d'accord pour dire que YAML est un format horrible. Pour un travail précédent où j'ai écrit un outil qui convertissait des fichiers de localisation (et il se trouve que certains logiciels localisent avec un format basé sur YAML), j'ai écrit un parseur basé sur la spéc. C'était franchement l'un des pires formats avec lequel j'ai eu à travailler. Aucune cohérence, 20000 façons de faire la même chose sémantiquement, des règles/exceptions super tarabiscotées. Même pour un humain, puisqu'il y a plusieurs façons de faire les mêmes choses, je suis persuadé que quand on se met à travailler en groupe avec ce format, on se retrouve avec des problèmes de compréhension de syntaxe.

Perso, je pense que XML reste un des meilleurs formats pour tout ce qui est automatisé (facile à parser par une machine, et facile à lire, donc débugguer par un humain en cas de problème); et pour tout ce qui est à éditer par un humain (fichiers de configuration pour un logiciel non-graphique par ex) ou pour des données vraiment simples et linéaires, de simples fichiers INI ou similaires vont parfaitement.

Json, c'est bien pour le web, où on essaie souvent d'optimiser le moindre bit. Mais pour des fichiers qui restent principalement sur la même machine, je lui préfère de loin XML. C'est beaucoup plus lisible.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

Oui non c'est sûr, c'était une phrase idiote de ma part. À partir du moment où je gère mes papiers dans l'ordi, je laisse un système informatique gérer entièrement ces fichiers. Et bien d'autres choses peuvent foirer dans un ordi. Disons plutôt que je ne me sens confiant pour laisser un système informatique gérer mes fichiers que jusqu'à un certain niveau d'automatisation et d'abstraction.

Peut-être que cela changera, mais à l'heure actuelle je ne souhaite pas laisser l'ordi ranger pour moi les fichiers. Je pense que nous ne sommes pas encore à un stade où les IA sont suffisamment évolués pour le faire sans accroc (c'est à dire qu'ils le font peut-être déjà mieux que nous, mais quand ça foire, ça foire bien! Et ça c'est un gros problème).

Le niveau "système de fichiers" (+ sauvegardes évidemment, et en utilisant un système de fichiers bien rôdé, pas un truc expérimental, bien sûr) est à mon sens suffisamment stable et fiable à l'heure actuelle pour que je lui fasse confiance. Pas l'automatisation des tags par contre.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

# Association LILA?

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Un nom de domaine en .info ou .fr à offrir. Évalué à 4.

Salut Benbben,

L'association LILA (Libre comme L'Art) est sur un .info: libreart.info.

Nous promouvons l'Art Libre, c'est à dire les logiciels Libres créatifs (Blender, GIMP, Inkscape, Scribus, Krita, MyPaint, etc.), les licences Libres, et de manière générale la liberté et tout activité créative bénéfique. N'hésite pas à jeter un œil sur notre site: http://libreart.info/fr/

On a expliqué notre gros projet en cours sur linuxfr: http://linuxfr.org/users/jehan/journaux/presentation-du-projet-film-d-animation-zemarmot-et-appel-a-musiciens

On a aussi d'autres projets dans la besace, mais comme on n'est pas nombreux pour le moment, c'est pas facile de tout mettre en avant! D'ailleurs n'hésitez pas, si quelqu'un a des projets qui rentrent dans le contexte et veut les faire sous notre bannière, nous en serions ravis. Devenez membre, on est ouvert! :-)

Enfin voilà, donc si ton .info gratuit marche aussi pour un renouvellement (en changeant de registrar puisqu'on n'est pas chez Gandi), on est preneur.

Si c'est seulement pour une création malheureusement, on laissera à d'autres. On ne prévoit pas de multiplier les domaines. :-)

Et pis je pense qu'on rentre bien dans tes critères "un projet sympa, culturel, ou en rapport la liberté, et/ou le logiciel libre", non? :-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Wilber aussi s'y met

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Je déteste le premier avril. Évalué à 4.

Ahahahah! En effet! Mais pour être tout à fait honnête, j'espère que ça ne va pas rester une blague trop longtemps. Donc je voudrais pas faire de cette blague une réalité en la dessinant! :p

Je pense qu'il faut commencer à stabiliser les fonctionnalités et à arrêter d'en accepter de nouvelles très bientôt. Je crois que je vais proposer cela lors de LGM en fin de mois, tiens.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

# Wilber aussi s'y met

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Je déteste le premier avril. Évalué à 5.

Ça compte probablement pas comme une blague de news, mais Wilber (la mascotte de GIMP pour les plus ignorants) s'y met aussi!

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Salve de questions

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Présentation du projet (film d'animation) ZeMarmot et appel à musiciens. Évalué à 5.

Salut,

Mon début de script actuel tient plutôt du moyen métrage. Je mise sur 45 min.

Maintenant c'est plus un "but", un idéal, et je reste réaliste, je pense que les chances sont faibles de lever suffisamment (mais sait-on jamais! Je fais tout ce qui dans mes faibles compétences marketing pour essayer tout de même et je touche du bois). Si on arrive à lever juste 10 000 EUR par exemple, faut pas s'attendre à 45 min. Ce sera plus de l'ordre de quelques minutes. À ce moment, on transformera peut-être le projet en une mini anecdote de quelques minutes, qui pourrait donner lieu à une mini série (dans ce cas, avec une suite de petits financements?).

L'idée, c'est d'arriver à payer des gens. Or on sait tous combien coûte un mois de salaire en gros (même sans grande ambition).

Oui pour l'instant le site du film est plus "en construction" qu'autre chose. Faut que je prenne le temps et mes journées sont pas assez longues! :P

Ce projet est d'abord personnel. Donc à l'heure actuelle, l'équipe, c'est juste cela. Pour l'instant, personne n'est rémunéré (pas même nous, on fait ça en puisant sur nos moyens), et on met les choses en place pour un financement pour justement espérer recruter et rémunérer des gens. On essaie déjà de voir à droite, à gauche les gens intéressants, et on a lié quelques contacts, mais on ne demande à personne de bosser gratos sur le projet. Bon si quelqu'un souhaitait intégrer et nous aider dès maintenant avec des compétences d'animation et de dessin, en acceptant de ne pas être rémunéré en espérant que le financement soit un succès, on dirait pas non. On est un peu comme un projet de Logiciel Libre. Mais personne ne nous a demandé. Y a je crois beaucoup plus de libristes parmi les développeurs que parmi les animateurs 2D! :-/

C'est aussi un peu l'un des points de notre association de présenter un nouveau mode de pensée parmi les artistes, d'ailleurs (qui pour la plupart ne vont jurer que par Adobe et autres logiciels proprios, ainsi que les modes de distribution classique de film).

Encore une fois, cela dépendra donc principalement du montant que nous arriverons à lever. Dans mon exemple fictif de 10 000 EUR plus haut par exemple, on n'aura pas les moyens de payer un autre animateur, c'est clair.

Ensuite plus on récoltera, plus cela permettra d'avoir un film long, et d'avoir des animateurs.

Bien entendu. Sans un aperçu, on n'aurait aucune chance. On est en train de préparer cette "bande annonce" (qui tiendrait plus du "teaser" que de la bande annonce d'ailleurs, mais aucune idée comment traduire ce terme convenablement en français).

Nous présenterons notre teaser lors du Libre Graphics Meeting 2015 à Toronto, au début du mois de mai (notre présentation est prévue le samedi 2 mai pour être précis) et nous prévoyons de démarrer le financement au même moment. C'est le plan. :-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Présent !

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Présentation du projet (film d'animation) ZeMarmot et appel à musiciens. Évalué à 2.

Salut,

Bien sûr, on est intéressé. Par contre l'un des prérequis pour bosser à distance est — je pense — d'être un minimum sûr de soi et de savoir ce qu'on fait. On a beaucoup d'idées nous même, mais dans un tel projet, il faut aussi clairement que les musiciens soient réactifs et proposent des choses auxquelles on ne pense pas, par exemple, explorent d'autres voies, etc. Je dis juste ça parce que tu m'as eu l'air un peu incertain dans ton message. Ça peut être fatal lors d'une entrevue d'embauche. Quand tu veux te vendre, tu dois te vendre comme le meilleur (ou au moins quelqu'un de bon, si tu veux faire le modeste), pas comme "je ne m'engage pas sur la qualité musicale du résultat". Juste un petit conseil quoi. :P

Enfin bon, envoie moi un email à jehan chez girinstud.io et on pourra parler plus en détail sur "la manière de procéder", et si on décide de bosser ensemble (j'ai reçu pas mal de propositions depuis hier, faut que je prenne le temps de tout écouter!).

Aussi tu me parles de tes contacts, vérifie bien que ces derniers ne soient pas affiliés SACEM, comme j'en parle dans mon journal, car la plupart des musiciens, même amateurs, s'y inscrivent. C'est vraiment pas moi qui fais les règles. J'aurais aucun problème à bosser avec quelqu'un à la SACEM (même si j'approuve pas, je comprends parfaitement la peur de l'inconnu et le besoin de faire comme tout le monde), mais ces derniers ont juste pas le droit. Donc pas la peine de discuter plus avant dans ce cas.

Enfin voilà, contacte moi. Ah et je veux bien écouter quelques enregistrements, si t'as aussi!

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: On se dépêche

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Présentation du projet (film d'animation) ZeMarmot et appel à musiciens. Évalué à 2.

Ah bah pourquoi pas. :-)

Si vous voulez passer en dépêche, je dis pas non!

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: L'AMMD serait partante

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Présentation du projet (film d'animation) ZeMarmot et appel à musiciens. Évalué à 3.

C'est génial, je vais vous contacter! :-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Projet très intéressant

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Présentation du projet (film d'animation) ZeMarmot et appel à musiciens. Évalué à 7.

Voilà, tout à fait.

Pour démo, voici le premier lien que je trouve quand je cherche la durée de vie moyenne de l'obturateur de mon appareil photo: http://www.olegkikin.com/shutterlife/canon_eos50d.htm

Basé apparemment sur quelques centaines de rapports utilisateurs, mon Canon EOS 50D tiendrait en moyenne ~ 70 000 clics (= photos, grosso modo) +/-. Or imagine un film d'une heure à 24 images seconde: il me faudrait 86400 photos! Sans compter toutes les photos ratées, les tests, les scènes enlevées éventuelles…

En gros, si tu fais un film de 2h, tu es sûr d'user 2, 3, voire 4 obturateurs!

C'est le problème de travailler avec de l'optique mécanique au lieu d'électronique, car ça s'use par la force des choses (ça s'ouvre, ça se ferme, ça s'ouvre, ça se ferme, etc.).

Note que quand ton obturateur lâche, tu n'es pas obligé de racheter un appareil. Tu peux faire changer l'obturateur (d'après le web, pour mon appareil, ça coûterait dans les 200 € pièces + main d'œuvre, ce qui reste bien moins cher que d'acheter un nouvel appareil de cette qualité, même d'occase). Ça limite l'utilisation de ce type d'appareil pour la stop-motion, ce qui est dommage car ça donne de la très bonne qualité!

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Projet très intéressant

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Présentation du projet (film d'animation) ZeMarmot et appel à musiciens. Évalué à 3.

J'ai oublié de répondre à ça:

On est sur Paris. L'assoce a un local dans le 11ème. En cliquant là tu trouveras l'adresse, le tél, etc.. Si tu es sur Paris ou proche, n'hésite pas à passer nous voir (appelle avant ou envoie un email pour être sûr qu'on y est! Ce serait bête d'arriver devant une porte fermée).

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: tabletop

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Présentation du projet (film d'animation) ZeMarmot et appel à musiciens. Évalué à 2.

J'écouterai.

Non si la personne est capable de bosser en collaboration en ligne, ça n'est pas un problème.

Ensuite il est clair que pouvoir rencontrer les artistes et bosser proche pour discuter et faire du détail, ça aide et c'est plus sympa. Mais si jamais on a un coup de cœur pour un artiste, ou simplement qu'on trouve quelqu'un très bien mais à l'autre bout du monde, on fait avec. :-)

Et puis des fois, on n'a juste pas le choix!

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Pour les musiciens

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Présentation du projet (film d'animation) ZeMarmot et appel à musiciens. Évalué à 2.

Super pour la liste, j'écouterai tout cela! :-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Projet très intéressant

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Présentation du projet (film d'animation) ZeMarmot et appel à musiciens. Évalué à 8.

Salut,

Nous aimons beaucoup la stopmotion également! On vient d'ailleurs d'aller voir "Shaun le Mouton", il y a une semaine, c'était vraiment cool et toujours aussi impressionnant techniquement.

À vrai dire, c'est quasi certain que — si notre premier financement de projet est un succès — notre projet de film d'animation suivant sera un film en stopmotion (notre premier projet a failli en être un d'ailleurs, nous avons hésité entre plusieurs propositions). Le logiciel candidat idéal pour faire de la stopmotion sur Linux est Entangle, sur lequel j'ai d'ailleurs contribué plusieurs patchs déjà. Entangle n'est pas fait initialement pour la stopmotion, mais est un logiciel de prise de vue photographique (tu branches ta caméra DSLR en USB, tu la mets sur un pied et tu prends les photos depuis l'ordi). Cela permet donc de prendre des photos de qualité (car depuis des appareils DSLR haut de gamme), et c'est donc idéal pour du stopmotion de qualité professionnel. Les autres logiciels "spécialisé stopmotion" sur Linux sont tous faits pour les webcams, ce qui est cool pour s'amuser et faire des films rapides, mais montre ses limites immédiatement pour un film pro. Et puis surtout ils sont soit abandonnés (Luciole), soit même si un dév a repris (comme Linux-Stopmotion), l'UI est mauvaise et surtout le logiciel instable (Linux-Stopmotion crashe pour un oui ou un non). En tous, le dév d'Entangle prévoit a terme d'ajouter aussi un support pour les webcam, ce qui permettra tout dans un seul logiciel. :-)

Mon dernier patch en date pour Entangle fut de simuler de "l'obturateur électronique", ce qui épargne la durée de vie de l'obturateur lorsque de la grande qualité n'est pas nécessaire, ce qui est le premier frein pour utiliser un DSLR en stopmotion. D'ailleurs dès que j'ai une caméra open-hardware AXIOM, l'un des premiers trucs que je ferai probablement sera d'ajouter sa prise en charge dans Entangle! On aura alors de la haute qualité, avec obturateur électronique. Idéal!

Et puis tiens pour le fun, voici une vidéo de mon patch pour ajouter un début d'UI pour stopmotion sur Entangle: https://www.youtube.com/watch?v=_bAzOTttYkM

Ce n'est pas encore dans les sources officielles, mais je peux assurer que si on se met à faire de la stopmotion après ZeMarmot, on aura enfin un logiciel digne de ce nom pour la stopmotion sous Linux. Surtout que le mainteneur n'est pas opposé à l'utilisation d'Entangle pour de la stopmotion.

Enfin voilà, tout ça pour dire, n'hésitez pas à nous suivre puis à donner, pour les amoureux de la stopmotion, car clairement on aime ça aussi et c'est le prochain sujet qu'on bichonnera, mais seulement si on nous en donne les moyens! :p

Cool.

Super, j'attends cela avec impatience.

Pour info, je suis aussi harmoniciste. C'est un bon instrument pour un vagabond. Cela m'a permis de jouer dans pas mal de pays du monde sans trimballer un gros instrument. Et ça m'a aussi payé pas mal de repas et de nuits. :-)

Et en fait si notre financement ne monte pas jusqu'à nos espérances, il y a des chances pour qu'on fasse aussi nous-même la musique. Mais je n'ai aucun problème pour payer un autre harmoniciste qui fait de meilleures choses. D'ailleurs j'ai déjà beaucoup à faire, donc ce serait tant mieux. Je dis juste ça pour faire la conversation. ;-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

# Et comment on fait des enceintes?

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal QSpeakers, une pièce manquante pour les DIY sous Linux. Évalué à 5.

Salut!

Ça a l'air cool, mais clairement destiné à un public averti qui connaît déjà tout le vocabulaire (Thiele & Small, etc.) et qui construit déjà des enceintes. Pour les moins avertis (comme moi!), qui s'intéresse potentiellement à ce type de sujet, t'as un lien détaillé sur la construction d'enceintes? :-)

Je sais pas si j'en construirais jamais (ça dépendra probablement de la complexité, mais surtout du type de matériel nécessaire; mais pareil, je le saurais uniquement si j'ai le texte explicatif adéquat), mais si un jour j'ai un peu de temps, il pourrait m'en prendre l'envie si j'ai un tutoriel adéquat pour m'expliquer ce qu'il en est.

Merci!

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Krita ou GIMP

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Remplacement de Photoshop par Krita dans une université parisienne. Évalué à 4.

Bien sûr! C'est du Logiciel Libre! :-)

Aussi je voudrai pointer du doigt que nous listons le paquet de lisanet sur notre page de Download pour OSX, juste à côté de notre propre paquet officiel upstream. En plus clairement le texte utilisé pour décrire cette version alternative donne plus envie de la choisir, plutôt que la version officielle.

Ça c'est pour faire taire un peu toutes les mauvaises langues qui semblent vouloir faire de nous d'horribles tyrans qui essayons de faire taire la masse. On n'a rien contre les gens qui sont pas d'accord avec nous. On a juste une décision collective d'équipe (avec bien sûr un pouvoir particulier du mainteneur, mais je vous assure qu'il écoute quand on n'est pas d'accord et est prêt à revenir sur des décisions quand on argumente bien) et c'est cette décision. C'est tout. Si quelqu'un souhaite faire autrement (fork, plugin, etc.), grand bien leur fasse, c'est le Logiciel Libre! Et s'ils font un travail de qualité (et pas juste du troll "bouh les méchants de GIMP"), nous n'hésiterons pas à les lister sur notre page de téléchargement comme version alternative.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Krita ou GIMP

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Remplacement de Photoshop par Krita dans une université parisienne. Évalué à 10.

Quel autre format prend en charge les calques, tous les modes de merge pris en charge par GIMP, les vecteurs, les guides, les sélections, les profondeurs de couleur jusqu'à 64 bit par canal (pour la version à venir), et j'en oublie probablement encore?

Désolé, Photoshop n'est pas notre référence, et on n'est pas là pour essayer de faire un clone.

D'ailleurs j'utilise quasi jamais Photoshop (les seules fois où cela m'arrive encore, c'est quand je suis chez des gens qui veulent que je leur explique un truc. En général c'est d'ailleurs un Photoshop piraté qu'ils ont…).

Cela ne me dérangerait pas plus que cela perso, mais franchement je comprends aussi le refus. Déjà parce que les gens ne "proposent" pas. En général ils "réclament" en disant qu'on est des connards qui se fichent des utilisateurs. Un peu comme tu le dis à demi-mot depuis quelques messages, il me semble. Ça donne pas envie d'écouter déjà. Ensuite passons sur la manière, soit, et voyons le fond: si la proposition a du sens, on peut toutefois l'adopter et passer outre les insultes. Mais voilà il se trouve qu'on a décidé ("on" générique de l'équipe, car perso je me fiche de ce sujet) que cela était un mauvais choix design. Et cela ajoute du code, donc des possibilités de bug futur que personne d'entre nous n'est prêt à maintenir puisqu'on est soit pas d'accord, soit on s'en fiche. Donc se donner du travail pour quelque chose qu'on pense être une mauvaise idée, sur un sujet qui a été beaucoup débattu, qui est le résultat de tests d'utilisabilité effectué par un designer professionnel, etc. Tu nous excuseras de ne pas vouloir maintenir ce code. Si encore c'était proposé par quelqu'un qui vient avec de vrais raisons, d'autres tests d'utilisabilité effectué par un panel d'utilisateurs dans un contexte professionnel (et venant donc contredire les premiers résultats), poliment, du code et un mainteneur, là on y réfléchirait.

Note qu'il y a plein de choix designs que je déplore, dans GIMP aussi d'ailleurs même si j'en suis développeur, tout comme dans d'autres logiciels que j'utilise (par exemple certains changements de Firefox). Mais voilà, je ne peux pas imposer ma vision partout. Des fois j'essaie de proposer constructivement (dans un rapport de bug, parfois même avec patch, pas avec du sarcasme ou des insultes), parfois ça ne prend pas, je prend sur moi et je passe à autre chose (soit en essayant d'autres logiciels si le problème rend mon utilisation impossible, soit en m'adaptant).

Peut-être que certains pourraient faire la même chose pour GIMP…

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Krita ou GIMP

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Remplacement de Photoshop par Krita dans une université parisienne. Évalué à 3.

Je pense que tu utilises GIMP sous OSX et que tu l'as téléchargé sur lisanet, non? Il me semble que c'est l'un des patchs qu'elle applique à l'arbre des sources avant de faire son paquet.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Krita ou GIMP

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Remplacement de Photoshop par Krita dans une université parisienne. Évalué à 10.

Tu traces une ligne droite avec shift-click (avec tous les outils qui permettent de peindre). C'est un classique de logiciels de dessin. Donc oui, faut le savoir, mais c'est normal dans un logiciel avec tant de fonctionnalités, y a des choses à apprendre pour le maîtriser.

Pour l'épaisseur de 3 pixels, c'est dans les options de l'outil. Pour la taille de l'image, tu choisis ça en créant l'image. Et pour le format png, tu choisis au moment d'exporter.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Krita ou GIMP

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Remplacement de Photoshop par Krita dans une université parisienne. Évalué à 10.

Je connais beaucoup d'utilisateurs avancés qui ne seraient pas d'accord avec ton propos. Si tu veux faire des statistiques au doigt levé, j'aurais même tendance à dire que ceux qui sont pas d'accord, c'est plutôt l'inverse: les utilisateurs non pros qui utilisent GIMP pour faire des bidouillages vite fait et ne sauvegardent jamais leur travail. En effet pour eux, le nouveau système a apporté une régression puisqu'ils ont un clic supplémentaire à faire.

Mais un utilisateur avancé ne se plaindra en général pas du nouveau système au contraire, car un utilisateur avancé ne fera pas un travail sans le sauvegarder.

De la même manière que lorsque je développe un logiciel, je ne garde en général pas que le binaire (mais aussi le fichier source), que lorsque j'écris un courrier dans LibreOffice ou LateX, je ne garde en général pas que le pdf (mais aussi le .odt/.tex), que lorsque je fais un projet 3D dans blender, je ne garde en général pas que le fichier vidéo (mais aussi le .blend), eh bien lorsque je travaille sur une image, je ne garde en général pas que l'image finale (mais aussi le fichier de travail .xcf). Et même je ne prends pas de risque de me tromper en affirmant que plus d'un utilisateur avancé a un jour remercié GIMP de lui avoir rappelé qu'il a oublié de sauver le .xcf en sortant du logiciel (lui évitant ainsi de perdre des heures de travail que le rendu final en jpg ou autre n'aurait absolument pas sauvé).

Les utilisateurs qui ont été les plus embêtés sont — de ce qu'il m'a semblé dans les quelques uns qui se plaignent sur la mailing list — plutôt des gens qui font une opération basique en masse sur des dizaines d'images (ex: redimensionner des centaines d'images), et qui veulent uniquement garder l'image finale. Dans ce cas, ils détestent cette popup supplémentaire qui leur rappelle qu'ils n'ont pas sauvé (donc perte de temps puisqu'ils travaillent sur une quantité phénoménale de photo). Mais franchement ceci n'est pas une utilisation avancée de GIMP. GIMP n'est pas fait pour traiter à la chaîne des dizaines d'images avec une opération simple. Pour cela, ils devraient utiliser ImageMagick, ou G'Mic il me semble (ils ont un outil de ligne de commande qui est assez similaire à ImageMagick, à ce que j'ai compris), ou même gegl directement (qui a aussi un outil en ligne de commande et permet de traiter aussi des images facilement avec l'ensemble des opérations GEGL accessibles).

Ensuite effectivement je pense qu'il y a beaucoup de ce type d'utilisateur, des gens qui font juste des petites modifs par ci par là (parfois sur de grosses quantités), souvent de façon absolument pas efficace (GIMP n'est pas adapté, en tous cas pour ceux qui travaillent sur de grosses quantité), probablement plus que des pros qui font un travail poussé avec GIMP. Donc ça a mécontenté une certaine tranche d'utilisateur, c'est sûr.

Ensuite pour ton attaque sur les dévs GIMP "repliés sur leurs idées", je dirais qu'au contraire l'équipe de GIMP est une équipe extrêmement accueillante, en particulier son mainteneur (même s'il est pas tellement bavard, donc ça se voit pas). Ensuite oui il y a quelques fortes têtes, et pas forcément ceux qui contribuent le plus au code, bien au contraire. Mais ça c'est dans tous les projets. Je peux t'assurer que si tu viens avec des idées et du code, on t'écoutera. C'est ainsi que cela s'est passé dans mon cas.

Ensuite oui, venir avec du code pour inverser cette fonctionnalité particulière de sauver/exporter qui a vraiment du sens, a sauvé beaucoup de travail à plein de gens et qui est devenu un troll, oui là ça ira pas.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: --prefix ?

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Comment faire une sandbox de mon système de fichier ?. Évalué à 3.

Salut,

Tu as raison, mais en même temps, c'est ce que l'auteur veut: une séparation de certains logiciels du reste du système. Et je suis pas sûr que ce soit beaucoup plus chiant que les alternatives proposées (sandboxing!).

Et si on utilise toujours le même préfixe alternatif, alors on n'a pas à mettre a jour les variables d'environnement 100 fois, juste la première fois. En fait tout dépend vraiment du type d'utilisation que l'auteur du journal avait en vue, ce qui n'est pas très clair pour moi. Si c'est juste pour utiliser un logiciel stable régulièrement et que la seule chose qu'elle souhaitait éviter était de mélanger des données et binaires installés manuellement avec le système principal (ce qui serait en effet une très mauvaise idée), alors un --prefix est je pense le plus simple.

Ensuite comme quelqu'un propose plus bas, y a aussi la solution de faire un paquet pour le système cible, ce qui permet à la fois d'installer avec le reste du système (et donc de n'avoir aucune variable à mettre à jour) tout en ayant une (dés)installation propre.

Par contre ça implique de savoir rapidement faire un paquet (là encore ça va, c'est comme tout, ça s'apprend; mais ça reste tout de même un point de complexité supplémentaire par rapport à un simple --prefix), mais surtout ça rend les modifications plus dur, ce qui est embêtant si le but était aussi de pouvoir modifier le programme (ce qui est souvent la raison pour laquelle je compile moi-même certains logiciels).

Bien sûr, si ce n'est pas le cas de Mildred et qu'elle n'a aucune intention de modifier le logiciel, alors c'est aussi une alternative intéressante.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

# --prefix ?

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Comment faire une sandbox de mon système de fichier ?. Évalué à 10.

Salut,

Corrige moi si je me trompe, mais ta problématique est simplement d'installer un programme auto-compilé, que tu comptes vraiment utiliser (et pas juste tester)?

Parce que le sandbox, c'est plus pour des tests, par exemple pour sécuriser tes données si tu n'as pas entièrement confiance au programme exécuté, ou si c'est une version de dév un peu instable, ou que sais-je encore. Mais si ta problématique est uniquement que tu veux pas faire d'install crade, ça me paraît disproportionné.

Si ton programme utilise les autotools, il suffit de mettre l'option --prefix au script configure:

Les autres systèmes de compilation ont (tous ceux qui se respecte, à ma connaissance) aussi un moyen de spécifier le préfixe d'installation, par exemple lors de la phase cmake, etc.

$HOME/.local est un préfixe assez classique pour installer des logiciels pour ton user seulement (mais ça mélangera les divers logiciels si tu en installes d'autres avec ce même préfixe). Tu n'as même pas besoin d'être root pour le

make install(en fait, de manière général, je déconseille d'installer quoi que ce soit d'auto-compilé en root, sauf si vous êtes vraiment sûr de vous).Sinon souvent on va installer dans /opt/nom-du-logiciel/ ou quoi que tu veuilles. Il suffit juste de bien mettre à jour la variable d'environnement $PATH.

Par exemple dans ton ~/.bashrc:

Ensuite quand tu veux désinstaller, si tu as utilisé un préfixe unique avec aucun autre logiciel installé dedans, tu peux juste effacer tout le répertoire.

Note que DESTDIR fait quelque chose de similaire, sauf que ce n'est absolument pas fait pour une installation finale. C'est plutôt fait pour créer votre arborescence, préfixe compris, dans un répertoire pour ensuite le déplacer ailleurs, cette fois au bon préfixe. L'utilisation la plus commune est la création de paquet, pour une utilisation sur plusieurs machines, par exemple dans un parc informatique, ou bien pour une distribution Linux, etc.

En gros on donne à --prefix l'emplacement qui sera utilisé au final par le logiciel dans la machine cible, alors que DESTDIR n'est qu'un emplacement temporaire, en préparation du paquet, sur la machine de compilation et ne doit avoir absolument aucun impact sur l'installation finale.

En fait c'est même sujet à bug d'utiliser DESTDIR pour une installation finale. En effet, le logiciel peut potentiellement utiliser le préfixe déterminé à la configuration (qui peut alors être inclus dans les sources avant compilation); par exemple pour connaître l'emplacement de données (permettant ainsi les binaires et les données d'être dans un préfixe différent notamment).

DESTDIR par contre ne sert à rien et ne sera jamais utilisé par le logiciel final. Tu risques donc de "casser" le logiciel si ton installation repose sur l'usage de DESTDIR.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: crossroad

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Je crée mon jeu vidéo E14 : formats de données. Évalué à 4.

Ah ben c'est en effet un commit intermédiaire. Mon dernier tag de release date de juillet.

Je viens de rajouter des infos supplémentaires dans le --version pour distinguer des versions de dév à partir de maintenant. :-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: crossroad

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Je crée mon jeu vidéo E14 : formats de données. Évalué à 3.

À part si tu utilises la version de dév (dépôt git), la version "release" n'a pas encore ce concept.

Pour l'instant y a juste le concept de plateforme cible (w32, w64), mais la version à venir a des projets nommés par cible. Donc la cible "w64" pourra avoir le projet "akagoria", et d'autre projets (nommés différemment), chacun avec son propre environnement séparé, car on ne veut pas mélanger les binaires de plusieurs projets indépendants en général.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

# crossroad

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Je crée mon jeu vidéo E14 : formats de données. Évalué à 3.

Cool de lire que tu utilises enfin crossroad, et apparemment avec succès! J'ai pas beaucoup de retours et ne savais pas si y avait vraiment des utilisateurs, hormis moi-même. N'hésite donc pas à faire des retours.

Aussi il y aura encore quelques changements de syntaxe de ligne de commande avec la prochaine version (qui arrivera quand je trouverai enfin le temps de finaliser le tout), car j'ai ajouté quelques paradigmes, notamment pour pouvoir travailler sur plusieurs projets en même temps, avec des environnements de cross-compilation indépendants.

Rien de terrible, ceci dit. :-)

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Non a YAML !

Posté par Jehan (site web personnel, Mastodon) . En réponse à la dépêche Je crée mon jeu vidéo E14 : formats de données. Évalué à 4.

Je suis d'accord pour dire que YAML est un format horrible. Pour un travail précédent où j'ai écrit un outil qui convertissait des fichiers de localisation (et il se trouve que certains logiciels localisent avec un format basé sur YAML), j'ai écrit un parseur basé sur la spéc. C'était franchement l'un des pires formats avec lequel j'ai eu à travailler. Aucune cohérence, 20000 façons de faire la même chose sémantiquement, des règles/exceptions super tarabiscotées. Même pour un humain, puisqu'il y a plusieurs façons de faire les mêmes choses, je suis persuadé que quand on se met à travailler en groupe avec ce format, on se retrouve avec des problèmes de compréhension de syntaxe.

Perso, je pense que XML reste un des meilleurs formats pour tout ce qui est automatisé (facile à parser par une machine, et facile à lire, donc débugguer par un humain en cas de problème); et pour tout ce qui est à éditer par un humain (fichiers de configuration pour un logiciel non-graphique par ex) ou pour des données vraiment simples et linéaires, de simples fichiers INI ou similaires vont parfaitement.

Json, c'est bien pour le web, où on essaie souvent d'optimiser le moindre bit. Mais pour des fichiers qui restent principalement sur la même machine, je lui préfère de loin XML. C'est beaucoup plus lisible.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]

[^] # Re: Métaphore du bureau

Posté par Jehan (site web personnel, Mastodon) . En réponse au journal Pourquoi on est bloqué, vers où on va peut-être pas. Évalué à 3.

Oui non c'est sûr, c'était une phrase idiote de ma part. À partir du moment où je gère mes papiers dans l'ordi, je laisse un système informatique gérer entièrement ces fichiers. Et bien d'autres choses peuvent foirer dans un ordi. Disons plutôt que je ne me sens confiant pour laisser un système informatique gérer mes fichiers que jusqu'à un certain niveau d'automatisation et d'abstraction.

Peut-être que cela changera, mais à l'heure actuelle je ne souhaite pas laisser l'ordi ranger pour moi les fichiers. Je pense que nous ne sommes pas encore à un stade où les IA sont suffisamment évolués pour le faire sans accroc (c'est à dire qu'ils le font peut-être déjà mieux que nous, mais quand ça foire, ça foire bien! Et ça c'est un gros problème).

Le niveau "système de fichiers" (+ sauvegardes évidemment, et en utilisant un système de fichiers bien rôdé, pas un truc expérimental, bien sûr) est à mon sens suffisamment stable et fiable à l'heure actuelle pour que je lui fasse confiance. Pas l'automatisation des tags par contre.

Film d'animation libre en CC by-sa/Art Libre, fait avec GIMP et autre logiciels libres: ZeMarmot [ http://film.zemarmot.net ]