ouin ouin utiliser WAF c’est pas sexiste je suis gentil,

Vu que c'est encore une attaque personnelle, faut il que je demande à ce que ton commentaire soit modéré ?

Je ne suis clairement pas quelqu'un de gentil, mais je ne suis pas sexiste. Et, tu ne sais pas mieux que moi ce que je pense. Je constate à regret que deux ans après ta tentative de lynchage à mon encontre tu en es toujours au même point.

tu vas encore me qualifier de paternaliste, mais je suis triste pour toi. J'espère sincèrement que tu arriveras à dépasser cet état de colère qui désert la cause noble que tu défends.

Quant à la modération, je ne trouve pas qu'ils soient laxiste. Il faut faire la part des choses entre ce qui est grossier, insultant, diffamant, ce qui peut être répréhensible devant la loi, d'une ligne éditoriale qui est hors de propos sur ce site dans les commentaires.

Ce n'était peut être pas très malin de ma part de te répondre, mais on est vendredi, alors j'ai le droit !

Où ai-je écrit que j'étais agacé, où j'ai écrit que je souhaitais faire un commentaire construit ?

Je note juste qu'ariasuni se plaint de chose qu'{il|elle} pratique également.

Va falloir vous de-stresser un peu, les gens ici ne sont pas des ennemis à pourfendre !

Il y a plein de gens qui ne sont pas d'accord entre eux, et qui s'invectivent plus ou moins subtilement et argumentent plus ou moins objectivement.

De plus qualifier mon commentaire d'agressif est clairement hors de propos.

Quand à se taire personne ne lui demande, il faut par contre accepter la contradiction et accepter d'être en position de minorité, ce que signifie faire preuve de pédagogie et pas d'agressivité. Je n'ai pas trouvé son message particulièrement bien veillant, ni le votre non plus.

Quant à la construction de mon assertion, elle est indiscutable, je ne vais pas en écrire 500 lignes pour vous faire plaisir, si l'évidence de ma remarque vous échappe, alors tant pis, c'est que vous n'avez pas compris pourquoi je faisais cette remarque. Je ne me place ici dans aucun camps, je constate juste que l'affecte domine et pourrit la discussion des deux cotés.

Votre commentaire est un exemple de réaction affective, il n'y a rien de répréhensible à écrire ce qui ne partagent pas vos avis écrivent, il n'y a pas d'attaque personnelle. Par contre vos réactions sont agressives, la colère n'a rien d'illégitime mais malheureusement en France, celui qui s'énerve a perdu …

Les gens ont le droit de ne pas vouloir de l'écriture inclusive, ce n'est pas illégal. Il est vrai que les règles d'accord ne sont pas gravées mais là on parle de complexifier grandement la lecture de texte et de ne pas être en mesure de l'oraliser …

Il est normal que des gens trouve cela trop contraignant, ce n'est pas mon cas. Il est normal que des gens n'aiment pas les pratiques de la communauté de ce jeu met en oeuvre.

En bref, redescendez, ça devient pénible à la longue. Faites des journaux sur vos combats bien argumentés et réellement informatif, mais systématiquement se plaindre des membres de ce site … Pourquoi y rester ?

Non, malheureusement non. De plus avec Texmaths une fois la formule copiée dans Impress, il n'est plus possible de l'éditer. C'est devenu un graphique SVG géré avec SVGIO, je pense (à vérifier il y a deux modes d'import de SVG dans LibreOffice, un avec SVGIO qui respecte au maximum la mise en forme et un natif qui essaye de traduire en odf).

Par contre il est tout à fait possible d'importer des objets OLE comme des textes. Ainsi tu profites de tout ce que peut faire writer. Les formules . Il est possible d'insérer des object OLE à partir de fichiers et de lier les fichiers. Ainsi tu peux bosser avec un writer mis en forme pour tes textes avec équations et recharger ton fichier odp lorsque tu as finis de modifier ton texte.

C'est très fastidieux mais c'est le seul moyen de répondre positivement à ta demande !

Si tu t'es fait une slide mairesse adaptée à cet exercice et que tu t'es fait un modèle writer adapté, tu peux t'en sortir honorablement, mais c'est bien moins simple que beamer … c'est clair.

Pour moi la meilleur amélioration c'est l'export des pdf avec vidéos. On l'attendaient depuis 10ans. finis les beamer-fans qui disent oui, ton truc c'est pourri moi avec beamer j'ai les vidéos en pdf !

Un argument de moins pour beamer. Il ne resterait plus qu'à pouvoir avoir une hiérarchie complète pour gérer des en-tête avec champs de titre et sous titres comme sous beamer et ça serait parfait !

C'est vraiment impressionnant le progrès fait en quelques années, chapeau bas

Ce qui m'embête le plus avec Impress, c'est la lourdeur du résultat final: ça a du mal à passer sur des ordinateurs pas très puissants.

Et bien en fait cela existe, et ça s'appelle l'export pdf

Depuis la version 5.4 l'export pdf inclue les vidéos. Si tu couples ça à l'extension expand animation, alors tu gardes 90% de ce que tu peux faire dans tes présentations. Les animation ne seront que des apparitions instantanées mais seront conservées, les vidéos présentes. tu peux régler la résolution des images lors de l'export par contre pour la vidéo c'est à toi de gérer (mencoder, ffmpeg, avidemux, sont tes amis).

J'aurai vraiment aimé pouvoir exporter le travail dans un format plus léger, comme une animation svg

Le svg n'est pas léger et n'est pas vraiment optimisé pour gérer des pages. C'est une mauvaise idée de l'utiliser dans ce contexte. Autant c'est très bien pour des présentations de type Sozi, autant pour des slides, j'ai des doutes, car firefox met généralement tout en mémoire au chargement du SVG, cela peut donc vite mettre à genou une petite configuration. Je rappelle également qu'il n'y a pas bijection entre SVG/odg donc il y a des pertes et même si c'est également le cas pour le pdf, l'export est optimisé pour le rendu visuel. Il est important de noter que LibreOffice a beaucoup progressé sur la prise en compte des gradient de texture lors des exports, mais il reste encore du chemin à faire.

Ou avoir un lecteur de diapo spécialisé dans la lecture, et qui le fasse bien.

Ça marche avec Okular et evince, donc c'est du standard de chez standard.

Que veux tu de plus ?

Après pas mal d'années à geeker avec Sozi/Beamer, j'ai fini par retourner vers impress.

Lorsque je fais une présentation j'ai besoin de pouvoir exprimer la causalité graphiquement, et de ce fait le WYSIWYG est vraiment un outil indispensable. Je conçois que pour certain la causalité puisse s'énoncer par écrit, mais personnellement le faire graphiquement me fait gagner du temps sur mes présentations et évite de faire trop lire l'auditeur. Je trouve ainsi que l'auditeur est plus attentif à ce que je dis.

C'est sûr que cela dépend beaucoup du domaine mais lorsque l'on présente beaucoup de cartes de champs scalaires, des manips et du code pour faire tourner ces manips, c'est mieux d'avoir un support graphique. Il est clair que pour ceux qui déroulent des algos, cette problématique est peut être moins dominante.

Alors certes, il est toujours possible d'inclure des figures, mais s'il faut mettre plus d'une figure dans une slide alors il deveint assez fastidieux de faire les alignements proprement dans les outils WYSIWYM. Les doctorants que j'encadre qui ont fait leur présentation de thèse en Beamer étaient très chiant lorsqu'on leur demandait de faire des modifications car cela leur prenait un temps considérable.

Au final, il faisaient des figures énormes dans inkscape et ils les exportaient en pdf, il avaient des présentations de 100Mo et avaient peur d'y retoucher …

Pendant un temps j'ai utilisé Sozi, mais là c'est l'inverse, il faut tout faire soit même ! Aucun formatage n'est prévu ! Cela m'a amusé un temps, car le résultat est très original, mais le fait que cela dans un temps un plugin d'inkscape rendait l'édition des animation hyper-lourde et le fait qu'après l'animation soit décorrélée de l'édition obligeait à de multiples aller/retours pénibles.

Au final aujourd'hui je fais mes présentations avec impress et ce n'est pas si mal. Il me manque clairement des choses :

* contrôle des vidéos dans le slideshow,

* hiérarchisation des titres et sous titres pour pouvoir faire un menu automatique à la Beamer.

Mais il existe aujourd'hui des fonctionnalités qui sont vraiment très cool :

* Import pdf de qualité

* Import SVG grandement amélioré

* Export de pdf avec vidéos,

* Extension pour exploser les animation pour les exports pdf,

* Extension pour rentrer ses équations en avec équations exportées en SVG et toujours éditables.

De plus de il est possible de travailler avec Draw qui permet de faire de supers diagrammes connectés, donc que l'on peut modifier facilement sans perdre les flèches.

Pour avoir plusieurs collègues qui bossent sur PowerPoint, il est clair que sur pas mal de points il est bien moins ergonomique, mais au final en combinant les outils on peut faire des choses bien sympa.

Par contre cela demande un investissement pour faire les choses proprement, il faut avoir son template, il faut apprendre à utiliser les bonnes fonctions pour rendre son travail réutilisable, il est clair que pour quelqu'un qui veut juste utiliser des listes et montrer quelques images, qui connait Beamer ou Markdown, cela peut être pénible d'avoir à se former à cette usine à clics. Pour ceux dont les présentations font partie intégrante des livrables de leurs travail, cela reste le plus polyvalent en OpenSource.

ok, je pensais qu'avec la mode des ROM (reduced order model) qui permettent justement la simulation en temps-réel, cela serait possible.

En théorie cela est possible, mais 99% de ces méthodes (PGD,POD, SuperElement, …) sont aujourd'hui adaptées à l'élasticité linéaire ce qui est très rarement ce que l'on a besoin de simuler. Donc au final on ne peut pas les utiliser.

Dans l'absolu, l'idée peut sembler intéressante mais c'est souvent assez compliqué car cela dépend beaucoup des objectifs de chacun.

Par exemple je peux te parler des simulateurs biomédicaux de déformation, car je travaille dessus. Nous avons collaboré avec une équipe qui travaillait plutôt avec des outils comme blender et codait son propre environnement de simulation mais leurs objectifs étaient vraiment différents des autres. Il voulaient avoir quelque chose de "réaliste" qui ressemble à la réalité mais qui soit en temps réel, alors que nous avons besoin de code dont nous maîtrisons les erreurs et notre contrainte à cette époque était la simulabilité du calcul pour avoir les résultats les plus exactes possibles si le calcul prenait une journée ce n'était pas grave.

Leur code bien que basé sur les mêmes théories ne permettait pas d'augmenter le nombre d'éléments dans le maillage car cela n'aurait pas permis le temps réel et donc en dehors de leurs préoccupations. La manière de découper les concepts mathématiques sous-jacent n'étaient pas celle que nous utilisions, il nous était donc impossible d'apporter notre expertise.

Il faut bien comprendre que ces outils sont des outils d'experts dont l'objectif et de pouvoir prédire de manière la plus fine possible les risques de défaillance (ici les risques sur les centrales nucléaires), une attention toute particulière est donc apportée à l'évaluation des erreurs et la possibilité d'augmenter la finesse des maillages. Ainsi les outils développés sont plutôt de nature à aller attaquer des cluster de calculs plutôt que de faire des simulations multi-physique sur ton PC.

Malheureusement simplifier l'accès est nécessaire mais ne change rien au fait qu'avoir les connaissances pour évaluer une simulation dans différentes physique nécessite la compréhension de ces physiques. Tout les calculs sont basés sur des approximations et modèles et qui doivent être compris ainsi que leur limites intégrées par leurs utilisateurs.

Après pour les simus dans blender en vu de rendu réaliste, le talents des gens qui font les moteurs de rendu est d'intégrer des équations aux dérivées partielles et ordinaires adaptées au rendu, d'avoir des modèles de collision "réaliste" et le tout dans une temps compatible avec la génération d'une séquence temporelle extrêmement longue, autant dire que le travail de développeur de moteur de rendu n'est pas prêt d'être remplacé par celui des scientifiques des edp.

Je ne connais Sozi que de nom.

Du coup, j'ai installé et vois que c'est également un beau projet.

J'ai pas suffisamment de recul pour dire si on marche sur les mêmes plate-bandes.

La dernière version ne dépend plus de inkscape, elle utilise le navigateur pour construire le diaporama et donc des technos web.

Pour une version 2.0, j'ai déjà noté la possibilité de rajouter des vidéos et du son.

Néanmoins, ça nécessitera de revoir le fichier produit (un zip ou zim) : pour les images, je triche en convertissant en base64.

Pour du svg, c'est moins compliqué : j'en prend note pour une version intermédiaire.

Ça serait vraiment cool et intéressant ! Postes sur linuxfr lorsque tu auras ces possibilités et je me ferais un plaisir de tester intensément ton logiciel !

Code_Aster est le code OpenSource de FEM orienté mécanique le plus complet, il est réalisé par des chercheurs et ingénieurs dans un esprit de collaboration assez rare dans le milieu académique.

Ton introduction est très intéressante car tu mets les "mains dans le cambouis", il est possible aujourd'hui de faire une simulation complexe à l'intérieur de Salome-Méca sans éditer manuelement des fichiers textes, cela se rapproche plus de ce que les étudiants en méca connaissent, avec des plateformes comme Abaqus ou ANSYS. La nouvelle mouture intégrée de Salome-Meca étant encore jeune, il n'y a pas encore profusion de supports mais on peut tout de même noter l'apparition de plusieurs tutoriels vidéos assez intéressant (n'ayant pas trop besoin je ne les ai que parcouru). A noter également la chaîne de Code_Aster avec des choses assez intéressantes comme des études de sensibilité.

Il a conçu une tête d'impression OpenSource HardWare permettant d'utiliser des granulé ou du plastique broyé. Il a aussi conçu une broyeuse de table.

La tête qu'il a conçu pourra se mettre à terme sur n'importe quelle imprimante et coûtera moins de 300€.

Il a fait un vrai travail sérieux, il a dimensionné proprement la vis d'archimède adaptée à l'extrusion et a déjà des démonstrateurs très sérieux sur youtube.

Dès qu'il les distribue, on achète !!

De notre cotés, on essaye de reprendre le principe de sa conception en remettant tout sous OnShape de manière à pouvoir avoir des formes paramétrique. Ce n'est pas moi qui le fait (je suis une quiche en DAO), donc ça ne sera pas sous FreeCAD.

On espère pouvoir en créer une en Q1 2018.

Lorsque l'on aura quelque chose de présentable je ferais une dépêche !

Pour moi cela ne répond pas au même problème. Le calcul scientifique utilise assez souvent scipy et celui-ci n'est pas compatible avec pypy de ce que j'en avais compris. De plus ils ré-implémentent la bibliothèque numpy qui n'est pas encore complète. Je pense que lorsque tu as protoypé un code, qu'il fonctionne avec les bibliothèques que tu as choisi et qui font une grande partie du travail, passer en pypy demande un gros boulot comparativement à pythran ou numba (anaconda accelerate) qui est d'ailleurs depuis juillet totalement opensource

On July 27, 2017, Accelerate was split into the Intel Distribution for Python and the open source Numba project’s sub-projects pyculib, pyculib_sorting and data_profiler. Numba and all its sub-projects are available under a BSD license.

et permet de de compiler des fonctions directement pour cuda !

C'est très louable de vouloir réimplémenter un interpréteur python mais ce n'est pas ce que souhaite faire un scientifique lorsqu'il veut accélérer son code. Des solutions simples telles que celles qui seront présentées sont vraiment intéressantes.

Serge, serait il possible de mettre en place cette formation ailleurs ? Nous pourrions être intéressé sur Lille par exemple.

Il me reste la partie trois de ma série d'articles à faire, serais tu d'accord pour que j'intègre ce journal comme application de ton logiciel présenté dans la précédente dépêche ?

Toute cette partie :

ncview netcdf-bin python-matplotlib python-netcdf4 python-numpy python-scipy dvipng texlive-full ghostscript ghostscript

est pour le post traitement en python, la partie texlive-full est très lourde et elle permet juste de pouvoir afficher du code latex dans matplotlib, je pense qu'il ne vaut mieux pas la mettre dans une image docker …

Étant donné que l'on ne va plus développer sur cette base mais que le soft n'a pas vraiment d'équivalent sur les aspects traitement 3D, pouvoir le conserver fonctionnel avec Docker me semble un bon moyen de ne plus jamais avoir à gérer les changements de distribution !

Et bien écoute, si c'était si simple, peut être que je ne posterais pas ici, non ?

J'ai essayé de voir avec cmake et les tutos de base, mais cela ne marche pas et les messages de compilation sont tout sauf simple. Donc oui utiliser un conteneur peut être plus simple pour moi que de refaire la chaine de compilation avec mon niveau en ingénierie logicielle. Alors tu as le droit de penser que c'est regrettable mais c'est comme ça. Je saurais le faire rapidement avec une virtualbox mais j'ai trouvé que c'était moins élégant qu'avec docker.

De plus, bien souvent lorsque tu compiles en statique, il reste des libs qui ne le sont pas et dont le numéro change. Il faut ainsi faire des liens symboliques qui des foi résolvent les problèmes mais d'autres fois engendrent une erreur au niveau de l'ABI. Donc, ce n'est pas un sujet si simple que ça …

Avec une image docker, je suis certain que même dans 5 ans mon image fonctionnera encore. Cela me semble être un bon moyen de figer un logiciel, non ?

Après si tu sais m'expliquer comment passer le CMakeList en version statique, je serais très heureux d'essayer.

[^] # Re: Super projet, réactions ridicules

Posté par freejeff . En réponse à la dépêche Khaganat, des stands et des avancées. Évalué à 1.

Vu que c'est encore une attaque personnelle, faut il que je demande à ce que ton commentaire soit modéré ?

Je ne suis clairement pas quelqu'un de gentil, mais je ne suis pas sexiste. Et, tu ne sais pas mieux que moi ce que je pense. Je constate à regret que deux ans après ta tentative de lynchage à mon encontre tu en es toujours au même point.

tu vas encore me qualifier de paternaliste, mais je suis triste pour toi. J'espère sincèrement que tu arriveras à dépasser cet état de colère qui désert la cause noble que tu défends.

Quant à la modération, je ne trouve pas qu'ils soient laxiste. Il faut faire la part des choses entre ce qui est grossier, insultant, diffamant, ce qui peut être répréhensible devant la loi, d'une ligne éditoriale qui est hors de propos sur ce site dans les commentaires.

Ce n'était peut être pas très malin de ma part de te répondre, mais on est vendredi, alors j'ai le droit !

[^] # Re: Super projet, réactions ridicules

Posté par freejeff . En réponse à la dépêche Khaganat, des stands et des avancées. Évalué à 5.

Où ai-je écrit que j'étais agacé, où j'ai écrit que je souhaitais faire un commentaire construit ?

Je note juste qu'ariasuni se plaint de chose qu'{il|elle} pratique également.

Va falloir vous de-stresser un peu, les gens ici ne sont pas des ennemis à pourfendre !

Il y a plein de gens qui ne sont pas d'accord entre eux, et qui s'invectivent plus ou moins subtilement et argumentent plus ou moins objectivement.

De plus qualifier mon commentaire d'agressif est clairement hors de propos.

Quand à se taire personne ne lui demande, il faut par contre accepter la contradiction et accepter d'être en position de minorité, ce que signifie faire preuve de pédagogie et pas d'agressivité. Je n'ai pas trouvé son message particulièrement bien veillant, ni le votre non plus.

Quant à la construction de mon assertion, elle est indiscutable, je ne vais pas en écrire 500 lignes pour vous faire plaisir, si l'évidence de ma remarque vous échappe, alors tant pis, c'est que vous n'avez pas compris pourquoi je faisais cette remarque. Je ne me place ici dans aucun camps, je constate juste que l'affecte domine et pourrit la discussion des deux cotés.

Votre commentaire est un exemple de réaction affective, il n'y a rien de répréhensible à écrire ce qui ne partagent pas vos avis écrivent, il n'y a pas d'attaque personnelle. Par contre vos réactions sont agressives, la colère n'a rien d'illégitime mais malheureusement en France, celui qui s'énerve a perdu …

Les gens ont le droit de ne pas vouloir de l'écriture inclusive, ce n'est pas illégal. Il est vrai que les règles d'accord ne sont pas gravées mais là on parle de complexifier grandement la lecture de texte et de ne pas être en mesure de l'oraliser …

Il est normal que des gens trouve cela trop contraignant, ce n'est pas mon cas. Il est normal que des gens n'aiment pas les pratiques de la communauté de ce jeu met en oeuvre.

En bref, redescendez, ça devient pénible à la longue. Faites des journaux sur vos combats bien argumentés et réellement informatif, mais systématiquement se plaindre des membres de ce site … Pourquoi y rester ?

[^] # Re: Super projet, réactions ridicules

Posté par freejeff . En réponse à la dépêche Khaganat, des stands et des avancées. Évalué à 4.

C'est sur que ton commentaire est très construit et que tu parles du fond de l'article, la paille et la poutre …

[^] # Re: Pdf avec Vidéos

Posté par freejeff . En réponse à la dépêche LibreOffice 5.4.5. Évalué à 3.

Non, malheureusement non. De plus avec Texmaths une fois la formule copiée dans Impress, il n'est plus possible de l'éditer. C'est devenu un graphique SVG géré avec SVGIO, je pense (à vérifier il y a deux modes d'import de SVG dans LibreOffice, un avec SVGIO qui respecte au maximum la mise en forme et un natif qui essaye de traduire en odf).

Par contre il est tout à fait possible d'importer des objets OLE comme des textes. Ainsi tu profites de tout ce que peut faire writer. Les formules . Il est possible d'insérer des object OLE à partir de fichiers et de lier les fichiers. Ainsi tu peux bosser avec un writer mis en forme pour tes textes avec équations et recharger ton fichier odp lorsque tu as finis de modifier ton texte.

. Il est possible d'insérer des object OLE à partir de fichiers et de lier les fichiers. Ainsi tu peux bosser avec un writer mis en forme pour tes textes avec équations et recharger ton fichier odp lorsque tu as finis de modifier ton texte.

C'est très fastidieux mais c'est le seul moyen de répondre positivement à ta demande !

Si tu t'es fait une slide mairesse adaptée à cet exercice et que tu t'es fait un modèle writer adapté, tu peux t'en sortir honorablement, mais c'est bien moins simple que beamer … c'est clair.

# Pdf avec Vidéos

Posté par freejeff . En réponse à la dépêche LibreOffice 5.4.5. Évalué à 6.

Pour moi la meilleur amélioration c'est l'export des pdf avec vidéos. On l'attendaient depuis 10ans. finis les beamer-fans qui disent oui, ton truc c'est pourri moi avec beamer j'ai les vidéos en pdf !

Un argument de moins pour beamer. Il ne resterait plus qu'à pouvoir avoir une hiérarchie complète pour gérer des en-tête avec champs de titre et sous titres comme sous beamer et ça serait parfait !

C'est vraiment impressionnant le progrès fait en quelques années, chapeau bas

[^] # Re: Séparation contenu/forme pour une présentation ?

Posté par freejeff . En réponse au journal 'Markdown presentation processor' (ou de l'intérêt des fichiers texte).. Évalué à 4.

Et bien en fait cela existe, et ça s'appelle l'export pdf

Depuis la version 5.4 l'export pdf inclue les vidéos. Si tu couples ça à l'extension expand animation, alors tu gardes 90% de ce que tu peux faire dans tes présentations. Les animation ne seront que des apparitions instantanées mais seront conservées, les vidéos présentes. tu peux régler la résolution des images lors de l'export par contre pour la vidéo c'est à toi de gérer (mencoder, ffmpeg, avidemux, sont tes amis).

Le svg n'est pas léger et n'est pas vraiment optimisé pour gérer des pages. C'est une mauvaise idée de l'utiliser dans ce contexte. Autant c'est très bien pour des présentations de type Sozi, autant pour des slides, j'ai des doutes, car firefox met généralement tout en mémoire au chargement du SVG, cela peut donc vite mettre à genou une petite configuration. Je rappelle également qu'il n'y a pas bijection entre SVG/odg donc il y a des pertes et même si c'est également le cas pour le pdf, l'export est optimisé pour le rendu visuel. Il est important de noter que LibreOffice a beaucoup progressé sur la prise en compte des gradient de texture lors des exports, mais il reste encore du chemin à faire.

Ça marche avec Okular et evince, donc c'est du standard de chez standard.

Que veux tu de plus ?

# Séparation contenu/forme pour une présentation ?

Posté par freejeff . En réponse au journal 'Markdown presentation processor' (ou de l'intérêt des fichiers texte).. Évalué à 10.

Après pas mal d'années à geeker avec Sozi/Beamer, j'ai fini par retourner vers impress.

Lorsque je fais une présentation j'ai besoin de pouvoir exprimer la causalité graphiquement, et de ce fait le WYSIWYG est vraiment un outil indispensable. Je conçois que pour certain la causalité puisse s'énoncer par écrit, mais personnellement le faire graphiquement me fait gagner du temps sur mes présentations et évite de faire trop lire l'auditeur. Je trouve ainsi que l'auditeur est plus attentif à ce que je dis.

C'est sûr que cela dépend beaucoup du domaine mais lorsque l'on présente beaucoup de cartes de champs scalaires, des manips et du code pour faire tourner ces manips, c'est mieux d'avoir un support graphique. Il est clair que pour ceux qui déroulent des algos, cette problématique est peut être moins dominante.

Alors certes, il est toujours possible d'inclure des figures, mais s'il faut mettre plus d'une figure dans une slide alors il deveint assez fastidieux de faire les alignements proprement dans les outils WYSIWYM. Les doctorants que j'encadre qui ont fait leur présentation de thèse en Beamer étaient très chiant lorsqu'on leur demandait de faire des modifications car cela leur prenait un temps considérable.

Au final, il faisaient des figures énormes dans inkscape et ils les exportaient en pdf, il avaient des présentations de 100Mo et avaient peur d'y retoucher …

Pendant un temps j'ai utilisé Sozi, mais là c'est l'inverse, il faut tout faire soit même ! Aucun formatage n'est prévu ! Cela m'a amusé un temps, car le résultat est très original, mais le fait que cela dans un temps un plugin d'inkscape rendait l'édition des animation hyper-lourde et le fait qu'après l'animation soit décorrélée de l'édition obligeait à de multiples aller/retours pénibles.

Au final aujourd'hui je fais mes présentations avec impress et ce n'est pas si mal. Il me manque clairement des choses :

* contrôle des vidéos dans le slideshow,

* hiérarchisation des titres et sous titres pour pouvoir faire un menu automatique à la Beamer.

Mais il existe aujourd'hui des fonctionnalités qui sont vraiment très cool : avec équations exportées en SVG et toujours éditables.

avec équations exportées en SVG et toujours éditables.

* Import pdf de qualité

* Import SVG grandement amélioré

* Export de pdf avec vidéos,

* Extension pour exploser les animation pour les exports pdf,

* Extension pour rentrer ses équations en

De plus de il est possible de travailler avec Draw qui permet de faire de supers diagrammes connectés, donc que l'on peut modifier facilement sans perdre les flèches.

Pour avoir plusieurs collègues qui bossent sur PowerPoint, il est clair que sur pas mal de points il est bien moins ergonomique, mais au final en combinant les outils on peut faire des choses bien sympa.

Par contre cela demande un investissement pour faire les choses proprement, il faut avoir son template, il faut apprendre à utiliser les bonnes fonctions pour rendre son travail réutilisable, il est clair que pour quelqu'un qui veut juste utiliser des listes et montrer quelques images, qui connait Beamer ou Markdown, cela peut être pénible d'avoir à se former à cette usine à clics. Pour ceux dont les présentations font partie intégrante des livrables de leurs travail, cela reste le plus polyvalent en OpenSource.

[^] # Re: Super article

Posté par freejeff . En réponse à la dépêche Tutoriel Code_Aster. Évalué à 3.

En théorie cela est possible, mais 99% de ces méthodes (PGD,POD, SuperElement, …) sont aujourd'hui adaptées à l'élasticité linéaire ce qui est très rarement ce que l'on a besoin de simuler. Donc au final on ne peut pas les utiliser.

[^] # Re: Super article

Posté par freejeff . En réponse à la dépêche Tutoriel Code_Aster. Évalué à 7.

Dans l'absolu, l'idée peut sembler intéressante mais c'est souvent assez compliqué car cela dépend beaucoup des objectifs de chacun.

Par exemple je peux te parler des simulateurs biomédicaux de déformation, car je travaille dessus. Nous avons collaboré avec une équipe qui travaillait plutôt avec des outils comme blender et codait son propre environnement de simulation mais leurs objectifs étaient vraiment différents des autres. Il voulaient avoir quelque chose de "réaliste" qui ressemble à la réalité mais qui soit en temps réel, alors que nous avons besoin de code dont nous maîtrisons les erreurs et notre contrainte à cette époque était la simulabilité du calcul pour avoir les résultats les plus exactes possibles si le calcul prenait une journée ce n'était pas grave.

Leur code bien que basé sur les mêmes théories ne permettait pas d'augmenter le nombre d'éléments dans le maillage car cela n'aurait pas permis le temps réel et donc en dehors de leurs préoccupations. La manière de découper les concepts mathématiques sous-jacent n'étaient pas celle que nous utilisions, il nous était donc impossible d'apporter notre expertise.

Il faut bien comprendre que ces outils sont des outils d'experts dont l'objectif et de pouvoir prédire de manière la plus fine possible les risques de défaillance (ici les risques sur les centrales nucléaires), une attention toute particulière est donc apportée à l'évaluation des erreurs et la possibilité d'augmenter la finesse des maillages. Ainsi les outils développés sont plutôt de nature à aller attaquer des cluster de calculs plutôt que de faire des simulations multi-physique sur ton PC.

Malheureusement simplifier l'accès est nécessaire mais ne change rien au fait qu'avoir les connaissances pour évaluer une simulation dans différentes physique nécessite la compréhension de ces physiques. Tout les calculs sont basés sur des approximations et modèles et qui doivent être compris ainsi que leur limites intégrées par leurs utilisateurs.

Après pour les simus dans blender en vu de rendu réaliste, le talents des gens qui font les moteurs de rendu est d'intégrer des équations aux dérivées partielles et ordinaires adaptées au rendu, d'avoir des modèles de collision "réaliste" et le tout dans une temps compatible avec la génération d'une séquence temporelle extrêmement longue, autant dire que le travail de développeur de moteur de rendu n'est pas prêt d'être remplacé par celui des scientifiques des edp.

[^] # Re: quelques réponses

Posté par freejeff . En réponse au journal Editeur de SVG Interactif. Évalué à 2.

La dernière version ne dépend plus de inkscape, elle utilise le navigateur pour construire le diaporama et donc des technos web.

Ça serait vraiment cool et intéressant ! Postes sur linuxfr lorsque tu auras ces possibilités et je me ferais un plaisir de tester intensément ton logiciel !

# Bien Sympa

Posté par freejeff . En réponse au journal Editeur de SVG Interactif. Évalué à 4.

Le résultat est bien sympa !

Comment tu le positionnes par rapport à Sozi ? Cela pourrait il être complémentaire ?

Pourrais tu faire apparaître des objet svg dans les zones de texte ?

# Super article

Posté par freejeff . En réponse à la dépêche Tutoriel Code_Aster. Évalué à 10.

Code_Aster est le code OpenSource de FEM orienté mécanique le plus complet, il est réalisé par des chercheurs et ingénieurs dans un esprit de collaboration assez rare dans le milieu académique.

Ton introduction est très intéressante car tu mets les "mains dans le cambouis", il est possible aujourd'hui de faire une simulation complexe à l'intérieur de Salome-Méca sans éditer manuelement des fichiers textes, cela se rapproche plus de ce que les étudiants en méca connaissent, avec des plateformes comme Abaqus ou ANSYS. La nouvelle mouture intégrée de Salome-Meca étant encore jeune, il n'y a pas encore profusion de supports mais on peut tout de même noter l'apparition de plusieurs tutoriels vidéos assez intéressant (n'ayant pas trop besoin je ne les ai que parcouru). A noter également la chaîne de Code_Aster avec des choses assez intéressantes comme des études de sensibilité.

Vive la mécanique libre !

[^] # Re: Quelle(s) solution(s) pour les "déchets" ?

Posté par freejeff . En réponse au journal J'ai acheté une imprimante 3D (presque open source) à 150€. Évalué à 8.

Il y a ce type qui est vraiment impressionnant :

http://www.mahor.xyz/

Il a conçu une tête d'impression OpenSource HardWare permettant d'utiliser des granulé ou du plastique broyé. Il a aussi conçu une broyeuse de table.

La tête qu'il a conçu pourra se mettre à terme sur n'importe quelle imprimante et coûtera moins de 300€.

Il a fait un vrai travail sérieux, il a dimensionné proprement la vis d'archimède adaptée à l'extrusion et a déjà des démonstrateurs très sérieux sur youtube.

Dès qu'il les distribue, on achète !!

De notre cotés, on essaye de reprendre le principe de sa conception en remettant tout sous OnShape de manière à pouvoir avoir des formes paramétrique. Ce n'est pas moi qui le fait (je suis une quiche en DAO), donc ça ne sera pas sous FreeCAD.

On espère pouvoir en créer une en Q1 2018.

Lorsque l'on aura quelque chose de présentable je ferais une dépêche !

[^] # Re: Sinon sur ubuntu

Posté par freejeff . En réponse au journal Parceque l'on peut aussi rigoler de la pomme. Évalué à 3.

C'est un peu pénible …, ce n'est pas parce que ça ne fonctionne pas chez toi que ça ne fonctionne pas chez les autres …

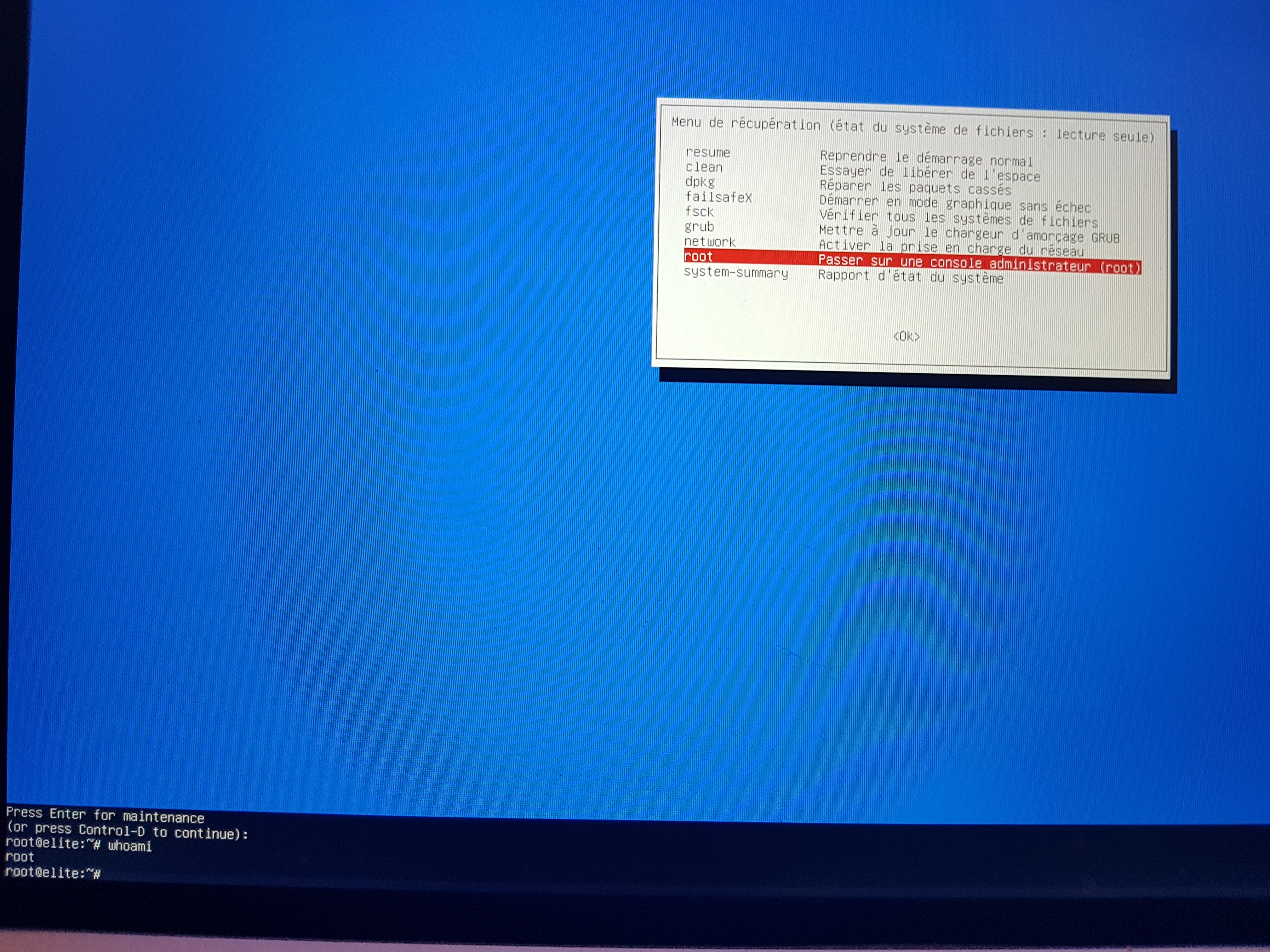

J'arrive à ça après avoir activé le noyau courant en mode recovery

Si je tape entrée, j'arrive ici

Essayé sur 4 PC en 16.04, 17.04, 17.10 et ça marche à chaque fois, c'est donc peut être toi qui a fait quelque chose de particulier sur ta distrib.

Si quelqu'un d'autre veut bien essayer …

Perso, ça me semble aussi simple que mac mais ça n'est pas corrigé ni même considéré comme une faille …

Alors libre à toi de me croire ou non, mais ce n'est pas un bug et non je ne l'ai pas rêvé.

[^] # Re: Sinon sur ubuntu

Posté par freejeff . En réponse au journal Parceque l'on peut aussi rigoler de la pomme. Évalué à 2.

Je connaissais aussi le init=/bin/bash

mais chez Ubuntu c'est une option installée par défaut pas un hack, je l'ai re-testé hier et il n'y a pas besoin de mot de passe …

# Sinon sur ubuntu

Posté par freejeff . En réponse au journal Parceque l'on peut aussi rigoler de la pomme. Évalué à 0.

flêche du bas au démarage pour activer le menu dans le grub

lancer un mode recovery

on arrive sur un petit menu qui nous propose une console root …

et ce n'est pas un bug mais une feature !

la poutre tout ça …

[^] # Re: pypy

Posté par freejeff . En réponse au journal Formation à Lyon : Compilateurs pour le Python Scientifique. Évalué à 4.

Pour moi cela ne répond pas au même problème. Le calcul scientifique utilise assez souvent scipy et celui-ci n'est pas compatible avec pypy de ce que j'en avais compris. De plus ils ré-implémentent la bibliothèque numpy qui n'est pas encore complète. Je pense que lorsque tu as protoypé un code, qu'il fonctionne avec les bibliothèques que tu as choisi et qui font une grande partie du travail, passer en pypy demande un gros boulot comparativement à pythran ou numba (anaconda accelerate) qui est d'ailleurs depuis juillet totalement opensource

et permet de de compiler des fonctions directement pour cuda !

C'est très louable de vouloir réimplémenter un interpréteur python mais ce n'est pas ce que souhaite faire un scientifique lorsqu'il veut accélérer son code. Des solutions simples telles que celles qui seront présentées sont vraiment intéressantes.

Serge, serait il possible de mettre en place cette formation ailleurs ? Nous pourrions être intéressé sur Lille par exemple.

[^] # Re: et bien fait le

Posté par freejeff . En réponse au message Empaqueter une appli dans docker. Évalué à 2.

Donc en gros, il ne reste que la machine virtuelle, c'est ça ?

# Super Cool !

Posté par freejeff . En réponse au journal Mechamatic de la méca pour tous !. Évalué à 3.

C'est vraiment une super initiative bravo !

Il me reste la partie trois de ma série d'articles à faire, serais tu d'accord pour que j'intègre ce journal comme application de ton logiciel présenté dans la précédente dépêche ?

[^] # Re: Oui ?

Posté par freejeff . En réponse au message Empaqueter une appli dans docker. Évalué à 3.

Pour la liste de dépendances :

apt-get install -qy build-essential cmake gcc-4.9-base gfortran imagemagick lib64gomp* libatlas3-base libatlas-dev liblapack-dev libc6 libfftw3-dev libgcc1 libgraphicsmagick++1-dev libnetcdf-dev libnetcdf-c++4 libnetcdf-c++4-dev libnetcdf-cxx-legacy-dev libtiff5-dev wget unzip

fait le job sur une ubuntu vierge dans un conteneur docker.

ensuite je crée un répertoire dans le home YaDICs.

je dezippe dans ce répertoire,

je vais dans : ./YaDICs_V04.14.a/build/

je fais un cmake ../

puis un make et ça marche.

Par contre, je ne sais pas comment sauver l'état du conteneur, ni lui faire accéder aux répertoires du pc hôte.

[^] # Re: Oui ?

Posté par freejeff . En réponse au message Empaqueter une appli dans docker. Évalué à 2.

Toute cette partie :

ncview netcdf-bin python-matplotlib python-netcdf4 python-numpy python-scipy dvipng texlive-full ghostscript ghostscript

est pour le post traitement en python, la partie texlive-full est très lourde et elle permet juste de pouvoir afficher du code latex dans matplotlib, je pense qu'il ne vaut mieux pas la mettre dans une image docker …

[^] # Re: et bien fait le

Posté par freejeff . En réponse au message Empaqueter une appli dans docker. Évalué à 2.

D'où l'intérêt de docker non ?

Étant donné que l'on ne va plus développer sur cette base mais que le soft n'a pas vraiment d'équivalent sur les aspects traitement 3D, pouvoir le conserver fonctionnel avec Docker me semble un bon moyen de ne plus jamais avoir à gérer les changements de distribution !

[^] # Re: Oui ?

Posté par freejeff . En réponse au message Empaqueter une appli dans docker. Évalué à 2.

Salut,

Merci beaucoup pour l'essai !!

Ca fonctionne sous Ubuntu 16.04, la dernière LTS.

Sur la 14.04 le paquet libnetcdf-cxx-legacy-dev n'était pas nécessaire.

[^] # Re: et bien fait le

Posté par freejeff . En réponse au message Empaqueter une appli dans docker. Évalué à 3.

Et bien écoute, si c'était si simple, peut être que je ne posterais pas ici, non ?

J'ai essayé de voir avec cmake et les tutos de base, mais cela ne marche pas et les messages de compilation sont tout sauf simple. Donc oui utiliser un conteneur peut être plus simple pour moi que de refaire la chaine de compilation avec mon niveau en ingénierie logicielle. Alors tu as le droit de penser que c'est regrettable mais c'est comme ça. Je saurais le faire rapidement avec une virtualbox mais j'ai trouvé que c'était moins élégant qu'avec docker.

De plus, bien souvent lorsque tu compiles en statique, il reste des libs qui ne le sont pas et dont le numéro change. Il faut ainsi faire des liens symboliques qui des foi résolvent les problèmes mais d'autres fois engendrent une erreur au niveau de l'ABI. Donc, ce n'est pas un sujet si simple que ça …

Avec une image docker, je suis certain que même dans 5 ans mon image fonctionnera encore. Cela me semble être un bon moyen de figer un logiciel, non ?

Après si tu sais m'expliquer comment passer le CMakeList en version statique, je serais très heureux d'essayer.

[^] # Re: et bien fait le

Posté par freejeff . En réponse au message Empaqueter une appli dans docker. Évalué à 3.

Ok, mais je n'ai pas les compétences pour réécrire toute la chaîne de compilation en statique, sinon je l'aurais déjà fait …